Hadoop入门 集群常用知识与常用脚本总结

集群常用知识与常用脚本总结

集群启动/停止方式

1 各个模块分开启动/停止(常用)

配置ssh是前提

整体启动/停止HDFS

[ranan@hadoop102 hadoop-3.1.3]$ sbin/start-dfs.sh

[ranan@hadoop102 hadoop-3.1.3]$ sbin/stop-dfs.sh

整体启动/停止YARN

[ranan@hadoop102 hadoop-3.1.3]$ sbin/start-yarn.sh

[ranan@hadoop102 hadoop-3.1.3]$ sbin/stop-yarn.sh

2 各个服务组件逐一启动/停止

分别启动/停止HDFS

hdfs --daemon start datanode/namenode/secondarynamenode

hdfs --daemon stop datanode/namenode/secondarynamenode

分别启动/停止YARN

yarn --daemon start resourcemanager/nodemanager

yarn --daemon stop resourcemanager/nodemanager

编写Hadoop集群常用脚本

1 Hadoop集群启停脚本myhadoop.sh

当集群很多的时候,为了方便启停,自己编写脚本。

包含HDFS、YARN、Historyserver

先到存放全局环境变量的环境下/home/ranan/bin,编写脚本文件myhadoop.sh

注意:脚本中尽量写绝对路径

#!/bin/bash

if [ $# -lt 1 ]

then

echo "No Args Input..."

exit ;

fi

case $1 in

"start")

echo " =================== 启动 hadoop 集群 ==================="

echo " --------------- 启动 hdfs ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/sbin/start-dfs.sh"

echo " --------------- 启动 yarn ---------------"

ssh hadoop103 "/opt/module/hadoop-3.1.3/sbin/start-yarn.sh"

echo " --------------- 启动 historyserver ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/bin/mapred --daemon start historyserver"

;;

"stop")

echo " =================== 关闭 hadoop 集群 ==================="

echo " --------------- 关闭 historyserver ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/bin/mapred --daemon stop historyserver"

echo " --------------- 关闭 yarn ---------------"

ssh hadoop103 "/opt/module/hadoop-3.1.3/sbin/stop-yarn.sh"

echo " --------------- 关闭 hdfs ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/sbin/stop-dfs.sh"

;;

*)

echo "Input Args Error..."

;;

esac

给脚本设置执行权限

[ranan@hadoop102 bin]$ chmod 777 myhadoop.sh

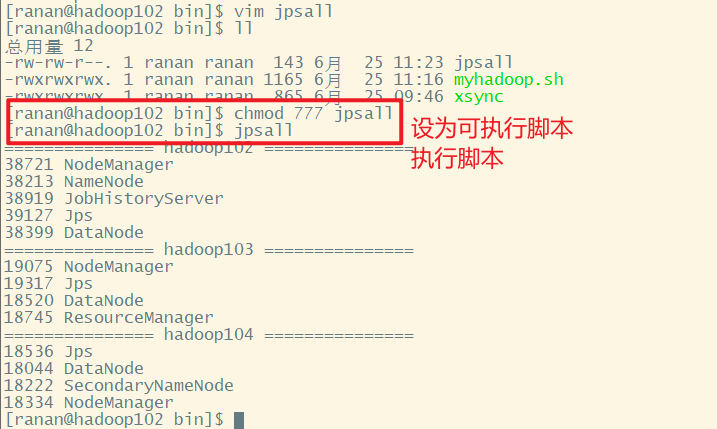

2 查看三台服务器Java进程脚本 jpsall

由于每次查看进程都得到每台服务器上输入jps查看,比较麻烦,且如果服务器较多,十分耗时,于是想到编写一个脚本,查看所有服务器的进程情况。

到存放全局环境变量的环境下/home/ranan/bin,编写脚本文件jpsall

#!/bin/bash

for host in hadoop102 hadoop103 hadoop104

do

echo =============== $host ===============

ssh $host jps

done

给脚本设置执行权限

[ranan@hadoop102 bin]$ chmod 777 jpsall

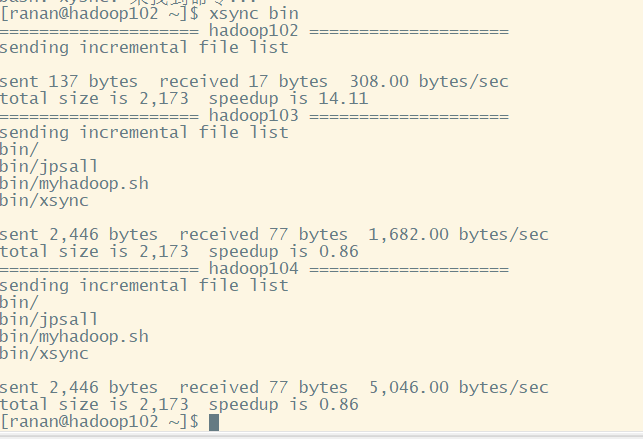

分发脚本

让三台服务器都可以使用脚本

[ranan@hadoop102 ~]$ xsync bin

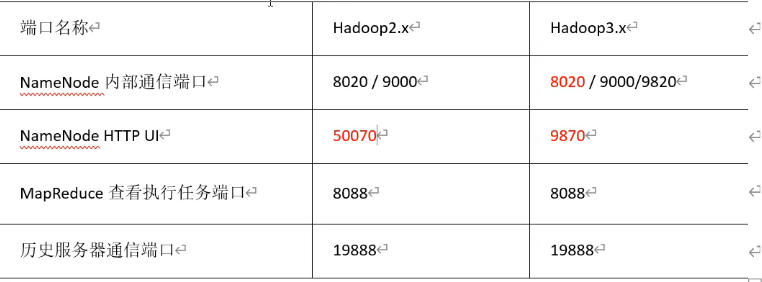

常用端口说明(面试题)

- hadoop3.x

- HDFS NameNode 内部通讯端口:8020/9000/9820

- HDFS NameNode 对用户的查询 端口:9870

- Yarn 查看任务运行情况端口:8088(没变)

- 历史服务器:19888(没变)

- hadoop2.x

- HDFS NameNode 内部通讯端口:8020/9000

- HDFS NameNode 对用户的查询 端口:50070

- Yarn 查看任务运行情况端口:8088

- 历史服务器:19888

常用的配置文件(面试题)

hadoop3.x

- core.site.xml

配置NameNode的内部通讯地址,hadoop数据存储在哪个目录下,配置HDFS网页登录使用的静态用户等。 - hdfs-site.xml

配置Namenode的Web访问地址,SecondaryNameNode的web访问地址等。 - yarn-site.xml

MR走什么协议,什么方式进行资源调度,指定ResourceManager部署在哪台节点服务器,日志的聚集等。 - mapred-site.xml

配置mapreduce运行在yarn,配置历史服务器等。 - workers

集群上有几个节点就配置几个主机名称,相当于连接。

- core.site.xml

hadoop2.x

- core.site.xml

- hdfs-site.xml

- yarn-site.xml

- mapred-site.xml

- slaves

Hadoop入门 集群常用知识与常用脚本总结的更多相关文章

- Hadoop入门 集群崩溃的处理方法

目录 集群崩溃的处理方法 搞崩集群 错误示范 正确处理方法 1 回到hadoop的家目录 2 杀死进程 3 删除每个集群的data和logs 4 格式化 5 启动集群 总结 原因分析 集群崩溃的处理方 ...

- Hadoop入门 集群时间同步

集群时间同步 如果服务器在公网环境(能连接外网),可以不采用集群时间同步.因为服务器会定期和公网时间进行校准. 如果服务器在内网环境,必须要配置集群时间同步,否则时间久了,会产生时间偏差,导致集群执行 ...

- Hadoop基础-HDFS集群中大数据开发常用的命令总结

Hadoop基础-HDFS集群中大数据开发常用的命令总结 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本盘博客仅仅列出了我们在实际生成环境中常用的hdfs命令,如果想要了解更多, ...

- (Linux环境Kafka集群安装配置及常用命令

Linux环境Kafka集群安装配置及常用命令 Kafka 消息队列内部实现原理 Kafka架构 一.下载Kafka安装包 二.Kafka安装包的解压 三.设置环境变量 四.配置kafka文件 4.1 ...

- hadoop+spark集群搭建入门

忽略元数据末尾 回到原数据开始处 Hadoop+spark集群搭建 说明: 本文档主要讲述hadoop+spark的集群搭建,linux环境是centos,本文档集群搭建使用两个节点作为集群环境:一个 ...

- 使用Docker在本地搭建Hadoop分布式集群

学习Hadoop集群环境搭建是Hadoop入门必经之路.搭建分布式集群通常有两个办法: 要么找多台机器来部署(常常找不到机器) 或者在本地开多个虚拟机(开销很大,对宿主机器性能要求高,光是安装多个虚拟 ...

- 分布式计算(一)Ubuntu搭建Hadoop分布式集群

最近准备接触分布式计算,学习分布式计算的技术栈和架构知识.目前的分布式计算方式大致分为两种:离线计算和实时计算.在大数据全家桶中,离线计算的优秀工具当属Hadoop和Spark,而实时计算的杰出代表非 ...

- 超快速使用docker在本地搭建hadoop分布式集群

超快速使用docker在本地搭建hadoop分布式集群 超快速使用docker在本地搭建hadoop分布式集群 学习hadoop集群环境搭建是hadoop入门的必经之路.搭建分布式集群通常有两个办法: ...

- 一脸懵逼学习Hadoop分布式集群HA模式部署(七台机器跑集群)

1)集群规划:主机名 IP 安装的软件 运行的进程master 192.168.199.130 jdk.hadoop ...

随机推荐

- Python | 实现pdf文件分页

不知道大家有没有遇到过这么一种情况,就比如一个pdf格式的电子书,我们经常浏览的是其中的一部分,而这电子书的页数很大,每当需要浏览时,就需要翻到对应的页码,就有点儿繁琐. 还有一些情况,比如,我们想分 ...

- 实验7:基于REST API的SDN北向应用实践

一.实验目的 1.能够编写程序调用OpenDaylight REST API实现特定网络功能: 2.能够编写程序调用Ryu REST API实现特定网络功能. 二.实验环境 下载虚拟机软件Oracle ...

- Relocations in generic ELF (EM: 40)

最近在搞机器上的wifi热点,需要移植一大堆东西,如hostapd\wpa_suppliant.dhcp等,这些玩意又依赖其他的一大堆库的移植,比如libnl,openssl等,今天在移植编译libn ...

- P2598 [ZJOI2009]狼和羊的故事(最小割)

P2598 [ZJOI2009]狼和羊的故事 说真的,要多练练网络流的题了,这么简单的网络流就看不出来... 题目要求我们要求将狼和羊分开,也就是最小割,(等等什么逻辑...头大....) 我们这样想 ...

- ssl 原理和建立连接过程

ssl ("Secure Sockets Layer")加密原理 和https的关系https = http + ssl ssl 位置: SSL握手 证书主要作用是在SSL握手中, ...

- Oracle 19c 单机

环境 vm虚拟机 双磁盘 操作系统 Oracle Linux 7.9 操作系统安装带图形 选择中文,注意不要新建用户 关闭防火墙 selinux 配置好IP 挂载系统盘镜像 修改主机名 配置hosts ...

- zabbix web管理页面 中文乱码问题

1.在自己电脑上找下图文件,C:\Windows\Fonts 2.上传到 /usr/share/zabbix/assets/fonts/ 目录下 可以看到 graphfont.ttf 是 /etc/a ...

- JVM-内存区域与OOM

本篇博客内容主要参考<深入理解Java虚拟机> 内存区域与内存溢出异常 运行时数据区 Java虚拟机运行时数据区: 程序计数器(Program Counter Register)是一块较小 ...

- Go 跳出 for-switch 和 for-select 代码块

原文:https://segmentfault.com/a/1190000013739000 没有指定标签的 break 只会跳出 switch/select 语句,若不能使用 return 语句跳出 ...

- Charles抓包 mock数据和rewrite功能

一.mock数据 mock:在后端返回异常或需要=改前端展示的数据时可以模拟返回的response 1.1 抓到接口后 右击保存response到本地,后缀改成.json打开可以看到是把json保存下 ...