TensorFlow实战第七课(dropout解决overfitting)

Dropout 解决 overfitting

overfitting也被称为过度学习,过度拟合。他是机器学习中常见的问题。

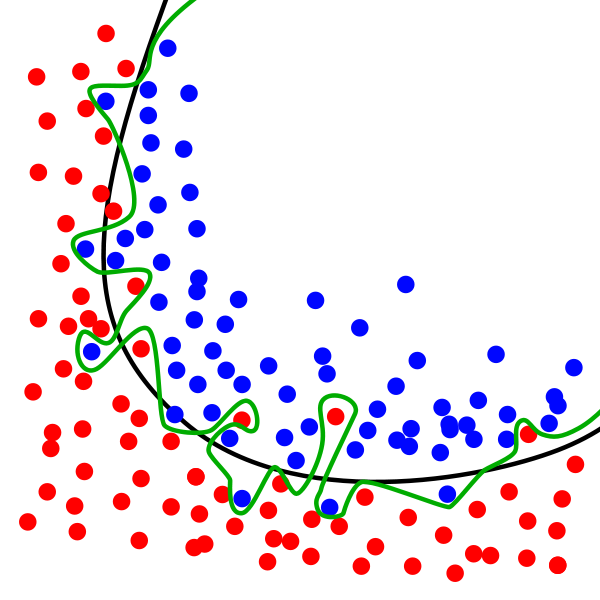

图中的黑色曲线是正常模型,绿色曲线就是overfitting模型。尽管绿色曲线很精确的区分了所有的训练数据,但是并没有描述数据的整体特征,对新测试的数据适应性比较差。

举个Regression(回归)的例子.

第三条曲线存在overfitting问题,尽管它经过了所有的训练点,但是不能很好地反映数据的趋势,预测能力严重不足。tensorflow提供了强大的dropout方法来结局overfitting的问题。

建立Dropout层

本次内容需要安装适应sklearn数据库中的数据 没有安装sklearn的同学可以参考一下以下

import tensorflow as tf

from sklearn.datasets import load_digits

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import LabelBinarizer

keep_prob = tf.placeholder(tf.float32)

...

...

Wx_plus_b = tf.nn.dropout(Wx_plus_b, keep_prob)

这里的keep_prob是保留概率,即我们要保留的结果所占的比例,他作为一个placeholder,在run时传入,当keep_prob=1的时候,相当于100%保留,就是drop没起作用。

下面准备数据:

digits = load_digits()

X = digits.data

y = digits.target

y = LabelBinarizer().fit_transform(y)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=.3)

其中X_train是训练数据,X_test是测试数据。然后添加隐藏层和输出层

# add output layer

l1 = add_layer(xs, 64, 50, 'l1', activation_function=tf.nn.tanh)

prediction = add_layer(l1, 50, 10, 'l2', activation_function=tf.nn.softmax)

添加层的激活函数选用tanh(其实我也不知道为什么,莫烦的课里讲不写tanh函数,其他的函数会报none错误,就不管啦)

训练

sess.run(train_step, feed_dict={xs: X_train, ys: y_train, keep_prob: 0.5})

#sess.run(train_step, feed_dict={xs: X_train, ys: y_train, keep_prob: 1})

保留概率是指保留下多少,我们尝试0.5&1.0 观察tensorboard生成的可视化结果

可视化结果

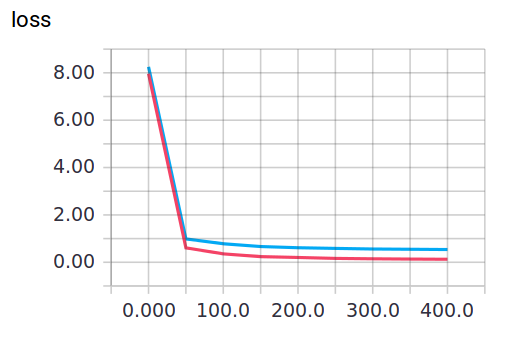

keep_prob=1时,会暴露overfitting的问题,keep_prob=0.5时,Dropout就发挥了作用。

当keep_prob=1时 模型对训练数据的适应性优于测试数据,存在overfitting。红线是train的误差,蓝线是test的误差。

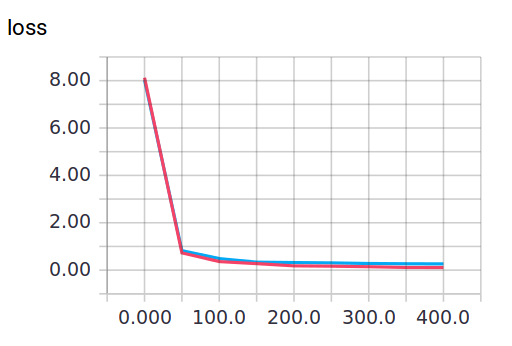

当keep_prob=0.5时

可以明显看到loss的变化

完整代码以及部分注释如下

import tensorflow as tf

from sklearn.datasets import load_digits

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import LabelBinarizer #载入数据

digits = load_digits()

X = digits.data

y = digits.target

#preprocessing.LabelBinarizer是一个很好用的工具。

# 比如可以把yes和no转化为0和1

# 或是把incident和normal转化为0和1

y = LabelBinarizer().fit_transform(y)

X_train,X_test,y_train,y_test = train_test_split(X,y,test_size=.3) def add_layer(inputs,in_size,out_size,layer_name,activation_function=None,):

Weights = tf.Variable(tf.random_normal([in_size,out_size]))

biases = tf.Variable(tf.zeros([1,out_size])+ 0.1)

Wx_plus_b = tf.matmul(inputs,Weights)+biases

#here to drop

Wx_plus_b = tf.nn.dropout(Wx_plus_b, keep_prob)

if activation_function is None:

outputs = Wx_plus_b

else:

outputs = activation_function(Wx_plus_b,)

tf.summary.histogram(layer_name + 'outputs',outputs)

return outputs #define placeholder for inputs to network

keep_prob = tf.placeholder(tf.float32)#保留概率 即我们需要保留的结果所占比

xs = tf.placeholder(tf.float32,[None,64])#8*8

ys = tf.placeholder(tf.float32,[None,10]) #add output layer

l1 = add_layer(xs,64,50,'l1',activation_function=tf.nn.tanh)

prediction = add_layer(l1,50,10,'l2',activation_function=tf.nn.softmax) #the loss between prediction and real data

#loss

cross_entropy = tf.reduce_mean(-tf.reduce_sum(ys*tf.log(prediction),reduction_indices=[1])) tf.summary.scalar('loss',cross_entropy)

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(cross_entropy) sess = tf.Session()

merged = tf.summary.merge_all() #summary writer goes in here

train_writer = tf.summary.FileWriter("logs/train",sess.graph)

test_writer = tf.summary.FileWriter("logs/test",sess.graph) init = tf.global_variables_initializer() #变量初始化 sess.run(init) for i in range(500):

#here to determine the keeping probability

sess.run(train_step,feed_dict={xs:X_train,ys:y_train,keep_prob:0.5})

if i %50 ==0:

#record loss

train_result = sess.run(merged,feed_dict={xs:X_train,ys:y_train,keep_prob:1})

test_result = sess.run(merged,feed_dict={xs:X_test,ys:y_test,keep_prob:1})

train_writer.add_summary(test_result,i)

test_writer.add_summary(test_result,i)

TensorFlow实战第七课(dropout解决overfitting)的更多相关文章

- tensorflow学习之(八)使用dropout解决overfitting(过拟合)问题

#使用dropout解决overfitting(过拟合)问题 #如果有dropout,在feed_dict的参数中一定要加入dropout的值 import tensorflow as tf from ...

- 4 TensorFlow入门之dropout解决overfitting问题

------------------------------------ 写在开头:此文参照莫烦python教程(墙裂推荐!!!) ---------------------------------- ...

- TensorFlow实战第八课(卷积神经网络CNN)

首先我们来简单的了解一下什么是卷积神经网路(Convolutional Neural Network) 卷积神经网络是近些年逐步兴起的一种人工神经网络结构, 因为利用卷积神经网络在图像和语音识别方面能 ...

- TensorFlow实战第六课(过拟合)

本节讲的是机器学习中出现的过拟合(overfitting)现象,以及解决过拟合的一些方法. 机器学习模型的自负又表现在哪些方面呢. 这里是一些数据. 如果要你画一条线来描述这些数据, 大多数人都会这么 ...

- TensorFlow实战第三课(可视化、加速神经网络训练)

matplotlib可视化 构件图形 用散点图描述真实数据之间的关系(plt.ion()用于连续显示) # plot the real data fig = plt.figure() ax = fig ...

- Tensorflow实战第十一课(RNN Regression 回归例子 )

本节我们会使用RNN来进行回归训练(Regression),会继续使用自己创建的sin曲线预测一条cos曲线. 首先我们需要先确定RNN的各种参数: import tensorflow as tf i ...

- Tensorflow实战第十课(RNN MNIST分类)

设置RNN的参数 我们本节采用RNN来进行分类的训练(classifiction).会继续使用手写数据集MNIST. 让RNN从每张图片的第一行像素读到最后一行,然后进行分类判断.接下来我们导入MNI ...

- TensorFlow实战第五课(MNIST手写数据集识别)

Tensorflow实现softmax regression识别手写数字 MNIST手写数字识别可以形象的描述为机器学习领域中的hello world. MNIST是一个非常简单的机器视觉数据集.它由 ...

- TensorFlow实战第四课(tensorboard数据可视化)

tensorboard可视化工具 tensorboard是tensorflow的可视化工具,通过这个工具我们可以很清楚的看到整个神经网络的结构及框架. 通过之前展示的代码,我们进行修改从而展示其神经网 ...

随机推荐

- ip端口协议,SSHj加密连接

SSH协议----一旦linux服务器开机,SSH协议就不断的侦听22端口,一旦有连接到达,就校验连接用户名和密码: 可以理解为连接ip端口为找到一栋大楼,发送用户名和密码为向大楼保安出示证件.SSH ...

- Tomcat与Jetty比较

Jetty 基本架构 Jetty目前的是一个比较被看好的 Servlet 引擎,它的架构比较简单,也是一个可扩展性和非常灵活的应用服务器. 它有一个基本数据模型,这个数据模型就是 Handler(处理 ...

- 基于node.js的websocket 前后端交互小功能

一.node var ws = require("nodejs-websocket"); console.log("开始建立连接...") var server ...

- MessagePack Java Jackson Dataformat 在 Map 中不使用 String 为 Key 的序列化

当你希望在 Map 中不使用 String 为 Key,那么你需要使用 MessagePackKeySerializer 来为 key 进行序列化. 本测试方法,可以在 https://github. ...

- svn的下载与安装,使用,包教包会!!!

svn的安装使用说明 下载svn服务器与搭建 高效开发 — SVN使用教程(客户端与服务端安装详解!带图!带注释!安装客户端与服务端的地址可以看上两个链接) svn安装分为两部分,服务端安装与客户端安 ...

- npm脚本编译代码

echo offset codeUrl=D:\svn\oppo_mis\OCSS_NEW\Branches\ProjectCode20190909\h5_ocssset publishUrl=D:\P ...

- Into Blocks (easy version)

G1 - Into Blocks (easy version) 参考:Codeforces Round #584 - Dasha Code Championship - Elimination Rou ...

- Linux停止被占用的端口

查找被占用的端口:netstat -lnp|grep 80 查看80端口被那些服务占用. kill掉该进程 kill -9 5574 然后在去查看一下80被占用的情况netstat -lnp|grep ...

- 2、记录代码----Ajax

$.ajax({ url:'/content-engine/index.php/tracker/confirmSendEmail', async: false, //默认为true,同意异步传输 da ...

- laravel 框架接入环信遇到的坑(-)

在脚本中执行判断user表中是否注册环信时,报错: “请求错误:service_resource_not_found Service resource not found ” // 判断环信是否已经 ...