Node.js实现简单的爬取

学习【node.js】也有几天时间了,所以打算写着练练手;索然我作为一个后端的选手,写起来还有那么一丝熟悉的感觉。emmm~~ ‘货’不多讲 ,开搞........

首先是依赖选择:

代码块如下:

//引入依赖

//https请求

const https = require('https');

//简称node版的jquery

const cheerio = require('cheerio');

//解决防止出现乱码

const iconv = require('iconv-lite')

//http请求

const request = require("request");

//负责读写文件

const fs = require('fs');

//处理文件路径

const path = require('path');

爬取路径:

代码块:(PS:这里单独拿出来是因为这个站的素材比较推荐,可以上去瞅瞅~~)

const url = 'https://unsplash.com/';

初步实现:

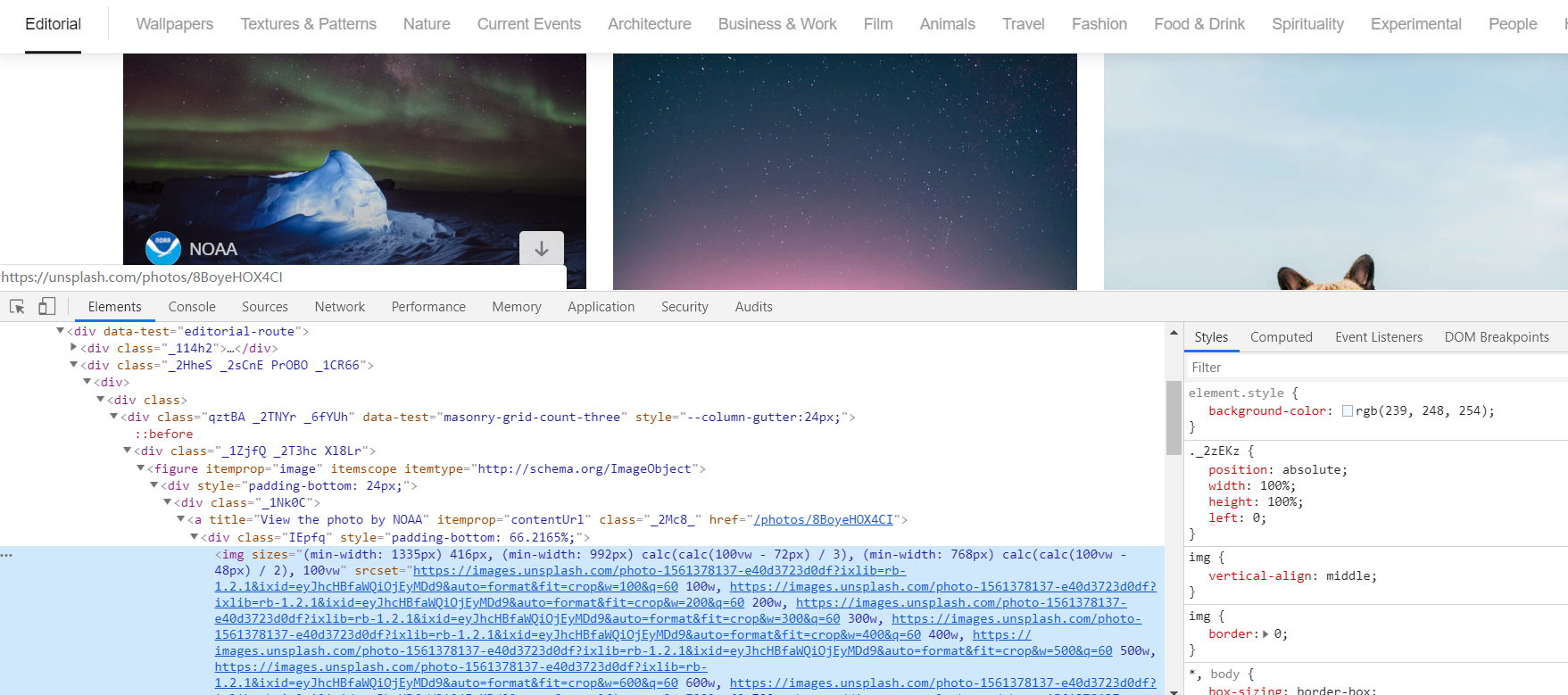

网站的基本构成

这里主要是我们直接确认一下需要的【img】标签,以及外面的【figure】,然后直接就可以开工了....

核心代码:

//方法对象

const util = { getsrc: function (url) {

https.get(url, res => {

const chunks = [];

res.on('data', chunk => {

// chunks里面存储着网页的html内容

chunks.push(chunk);

});

res.on('end', e => { let ALL = [];

//编码格式

let html = iconv.decode(Buffer.concat(chunks), 'utf8');

let $ = cheerio.load(html, { decodeEntities: false }); //标签遍历

$("figure img").each(function (idex, elent) {

let $elent = $(elent);

let $srcset = $elent.attr("srcset");

if ($srcset != undefined) {

let src = ($srcset.split(',').pop()).split('?')[0];

ALL.push({

src: src

})

}

});

//遍历数组 每个后面加.jpg

ALL.forEach(item => {

util.downloadimg(item.src, path.basename(item.src) + ".jpg", function () {

console.log(path.basename(item.src) + ".jpg");

});

})

}); res.on('error', e => {

console.log('Error: ' + e.message);

});

});

}, //运行主函数

main: function () {

console.log("------start--------");

util.getsrc(url);

},

//下载图片函数

downloadimg: function (src, srcname, callback) { //http请求

request.head(src, function (err, res, body) {

if (err) {

console.log('err:' + err);

return false;

}

console.log('res: ' + res);

//保存数据,这里是防止未来得及记录数据又开始读取数据而导致数据丢失

request(src).pipe(fs.createWriteStream('./img/' + srcname)).on('close', callback);

});

}

} //主函数

util.main();

然后就可以运行 node xxx.js 看运行结果。

Git源码地址:https://github.com/KelvinKey/node-reptile

END Initial entry into the front end, the inadequacies, please bear with me.

Node.js实现简单的爬取的更多相关文章

- node.js 89行爬虫爬取智联招聘信息

写在前面的话, .......写个P,直接上效果图.附上源码地址 github/lonhon ok,正文开始,先列出用到的和require的东西: node.js,这个是必须的 request,然发 ...

- 使用Node.js实现简单的网络爬取

由于最近要实现一个爬取H5游戏的代理服务器,隧看到这么一篇不错的文章(http://blog.miguelgrinberg.com/post/easy-web-scraping-with-nodejs ...

- 关于js渲染网页时爬取数据的思路和全过程(附源码)

于js渲染网页时爬取数据的思路 首先可以先去用requests库访问url来测试一下能不能拿到数据,如果能拿到那么就是一个普通的网页,如果出现403类的错误代码可以在requests.get()方法里 ...

- 使用webmagic爬虫对百度百科进行简单的爬取

分析要爬取的网页源码: 1.打开要分析的网页,查看源代码,找到要爬取的内容: (选择网页里的一部分右击审查元素也行) 2.导入jar包,这个就直接去网上下吧: 3.写爬虫: package com.g ...

- web scraper——简单的爬取数据【二】

web scraper——安装[一] 在上文中我们已经安装好了web scraper现在我们来进行简单的爬取,就来爬取百度的实时热点吧. http://top.baidu.com/buzz?b=1&a ...

- Centos7 中 Node.js安装简单方法

最近,我一直对学习Node.js比较感兴趣.下面是小编给大家带来的Centos7 中 Node.js安装简单方法,在此记录一下,方便自己也方便大家,一起看看吧! 安装node.js 登陆Centos ...

- 创建node.js一个简单的应用实例

在node.exe所在目录下,创建一个叫 server.js 的文件,并写入以下代码: //使用 require 指令来载入 http 模块 var http = require("http ...

- Node.js 实现简单小说爬虫

最近因为剧荒,老大追了爱奇艺的一部网剧,由丁墨的同名小说<美人为馅>改编,目前已经放出两季,虽然整部剧槽点满满,但是老大看得不亦乐乎,并且在看完第二季之后跟我要小说资源,直接要奔原著去看结 ...

- 用node.js实现简单的web服务器

node.js实现web服务器还是比较简单的,我了解node.js是从<node入门>开始的,如果你不了解node.js也可以看看! 我根据那书一步一步的练习完了,也的确大概了解了node ...

随机推荐

- hdoj1007【几何】【未完待续】

题意: 在一个平面上有n(1e5)个点,然后求一个圆来包住这些点,求这个圆的最小半径. 思考: 要使一个圆直接包了这些点,没有任何思路..

- bzoj 3232: 圈地游戏【分数规划+最小割】

数组开小导致TTTTTLE-- 是分数规划,设sm为所有格子价值和,二分出mid之后,用最小割来判断,也就是判断sm-dinic()>=0 这个最小割比较像最大权闭合子图,建图是s像所有点连流量 ...

- Jury Meeting CodeForces - 854D

Jury Meeting CodeForces - 854D 思路:暴力枚举会议开始的那一天(只需用所有向0点飞的航班的那一天+1去枚举即可),并计算所有人此情况下去0点和从0点出来的最小花费. 具体 ...

- 阻止默认行为是配合passive使用

在使用lighthouse检测pwa应用时,发现提示下面有下面的警告 默认使用passive:true提高滚动性能并减少崩溃,passive即顺从的,是指它顺从浏览器的默认行为.设置该属性的目的主要是 ...

- 关于在@Controller所返回的视图的css,js文件404问题

本人在使用layui打开一个请求后台的页面时,页面成功由controller重定向到了正确的位置,然而几乎所有的js文件和css文件都报404,并且确定这些css文件还有js文件的引入的路径都是正确的 ...

- FACVSPOW - Factorial vs Power 数学方法 + 二分

http://www.spoj.com/problems/FACVSPOW/ 求解n! > a^n最小的整数n 对于有n!和a^n的东西,一般是取ln 然后就是求解 (ln(1) + ln(2) ...

- 前端之HTML语法及常用标签

html语法: 1.常规标记: <标记 属性=“属性值” 属性=“属性值”></标记>: 2.空标记: <标记 属性=“属性值” 属性=“属性值”/> 注意事项: ...

- [BZOJ1040][ZJOI2008]骑士 基环树DP

题目链接:http://www.lydsy.com/JudgeOnline/problem.php?id=1040 题目给出了$n$个点和$n$条无向边,即一棵基环树或者基环树森林. 如果题目给的关系 ...

- 最优雅退出 Android 应用程序的 6 种方式

一.容器式 建立一个全局容器,把所有的Activity存储起来,退出时循环遍历finish所有Activity import java.util.ArrayList; import java.util ...

- Java进化的尽头

转载需声明:原文链接网址:http://www.artima.com/weblogs/viewpost.jsp?thread=221903 Java: Evolutionary Dead End 我在 ...