scrapy获取当当网中数据

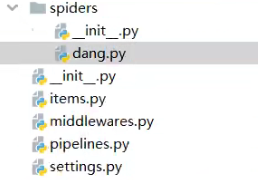

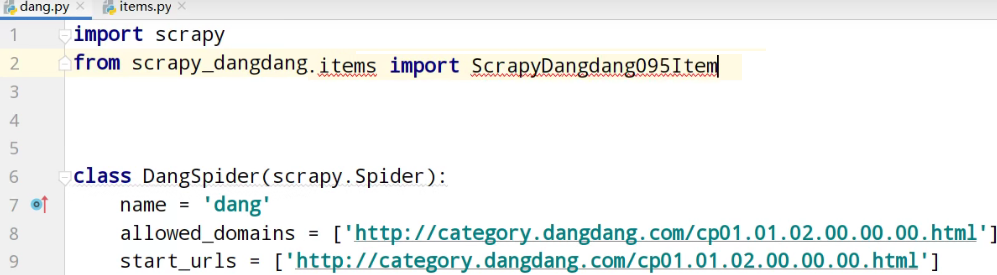

创建爬虫文件

scrapy_dangdang\scrapy_dangdang\scrapy> scrapy genspider dang http://category.dangdang.com/cp01.01.02.00.00.00.html

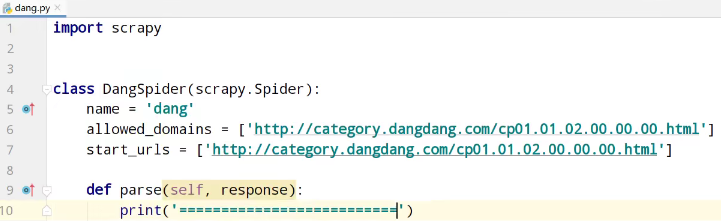

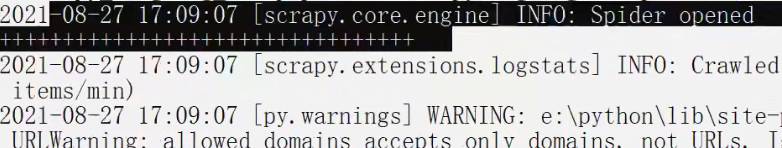

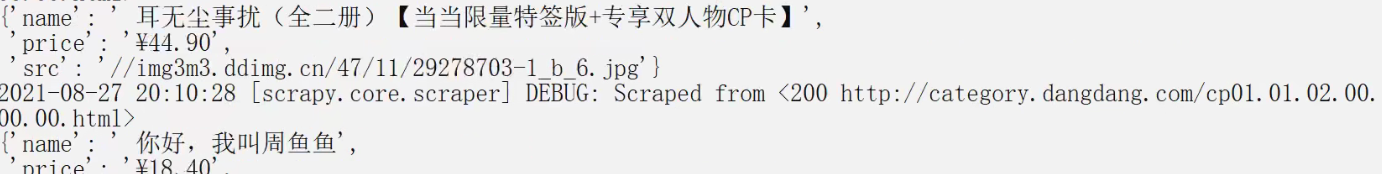

测试运行,爬虫文件

scrapy_dangdang\scrapy_dangdang\scrapy> scrapy crawl dang

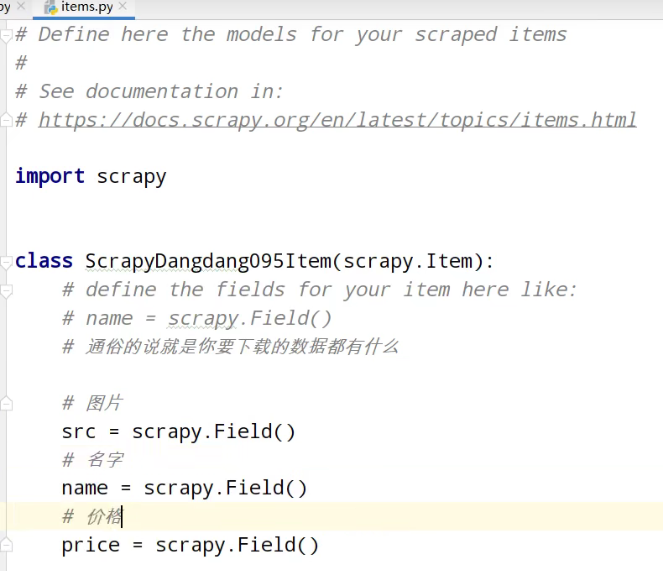

items.py定义数据结构

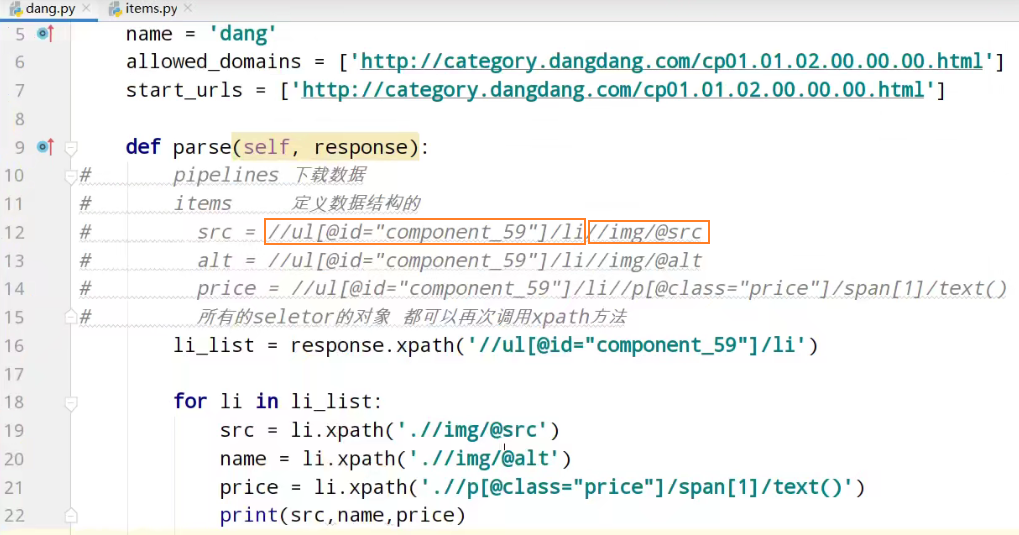

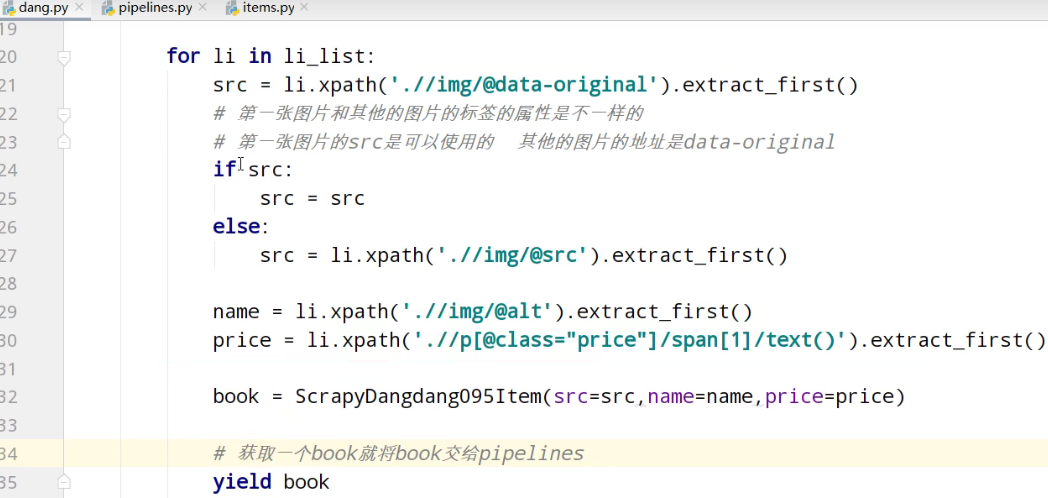

获取数据

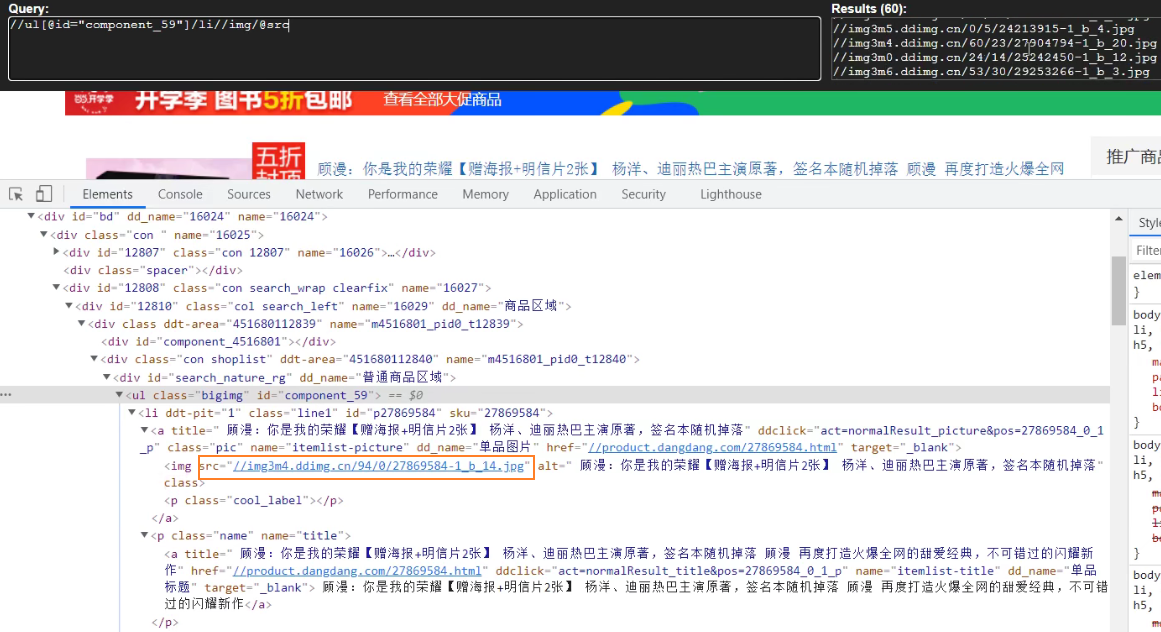

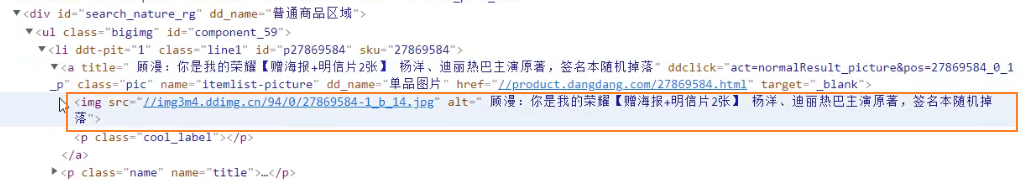

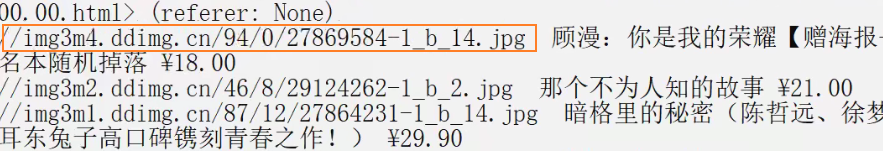

找到书图片的src

找到书名称的alt

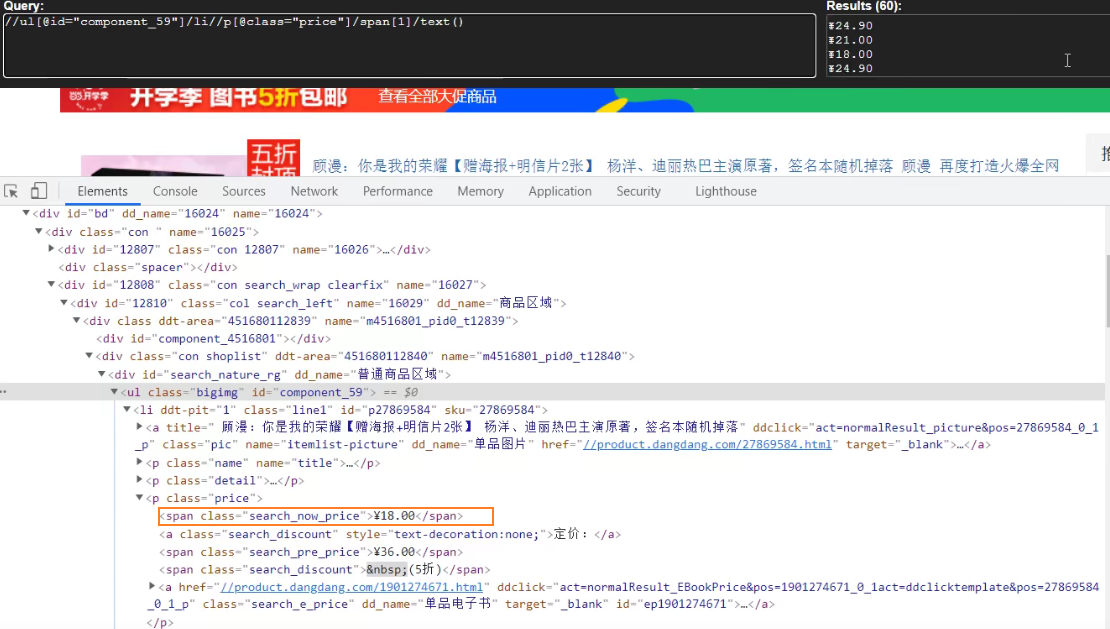

找到书价格的span

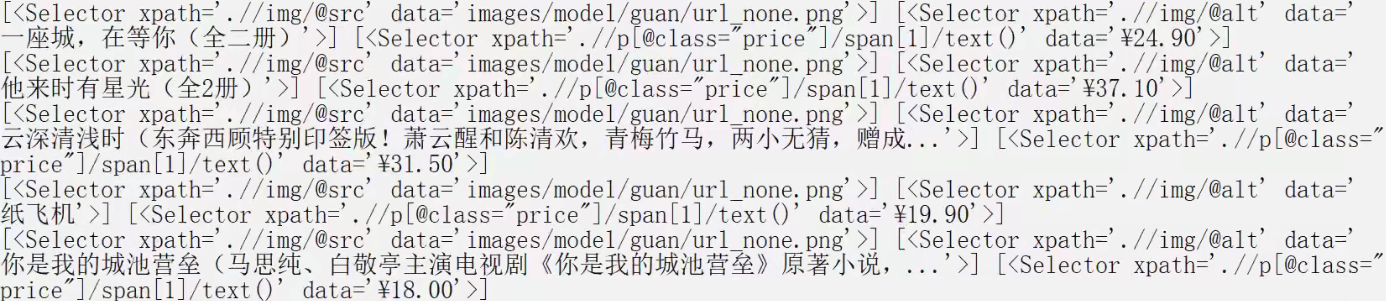

获取selector对象列表的data属性值

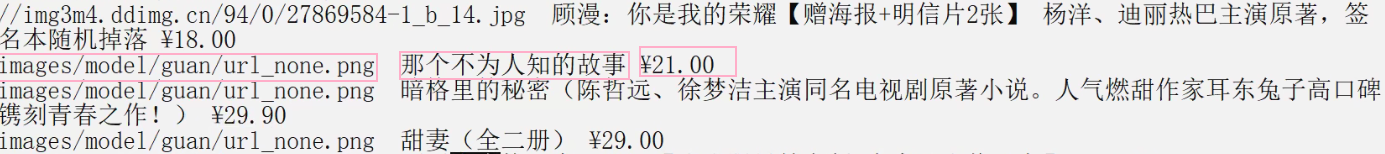

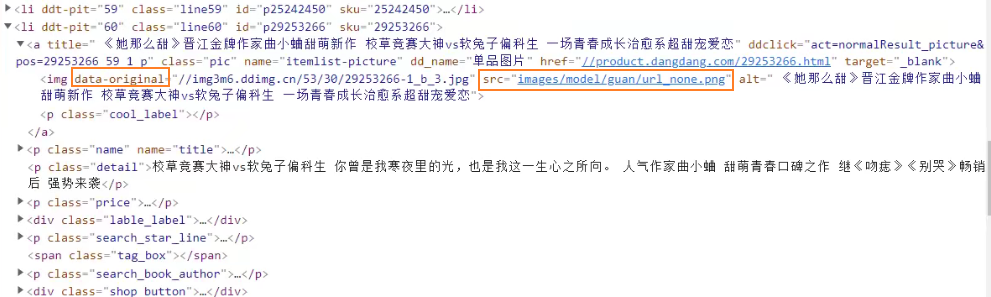

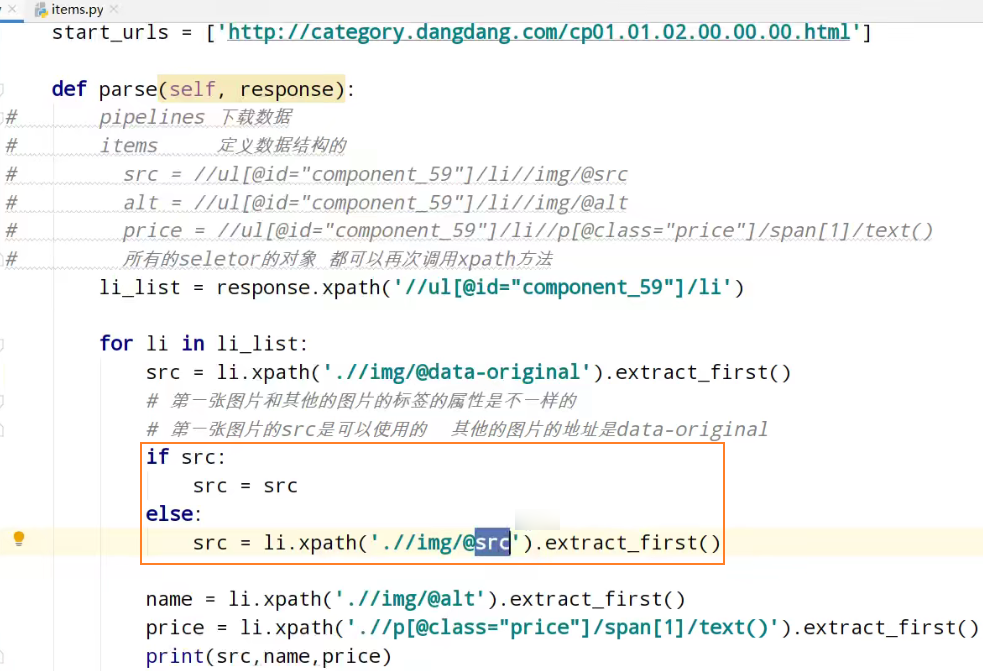

发现src相同,解决懒加载情况

网页向下滑动

使用图片的data-original值

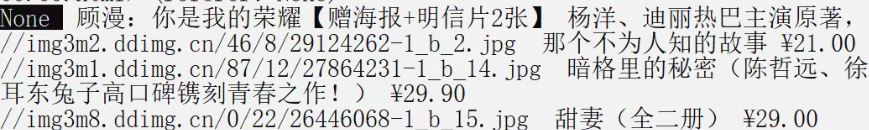

解决第一张图的src使用none空

第一张图的img只有src属性

第二张图及之后图的img有data-original属性

导入

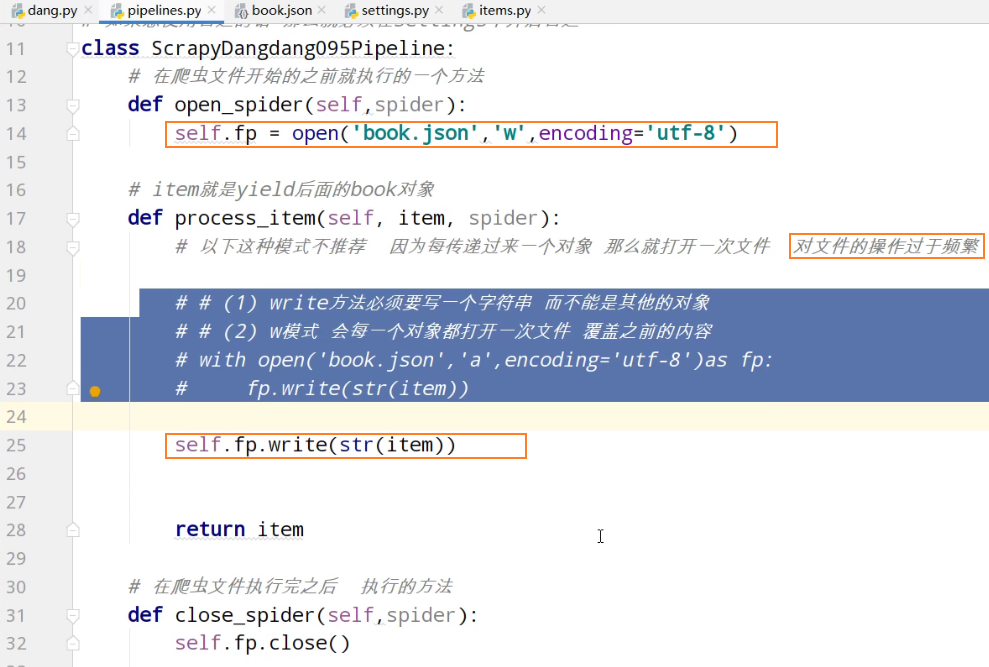

yield返回值到pipelines管道

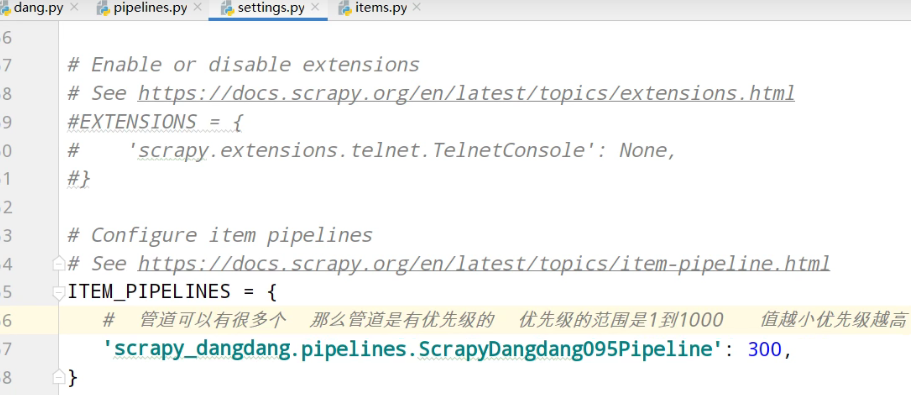

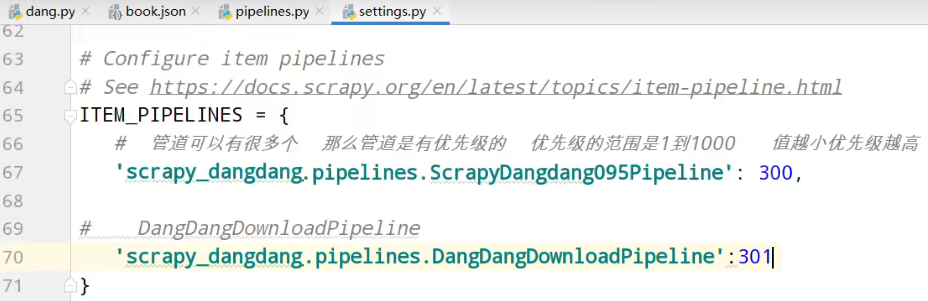

settings中开启管道

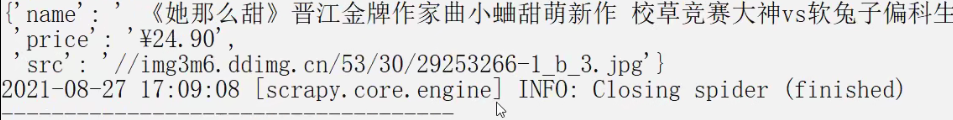

pipelines管道的封装

追加写入数据

爬虫文件执行之,前执行

爬虫文件执行之,后执行

解决操作文件过于频繁

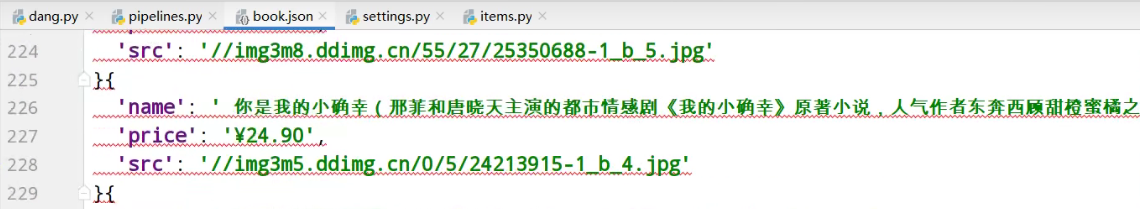

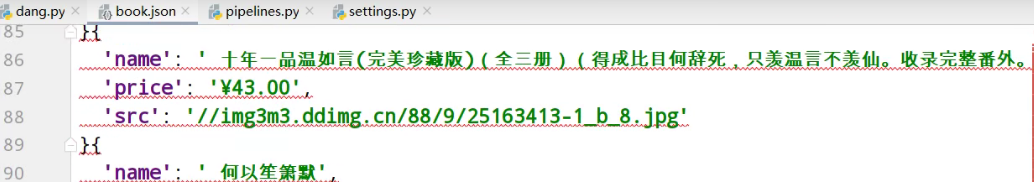

book.json

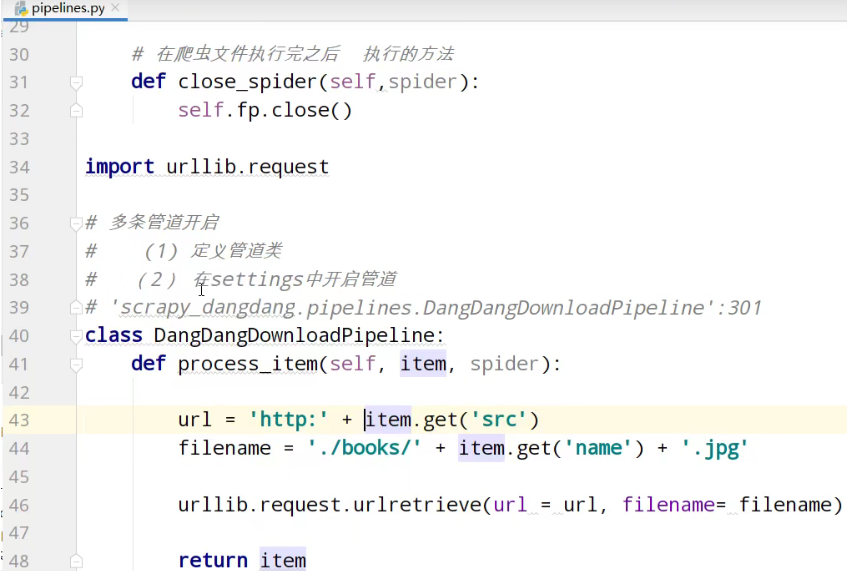

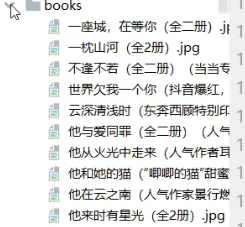

多条管道的下载

开启图片下载管道

运行

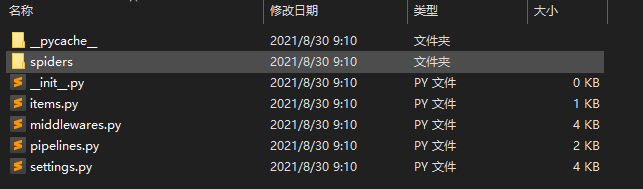

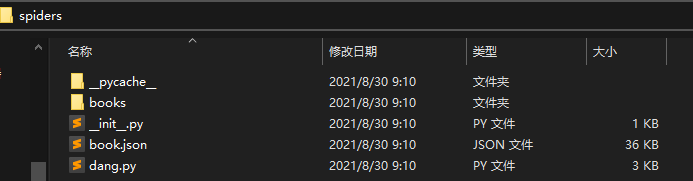

项目结构,及代码

dang.py爬虫核心功能

import scrapy

from scrapy_dangdang.items import ScrapyDangdang095Item class DangSpider(scrapy.Spider): # 如果是多页下载的话 那么必须要调整的是allowed_domains的范围 一般情况下只写域名

allowed_domains = ['http://category.dangdang.com/cp01.01.02.00.00.00.html']

start_urls = ['http://category.dangdang.com/cp01.01.02.00.00.00.html'] def parse(self, response):

# pipelines 下载数据

# items 定义数据结构的

# src = //ul[@id="component_59"]/li//img/@src

# alt = //ul[@id="component_59"]/li//img/@alt

# price = //ul[@id="component_59"]/li//p[@class="price"]/span[1]/text()

# 所有的seletor的对象 都可以再次调用xpath方法

li_list = response.xpath('//ul[@id="component_59"]/li') for li in li_list:

src = li.xpath('.//img/@data-original').extract_first()

# 第一张图片和其他的图片的标签的属性是不一样的

# 第一张图片的src是可以使用的 其他的图片的地址是data-original

if src:

src = src

else:

src = li.xpath('.//img/@src').extract_first() name = li.xpath('.//img/@alt').extract_first()

price = li.xpath('.//p[@class="price"]/span[1]/text()').extract_first() book = ScrapyDangdang095Item(src=src,name=name,price=price) # 获取一个book就将book交给pipelines

yield book

items.py定义数据结构,类

# Define here the models for your scraped items

#

# See documentation in:

# https://docs.scrapy.org/en/latest/topics/items.html import scrapy class ScrapyDangdang095Item(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

# 通俗的说就是你要下载的数据都有什么 # 图片

src = scrapy.Field()

# 名字

name = scrapy.Field()

# 价格

price = scrapy.Field()

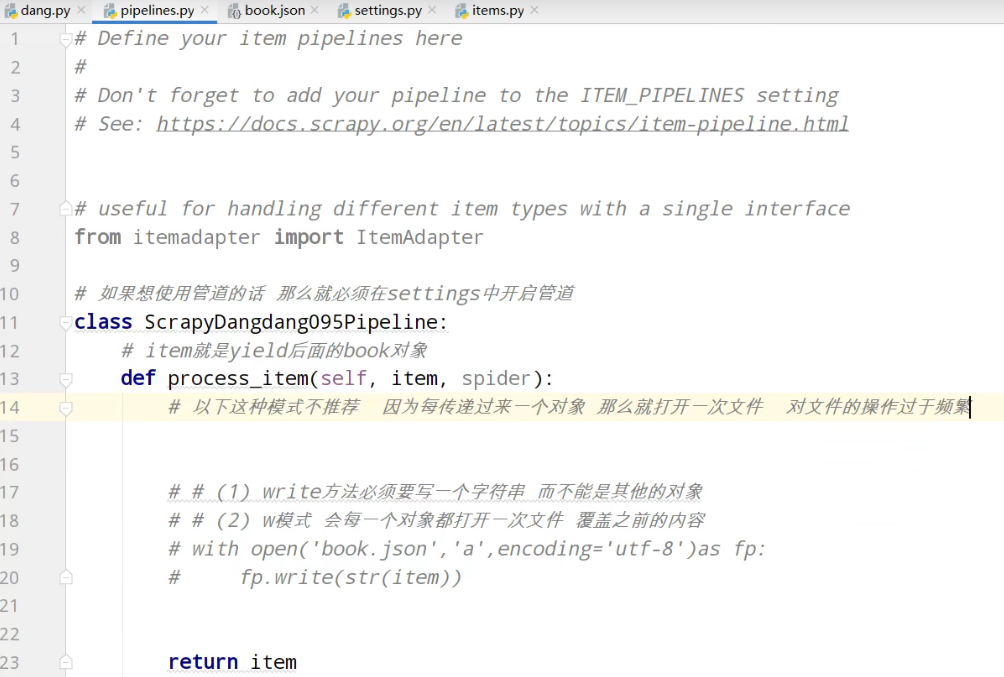

pipelines.py管道功能

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://docs.scrapy.org/en/latest/topics/item-pipeline.html # useful for handling different item types with a single interface

from itemadapter import ItemAdapter # 如果想使用管道的话 那么就必须在settings中开启管道

class ScrapyDangdang095Pipeline:

# 在爬虫文件开始的之前就执行的一个方法

def open_spider(self,spider):

self.fp = open('book.json','w',encoding='utf-8') # item就是yield后面的book对象

def process_item(self, item, spider):

# 以下这种模式不推荐 因为每传递过来一个对象 那么就打开一次文件 对文件的操作过于频繁 # # (1) write方法必须要写一个字符串 而不能是其他的对象

# # (2) w模式 会每一个对象都打开一次文件 覆盖之前的内容

# with open('book.json','a',encoding='utf-8')as fp:

# fp.write(str(item)) self.fp.write(str(item)) return item # 在爬虫文件执行完之后 执行的方法

def close_spider(self,spider):

self.fp.close() import urllib.request # 多条管道开启

# (1) 定义管道类

# (2) 在settings中开启管道

# 'scrapy_dangdang_095.pipelines.DangDangDownloadPipeline':301

class DangDangDownloadPipeline:

def process_item(self, item, spider): url = 'http:' + item.get('src')

filename = './books/' + item.get('name') + '.jpg' urllib.request.urlretrieve(url = url, filename= filename) return item

settings.py配置管道

# Scrapy settings for scrapy_dangdang_095 project

#

# For simplicity, this file contains only settings considered important or

# commonly used. You can find more settings consulting the documentation:

#

# https://docs.scrapy.org/en/latest/topics/settings.html

# https://docs.scrapy.org/en/latest/topics/downloader-middleware.html

# https://docs.scrapy.org/en/latest/topics/spider-middleware.html BOT_NAME = 'scrapy_dangdang' SPIDER_MODULES = ['scrapy_dangdang.spiders']

NEWSPIDER_MODULE = 'scrapy_dangdang.spiders' # Crawl responsibly by identifying yourself (and your website) on the user-agent

#USER_AGENT = 'scrapy_dangdang_095 (+http://www.yourdomain.com)' # Obey robots.txt rules

ROBOTSTXT_OBEY = True # Configure maximum concurrent requests performed by Scrapy (default: 16)

#CONCURRENT_REQUESTS = 32 # Configure a delay for requests for the same website (default: 0)

# See https://docs.scrapy.org/en/latest/topics/settings.html#download-delay

# See also autothrottle settings and docs

#DOWNLOAD_DELAY = 3

# The download delay setting will honor only one of:

#CONCURRENT_REQUESTS_PER_DOMAIN = 16

#CONCURRENT_REQUESTS_PER_IP = 16 # Disable cookies (enabled by default)

#COOKIES_ENABLED = False # Disable Telnet Console (enabled by default)

#TELNETCONSOLE_ENABLED = False # Override the default request headers:

#DEFAULT_REQUEST_HEADERS = {

# 'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

# 'Accept-Language': 'en',

#} # Enable or disable spider middlewares

# See https://docs.scrapy.org/en/latest/topics/spider-middleware.html

#SPIDER_MIDDLEWARES = {

# 'scrapy_dangdang_095.middlewares.ScrapyDangdang095SpiderMiddleware': 543,

#} # Enable or disable downloader middlewares

# See https://docs.scrapy.org/en/latest/topics/downloader-middleware.html

#DOWNLOADER_MIDDLEWARES = {

# 'scrapy_dangdang_095.middlewares.ScrapyDangdang095DownloaderMiddleware': 543,

#} # Enable or disable extensions

# See https://docs.scrapy.org/en/latest/topics/extensions.html

#EXTENSIONS = {

# 'scrapy.extensions.telnet.TelnetConsole': None,

#} # Configure item pipelines

# See https://docs.scrapy.org/en/latest/topics/item-pipeline.html

ITEM_PIPELINES = {

# 管道可以有很多个 那么管道是有优先级的 优先级的范围是1到1000 值越小优先级越高

'scrapy_dangdang.pipelines.ScrapyDangdang095Pipeline': 300, # DangDangDownloadPipeline

'scrapy_dangdang.pipelines.DangDangDownloadPipeline':301

}

# Enable and configure the AutoThrottle extension (disabled by default)

# See https://docs.scrapy.org/en/latest/topics/autothrottle.html

#AUTOTHROTTLE_ENABLED = True

# The initial download delay

#AUTOTHROTTLE_START_DELAY = 5

# The maximum download delay to be set in case of high latencies

#AUTOTHROTTLE_MAX_DELAY = 60

# The average number of requests Scrapy should be sending in parallel to

# each remote server

#AUTOTHROTTLE_TARGET_CONCURRENCY = 1.0

# Enable showing throttling stats for every response received:

#AUTOTHROTTLE_DEBUG = False # Enable and configure HTTP caching (disabled by default)

# See https://docs.scrapy.org/en/latest/topics/downloader-middleware.html#httpcache-middleware-settings

#HTTPCACHE_ENABLED = True

#HTTPCACHE_EXPIRATION_SECS = 0

#HTTPCACHE_DIR = 'httpcache'

#HTTPCACHE_IGNORE_HTTP_CODES = []

#HTTPCACHE_STORAGE = 'scrapy.extensions.httpcache.FilesystemCacheStorage'

scrapy获取当当网中数据的更多相关文章

- scrapy获取当当网多页的获取

结合上节,网多页的获取只需要修改 dang.py import scrapy from scrapy_dangdang.items import ScrapyDangdang095Item class ...

- scrapy项目3:爬取当当网中机器学习的数据及价格(spider类)

1.网页解析 当当网中,人工智能数据的首页url如下为http://category.dangdang.com/cp01.54.12.00.00.00.html 点击下方的链接,一次观察各个页面的ur ...

- Python爬虫库Scrapy入门1--爬取当当网商品数据

1.关于scrapy库的介绍,可以查看其官方文档:http://scrapy-chs.readthedocs.io/zh_CN/latest/ 2.安装:pip install scrapy 注意这 ...

- [转载]JAVA获取word表格中数据的方案

上一个项目的开发中需要实现从word中读取表格数据的功能,在JAVA社区搜索了很多资料,终于找到了两个相对最佳的方案,因为也得到了不少网友们的帮助,所以不敢独自享用,在此做一个分享. 两个方案分别是: ...

- [原创]JAVA获取word表格中数据的方案

上一个项目的开发中需要实现从word中读取表格数据的功能,在JAVA社区搜索了很多资料,终于找到了两个相对最佳的方案,因为也得到了不少网友们的帮助,所以不敢独自享用,在此做一个分享. 两个方案分别是: ...

- python xlrd 模块(获取Excel表中数据)

python xlrd 模块(获取Excel表中数据) 一.安装xlrd模块 到python官网下载http://pypi.python.org/pypi/xlrd模块安装,前提是已经安装了pyt ...

- 【记录】mybatis中获取常量类中数据

部分转载,已注明来源: 1.mybatis中获取常量类中数据 <update id="refuseDebt"> UPDATE dt_debt a SET ...

- scrapy项目4:爬取当当网中机器学习的数据及价格(CrawlSpider类)

scrapy项目3中已经对网页规律作出解析,这里用crawlspider类对其内容进行爬取: 项目结构与项目3中相同如下图,唯一不同的为book.py文件 crawlspider类的爬虫文件book的 ...

- scrapy获取汽车之家数据

1.创建scrapy项目 >scrapy startproject scrapy_carhome 2.找到对应接口 3.创建爬虫文件 > cd scrapy_carhome\scrapy_ ...

随机推荐

- 势流理论笔记:03 Hess-Smith积分方法

书接上回势流理论笔记:02 直接法与间接法 Hess-Smith方法 采用面向对象编程的思路,\(Matlab\)程序脚本,实现以下功能: 输入面元(四边形面元顶点坐标) 输出系数矩阵\([H][M] ...

- 关于突破 SESSION 0 隔离场景发现的一些问题

0x00 Tricks 0x01 用ZwCreateThreadEx 在 Windows 10 下直接通过管理员权限+SeDebugPrivilege启用. 0x02 用CreateRemoteThr ...

- 10.7 URI

URI: Uniform Resource Identifier 统一资源标识符 URL: Uniform Resource Locator 统一资源定位符 URN: Uniform R ...

- Linux下iptables学习笔记

Linux下iptables学习笔记 在Centos7版本之后,防火墙应用已经由从前的iptables转变为firewall这款应用了.但是,当今绝大多数的Linux版本(特别是企业中)还是使用的6. ...

- UOJ 2021 NOI Day2 部分题解

获奖名单 题目传送门 Solution 不难看出,若我们单个 \(x\) 连 \((0,x),(x,0)\),两个连 \((x,y),(y,x)\) ,除去中间过对称轴的一个两个组,就是找很多个欧拉回 ...

- CF123E Maze(期望dp,树形dp,式子)

题目大意: 给你一棵树,边权都是1,每一个点有一个是起点的概率和一个是终点的概率,你将以起点为根,开始在树上随机dfs,每到一个点,就会将他的所有儿子随机打乱成序列,然后按照那个随机顺序走完,直到走到 ...

- Java(12)方法的重载

作者:季沐测试笔记 原文地址:https://www.cnblogs.com/testero/p/15201592.html 博客主页:https://www.cnblogs.com/testero ...

- SpringCloud-SpringBoot-SpringCloudAlibaba对应版本选择

一.SpringCloud-SpringBoot 对应的版本选择 SpringCloud官网常规方式只能查看最新的几个版本信息 https://spring.io/projects/spring-cl ...

- Linux信号处理编程

01. 学习目标 了解信号中的基本概念 熟练使用信号相关的函数 了解内核中的阻塞信号集和未决信号集作用 熟悉信号集操作相关函数 熟练使用信号捕捉函数signal 熟练使用信号捕捉函数sigaction ...

- 【UE4 设计模式】观察者模式 Observer Pattern

概述 描述 定义对象间的一种一对多依赖关系,使得每当一个对象状态发生改变时,其相关依赖对象皆得到通知并被自动更新.观察者模式又叫做 发布-订阅(Publish/Subscribe)模式 模型-视图(M ...