OpenCV开发笔记(六十三):红胖子8分钟带你深入了解SIFT特征点(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载

原博主博客地址:https://blog.csdn.net/qq21497936

原博主博客导航:https://blog.csdn.net/qq21497936/article/details/102478062

本文章博客地址:https://blog.csdn.net/qq21497936/article/details/106755662

各位读者,知识无穷而人力有穷,要么改需求,要么找专业人士,要么自己研究

红胖子(红模仿)的博文大全:开发技术集合(包含Qt实用技术、树莓派、三维、OpenCV、OpenGL、ffmpeg、OSG、单片机、软硬结合等等)持续更新中…(点击传送门)

上一篇:《OpenCV开发笔记(六十二):红胖子8分钟带你深入了解亚像素角点检测(图文并茂+浅显易懂+程序源码)》

下一篇:持续补充中…

前言

红胖子,来也!

识别除了传统的模板匹配之外就是体征点了,此篇介绍了SIFT特征点提取使用方法。

Demo

SIFT特征点

概述

SIFT,即尺度不变特征变换(Scale-invariant feature transform,SIFT),是用于图像处理领域的一种描述。这种描述具有尺度不变性,可在图像中检测出关键点,是一种局部特征描述子。

SIFT算法特点

- SIFT特征是局部特征,其对旋转、尺度缩放、亮度变化保持不变性,对视角变化、仿射变换、噪声也保持一定程度的稳定性;

- 区分性(Distinctiveness)好,信息量丰富,适用于在海量特征数据库中进行快速、准确的匹配;

- 多量性,即使少数的几个物体也可以产生大量的SIFT特征向量;

- 高速性,经优化的SIFT匹配算法甚至可以达到实时的要求;

- 可扩展性,可以很方便的与其他形式的特征向量进行联合;

特征检测步骤

步骤一:尺度空间极值检测

搜索所有尺度上的图像位置。通过高斯微分函数来识别潜在的对于尺度和旋转不变的兴趣点。

过程了解,知道实现的基本原理,如下图:

步骤二:关键点定位

在每个候选的位置上,通过一个拟合精细的模型来确定位置和尺度。关键点的选择依据于它们的稳定程度。

采用的方法是LoG近似DoG找到关键点<检测DOG尺度空间极值点>

步骤三:方向确定

基于图像局部的梯度方向,分配给每个关键点位置一个或多个方向。所有后面的对图像数据的操作都相对于关键点的方向、尺度和位置进行变换,从而提供对于这些变换的不变性。

步骤四:关键点描述

在每个关键点周围的邻域内,在选定的尺度上测量图像局部的梯度。这些梯度被变换成一种表示,这种表示允许比较大的局部形状的变形和光照变化。

每一个关键点,都拥有位置、尺度以及方向三个信息。为每个关键点建立一个描述符,用一组向量将这个关键点描述出来,使其不随各种变化而改变,比如光照变化、视角变化等等。这个描述子不但包括关键点,也包含关键点周围对其有贡献的像素点,并且描述符应该有较高的独特性,以便于提高特征点正确匹配的概率。

SiftFeatureDetector类

该类是opencv中nonfree模块中的,之前没有勾选,需要需要重新勾选编译才会有的,所以按照3.4的最新版本为3.4.10,笔者重新编译了一个版本,带contrib模块,编译请参考博文《OpenCV开发笔记(三十四):红胖子带你小白式编译Qt+openCV3.4.1+opencv_contrib(全网最简单最强,可读性最高,没有之一)》,配置时,需要额外勾选下图显示的项:

编译好后,头文件和库替换,重新连接到3.4.10版本,使用sift。

需要添加头文件:

#include <opencv2/xfeatures2d.hpp>

SiftFeatureDetector类的使用

cv::Ptr<cv::xfeatures2d::SIFT> _pSift = cv::xfeatures2d::SiftFeatureDetector::create();

std::vector<cv::KeyPoint> keyPoints1;

//特征点检测

_pSift->detect(srcMat, keyPoints1);

SIFT宏定义

typedef SIFT SiftFeatureDetector;

typedef SIFT SiftDescriptorExtractor;

SIFT相关函数原型

static Ptr<xfeatures2d::SIFT> create(int nfeatures = 0,

int nOctaveLayers = 3,

double contrastThreshold = 0.04,

double edgeThreshold = 10,

double sigma = 1.6);

- 参数一:int类型的nfeatures,默认值0,nfeatures要保留的最佳特征点数。这些特征是按分数排列的(用SIFT算法作为局部对比度);

- 参数二:int类型的nOctaveLayers,默认值3,每八度音阶的层数。3是D.Lowe纸张中使用的值。这个八度音阶数是根据图像分辨率自动计算出来的;

- 参数三:double类型的contrastThreshold,默认值0.04,用于半均匀滤除弱特征的对比度阈值(低对比度)区域。阈值越大,检测器产生的特征越少;

- 参数四:double类型的edgeThreshold,默认值10,用于滤除边缘状特征的阈值。注意它的含义与对比度阈值不同,即边缘阈值越大,特征越少过滤掉(保留更多功能)。

- 参数五:double类型的sigma,默认值1.6,高斯的sigma,应用于输入图像的标准偏差。

void xfeatures2d::SIFT::detect( InputArray image,

std::vector<KeyPoint>& keypoints,

InputArray mask=noArray() );

- 参数一:InputArray类型的image,输入cv::Mat;

- 参数二:std::Vector类型的keypoints,检测到的关键点;

- 参数三:InputArray类型的mask,默认为空,指定在何处查找关键点的掩码(可选)。它必须是8位整数感兴趣区域中具有非零值的矩阵。

void xfeatures2d::SIFT::compute( InputArray image,

std::vector<KeyPoint>& keypoints,

OutputArray descriptors );

- 参数一:InputArray类型的image,输入cv::Mat;

- 参数二:std::Vector类型的keypoints,描述符不能为其已删除计算的。有时可以添加新的关键点,例如:SIFT duplicates keypoint有几个主要的方向(每个方向);

- 参数三:OutputArray类型的descriptors,计算描述符;

// 该函数结合了detect和compute,参照detect和compute函数参数

void xfeatures2d::SIFT::detectAndCompute( InputArray image,

InputArray mask,

std::vector<KeyPoint>& keypoints,

OutputArray descriptors,

bool useProvidedKeypoints=false );

绘制关键点函数原型

void drawKeypoints( InputArray image,

const std::vector<KeyPoint>& keypoints,

InputOutputArray outImage,

const Scalar& color=Scalar::all(-1),

int flags=DrawMatchesFlags::DEFAULT );

- 参数一:InputArray类型的image,;

- 参数二:std::Vector类型的keypoints,原图的关键点;

- 参数三:InputOutputArray类型的outImage,其内容取决于定义在输出图像。请参阅参数五的标志flag);

- 参数四:cv::Scalar类型的color,绘制关键点的颜色,默认为Scalar::all(-1)随机颜色,每个点都是这个颜色,那么随机时,每个点都是随机的;

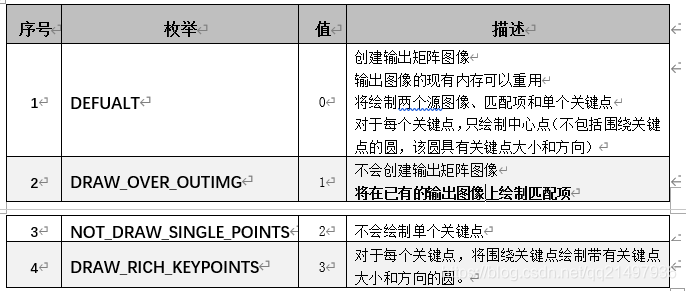

- 参数五:int类型的flags,默认为DEFAULT,具体参照DrawMatchesFlags枚举如下:

相关博客

本源码中包含了“透视变换”,请参照博文《OpenCV开发笔记(五十一):红胖子8分钟带你深入了解透视变换(图文并茂+浅显易懂+程序源码)》

Demo源码

void OpenCVManager::testSiftFeatureDetector()

{

QString fileName1 = "16.jpg";

int width = 400;

int height = 300;

cv::Mat srcMat = cv::imread(fileName1.toStdString());

cv::resize(srcMat, srcMat, cv::Size(width, height));

cv::String windowName = _windowTitle.toStdString();

cvui::init(windowName);

cv::Mat windowMat = cv::Mat(cv::Size(srcMat.cols * 2, srcMat.rows * 3),

srcMat.type());

cv::Ptr<cv::xfeatures2d::SIFT> _pSift = cv::xfeatures2d::SiftFeatureDetector::create();

int k1x = 0;

int k1y = 0;

int k2x = 100;

int k2y = 0;

int k3x = 100;

int k3y = 100;

int k4x = 0;

int k4y = 100;

while(true)

{

windowMat = cv::Scalar(0, 0, 0);

cv::Mat mat;

// 原图先copy到左边

mat = windowMat(cv::Range(srcMat.rows * 1, srcMat.rows * 2),

cv::Range(srcMat.cols * 0, srcMat.cols * 1));

cv::addWeighted(mat, 0.0f, srcMat, 1.0f, 0.0f, mat);

{

std::vector<cv::KeyPoint> keyPoints1;

std::vector<cv::KeyPoint> keyPoints2;

cvui::printf(windowMat, 0 + width * 1, 10 + height * 0, "k1x");

cvui::trackbar(windowMat, 0 + width * 1, 20 + height * 0, 165, &k1x, 0, 100);

cvui::printf(windowMat, 0 + width * 1, 70 + height * 0, "k1y");

cvui::trackbar(windowMat, 0 + width * 1, 80 + height * 0, 165, &k1y, 0, 100);

cvui::printf(windowMat, width / 2 + width * 1, 10 + height * 0, "k2x");

cvui::trackbar(windowMat, width / 2 + width * 1, 20 + height * 0, 165, &k2x, 0, 100);

cvui::printf(windowMat, width / 2 + width * 1, 70 + height * 0, "k2y");

cvui::trackbar(windowMat, width / 2 + width * 1, 80 + height * 0, 165, &k2y, 0, 100);

cvui::printf(windowMat, 0 + width * 1, 10 + height * 0 + height / 2, "k3x");

cvui::trackbar(windowMat, 0 + width * 1, 20 + height * 0 + height / 2, 165, &k3x, 0, 100);

cvui::printf(windowMat, 0 + width * 1, 70 + height * 0 + height / 2, "k3y");

cvui::trackbar(windowMat, 0 + width * 1, 80 + height * 0 + height / 2, 165, &k3y, 0, 100);

cvui::printf(windowMat, width / 2 + width * 1, 10 + height * 0 + height / 2, "k4x");

cvui::trackbar(windowMat, width / 2 + width * 1, 20 + height * 0 + height / 2, 165, &k4x, 0, 100);

cvui::printf(windowMat, width / 2 + width * 1, 70 + height * 0 + height / 2, "k4y");

cvui::trackbar(windowMat, width / 2 + width * 1, 80 + height * 0 + height / 2, 165, &k4y, 0, 100);

std::vector<cv::Point2f> srcPoints;

std::vector<cv::Point2f> dstPoints;

srcPoints.push_back(cv::Point2f(0.0f, 0.0f));

srcPoints.push_back(cv::Point2f(srcMat.cols - 1, 0.0f));

srcPoints.push_back(cv::Point2f(srcMat.cols - 1, srcMat.rows - 1));

srcPoints.push_back(cv::Point2f(0.0f, srcMat.rows - 1));

dstPoints.push_back(cv::Point2f(srcMat.cols * k1x / 100.0f, srcMat.rows * k1y / 100.0f));

dstPoints.push_back(cv::Point2f(srcMat.cols * k2x / 100.0f, srcMat.rows * k2y / 100.0f));

dstPoints.push_back(cv::Point2f(srcMat.cols * k3x / 100.0f, srcMat.rows * k3y / 100.0f));

dstPoints.push_back(cv::Point2f(srcMat.cols * k4x / 100.0f, srcMat.rows * k4y / 100.0f));

cv::Mat M = cv::getPerspectiveTransform(srcPoints, dstPoints);

cv::Mat srcMat2;

cv::warpPerspective(srcMat,

srcMat2,

M,

cv::Size(srcMat.cols, srcMat.rows),

cv::INTER_LINEAR,

cv::BORDER_CONSTANT,

cv::Scalar::all(0));

mat = windowMat(cv::Range(srcMat.rows * 1, srcMat.rows * 2),

cv::Range(srcMat.cols * 1, srcMat.cols * 2));

cv::addWeighted(mat, 0.0f, srcMat2, 1.0f, 0.0f, mat);

//特征点检测

_pSift->detect(srcMat, keyPoints1);

//绘制特征点(关键点)

cv::Mat resultShowMat;

cv::drawKeypoints(srcMat,

keyPoints1,

resultShowMat,

cv::Scalar(0, 0, 255),

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

mat = windowMat(cv::Range(srcMat.rows * 2, srcMat.rows * 3),

cv::Range(srcMat.cols * 0, srcMat.cols * 1));

cv::addWeighted(mat, 0.0f, resultShowMat, 1.0f, 0.0f, mat);

//特征点检测

_pSift->detect(srcMat2, keyPoints2);

//绘制特征点(关键点)

cv::Mat resultShowMat2;

cv::drawKeypoints(srcMat2,

keyPoints2,

resultShowMat2,

cv::Scalar(0, 0, 255),

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

mat = windowMat(cv::Range(srcMat.rows * 2, srcMat.rows * 3),

cv::Range(srcMat.cols * 1, srcMat.cols * 2));

cv::addWeighted(mat, 0.0f, resultShowMat2, 1.0f, 0.0f, mat);

cv::imshow(windowName, windowMat);

}

// 更新

cvui::update();

// 显示

// esc键退出

if(cv::waitKey(25) == 27)

{

break;

}

}

}

工程模板:对应版本号v1.57.0

对应版本号v1.57.0

上一篇:《OpenCV开发笔记(六十二):红胖子8分钟带你深入了解亚像素角点检测(图文并茂+浅显易懂+程序源码)》

下一篇:持续补充中…

原博主博客地址:https://blog.csdn.net/qq21497936

原博主博客导航:https://blog.csdn.net/qq21497936/article/details/102478062

本文章博客地址:https://blog.csdn.net/qq21497936/article/details/106755662

OpenCV开发笔记(六十三):红胖子8分钟带你深入了解SIFT特征点(图文并茂+浅显易懂+程序源码)的更多相关文章

- OpenCV开发笔记(五十六):红胖子8分钟带你深入了解多种图形拟合逼近轮廓(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(六十四):红胖子8分钟带你深入了解SURF特征点(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(六十五):红胖子8分钟带你深入了解ORB特征点(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(六十九):红胖子8分钟带你使用传统方法识别已知物体(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(五十五):红胖子8分钟带你深入了解Haar、LBP特征以及级联分类器识别过程(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(七十一):红胖子8分钟带你深入级联分类器训练

前言 红胖子,来也! 做图像处理,经常头痛的是明明分离出来了(非颜色的),分为几块区域,那怎么知道这几块区域到底哪一块是我们需要的,那么这部分就涉及到需要识别了. 识别可以自己写模板匹配.特征 ...

- OpenCV开发笔记(七十三):红胖子8分钟带你使用opencv+dnn+yolov3识别物体

前言 级联分类器的效果并不是很好,准确度相对深度学习较低,上一章节使用了dnn中的tensorflow,本章使用yolov3模型,识别出具体的分类. Demo 320x320,置信度0 ...

- OpenCV开发笔记(七十二):红胖子8分钟带你使用opencv+dnn+tensorFlow识别物体

前言 级联分类器的效果并不是很好,准确度相对深度学习较低,本章使用opencv通过tensorflow深度学习,检测已有模型的分类. Demo 可以猜测,1其实是人,18序号类是狗 ...

- OpenCV开发笔记(七十四):OpenCV3.4.1+ffmpeg3.4.8交叉编译移植到海思平台Hi35xx平台

前言 移植opencv到海思平台,opencv支持对视频进行解码,需要对应的ffmpeg支持. Ffmpeg的移植 Ffmpeg的移植请参考之前的文章:<FFmpeg开发笔记(十): ...

- Django开发笔记六

Django开发笔记一 Django开发笔记二 Django开发笔记三 Django开发笔记四 Django开发笔记五 Django开发笔记六 1.登录功能完善 登录成功应该是重定向到首页,而不是转发 ...

随机推荐

- [转帖]s3fs - 使用S3FS存储桶目录允许其他用户使用权限

https://www.coder.work/article/6661505 我在使用S3FS时遇到问题.我正在使用 ubuntu@ip-x-x-x-x:~$ /usr/bin/s3fs --ve ...

- [转帖]如何部署windows版本的oswatcher

2017-02-22 没有评论 windows上也有os watcher:OSWFW. 目前支持的windows版本是: Windows XP (x86 & x64)Windows 7 (x8 ...

- [转帖]configure: error: cannot guess build type;you must specify one

该问题一般出现在国产平台,从错误描述来看,意思是:无法猜测build类型,你必须指定一个. 解决办法: 1. 在系统/usr路径下搜索 config.guess 和 config.sub 这两个文件. ...

- 【转帖】奇淫技巧 | route命令设置网络优先级

奇淫技巧 | route命令设置网络优先级 https://blog.csdn.net/DynmicResource/article/details/120134745 1. 背景 在生活中的会经常遇 ...

- [转帖]五类IP的范围

五类IP的范围 IP地址分为A,B,C,D,E五类. 网络号:用于识别主机所在的网络: 主机号:用于识别该网络中的主机. 其中A类分配给政府机关使用,B类地址给大中型企业使用,C类地址给个人使用.这 ...

- ubuntu18.04 安装wine以及添加mono和gecko打开简单.net应用的方法

1. 今天突然想试试能不能用ubuntu跑一下公司的.net的智能客户端(SmartClient). 想到的办法就是 安装wine 但是过程略坑..这里简单说一下总结之后的过程. 2. 第一步安装wi ...

- K8S 使用loki 监控 应用日志的搭建办法

1. 背景 这几天一直在用k8s部署分SU的测试环境,开发反馈看日志比较麻烦. 昨天晚上在家里本来想搭建ELK 发现比较重, 又说有一个比较轻量级的 loki 可以实现使用grafana进行监控和查看 ...

- 大数据面试题集锦-Hadoop面试题(五)-优化

你准备好面试了吗?这里有一些面试中可能会问到的问题以及相对应的答案.如果你需要更多的面试经验和面试题,关注一下"张飞的猪大数据分享"吧,公众号会不定时的分享相关的知识和资料. 1. ...

- vim 从嫌弃到依赖(21)——跨文件搜索

之前介绍了vim中的搜索模式,使用正则表达式可以很方便的在一个文件中进行搜索.后续也介绍了如何使用 argsdo 命令在参数列表中进行替换操作.但是到目前为止还没有介绍如何在工程目录中进行搜索,而这个 ...

- MybatisPlus对Mysql数据库关键字作为列名的处理--SQLSyntaxErrorException: You have an error in your SQL syntax;

说明: 在设计数据库时,使用mysql关键字作为列名(比如order用于排序),就会报错:java.sql.SQLSyntaxErrorException: You have an error in ...