(三)xpath爬取4K高清美女壁纸

功能:通过xpath爬取彼岸图网的高清美女壁纸

url = 'http://pic.netbian.com/4kmeinv/'

1. 通过url请求整张页面的数据

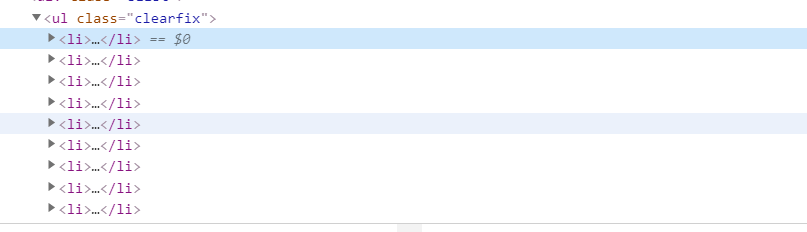

2.通过页面的标签定位图片所在的位置

3.找到所有图片的通用的标签

向图片标签的父级查找,可以发现每一张图片都在ul下的li标签下。

4.知道每一个li标签下图片所处的位置

5.思路:通过url拿到整张页面的数据,通过etree进行标签定位,拿到所有的li标签,再循环对每一个li标签下的每一个图片发送请求,拿到图片。

import requests

from lxml import etree

import os

import time

if not os.path.exists('./4kPic'):

os.makedirs('./4kPic')

url ='http://pic.netbian.com/4kmeinv/'

headers={

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.92 Safari/537.36',

}

response = requests.get(url=url,headers=headers)

# 获取网页所有数据

page_text = response.text

# 实例化etree对象

tree = etree.HTML(page_text)

# 找到所有的li标签

li_list = tree.xpath("//div[@class='slist']/ul/li")

# 遍历所有li标签

for li in li_list:

# 局部解析用./表示当前的li标签

img_src = li.xpath('.//img/@src')[0] # 获取图片路径

img_alt = li.xpath('.//img/@alt')[0] # 获取图片名称

# 解决中文乱码问题的通用方式

img_name = img_alt.encode('iso-8859-1').decode('gbk')

# 获取图片完整路径

img_url = 'http://pic.netbian.com'+img_src

try:

# content获取图片的二进制数据 文件传输都是以二进制的形式

img_data = requests.get(url=img_url, headers=headers).content

except requests.exceptions.ConnectionError:

time.sleep(1) # 数据请求过快会请求失败 可以time.sleep

continue

fileName = img_name+'.jpg'

with open('4kPic/'+fileName,'wb') as f:

f.write(img_data)

print(img_name+'--------------爬取成功')

注:解决中文乱码问题的方式

方式1:

response.encoding='utf-8' 有些数据不能直接用utf8编码 这不是一种通用的方式

方式2:

img_name = img_alt.encode('iso-8859-1').decode('gbk') 这种为通用方式

(三)xpath爬取4K高清美女壁纸的更多相关文章

- 实例学习——爬取Pexels高清图片

近来学习爬取Pexels图片时,发现书上代码会抛出ConnectionError,经查阅资料知,可能是向网页申请过于频繁被禁,可使用time.sleep(),减缓爬取速度,但考虑到爬取数据较多,运行时 ...

- 别人用钱,而我用python爬虫爬取了一年的4K高清壁纸

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取htt ...

- python网络爬虫之解析网页的正则表达式(爬取4k动漫图片)[三]

前言 hello,大家好 本章可是一个重中之重,因为我们今天是要爬取一个图片而不是一个网页或是一个json 所以我们也就不用用到selenium模块了,当然有兴趣的同学也一样可以使用selenium去 ...

- python网络爬虫之解析网页的XPath(爬取Path职位信息)[三]

目录 前言 XPath的使用方法 XPath爬取数据 后言 @(目录) 前言 本章同样是解析网页,不过使用的解析技术为XPath. 相对于之前的BeautifulSoup,我感觉还行,也是一个比较常用 ...

- Python爬虫实战 批量下载高清美女图片

彼岸图网站里有大量的高清图片素材和壁纸,并且可以免费下载,读者也可以根据自己需要爬取其他类型图片,方法是类似的,本文通过python爬虫批量下载网站里的高清美女图片,熟悉python写爬虫的基本方法: ...

- 爬虫系列2:Requests+Xpath 爬取租房网站信息

Requests+Xpath 爬取租房网站信息 [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]:参考前文 ...

- 爬虫系列1:Requests+Xpath 爬取豆瓣电影TOP

爬虫1:Requests+Xpath 爬取豆瓣电影TOP [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]: ...

- 爬虫系列(十) 用requests和xpath爬取豆瓣电影

这篇文章我们将使用 requests 和 xpath 爬取豆瓣电影 Top250,下面先贴上最终的效果图: 1.网页分析 (1)分析 URL 规律 我们首先使用 Chrome 浏览器打开 豆瓣电影 T ...

- 爬虫系列(十一) 用requests和xpath爬取豆瓣电影评论

这篇文章,我们继续利用 requests 和 xpath 爬取豆瓣电影的短评,下面还是先贴上效果图: 1.网页分析 (1)翻页 我们还是使用 Chrome 浏览器打开豆瓣电影中某一部电影的评论进行分析 ...

- 爬虫系列4:Requests+Xpath 爬取动态数据

爬虫系列4:Requests+Xpath 爬取动态数据 [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]:参 ...

随机推荐

- 5款开源、美观、强大的WPF UI组件库

前言 经常看到有小伙伴在DotNetGuide技术社区交流群里提问:WPF有什么好用或者好看的UI组件库?,今天大姚给大家分享5款开源.美观.强大.简单易用的WPF UI组件库. WPF介绍 WPF ...

- iLogtail社区版使用入门 - 采集MySQL Binlog

简介: MySQL Binlog记录了MySQL的变更日志,业界也有一些方案来同步Binlog的数据,如Canal.MaxWell.DTS等.不同的工具可以实现不同的目标,iLogtail也提供了便捷 ...

- Redis消息队列发展历程

简介:Redis是目前最受欢迎的kv类数据库,当然它的功能越来越多,早已不限定在kv场景,消息队列就是Redis中一个重要的功能.Redis从2010年发布1.0版本就具备一个消息队列的雏形,随着1 ...

- K8s Ingress Provider 为什么选择 MSE 云原生网关?

简介:在虚拟化时期的微服务架构下,业务通常采用流量网关 + 微服务网关的两层架构,流量网关负责南北向流量调度和安全防护,微服务网关负责东西向流量调度和服务治理,而在容器和 K8s 主导的云原生时代, ...

- 阿里云云效技术专家:一文详解kubernetes下5种常见发布模式如何选择

简介: Kubernetes下5场场景应用发布方式的选择,每种发布模式适合什么样的场景,以及如何在阿里云云效上高效落地. 作者:郑云龙,阿里云云效技术专家 Kubernetes面向通用场景提供了非常灵 ...

- 如何避免JS内存泄漏?

简介: 很多开发者可能平时并不关心自己维护的页面是否存在内存泄漏,原因可能是刚开始简单的页面内存泄漏的速度很缓慢,在造成严重卡顿之前可能就被用户刷新了,问题也就被隐藏了,但是随着页面越来越复杂,尤 ...

- DataWorks 功能实践速览

简介: DataWorks功能实践系列,帮助您解析业务实现过程中的痛点,提高业务功能使用效率! 功能推荐:独享数据集成资源组 如上期数据同步解决方案介绍,数据集成的批数据同步任务运行时,需要占用一定 ...

- Flink 在 58 同城的应用与实践

简介: 58 同城的实时 SQL 建设以及如何从 Storm 迁移至 Flink. 本文整理自 58 同城实时计算平台负责人冯海涛在 Flink Forward Asia 2020 分享的议题< ...

- HarmonyOS 实战开发-Worker子线程中解压文件

介绍 本示例介绍在Worker子线程使用@ohos.zlib提供的zlib.decompressfile接口对沙箱目录中的压缩文件进行解压操作,解压成功后将解压路径返回主线程,获取解压文件列表. 效果 ...

- [Gin] 运行模式检测和设置 (mode.go)

// 设置方式 gin.SetMode(gin.ReleaseMode) // 检测方式 if gin.Mode() == gin.DebugMode { } 更多相关信息,建议直接去看源代码. Re ...