centos-7部署kafka-v2.13.3.0.1集群

1、部署测试机器规划

| ip | kafka 版本 | zookeeper 版本 |

| 192.168.113.132 | v2.13.3.0.1 | v3.6.3 |

| 192.168.113.135 | v2.13.3.0.1 | v3.6.3 |

| 192.168.113.136 | v2.13.3.0.1 | v3.6.3 |

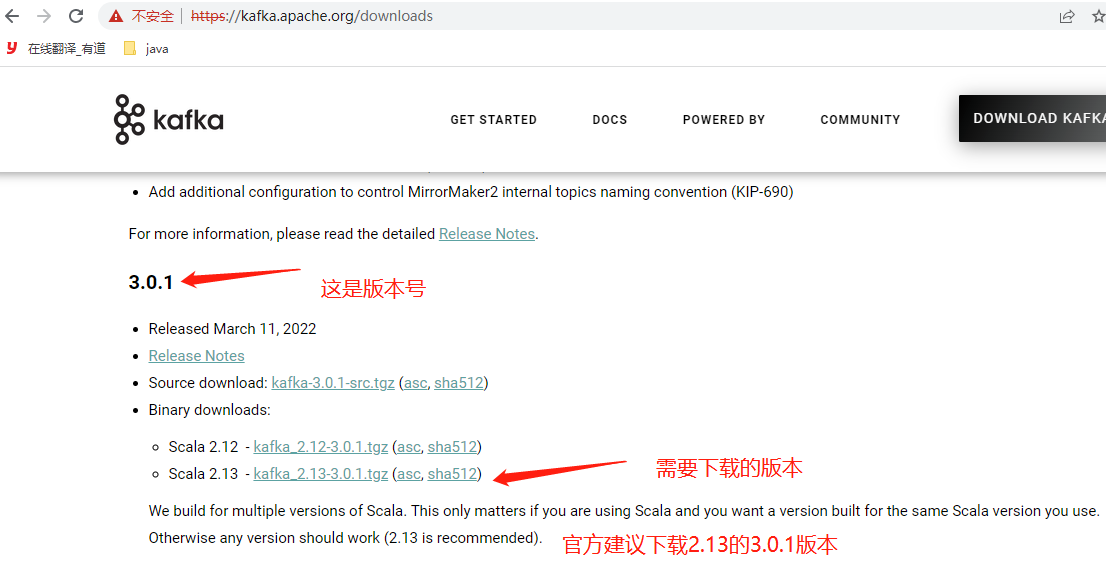

kafka下载官网:https://kafka.apache.org/downloads.html

[root@localhost ~]# cd /opt/ #计划安装kafka的位置

[root@localhost opt]# wget https://archive.apache.org/dist/kafka/3.0.1/kafka_2.13-3.0.1.tgz #下载包

[root@localhost opt]# tar xf kafka_2.13-3.0.1.tgz #解压

[root@localhost opt]# mv kafka_2.13-3.0.1/ kafka #重命名

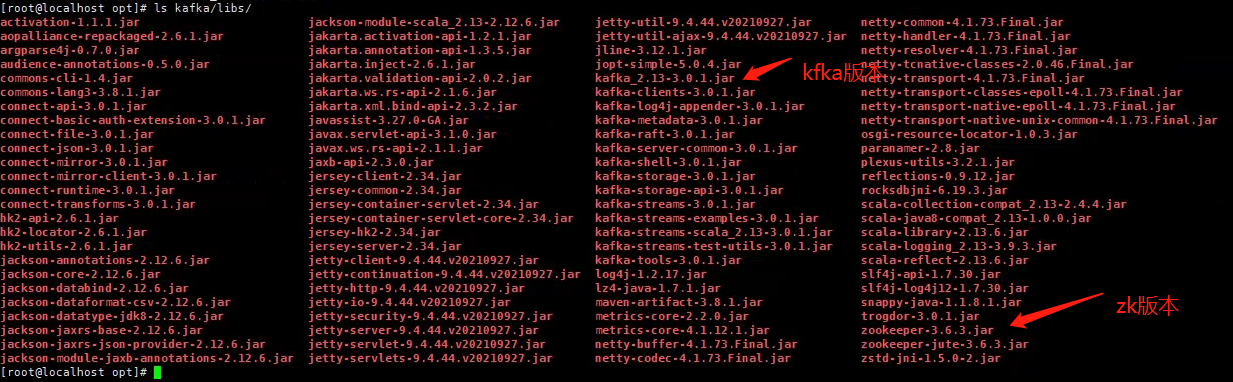

[root@localhost opt]# ls kafka/libs/ #查看kfaka的包名查看zk的版本,如果不使用kafka包里面自带的zk服务,自己搭建的话,最好下载对应版本的zk

zookeeper下载官网:http://zookeeper.apache.org/

下载二进制包

每台节点执行操作

[root@localhost ~]# cd /opt/

[root@localhost opt]# wget https://dlcdn.apache.org/zookeeper/zookeeper-3.6.3/apache-zookeeper-3.6.3-bin.tar.gz --no-check-certificate

[root@localhost opt]# tar xf apache-zookeeper-3.6.3-bin.tar.gz

[root@localhost opt]# mv apache-zookeeper-3.6.3-bin zookeeper2、使用二进制安装zookeeper集群

应用场景:ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件。

它是一个为分布式应用提供一致性服务的软件,提供的功能包括:配置维护、域名服务、分布式同步、组服务等

kafka需要使用zookeeper来进行调度所以首先安装,也可以不单独安装直接使用kafka包里面的zookeeper进行配置启动,但是建议单独安装

2.1、前面已经将包下载好并解压重命名了,接下来进行配置zookeeper

没安装jdk的先安装jdk,我这里是yum安装的也可以下载二进制包进行

[root@localhost conf]# yum -y install java-1.8.0-openjdk*对每台节点进行操作

[root@localhost opt]# cd zookeeper/conf/ #切换目录

[root@localhost conf]# ls #查看配置文件

configuration.xsl log4j.properties zoo_sample.cfg

[root@localhost conf]# cp zoo_sample.cfg zoo.cfg #拷贝配置文件并重命名

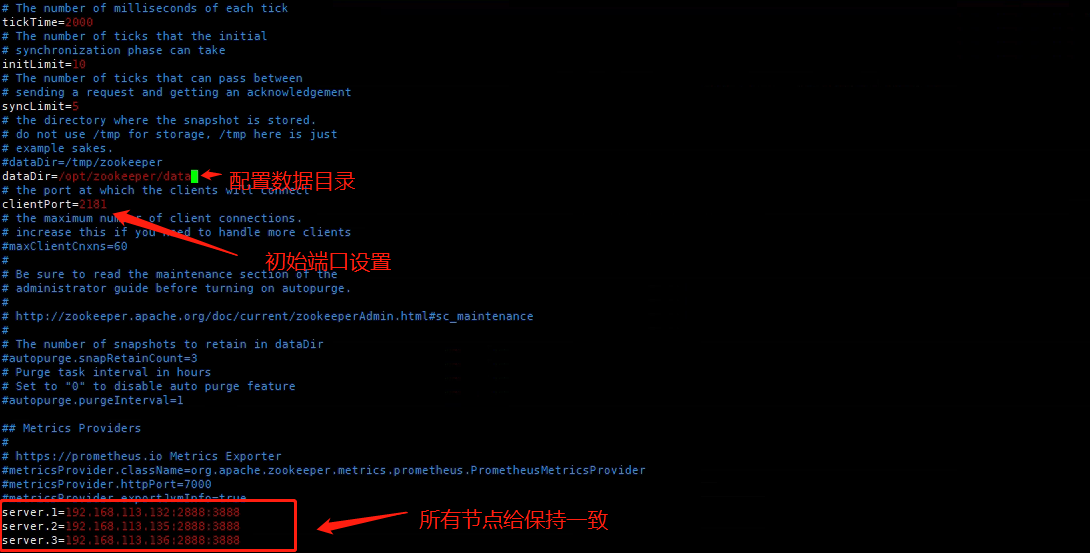

[root@localhost conf]# vim zoo.cfg #编辑配置文件进行修改

注意!zk-3.6过后的版本在开启服务器后会默认占用8080端口

可以修改配置来修改端口

# admin.serverPort 默认占8080端口

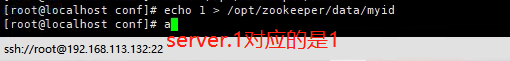

admin.serverPort=88882.2、添加myid文件这个配置是区分节点的

[root@localhost conf]# mkdir /opt/zookeeper/data

[root@localhost conf]# vim /opt/zookeeper/data/myid

[root@localhost conf]# echo 1 > /opt/zookeeper/data/myid #分别给三个server节点定向一个编号到myid文件里面(1 2 3)来进行节点区分

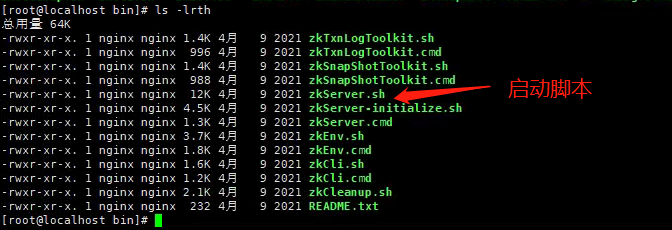

切换到启动目录

[root@localhost zookeeper]# cd /opt/zookeeper/bin/

启动zk

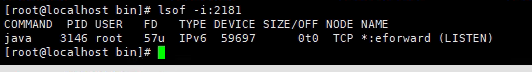

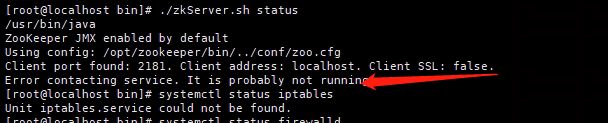

[root@localhost bin]# /opt/zookeeper/bin/zkServer.sh start #源码包安装的方式需要指定配置文件查看启动状态

提示下面错误表示没有关闭selinux或者防火墙(或者直接配置iptables规则)

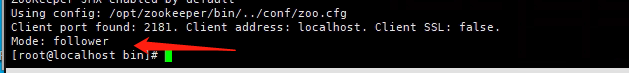

关闭防火墙跟selinux后状态正常(这是被分配到的从节点)

再看看分配到的主节点(leader)

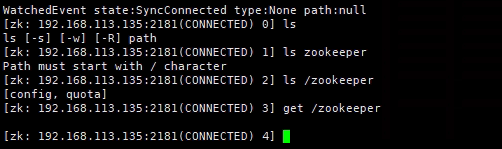

zkCli.sh客户端使用

[root@localhost bin]# ./zkCli.sh -server 192.168.113.135:2181 #连接本机

[root@localhost bin]# ./zkCli.sh -server 192.168.113.135 #不适用端口连接本机,默认去连接2181端口

[root@localhost bin]# ./zkCli.sh -server 192.168.113.132:2181 #连接到其他机器

2.3、为了安全起见可以给zk集群添加ip白名单,本来zk只是kafka使用只需要集群ip能访问就可以了

登陆zookeeper

进入zookeeper安装目录下的bin目录下执行

./zkCli.sh -server ip:port

./zkCli.sh -server 192.168.113.135:2181 #例!在bin目录下面执行,进入集群的任意一台zk查看当前权限,未配置会提示允许所有

getAcl /添加可访问IP

setAcl / ip:192.168.113.132:cdrwa,ip:192.168.113.135:cdrwa,ip:192.168.113.136:cdrwa,ip:127.0.0.1:cdrwa注:1.在设置IP白名单时,将本机ip 127.0.0.1也加上,让本机也可以访问及修改

在第一次添加完ip白名单后,又想继续添加白名单,则在设置的时候,以前的ip也都是写在命令里,不然以前添加的都会被覆盖掉,那就坑了

查看是否正常添加

getAcl /如果要恢复所有ip皆可访问,则执行

setAcl / world:anyone:cdrwa3、配置kafka

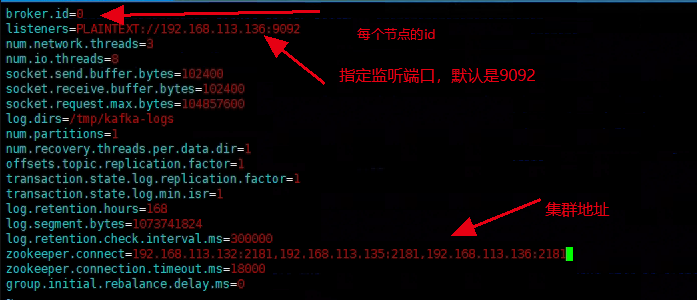

[root@localhost opt]# cd /opt/kafka/config/

[root@localhost config]# vim /opt/kafka/config/server.properties

注意!:log.dirs在生产中不要配置到tmp目录下面不然系统定时清理掉这个下面的文件会导致系统崩溃。

启动kafka

[root@localhost ~]# nohup /opt/kafka/bin/kafka-server-start.sh /opt/kafka/config/server.properties 1> /dev/null 2>&1 &测试创建topic

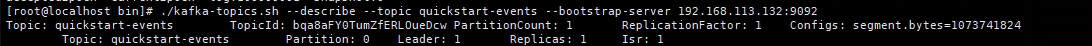

[root@localhost bin]# ./kafka-topics.sh --create --topic quickstart-events --bootstrap-server 192.168.113.132:9092查看topic

[root@localhost bin]# ./kafka-topics.sh --describe --topic quickstart-events --bootstrap-server 192.168.113.132:9092

生产者:发送消息

[root@localhost bin]# ./kafka-console-producer.sh --topic quickstart-events --bootstrap-server 192.168.113.132:9092消费者:处理消息

[root@localhost bin]# ./kafka-console-consumer.sh --topic quickstart-events --from-beginning --bootstrap-server 192.168.113.132:9092命令使用拓展

指定创建多个副本及分区

./kafka-topics.sh --create --replication-factor 2 --partitions 4 --topic quickstart-events --bootstrap-server 192.168.113.132:9092

# --replication-factor 参数是指定副本数

# --partitions 指定分区动态调整分区只能网上调不能向下

./kafka-topics.sh --alter --bootstrap-server 192.168.113.132:9092 --topic quickstart-events --partitions 12删除topic

./kafka-topics.sh --delete --bootstrap-server 192.168.113.132:9092 --topic quickstart-events kafka查看所有组

./kafka-consumer-groups.sh --bootstrap-server 192.168.113.132:9092 --list查看topIc消费组consumer的积压情况

./kafka-consumer-groups.sh --bootstrap-server 192.168.113.132:9092 --describe --group +需要查询的groupcentos-7部署kafka-v2.13.3.0.1集群的更多相关文章

- K8S学习笔记之二进制部署Kubernetes v1.13.4 高可用集群

0x00 概述 本次采用二进制文件方式部署,本文过程写成了更详细更多可选方案的ansible部署方案 https://github.com/zhangguanzhang/Kubernetes-ansi ...

- 2、kubeadm快速部署kubernetes(v1.15.0)集群190623

一.网络规划 节点网络:192.168.100.0/24 Service网络:10.96.0.0/12 Pod网络(默认):10.244.0.0/16 二.组件分布及节点规划 master(192.1 ...

- CentOS 7部署Kafka和Kafka集群

CentOS 7部署Kafka和Kafka集群 注意事项 需要启动多个shell脚本交互客户端进行验证,运行中的客户端不要停止. 准备工作: 安装java并设置java环境变量,在`/etc/prof ...

- [转帖]Breeze部署kubernetes1.13.2高可用集群

Breeze部署kubernetes1.13.2高可用集群 2019年07月23日 10:51:41 willblog 阅读数 673 标签: kubernetes 更多 个人分类: kubernet ...

- kafka2.3.1+zookeeper3.5.6+kafka-manager2.0.0.2集群部署(centos7.7)

一.准备三台服务器,配置好主机名和ip地址 二.服务器初始化:包括安装常用命令工具,修改系统时区,校对系统时间,关闭selinux,关闭firewalld,修改主机名,修改系统文件描述符,优化内核参数 ...

- Storm1.0.3集群部署

Storm集群部署 所有集群部署的基本流程都差不多:下载安装包并上传.解压安装包并配置环境变量.修改配置文件.分发安装包.启动集群.查看集群是否部署成功. 1.所有的集群上都要配置hosts vi ...

- hbase-2.0.4集群部署

hbase-2.0.4集群部署 1. 集群节点规划: rzx1 HMaster,HRegionServer rzx2 HRegionServer rzx3 HRegionServer 前提:搭建好ha ...

- lvs+keepalived部署k8s v1.16.4高可用集群

一.部署环境 1.1 主机列表 主机名 Centos版本 ip docker version flannel version Keepalived version 主机配置 备注 lvs-keepal ...

- Centos7.6部署k8s v1.16.4高可用集群(主备模式)

一.部署环境 主机列表: 主机名 Centos版本 ip docker version flannel version Keepalived version 主机配置 备注 master01 7.6. ...

- 分布式存储 CentOS6.5虚拟机环境搭建FastDFS-5.0.5集群(转载-2)

原文:http://www.cnblogs.com/PurpleDream/p/4510279.html 分布式存储 CentOS6.5虚拟机环境搭建FastDFS-5.0.5集群 前言: ...

随机推荐

- SVN 提交失败 Unexpected HTTP status 200 'OK' on 'PUT' request to

提交SVN 时 提示 Commit Failed Unexpected HTTP status 200 'OK' on 'PUT' request to 旧的文件在SVN 上也无法删除,删除文件 ...

- WCF教程 简单入门

版权 本文摘自 http://www.cnblogs.com/iamlilinfeng 本人只做了搬运工 转载请注明出处:http://www.cnblogs.com/iamlilinfeng ...

- Biba模型(MAC)

毕巴模型用完整性级别来对完整性进行量化描述. 设i1和i2是任意两个完整性级别,如果完整性级别为i2的实体比完整性级别为i1的实体具有更高的完整性,则称完整性级别i2绝对支配完整性级别i1,记为:i ...

- [前端js] 爬取亿图脑图大纲

这段程序使看到了好的东西,又没有零钱的产物 还是老师让画思维导图我不想画还想白嫖的想法 用时20分钟 就拿这个来作为例子 https://mm.edrawsoft.cn/template/286842 ...

- Hadoop环境的搭建

Hadoop HDFS.Yarn.MapReduce Hadoop集群环境搭建 完全分布式环境,伪分布式将其中的多台服务器改为一台,并将配置文件中的相关内容更改即可 1.安装Linux系统模型机 关闭 ...

- idea等工具网盘下载地址

1.idea2020 下载地址:https://caiyun.139.com/m/i?1E5C2SkIZbJH4 ,下载密码微信 搜索 "白菜拼吧" 回复 idea2020 获取 ...

- requests库获取指定关键词的图片,并保存到本地

var code = "45f4267f-9476-44ca-ac68-6d32aad2d4e1" 源码地址:https://gitee.com/myrensheng/data_a ...

- python 成功解决import librosa出错问题

在做音频处理时,用到了librosa这个库,但是一直在报错,一开始以为代码错误,后来发现import的时候就已经出错了. 我给他卸载了重新安装,结果是一样的,报错如下: Traceback (most ...

- 使用ts二次封装storage(sessionStorage/localStorage)

export class LocalCache { setCache<T = any>(key: string, value: T): boolean; setCache<T = a ...

- verilog 和system verilog 文件操作

1. 文件操作 Verilog具有系统任务和功能,可以打开文件.将值输出到文件.从文件中读取值并加 载到其他变量和关闭文件. 1.1 Verilog文件操作 1.1.1 打开和关闭文件 module ...