Spark读写ES

本文主要介绍spark sql读写es、structured streaming写入es以及一些参数的配置

ES官方提供了对spark的支持,可以直接通过spark读写es,具体可以参考ES Spark Support文档(文末有地址)。

以下是pom依赖,具体版本可以根据自己的es和spark版本进行选择:

<dependency>

<groupId>org.elasticsearch</groupId>

<artifactId>elasticsearch-spark-20_2.11</artifactId>

<version>6.0.0</version>

</dependency>

Spark SQL - ES

主要提供了两种读写方式:一种是通过DataFrameReader/Writer传入ES Source实现;另一种是直接读写DataFrame实现。在实现前,还要列一些相关的配置:

配置

| 参数 | 描述 |

|---|---|

| es.nodes.wan.only | true or false,在此模式下,连接器禁用发现,并且所有操作通过声明的es.nodes连接 |

| es.nodes | ES节点 |

| es.port | ES端口 |

| es.index.auto.create | true or false,是否自动创建index |

| es.resource | 资源路径 |

| es.mapping.id | es会为每个文档分配一个全局id。如果不指定此参数将随机生成;如果指定的话按指定的来 |

| es.batch.size.bytes | es批量API的批量写入的大小(以字节为单位) |

| es.batch.write.refresh | 批量更新完成后是否调用索引刷新 |

| es.read.field.as.array.include | 读es的时候,指定将哪些字段作为数组类型 |

列了一些常用的配置,更多配置查看ES Spark Configuration文档

DataFrameReader读ES

import org.elasticsearch.spark.sql._

val options = Map(

"es.nodes.wan.only" -> "true",

"es.nodes" -> "29.29.29.29:10008,29.29.29.29:10009",

"es.port" -> "9200",

"es.read.field.as.array.include" -> "arr1, arr2"

)

val df = spark

.read

.format("es")

.options(options)

.load("index1/info")

df.show()

DataFrameWriter写ES

import org.elasticsearch.spark.sql._

val options = Map(

"es.index.auto.create" -> "true",

"es.nodes.wan.only" -> "true",

"es.nodes" -> "29.29.29.29:10008,29.29.29.29:10009",

"es.port" -> "9200",

"es.mapping.id" -> "id"

)

val sourceDF = spark.table("hive_table")

sourceDF

.write

.format("org.elasticsearch.spark.sql")

.options(options)

.mode(SaveMode.Append)

.save("hive_table/docs")

读DataFrame

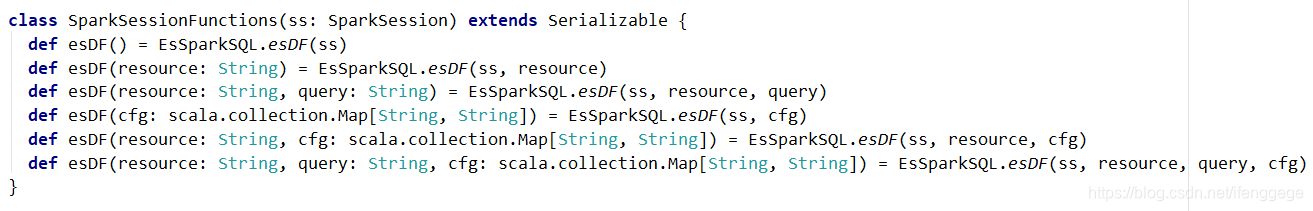

jar包中提供了esDF()方法可以直接读es数据为DataFrame,以下是源码截图。

简单说一下各个参数:

resource:资源路径,例如hive_table/docs

cfg:一些es的配置,和上面代码中的options差不多

query:指定DSL查询语句来过滤要读的数据,例如"?q=user_group_id:3"表示读user_group_id为3的数据

val options = Map(

"pushdown" -> "true",

"es.nodes.wan.only" -> "true",

"es.nodes" -> "29.29.29.29:10008,29.29.29.29:10009",

"es.port" -> "9200"

)

val df = spark.esDF("hive_table/docs", "?q=user_group_id:3", options)

df.show()

写DataFrame

jar包中提供了saveToEs()方法可以将DataFrame写入ES,以下是源码截图。

resource:资源路径,例如hive_table/docs

cfg:一些es的配置,和上面代码中的options差不多

import org.elasticsearch.spark.sql._

val options = Map(

"es.index.auto.create" -> "true",

"es.nodes.wan.only" -> "true",

"es.nodes" -> "29.29.29.29:10008,29.29.29.29:10009",

"es.port" -> "9200",

"es.mapping.id" -> "zip_record_id"

)

val df = spark.table("hive_table")

df.saveToEs("hive_table/docs", options)

Structured Streaming - ES

es也提供了对Structured Streaming的集成,使用Structured Streaming可以实时的写入ES。

import org.elasticsearch.spark.sql._

val options = Map(

"es.index.auto.create" -> "true",

"es.nodes.wan.only" -> "true",

"es.nodes" -> "29.29.29.29:10008,29.29.29.29:10009",

"es.port" -> "9200",

"es.mapping.id" -> "zip_record_id"

)

val df = spark

.readStream

.format("kafka")

.option("kafka.bootstrap.servers", "a:9092,b:9092,c:9092")

.option("subscribe", "test")

.option("failOnDataLoss", "false")

.load()

df

.writeStream

.outputMode(OutputMode.Append())

.format("es")

.option("checkpointLocation", s"hdfs://hadoop:8020/checkpoint/test01")

.options(options)

.start("test_streaming/docs")

.awaitTermination()

可能遇到的问题

数组类型转换错误

报错信息:type (scala.collection.convert.Wrappers.JListWrapper) cannot be converted to the string type

因为es的mapping只会记录字段的类型,不会记录是否是数组,也就是说如果是int数组,es的mapping只是记录成int。

可以在option中加一个es.read.field.as.array.include,标明数组字段

es.read.field.as.array.include" -> "数组字段的名字"

如果是object里的某个字段,写成"object名字.数组字段名字",如果是多个字段,字段名之间用逗号分隔

Timestamp被转为Long

DataFrame的Timestamp类型数据写入ES后,就变成了Number类型。

这可能不算个问题,时间戳本质上就是Long类型的毫秒值;但是在Hive中Timestamp是"yyyy-MM-dd HH:mm:ss"的类型,个人觉得很别扭。

尝试将Timestamp类型字段转成Date类型,写入ES后还是Number类型。网上搜了一圈也没有什么好的办法,大家有什么解决办法欢迎交流。

References

ES Spark Support文档:https://www.elastic.co/guide/en/elasticsearch/hadoop/current/spark.html#spark

ES Spark Configuration: https://www.elastic.co/guide/en/elasticsearch/hadoop/current/configuration.html

end.

个人公众号:码农峰,定时推送行业资讯,持续发布原创技术文章,欢迎大家关注。

Spark读写ES的更多相关文章

- Spark 读写hive 表

spark 读写hive表主要是通过sparkssSession 读表的时候,很简单,直接像写sql一样sparkSession.sql("select * from xx") 就 ...

- Spark读写HBase

Spark读写HBase示例 1.HBase shell查看表结构 hbase(main)::> desc 'SDAS_Person' Table SDAS_Person is ENABLED ...

- 使用Spark读写CSV格式文件(转)

原文链接:使用Spark读写CSV格式文件 CSV格式的文件也称为逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号.在本文中的CSV格 ...

- spark读写mysql

spark读写mysql除官网例子外还要指定驱动名称 travels.write .mode(SaveMode.Overwrite) .format("jdbc") .option ...

- Spark读写Hbase的二种方式对比

作者:Syn良子 出处:http://www.cnblogs.com/cssdongl 转载请注明出处 一.传统方式 这种方式就是常用的TableInputFormat和TableOutputForm ...

- spark on es 多索引查询

核心接口 trait SparkOnEsService { val conf = new SparkConf // conf.setMaster("local[10]") val ...

- spark读写Sequoiadb

spark如何读写Sequoiadb,最近被客户问多了,这个记录下. Spark读Sequoiadb数据: package marketing import com.sequoiadb.hadoop. ...

- Spark读写Hbase中的数据

def main(args: Array[String]) { val sparkConf = new SparkConf().setMaster("local").setAppN ...

- spark读写hbase性能对比

一.spark写入hbase hbase client以put方式封装数据,并支持逐条或批量插入.spark中内置saveAsHadoopDataset和saveAsNewAPIHadoopDatas ...

随机推荐

- Date和Calendar

处理日期,时间: 大部分的方法已过时,不推荐使用,但是你使用过时的方法也不会报错. Date() 分配 Date 对象并初始化此对象,以表示分配它的时间(精确到毫秒). Date(long date) ...

- java面向接口编程之适配器模式

使用一个现成的类,但是它的接口不完全符合你的需求,我只想要它其中的一个方法,不想覆写其他的方法. 比如,窗体有变大,变小,关闭的行为,但是我现在只需要关闭行为; package reviewDem ...

- js基础——面向对象(构造函数)

1.面向对象:类的标志,通过类可创建多个具有相同属性和方法的对象 2.创建对象 1)工厂模式方式:避免重复实例化但未能解决识别问题 function boss(name, age) { ...

- 2019-9-3-win10-uwp-收集-DUMP-文件

title author date CreateTime categories win10 uwp 收集 DUMP 文件 lindexi 2019-09-03 17:48:44 +0800 2018- ...

- CachedRowSet 接口

Sun Microsystems 提供的 CachedRowSet 接口的参考实现是一个标准实现.开发人员可以按原样使用此实现.可以扩展它,也可以选择自己编写此接口的实现. CachedRowSet ...

- 第二阶段:2.商业需求文档MRD:2.MRD-目标市场分析

版本管理的变更人,属性,时间以及审核人都要严格的写清楚. MRD主要面向的是参与这个需求同级别的同时或主管,让大家更好的了解这个产品的各个方面,达成共识. 现在互联网的发展周期很短,不需要看4.5年, ...

- 试着用教程跑cifar10数据

1.terminal里已经可import torchvision了,为什么Spyder里还是不能import torchvision 重启. 2. trainset = torchvision.dat ...

- linux下tomcat相关的命令

1.查看Tomcat是否以关闭 ps -ef|grep tomcat 2.直接干掉Tomcat可以使用kill命令,直接杀死Tomcat进程(这个命令用在当你关闭tomcat报错的时候直接杀死进程) ...

- 通过9个Linux-0.11实验学习操作系统

简介 2019年秋,我自学了一下哈工大的操作系统课程,感觉其设计的教程和实验作为操作系统入门是个不错的选择(虽然是基于较老的Linux-0.11写的).实验大致覆盖了操作系统中的核心概念,例如启动.中 ...

- acwing 102 -利用二分枚举区间平均值

我真的是服了,看了一晚上发现居然,,,,, 上图吧,话说有人评论没... 对于结果来说,不一定要枚举有序数列,感觉这是一种猜结果的方法,只不过特别精确,令人发指 #include<cstdio& ...