tensorflow-LSTM-网络输出与多隐层节点

本文从tensorflow的代码层面理解LSTM。

看本文之前,需要先看我的这两篇博客

https://www.cnblogs.com/yanshw/p/10495745.html 谈到网络结构

https://www.cnblogs.com/yanshw/p/10515436.html 谈到多隐层神经网络

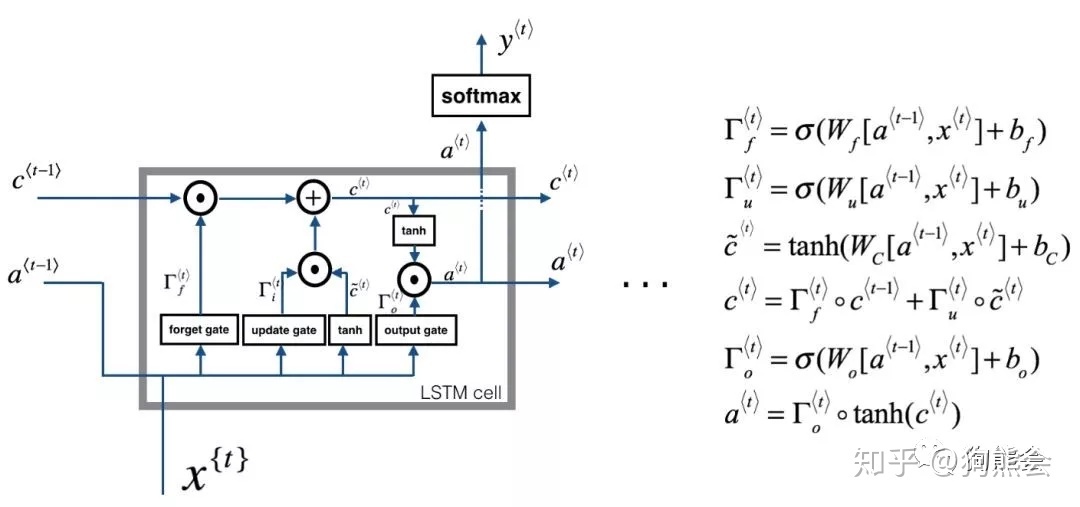

回忆一下LSTM网络

输出

tensorflow 用 tf.nn.dynamic_rnn构建LSTM的输出

lstm_cell = tf.nn.rnn_cell.BasicLSTMCell(n_hidden_number,forget_bias = 1.0)

# 初始化s

init_state = lstm_cell.zero_state(batch_size,dtype=tf.float32)

outputs,states = tf.nn.dynamic_rnn(lstm_cell,X_in,initial_state=init_state,time_major=False)

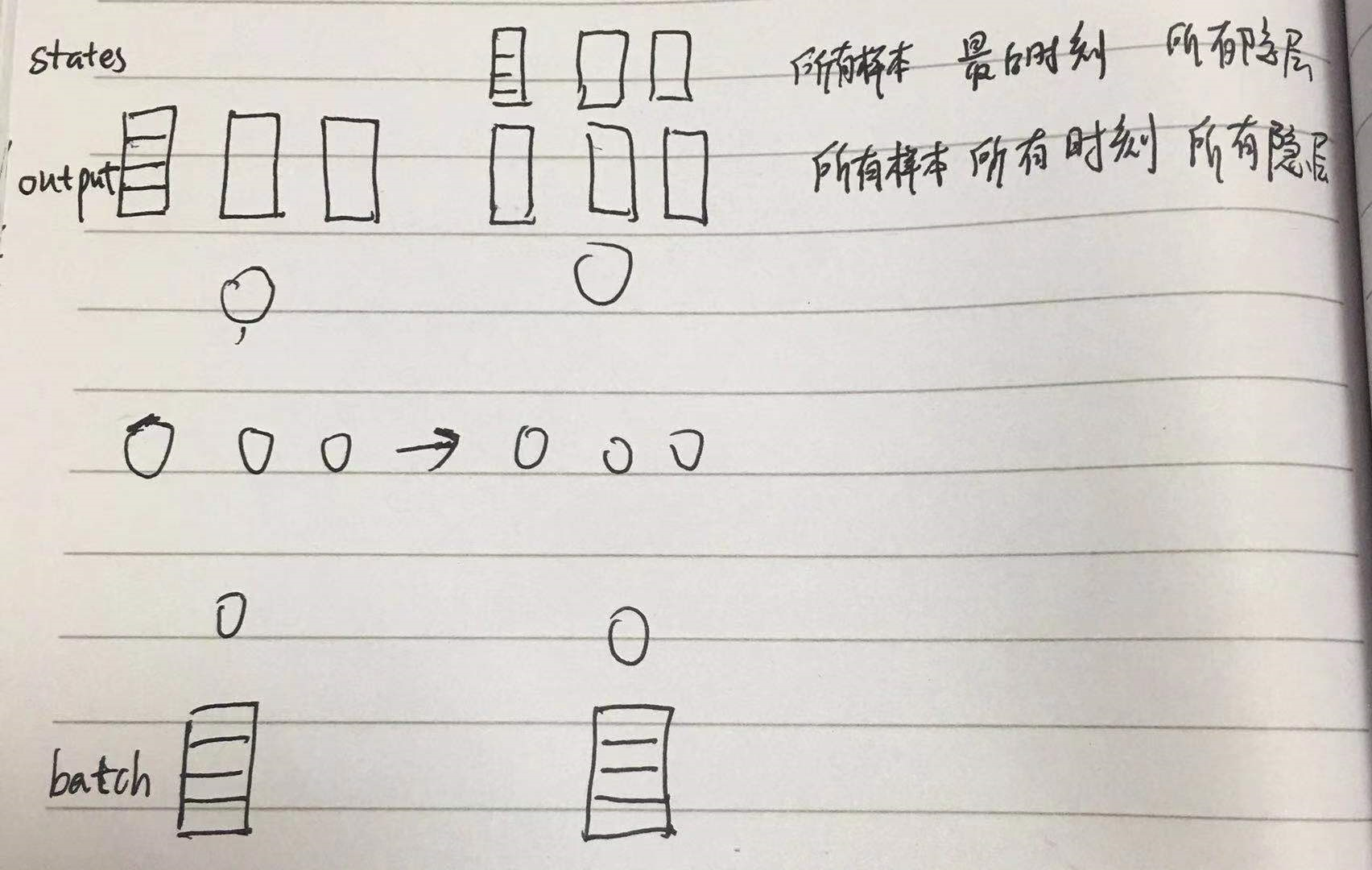

output,states 都是隐层的输出,注意只是隐层h,还没到o,o=vh+c(c是bias,不同于states的c,这是记忆单元)

output 是以三维矩阵形式记录了 所有样本所有时刻所有隐层的输出,shape 为 [batch_size, timestep_size, hidden_size]

states 是所有样本最后时刻所有隐层的 c 和 h,c 是记忆单元, states的shape 为 [2, batch_size, hidden_size] ,2表示 c 和 h

故 states[1] == outputs[:,-1,:] == h

图形表示如下

多隐层

1. MultiRNNCell 构建多隐层LSTM,输出同 tf.nn,dynamic_rnn

2. 多隐层 h0 的shape

3. 多隐层 的输出

# encoding:utf-8

__author__ = 'HP'

import tensorflow as tf # 时序为1 batch_size=10

depth=128 # 特征数 inputs=tf.Variable(tf.random_normal([batch_size,depth])) # # 多隐层的h0

previous_state0=(tf.random_normal([batch_size,100]),tf.random_normal([batch_size,100]))

previous_state1=(tf.random_normal([batch_size,200]),tf.random_normal([batch_size,200]))

previous_state2=(tf.random_normal([batch_size,300]),tf.random_normal([batch_size,300])) num_units=[100,200,300] # 隐层神经元个数

print(inputs) cells=[tf.nn.rnn_cell.BasicLSTMCell(num_unit) for num_unit in num_units]

mul_cells=tf.nn.rnn_cell.MultiRNNCell(cells) # MultiRNNCell 直接输出

outputs,states=mul_cells(inputs,(previous_state0,previous_state1,previous_state2)) print(outputs.shape) #(10, 300)

print(states[0]) #第一层LSTM

print(states[1]) #第二层LSTM

print(states[2]) ##第三层LSTM

print(states[0].h.shape) #第一层LSTM的h状态,(10, 100)

print(states[0].c.shape) #第一层LSTM的c状态,(10, 100)

print(states[1].h.shape) #第二层LSTM的h状态,(10, 200)

网络构建

lstm_cell = tf.nn.rnn_cell.BasicLSTMCell(num_units=hidden_size, forget_bias=1.0, state_is_tuple=True)

mlstm_cell = rnn.MultiRNNCell([clstm() for i in range(layer_num)], state_is_tuple=True)

outputs, state = tf.nn.dynamic_rnn(mlstm_cell, inputs=X, initial_state=init_state, time_major=False) vs mul_cells=tf.nn.rnn_cell.MultiRNNCell(cells)

outputs,states=mul_cells(inputs,(previous_state0,previous_state1,previous_state2))

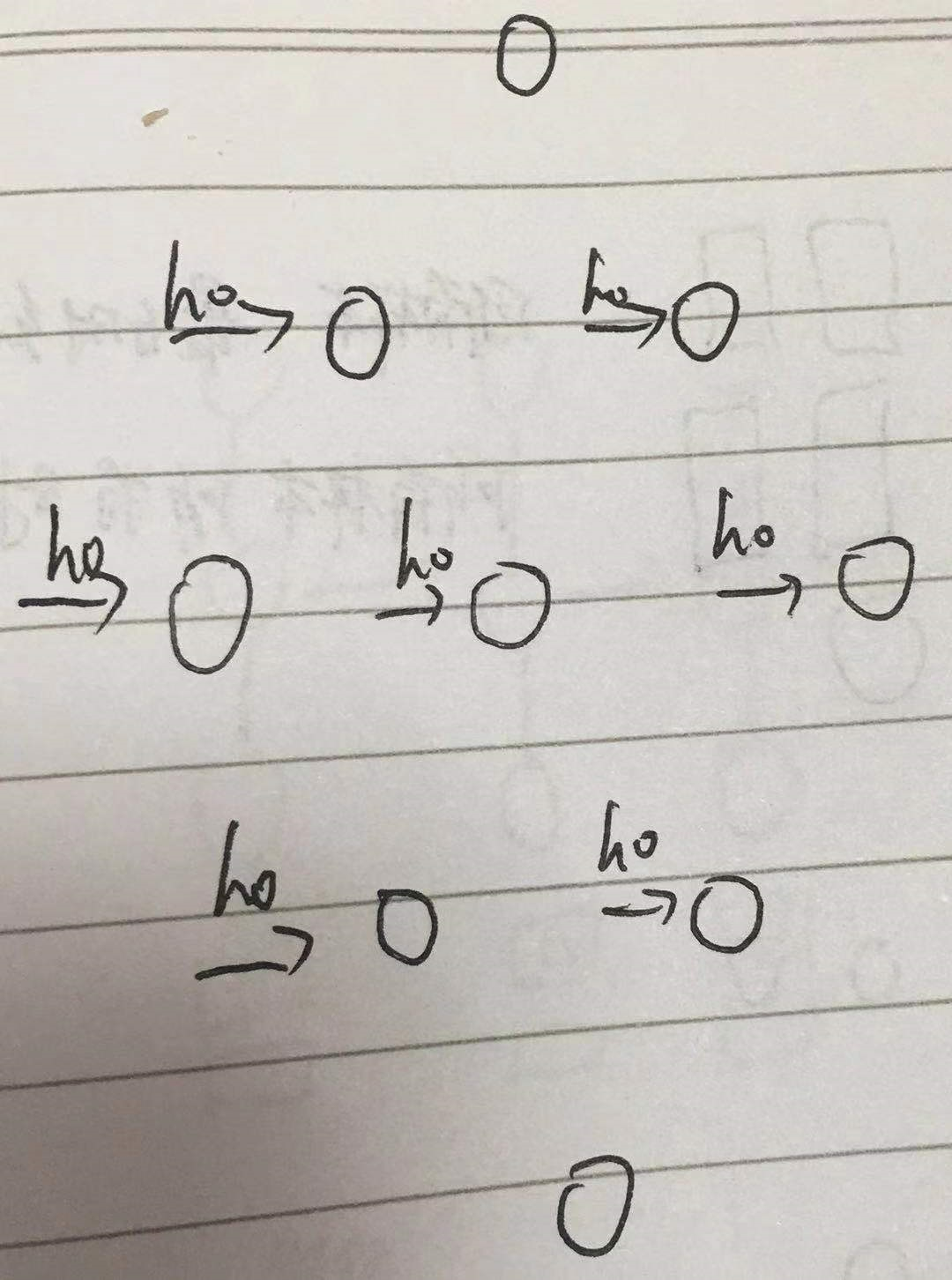

h0 shape

之前讲到h0的shape是 [batch_size, hidden_size],只是针对单隐层的

多隐层应该是 [batch_size, hidden1_size] + [batch_size, hidden2_size] + [batch_size, hidden3_size] + ...

上例中用 MultiRNNCell 构建LSTM, 需要同时定义 c0 和 h0,且二者shape相同,故

previous_state0=(tf.random_normal([batch_size,100]),tf.random_normal([batch_size,100]))

previous_state1=(tf.random_normal([batch_size,200]),tf.random_normal([batch_size,200]))

previous_state2=(tf.random_normal([batch_size,300]),tf.random_normal([batch_size,300]))

图形表示

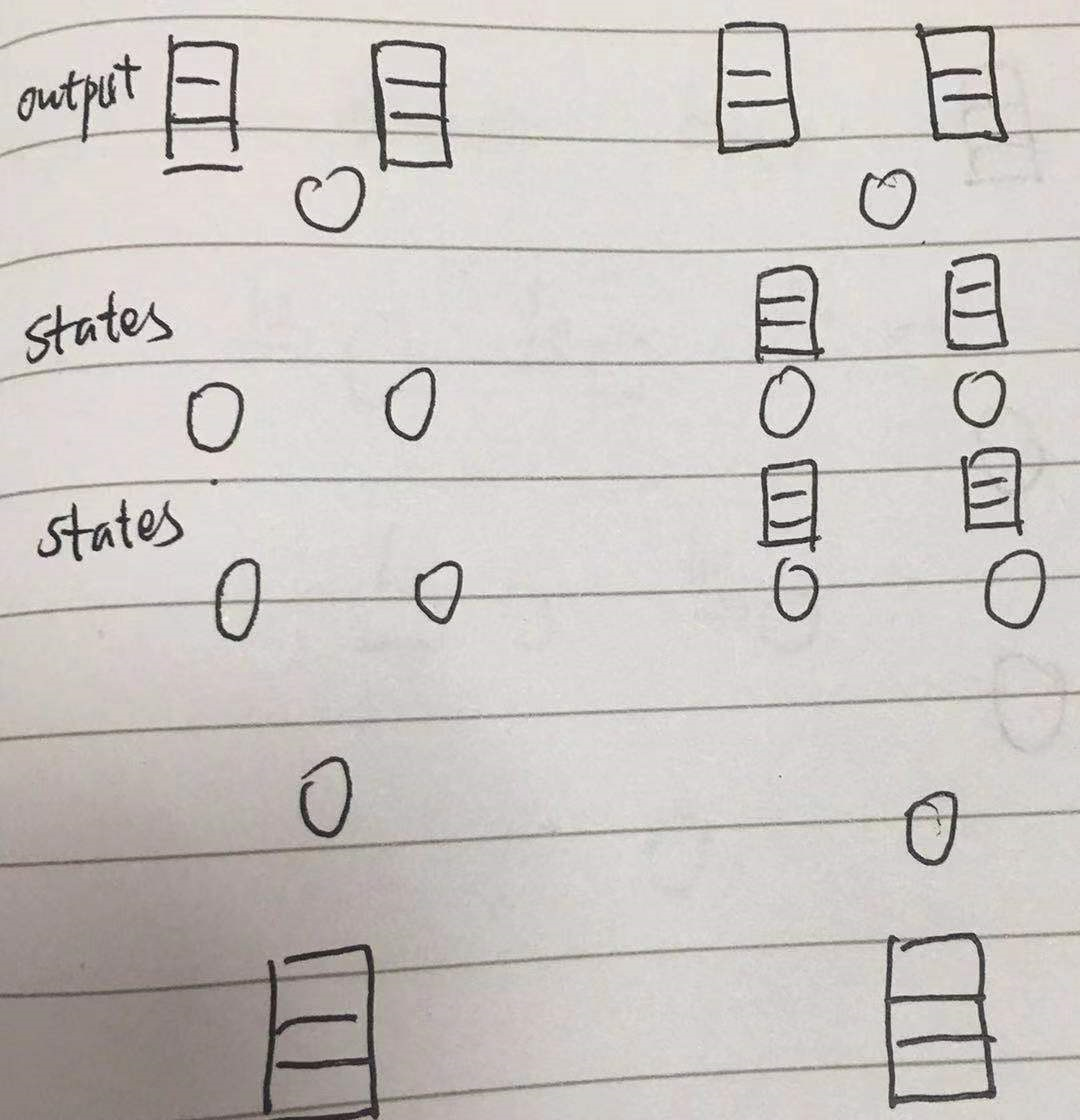

多隐层输出

单隐层输出本文最开头已经讲了,多隐层会稍有不同

output 仍然是 [batch_size, timestep_size, hidden_size]

而 states 是 [n_layer, 2, batch_size, hidden_size]

print(outputs.shape) #(10, 300)

print(states[0]) #第一层LSTM

print(states[1]) #第二层LSTM

print(states[2]) ##第三层LSTM

print(states[0].h.shape) #第一层LSTM的h状态,(10, 100)

print(states[0].c.shape) #第一层LSTM的c状态,(10, 100)

print(states[1].h.shape) #第二层LSTM的h状态,(10, 200)

图形表示

故 state[-1][1] == outputs[:, -1, :] == h

tensorflow-LSTM-网络输出与多隐层节点的更多相关文章

- 吴裕雄--天生自然神经网络与深度学习实战Python+Keras+TensorFlow:使用TensorFlow和Keras开发高级自然语言处理系统——LSTM网络原理以及使用LSTM实现人机问答系统

!mkdir '/content/gdrive/My Drive/conversation' ''' 将文本句子分解成单词,并构建词库 ''' path = '/content/gdrive/My D ...

- RNN,LSTM中如何使用TimeDistributed包装层,代码示例

本文介绍了LSTM网络中的TimeDistributed包装层,代码演示了具有TimeDistributed层的LSTM网络配置方法. 演示了一对一,多对一,多对多,三种不同的预测方法如何配置. 在对 ...

- 使用tensorflow的lstm网络进行时间序列预测

https://blog.csdn.net/flying_sfeng/article/details/78852816 版权声明:本文为博主原创文章,未经博主允许不得转载. https://blog. ...

- Tensorflow进行POS词性标注NER实体识别 - 构建LSTM网络进行序列化标注

http://blog.csdn.net/rockingdingo/article/details/55653279 Github下载完整代码 https://github.com/rockingd ...

- 神经网络结构设计指导原则——输入层:神经元个数=feature维度 输出层:神经元个数=分类类别数,默认只用一个隐层 如果用多个隐层,则每个隐层的神经元数目都一样

神经网络结构设计指导原则 原文 http://blog.csdn.net/ybdesire/article/details/52821185 下面这个神经网络结构设计指导原则是Andrew N ...

- 循环神经网络与LSTM网络

循环神经网络与LSTM网络 循环神经网络RNN 循环神经网络广泛地应用在序列数据上面,如自然语言,语音和其他的序列数据上.序列数据是有很强的次序关系,比如自然语言.通过深度学习关于序列数据的算法要比两 ...

- LSTM网络(Long Short-Term Memory )

本文基于前两篇 1. 多层感知机及其BP算法(Multi-Layer Perceptron) 与 2. 递归神经网络(Recurrent Neural Networks,RNN) RNN 有一个致命的 ...

- Tensorflow[LSTM]

0.背景 通过对<tensorflow machine learning cookbook>第9章第3节"implementing_lstm"进行阅读,发现如下形式可以 ...

- (译)理解 LSTM 网络 (Understanding LSTM Networks by colah)

@翻译:huangyongye 原文链接: Understanding LSTM Networks 前言:其实之前就已经用过 LSTM 了,是在深度学习框架 keras 上直接用的,但是到现在对LST ...

随机推荐

- 新项目的vue组件

项目地址:http://pan.baidu.com/s/1qYIxCXu 很久没有写博客的原因的是之前一直在解决一个问题,这个问题就是:我们在写组件的时候,官方推荐把css写在组件里面,但是如果我们写 ...

- 静默安装/ 普通安装与root权限获取相关

静默安装 有时候使用第三方的插件时我们需要静默安装其提供的apk包,静默安装时我们需要获取root权限,如下代码 Process process = Runtime.getRuntime().exec ...

- 深刻理解Web标准,对可用性、可访问性、可维护性等相关知识有实际的了解和实践经验

WEB标准不是某一个标准,而是一系列标准的集合.网页主要由三部分组成:结构(Structure).表现(Presentation)和行为(Behavior).对应的标准也分三方面:结构化标准语言主要包 ...

- hdu-5985 概率DP

http://acm.hdu.edu.cn/showproblem.php?pid=5985 作为队里负责动态规划的同学,做不出来好无奈啊.思考了一个下午,最好还是参考了别人的思想才写出来,数学啊!! ...

- mysql常用修改创建语句

一.连接数据库 <?php $dbhost = 'localhost:3306'; // mysql服务器主机地址 $dbuser = 'root'; // mysql用户名 $dbpass = ...

- java多线程wait()方法必须放在while循环里面的原因探析

1.写一个包子生产消费案例:一次生产或消费一个包子,有包子就消费,没有就生产.(部分代码参考传智播客刘意2015Java基础视频讲义) 1.1 写一个Baozi.class,包含main()方法,用来 ...

- leetcode-algorithms-36 Valid Sudoku

leetcode-algorithms-36 Valid Sudoku Determine if a 9x9 Sudoku board is valid. Only the filled cells ...

- hdu-6341-搜索

Problem J. Let Sudoku Rotate Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 262144/262144 K ...

- springboot activiti 配置项详解

asyncExecutorEnabled属性设置设置true后将代替那些老的Job executorspring.activiti.async-executor-enabled=false sprin ...

- Liunx 更新环境时用到的命令

1.进入项目文件所在位置:cd/home/zhaorg/shelly62/apache-tomcat-7.0.5.2/bin 2.关闭服务:./shuntdown.sh或者 sh.shuntdown. ...