CA-RNN论文读取

**论文通读:**

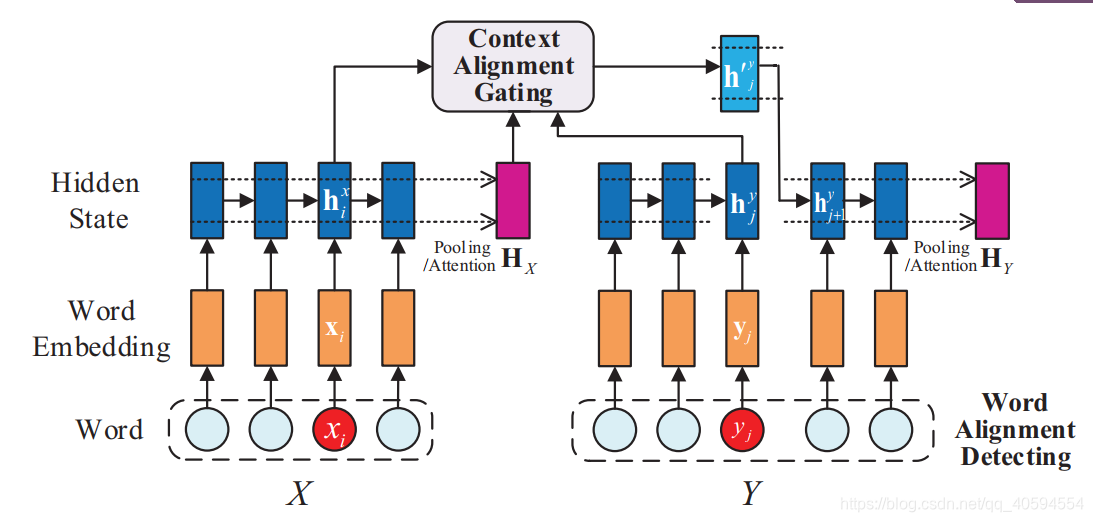

大多数RNN专注于基于当前句子对隐藏状态进行建模,而在隐藏状态生成过程中,其他句子的上下文信息却没有得到很好的研究。在本文中,我们提出了**一种上下文对齐的RNN(CA-RNN)模型**,该模型在句子对中**合并了对齐单词的上下文信息**,以生成内部隐藏状态。具体来说,我们首先执行单词对齐检测,以识别两个句子中对齐的单词。然后,我们提出一种**上下文对齐门控机制**,并将其嵌入到我们的模型中,以自动吸收对齐单词的上下文以进行隐藏状态更新

2. 提出了一种上下文对齐选通机制,并将其很好地嵌入到我们的模型中,该机制可以自动吸收相关上下文并减少生成特定隐藏状态的噪声;

3. 我们对两个句子相似性任务进行了实验结果的详尽分析,从而更好地理解了模型的有效性相关工作

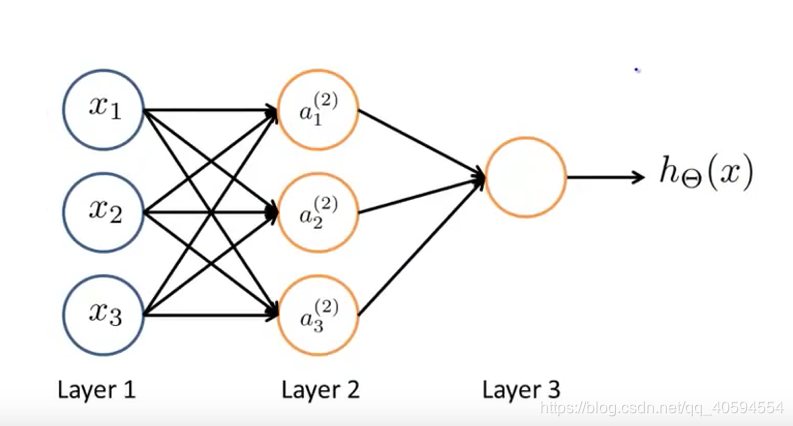

其模型如下:

)

输入特征项:x1,x2,x3,最后h(x)为输出。

layer2为隐藏层,这里面的值我们不知道。所有输出层和输入层都是隐藏层。

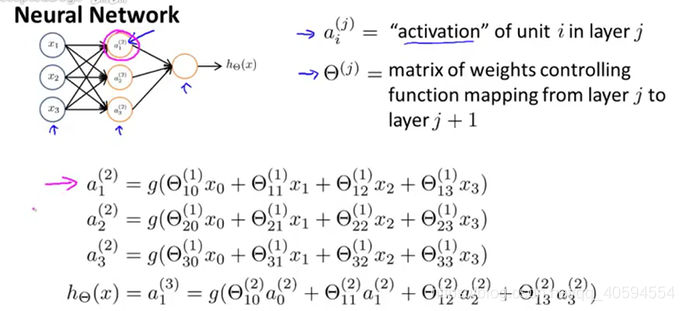

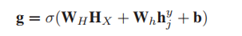

上述的神经元,计算过程如下:

每个输入值,在一个节点中,有不同的权值,根据不同的权值来计算输出。

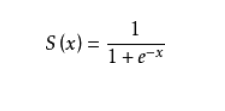

其中为矩阵相乘的相关知识,g为sigmode函数:

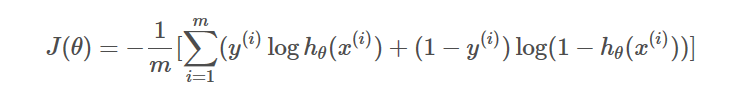

- 损失函数,反向传播

损失函数:

反向传播:(具体算式略):即采用正向传播得出的结果与真实值进行比较,得出误差,然后通过代价函数和误差推导输出前一层的神经网络的误差,然后通过得出的误差一直向前推导,直到输入层的下一层,然后再通过调整权值,调整误差,尽量使得误差较小。

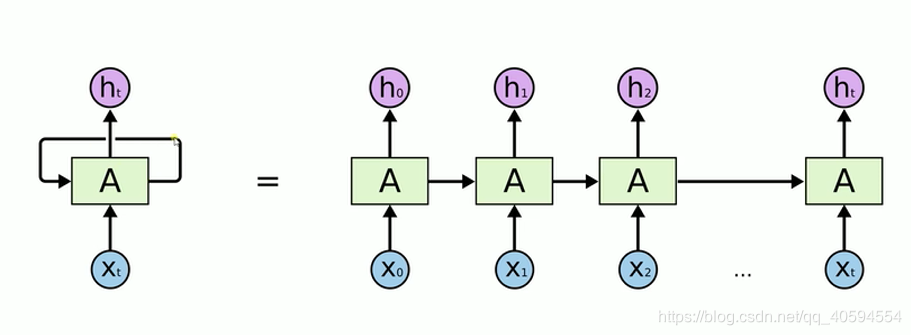

- RNN:递归神经网络,其模型如下:

我们在处理文字等问题的时候,我们的输入会把上一个时间输出的数据作为下一个时间的输入数据进行处理。

例如:我们有一段话,我们将其分词,得到t个数据,我们分别将每一个词传入到x0,x1…xt里面,当x0传入后,会得到一个结果h0,同时我们会将处理后的数据传入到下个时间,到下个时间的时候,我们会再传入一个数据x1,同时还有上一个时间处理后的数据,将这两个数据进行整合计算,然后再向下传输,一直到结束。

rnn本质来说还是一个bp回路,不过他只是比bp网络多一个环节,即它可以反馈上一时间点处理后的数据。

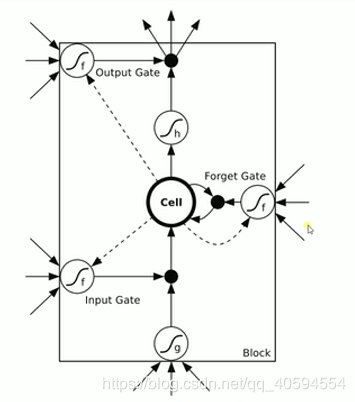

- LSTM(长短期记忆网络)

上图有三个门:输入门 忘记门 输出门

1.输入门:通过input * g 来判断是否输入,如果不输入就为0,输入就是0,以此判断信号是否输入

2.忘记门:这个信号是否需要衰减多少,可能为50%,衰减是根据信号来判断。

3.输入门:通过判断是否输出,或者输出多少,例如输出50%。

按照上述要求:

**上下文对齐选通机制:**

单词重叠即相同单词,获取相同单词的上下文信息即可。

- 2.基于语义相似度

基于语义,即为相似词,例如:爸爸也叫老爸,通过词或字的相似性来进行选择上下文。(基于Stanford Core NLP工具2的单语单词aligner1算法(语义算法))

- 2.上下文吸收

1.测量对齐的单词所在的句子(HX)的表示与当前单词对应的隐藏状态(hy j)之间的相关性,这是确定多少上下文信息的良好标准另一个句子中对齐的单词中要吸收的部分。(即为激励函数求概率)

2.由RNN获得的原始隐藏状态(hy j)将根据所测量的相关性直接吸收其他句子中对齐单词的上下文信息(hx i)。结果,将生成新的隐藏状态,其公式为:hyj = g hx i +(1- g)hy j(3)其中,g是通过公式(2)获得的内插相关参数,表示逐元素相乘,并且hyj是新生成的隐藏状态

综上,ca-rnn即为其流程

CA-RNN论文读取的更多相关文章

- 序列模型(2)-----循环神经网络RNN

一.RNN的作用和粗略介绍: RNN可解决的问题: 训练样本输入是连续的序列,且序列的长短不一,比如基于时间的序列:一段段连续的语音,一段段连续的手写文字.这些序列比较长,且长度不一,比较难直接的拆分 ...

- RNN,LSTM

RNN: Vanilla Neural Network :对单一固定的输入给出单一固定输出 Recurrent Neural Network:对单一固定的输入给出一系列输出(如:可边长序列),例:图片 ...

- 神经机器翻译 - NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE

论文:NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE 综述 背景及问题 背景: 翻译: 翻译模型学习条件分布 ...

- deep learning新征程

deep learning新征程(一) zoerywzhou@gmail.com http://www.cnblogs.com/swje/ 作者:Zhouwan 2015-11-26 声明: 1 ...

- 软工结对项目之词频统计update

队友 胡展瑞 031602215 作业页面 GitHub 具体分工 111500206 赵畅:负责WordCount的升级,添加新的命令行参数支持(自定义输入输出文件,权重词频统计,词组统计等所有新功 ...

- Fabric-Ca使用

Fabric-Ca的概念不再解释了,这里只说明使用方法: 前置条件 Go语言1.10+版本 GOPATH环境变量正确设置 已安装libtool和libtdhl-dev包 Ubuntu系统 通过以下命令 ...

- Tensorflow Probability Distributions 简介

摘要:Tensorflow Distributions提供了两类抽象:distributions和bijectors.distributions提供了一系列具备快速.数值稳定的采样.对数概率计算以及其 ...

- 一篇提及如何通过串口读取并提取GPS信号的论文

一篇提及如何通过串口读取并提取GPS信号的论文 作者:崔杰 梁计春 王国军 目前,在用计算机进行数据传输时,常用的是串行通信方式.在Visual C++的编程中,既可以用Windows API函数进行 ...

- RNN(2) ------ “《A Critical Review of Recurrent Neural Networks for Sequence Learning》RNN综述性论文讲解”(转载)

原文链接:http://blog.csdn.net/xizero00/article/details/51225065 一.论文所解决的问题 现有的关于RNN这一类网络的综述太少了,并且论文之间的符号 ...

随机推荐

- day2 上午 游戏 对应关系--->判断素数---->多重背包 神题

#include<iostream> using namespace std; int n; ; ]; long long p[maxn]; long long dp[maxn][maxn ...

- Spring容器自动调用方法的两种方式

先看一个Spring中Bean的实例化过程: 1.配置文件中指定Bean的init-method参数 <bean class="com.jts.service.UserService& ...

- starUML 3.0.2文件 百度云

文件百度云---链接:https://pan.baidu.com/s/1BVX9Ze40bkgd3k_4WFb99A 提取码:t7kj 使用方法:将starUML安装目录(一般为 C:\Program ...

- one of neural network

map source:https://github.com/microsoft/ai-edu Fundamental Principle inputs: characteristic value th ...

- 小白历险记:spingboot之helloworld

还记得入职第一天的时候,先安装了相关的软件,配置了环境.boss叫我写的第一个程序:搭建一个springboot工程,输出helloworld. 哈哈话不多说,回忆一下. 1.打开IDEA,点击Cre ...

- go中的数据结构接口-interface

1. 接口的基本使用 golang中的interface本身也是一种类型,它代表的是一个方法的集合.任何类型只要实现了接口中声明的所有方法,那么该类就实现了该接口.与其他语言不同,golang并不需要 ...

- 基于Docker的Mysql主从复制

基于Docker的Mysql主从复制搭建 为什么基于Docker搭建? 资源有限 虚拟机搭建对机器配置有要求,并且安装mysql步骤繁琐 一台机器上可以运行多个Docker容器 Docker容器之间相 ...

- Python字符串类型判断错误

Python里面常用的字符串类型有str和unicode,如果要判断一个对象的类型,最好用basestring,否则可能会判断错误: str1 = "hello" str2 = u ...

- 802.11r协议理解

首先阅读了相关协议内容整理出了如下的802.11r时序图所谓基础,然后会详细理解其中的每一个步骤:

- Java IO入门

目录 一. 数据源(流) 二. 数据传输 三. 总结 我们从两个方面来理解Java IO,数据源(流).数据传输,即IO的核心就是对数据源产生的数据进行读写并高效传输的过程. 一. 数据源(流) 数据 ...