Tensorflow实战第十课(RNN MNIST分类)

设置RNN的参数

我们本节采用RNN来进行分类的训练(classifiction)。会继续使用手写数据集MNIST。

让RNN从每张图片的第一行像素读到最后一行,然后进行分类判断。接下来我们导入MNIST数据并确定RNN的各种参数(hyper-parameters)

注:

参数(parameters)/参数模型

由模型通过学习得到变量,比如权重w,偏置b

超参数(hyper-parameters)/算法参数

根据经验设定,影响到权重w和偏置b的大小,比如迭代次数、隐藏层的层数、每层神经元的个数、学习速率等。

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data #data

mnist = input_data.read_data_sets('MNIST_data',one_hot=True) #hyperparameters

lr = 0.001 #learing rate

training_iters = 100000 #train step 上限

batch_size = 128 n_inputs = 28 #mnist data input(img shape:28*28)

n_steps = 28 #time step

n_hidden_units = 128 #neurons in hidden layer

n_classes = 10 #mnist classes(0-9 digits)

接下来定义的是x,y的placeholder和weights,biases的初始状况

#tf graph input

x = tf.placeholder(tf.float32,[None,n_steps,n_inputs])

y = tf.placeholder(tf.float32,[None,n_classes]) #define weights & biases

weights = {

#(28,128)

'in': tf.Variable(tf.random_normal([n_inputs,n_hidden_units])),

#(128,10)

'out': tf.Variable(tf.random_normal([n_hidden_units,n_classes]))

}

biases = {

#(128,)

'in' : tf.Variable(tf.constant(0.1,shape=[n_hidden_units,])),

#(10,)

'out' : tf.Variable(tf.constant(0.1,shape=[n_classes,]))

}

定义RNN的主体结构

接着我们定义RNN主体结构,RNN共有3个组成部分(input_layer,cell,output_layer),首先我们定义input_layer:

#hidden layer for input to cell#

# 原始的 X 是 3 维数据, 我们需要把它变成 2 维数据才能使用 weights 的矩阵乘法

# X ==> (128 batches * 28 steps, 28 inputs)

X = tf.reshape(X,[-1,n_inputs]) #into hidden

#X_in = W*X + b

X_in = tf.matmul(X,weights['in'])+biases['in']

# X_in ==> (128 batches, 28 steps, 128 hidden) 换回3维

X_in = tf.reshape(X_in,[-1,n_steps,n_hidden_units])

接下来就是lstm_cell中的计算,有两种途径:

1.使用tf.nn.rnn(cell,inputs) 不推荐

2.使用tf.nndynamic_rnn(cell,inputs) 推荐

因 Tensorflow 版本升级原因,state_is_tuple = True将在之后的版本中变为默认. 对于LSTM来说,state可被分为(c_state,h_state)

#use basic lstm cell

lstm_cell = tf.contrib.rnn.BasicLSTMCell(n_hidden_units)

init_state = lstm_cell.zero_state(batch_size,dtype=tf.float32) #初始化为零

outputs, final_state = tf.nn.dynamic_rnn(lstm_cell, X_in,initial_state=init_state, time_major=False)

若使用tf.nn.dynamic_rnn(cell,inputs),我们要确定inputs的格式,tf.nn.dynamic_rnn中的time_major参数会针对不同的inputs格式有不同的值。

1.如果inputs为(batches,steps,inputs)==>time_major=False

2.如果inputs为(steps,batches,inputs)==>time_major=True

outputs, final_state = tf.nn.dynamic_rnn(lstm_cell, X_in, initial_state=init_state, time_major=False)

最后是output_layer和return的值,因为这个例子的特殊性,有两种方法可以求得results。

method 1:直接调用final_state中的h_state(final_states[1])来进行运算:

results = tf.matmul(final_state[1], weights['out']) + biases['out']

method 2:调用最后一个outputs(在这个例子中,和上面的final_states[1]是一样的):

# 把 outputs 变成 列表 [(batch, outputs)..] * steps

outputs = tf.unstack(tf.transpose(outputs, [1,0,2]))

results = tf.matmul(outputs[-1], weights['out']) + biases['out'] #选取最后一个 output

在def RNN()的最后输出results

return results

定义好了RNN主体结构后 我们就可以来计算cost 和 train_op:

pred = RNN(x, weights, biases)

cost = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(pred, y))

train_op = tf.train.AdamOptimizer(lr).minimize(cost)

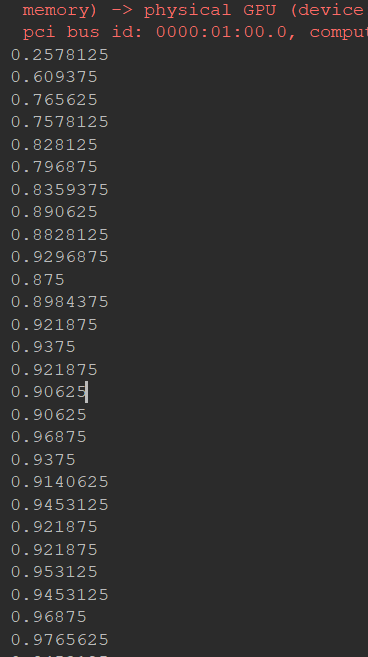

训练RNN,不断输出accuracy观看结果:

correct_pred = tf.equal(tf.argmax(pred, 1), tf.argmax(y, 1))

accuracy = tf.reduce_mean(tf.cast(correct_pred, tf.float32)) with tf.Session() as sess:

init = tf.global_variables_initializer()

sess.run(init)

step = 0

while step * batch_size < training_iters:

batch_xs, batch_ys = mnist.train.next_batch(batch_size)

batch_xs = batch_xs.reshape([batch_size, n_steps, n_inputs])

sess.run([train_op], feed_dict={

x: batch_xs,

y: batch_ys,

})

if step % 20 == 0:

print(sess.run(accuracy, feed_dict={

x: batch_xs,

y: batch_ys,

}))

step += 1

完整代码如下:

#RNN practice import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data #data

mnist = input_data.read_data_sets('MNIST_data',one_hot=True) #hyperparameters

lr = 0.001 #learing rate

training_iters = 100000 #train step 上限

batch_size = 128 n_inputs = 28 #mnist data input(img shape:28*28)

n_steps = 28 #time step

n_hidden_units = 128 #neurons in hidden layer

n_classes = 10 #mnist classes(0-9 digits) #tf graph input

x = tf.placeholder(tf.float32,[None,n_steps,n_inputs])

y = tf.placeholder(tf.float32,[None,n_classes]) #define weights & biases

weights = {

#(28,128)

'in': tf.Variable(tf.random_normal([n_inputs,n_hidden_units])),

#(128,10)

'out': tf.Variable(tf.random_normal([n_hidden_units,n_classes]))

}

biases = {

#(128,)

'in' : tf.Variable(tf.constant(0.1,shape=[n_hidden_units,])),

#(10,)

'out' : tf.Variable(tf.constant(0.1,shape=[n_classes,]))

} #define rnn

def RNN(X,weights,biases):

#hidden layer for input to cell#

# 原始的 X 是 3 维数据, 我们需要把它变成 2 维数据才能使用 weights 的矩阵乘法

# X ==> (128 batches * 28 steps, 28 inputs)

X = tf.reshape(X,[-1,n_inputs]) #into hidden

#X_in = W*X + b

X_in = tf.matmul(X,weights['in'])+biases['in']

# X_in ==> (128 batches, 28 steps, 128 hidden) 换回3维

X_in = tf.reshape(X_in,[-1,n_steps,n_hidden_units]) #use basic lstm cell

lstm_cell = tf.contrib.rnn.BasicLSTMCell(n_hidden_units)

init_state = lstm_cell.zero_state(batch_size,dtype=tf.float32) #初始化为零

outputs, final_state = tf.nn.dynamic_rnn(lstm_cell, X_in, initial_state=init_state, time_major=False) #hidden layer for output as the final results

outputs = tf.unstack(tf.transpose(outputs,[1,0,2]))

results = tf.matmul(outputs[-1],weights['out']+biases['out']) return results

pred = RNN(x, weights, biases)

cost = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits=pred, labels=y))

train_op = tf.train.AdamOptimizer(lr).minimize(cost) correct_pred = tf.equal(tf.argmax(pred, 1), tf.argmax(y, 1))

accuracy = tf.reduce_mean(tf.cast(correct_pred, tf.float32)) with tf.Session() as sess:

init = tf.global_variables_initializer()

sess.run(init)

step = 0

while step * batch_size < training_iters:

batch_xs, batch_ys = mnist.train.next_batch(batch_size)

batch_xs = batch_xs.reshape([batch_size, n_steps, n_inputs])

sess.run([train_op], feed_dict={

x: batch_xs,

y: batch_ys,

})

if step % 20 == 0:

print(sess.run(accuracy, feed_dict={

x: batch_xs,

y: batch_ys,

}))

step += 1

运行截图:

Tensorflow实战第十课(RNN MNIST分类)的更多相关文章

- TensorFlow实战第五课(MNIST手写数据集识别)

Tensorflow实现softmax regression识别手写数字 MNIST手写数字识别可以形象的描述为机器学习领域中的hello world. MNIST是一个非常简单的机器视觉数据集.它由 ...

- Tensorflow实战第十一课(RNN Regression 回归例子 )

本节我们会使用RNN来进行回归训练(Regression),会继续使用自己创建的sin曲线预测一条cos曲线. 首先我们需要先确定RNN的各种参数: import tensorflow as tf i ...

- TensorFlow实战第八课(卷积神经网络CNN)

首先我们来简单的了解一下什么是卷积神经网路(Convolutional Neural Network) 卷积神经网络是近些年逐步兴起的一种人工神经网络结构, 因为利用卷积神经网络在图像和语音识别方面能 ...

- TensorFlow实战第七课(dropout解决overfitting)

Dropout 解决 overfitting overfitting也被称为过度学习,过度拟合.他是机器学习中常见的问题. 图中的黑色曲线是正常模型,绿色曲线就是overfitting模型.尽管绿色曲 ...

- TensorFlow实战第六课(过拟合)

本节讲的是机器学习中出现的过拟合(overfitting)现象,以及解决过拟合的一些方法. 机器学习模型的自负又表现在哪些方面呢. 这里是一些数据. 如果要你画一条线来描述这些数据, 大多数人都会这么 ...

- TensorFlow实战第四课(tensorboard数据可视化)

tensorboard可视化工具 tensorboard是tensorflow的可视化工具,通过这个工具我们可以很清楚的看到整个神经网络的结构及框架. 通过之前展示的代码,我们进行修改从而展示其神经网 ...

- TensorFlow实战第三课(可视化、加速神经网络训练)

matplotlib可视化 构件图形 用散点图描述真实数据之间的关系(plt.ion()用于连续显示) # plot the real data fig = plt.figure() ax = fig ...

- 芝麻HTTP:TensorFlow LSTM MNIST分类

本节来介绍一下使用 RNN 的 LSTM 来做 MNIST 分类的方法,RNN 相比 CNN 来说,速度可能会慢,但可以节省更多的内存空间. 初始化 首先我们可以先初始化一些变量,如学习率.节点单元数 ...

- 深度学习原理与框架-Tensorflow卷积神经网络-神经网络mnist分类

使用tensorflow构造神经网络用来进行mnist数据集的分类 相比与上一节讲到的逻辑回归,神经网络比逻辑回归多了隐藏层,同时在每一个线性变化后添加了relu作为激活函数, 神经网络使用的损失值为 ...

随机推荐

- ueditor编辑器+粘贴word

最近公司做项目需要实现一个功能,在网页富文本编辑器中实现粘贴Word图文的功能. 我们在网站中使用的Web编辑器比较多,都是根据用户需求来选择的.目前还没有固定哪一个编辑器 有时候用的是UEditor ...

- 使用matplotlib绘制常用图表(3)-其他图表绘制

一.绘制三点图 """ 三月份最高气温 a = [12,15,18,6,7,5,6,8,9,10,15,10,4,5,11,10,5,6,12,15,10,5,14,10 ...

- C. Planning(贪心)

C. Planning time limit per test 1 second memory limit per test 512 megabytes input standard input ou ...

- nginx配置服务

在nginx中的conf的文件夹里面的nginx.conf文件中 server { listen 8888; server_name localhost; location / { root C:/P ...

- MySQL的安装教程

一.MYSQL的安装 首先登入官网下载mysql的安装包,官网地址:https://dev.mysql.com/downloads/mysql/ 一般下载这个就好,现在的最新版本是5.8,但是据说已经 ...

- Vue_(组件通讯)父子组件简单关系

Vue组件 传送门 在Vue的组件内也可以定义组件,这种关系成为父子组件的关系 如果在一个Vue实例中定义了component-a,然后在component-a中定义了component-b,那他们的 ...

- SVN如何处理包含@2x or @3x的图片文件

一般iOS图片文件都会包含@2x,@3x之类的字符比如icon@2x,icon@3x,当你在svn命令行中add或是delete的时候总是报错说file does not exit之类的错误,其实之类 ...

- SpringMVC接收请求参数和页面传参

接收请求参数: 1,使用HttpServletRequest获取 @RequestMapping("/login.do") public String login(HttpServ ...

- 移动平台对meta标签的定义

一.meta 标签分两大部分:HTTP 标题信息(http-equiv)和页面描述信息(name). 1.http-equiv 属性的 Content-Type 值(显示字符集的设定) 说明:设定页面 ...

- 软工团队Git现场编程实战

组员职责分工 成员 分工 鲍子涵 分配职责,整合代码 吴宜航 UI设计与实现 钟博 UI设计与实现(Main Coder) 黄海东 数据整理 王镇隆 前端api接口分析和使用(Main Coder) ...