python-requests库的使用之爬取贴吧内容并保存在本地

以面向对象的程序设计方式,编写爬虫代码爬去‘李毅吧’所有页面的内容,也可以通过改变对象的参数来爬取其它贴吧页面的内容。

所用到的库为:requests

涉及知识点:python面向对象编程,字符串操作,文件操作,爬虫基本原理

程序代码如下:

import requests class TiebaSpider:

def __init__(self, tieba_name):

self.tieba_name=tieba_name

self.url_tmp='https://tieba.baidu.com/f?kw='+self.tieba_name+'&ie=utf-8&pn={}'

self.headers={"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/64.0.3282.140 Safari/537.36 Edge/17.17134"} def get_url_list(self): # 获取该贴吧所有的url地址并存放在列表中

url_list=[]

for i in range(1000):

url_list.append(self.url_tmp.format(i+50))

return url_list def parse_url(self,url): # 解析url,获得响应的页面内容

response=requests.get(url,headers=self.headers)

return response.content.decode() # 默认是utf-8解码 def save_html(self,html_str,page_num):

file_path='html/{}-第{}页.html'.format(self.tieba_name,page_num)

with open(file_path,'w',encoding='utf-8') as f: # 此处一定要加encoding=‘utf8'否则会报错,默认打开是以ASCII码方式,而解码是以utf8解码

f.write(html_str) def run(self):

url_list=self.get_url_list()

for url in url_list:

html_str=self.parse_url(url)

page_num=url_list.index(url)+1

self.save_html(html_str,page_num) if __name__=='__main__':

tiebaspider = TiebaSpider('李毅')

tiebaspider.run()

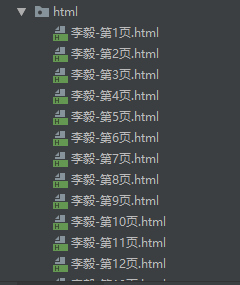

爬取结果如下:

python-requests库的使用之爬取贴吧内容并保存在本地的更多相关文章

- Python+Requests+Bs4(解析)爬取某诗词信息(数据分析二)

1.环境安装 - 需要将pip源设置为国内源,阿里源.豆瓣源.网易源等 - windows (1)打开文件资源管理器(文件夹地址栏中) (2)地址栏上面输入 %appdata% (3)在这里面新建一个 ...

- Python+Requests+Re(正则)爬取某糗事百科图片(数据分析一)

1.博客目前在学习爬虫课程,使用正则表达式来爬取网页的图片信息 2.下面我们一起来回归下Python中的正则使用方式/方法 3.糗事百科图片爬取源码如下: import requestsimport ...

- Python+Requests+Xpath(解析)爬取某站点简历图片(数据分析三)

1.环境安装 pip install lxml 2.解析原理 使用通用爬虫爬取网页数据 实例化etree对象,且将页面数据加载到该对象中 使用xpath函数结合xpath表达式进行标签定位和指定数据提 ...

- 用thinkphp写的一个例子:抓取网站的内容并且保存到本地

我需要写这么一个例子,到电子课本网下载一本电子书. 电子课本网的电子书,是把书的每一页当成一个图片,然后一本书就是有很多张图片,我需要批量的进行下载图片操作. 下面是代码部分: public func ...

- Python网页解析库:用requests-html爬取网页

Python网页解析库:用requests-html爬取网页 1. 开始 Python 中可以进行网页解析的库有很多,常见的有 BeautifulSoup 和 lxml 等.在网上玩爬虫的文章通常都是 ...

- Python:requests库、BeautifulSoup4库的基本使用(实现简单的网络爬虫)

Python:requests库.BeautifulSoup4库的基本使用(实现简单的网络爬虫) 一.requests库的基本使用 requests是python语言编写的简单易用的HTTP库,使用起 ...

- 初识python 之 爬虫:使用正则表达式爬取“糗事百科 - 文字版”网页数据

初识python 之 爬虫:使用正则表达式爬取"古诗文"网页数据 的兄弟篇. 详细代码如下: #!/user/bin env python # author:Simple-Sir ...

- 大概看了一天python request源码。写下python requests库发送 get,post请求大概过程。

python requests库发送请求时,比如get请求,大概过程. 一.发起get请求过程:调用requests.get(url,**kwargs)-->request('get', url ...

- python requests库学习笔记(上)

尊重博客园原创精神,请勿转载! requests库官方使用手册地址:http://www.python-requests.org/en/master/:中文使用手册地址:http://cn.pytho ...

随机推荐

- Linux基石【第四篇】基本Linux命令

Linux 系统上一切皆文件 命令: pwd -- 查看当前目录 / 代表根目录 clear -- 清屏命令 cd(change directory) -- 切换目录 cd / -- 切换到根目录 ...

- 如何求数字n的因数个数及因数和

我们有可能在某些数学题中会求到某个数的因数和,那我们怎么求呢? 因为我们知道任意一个合数都可以由两个或多个质数相乘得到,那么我们就先分解质因数吧 例:我们随便去一个数吧,嗯,就108了,好算... 我 ...

- SNMP++ 编译记录

/************************************************************** 技术博客 http://www.cnblogs.com/itdef/ ...

- 【原创】请避免GO语言中的携程空跑(CPU突然激增)

其实GO语言从1.6版本开始非常不错了,GC性能优化非常到位,并且各种并行设计比从新实现一套C++版本的确是方便不少. 语言包也很多,库也相对稳定,完全可以适用于生产环境. 本文主要是给刚刚入门新手注 ...

- cucumber安装步骤

#Start Guide##Environment###1. Install Ruby Verify your installation by running ruby -v in a termina ...

- “undefined JNI_GetCreatedJavaVM”和“File format not recognized”错误原因分析

如果编译时,报如下所示错误:../../third-party/hadoop/lib/libhdfs.a(jni_helper.c.o): In function `getGlobalJNIEnv': ...

- ZOJ2208 To and Fro 2017-04-16 19:30 45人阅读 评论(0) 收藏

To and Fro Time Limit: 2 Seconds Memory Limit: 65536 KB Mo and Larry have devised a way of encr ...

- 两段 PHP 代码比较优劣

// 代码一 public function getPCA($level = false) { $results = array(); $where = $level ? " where f ...

- Oracle EBS 快捷键

打开菜单 Help > Keyboard Help... 功能 快捷键 =================================== 1 ...

- CDI Event解析

CDI(Contexts And Dependency Injection)是JavaEE 6标准中一个规范,将依赖注入IOC/DI上升到容器级别, 它提供了Java EE平台上服务注入的组件管理核心 ...