HDFS初次编程

hadoop是用Java语言实现的开源软件框架,可以支持多种语言,我学习的时候用得自然就是Java了。

在开始编程之前需要做一些配置工作:

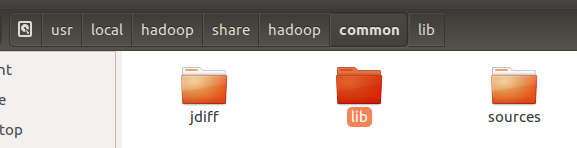

Hadoop开发:Hadoop为HDFS和Mapreduce提供了基础的支持,叫hadoop common。Hadoop有一个专门的common jar包,需要导入这个包。

路径:(安装位置)/hadoop(安装之后整个文件夹,一般格式为hadoop+版本号)/share/hadoop

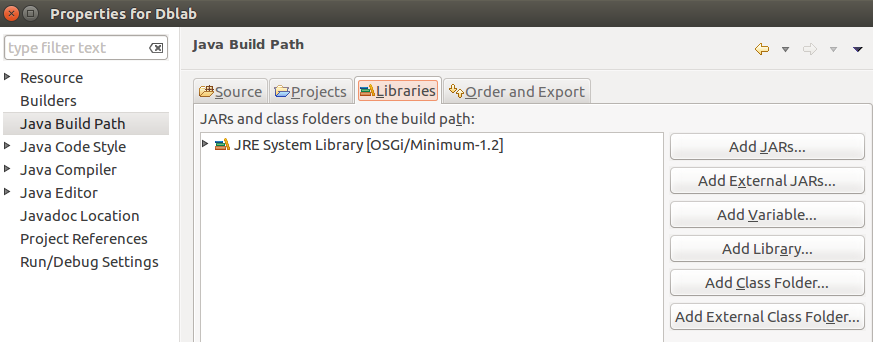

首先新建一个Java Project,右键项目选择Properties---->Java Build Path---->Libraries---->Add External JARs

导入如下所示jar包:

接下来就可以具体编程了。

编程实例:

检测伪分布式文件系统HDFS上到底存不存在一个test.txt文件?

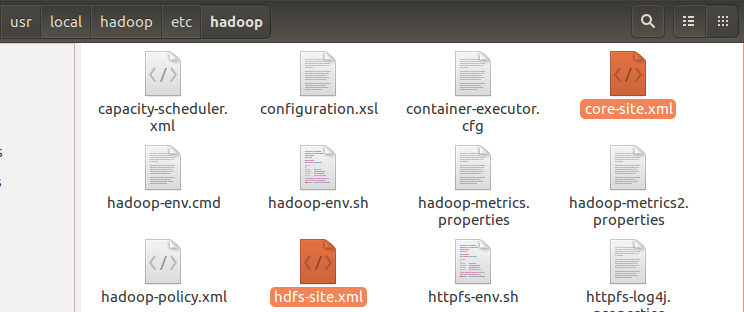

1. 把配置文件放到当前Java工程目录下,即把core-site.xml和hdfs-site.xml(/hadoop/etc/hadoop/)放到项目的bin文件夹下面。

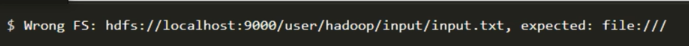

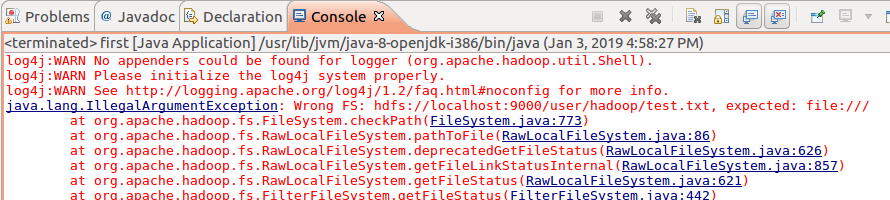

若是缺少该步,运行时会出现错误:

2 编写代码如下:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; public class first {

public static void main(String args[]){

try{

String filename = "hdfs://localhost:9000/user/hadoop/test.txt"; Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

if(fs.exists(new Path(filename))){

System.out.println("File exists");

}

else{

System.out.println("File dose not exist");

} }

catch(Exception e){

e.printStackTrace();

}

}

}

启动hadoop:

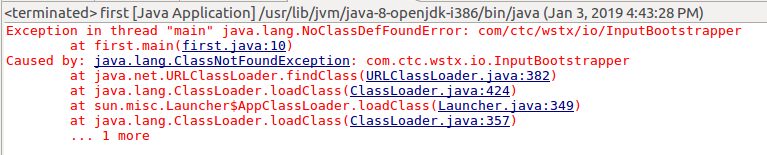

在这过程中也是遇到了一系列错误,首先是:

错误原因是缺少包,简单粗暴的解决办法是把common中lib下的所有包都导进去。

再次运行,又出错:

解决办法为在项目的src文件下面创建一个log4j.properties文件,内容为:

# Configure logging for testing: optionally with log file

log4j.rootLogger=WARN, stdout

# log4j.rootLogger=WARN, stdout, logfile log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

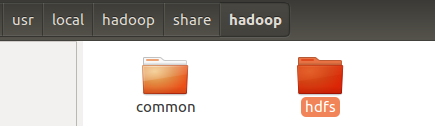

再运行,继续出错,"Class org.apache.hadoop.hdfs.DistributedFileSystem not found":

又是缺少包,仍然是粗暴添加包,把hdfs中的所有jar包添加进去即可。

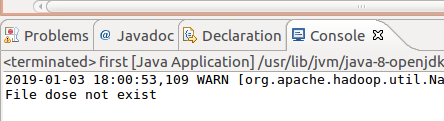

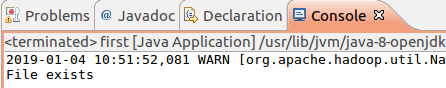

最后,终于成功了!

HDFS初次编程的更多相关文章

- 【HDFS API编程】查看文件块信息

现在我们把文件都存在HDFS文件系统之上,现在有一个jdk.zip文件存储在上面,我们想知道这个文件在哪些节点之上?切成了几个块?每个块的大小是怎么样?先上测试类代码: /** * 查看文件块信息 * ...

- 【HDFS API编程】查看目标文件夹下的所有文件、递归查看目标文件夹下的所有文件

使用hadoop命令:hadoop fs -ls /hdfsapi/test 我们能够查看HDFS文件系统/hdfsapi/test目录下的所有文件信息 那么使用代码怎么写呢?直接先上代码:(这之后 ...

- 【HDFS API编程】从本地拷贝文件,从本地拷贝大文件,拷贝HDFS文件到本地

接着之前继续API操作的学习 CopyFromLocalFile: 顾名思义,从本地文件拷贝 /** * 使用Java API操作HDFS文件系统 * 关键点: * 1)create Configur ...

- 【HDFS API编程】副本系数深度剖析

上一节我们使用Java API操作HDFS文件系统创建了文件a.txt并写入了hello hadoop(回顾:https://www.cnblogs.com/Liuyt-61/p/10739018.h ...

- 【HDFS API编程】查看HDFS文件内容、创建文件并写入内容、更改文件名

首先,重点重复重复再重复: /** * 使用Java API操作HDFS文件系统 * 关键点: * 1)创建 Configuration * 2)获取 FileSystem * 3)...剩下的就是 ...

- 【HDFS API编程】jUnit封装-改写创建文件夹

首先:什么是jUnit 回顾: https://www.cnblogs.com/Liuyt-61/p/10374732.html 上一节我们知道: /** * 使用Java API操作HDFS文件系 ...

- 【HDFS API编程】第一个应用程序的开发-创建文件夹

/** * 使用Java API操作HDFS文件系统 * 关键点: * 1)创建 Configuration * 2)获取 FileSystem * 3)...剩下的就是 HDFS API的操作了*/ ...

- HDFS简单编程实例:文件合并

下图显示了HDFS文件系统中路径为“localhost:50070/explorer.html#/user/hadoop”的目录中所有的文件信息: 对于该目录下的所有文件,我们将执行以下操作: 首先, ...

- HDFS API编程

3.1常用类 3.1.1Configuration Hadoop配置文件的管理类,该类的对象封装了客户端或者服务器的配置(配置集群时,所有的xml文件根节点都是configuration ...

随机推荐

- swust oj 1069

图的按录入顺序广度优先搜索 5000(ms) 10000(kb) 2347 / 4868 Tags: 广度优先 图的广度优先搜索类似于树的按层次遍历,即从某个结点开始,先访问该结 点,然后访问该结点的 ...

- UML关系实现、泛化,依赖、组合

图片via<大话设计模式> UML一目了然

- 页面初始化document.body.clientWidth大小变化

目前:原因不明 初步判断:设置字体大小前图片加载失败! 结果:等待验证

- 3.1.2 Spring之IoC

二.Spring之IoC 1. IoC与DI (1) IoC 控制反转( IoC, Inversion of Control) , 是一个概念, 是一种思想. 控制反转就是对对象控制权的转移, 从程序 ...

- 更多more 123123循环

- 图片居中table-cell

- Python学习之数组类型一:

Python学习之数组类型一: Numpy中的向量与矩阵: 1.创建: 向量.矩阵均由array函数创建,区别在于向量是v=array( [逗号分隔的元素] ), 矩阵是M=array( [[ ]] ...

- python进阶(一) 多进程并发机制

python多进程并发机制: 这里使用了multprocessing.Pool进程池,来动态增加进程 #coding=utf-8 from multiprocessing import Pool im ...

- python进阶(三) 内建函数getattr工厂模式

getattr()这个方法最主要的作用是实现反射机制.也就是说可以通过字符串获取方法实例. 传入不同的字符串,调用的方法不一样. 原型:getattr(对象,方法名) 举个栗子: pyMethod类 ...

- redis内存不够 : OOM command not allowed when used memory > ‘maxmemory’

Redis内存不够,报错. 三种解决思路 注:如修改了配置文件需重启redis 1. 增加redis内存,修改redis.conf(集群中为redis-env.sh),默认为1024MB,增加到合适的 ...