深度学习面试题13:AlexNet(1000类图像分类)

目录

网络结构

两大创新点

参考资料

第一个典型的CNN是LeNet5网络结构,但是第一个引起大家注意的网络却是AlexNet,Alex Krizhevsky其实是Hinton的学生,这个团队领导者是Hinton,于2012年发表论文。

AlexNet有60 million个参数和65000个 神经元,五层卷积,三层全连接网络,最终的输出层是1000通道的softmax。AlexNet利用了两块GPU进行计算,大大提高了运算效率,并且在ILSVRC-2012竞赛中获得了top-5测试的15.3%error rate, 获得第二名的方法error rate 是 26.2%,可以说差距是非常的大了,足以说明这个网络在当时给学术界和工业界带来的冲击之大。

|

网络结构 |

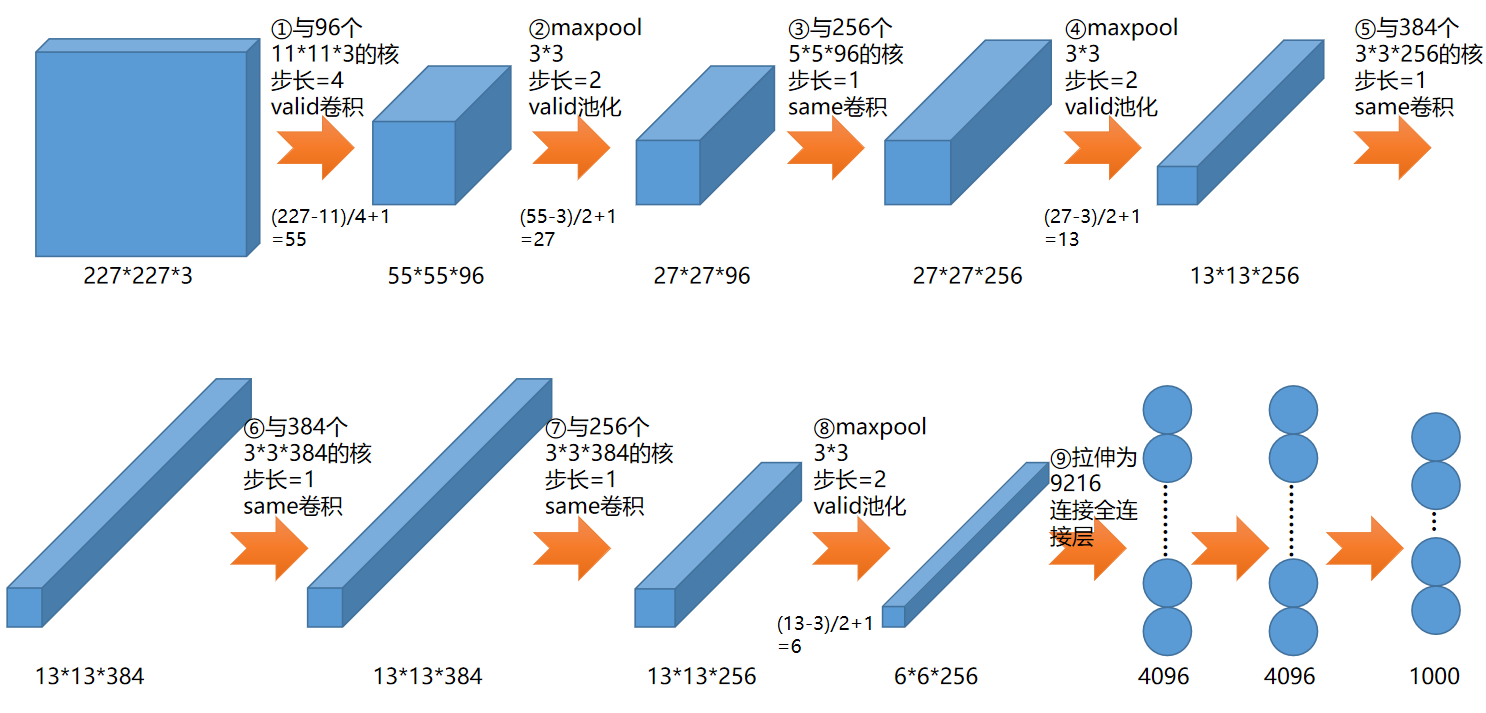

AlexNet的网络结构如下,在论文中输入图像写的是224,通过查阅资料了解到,应该是作者做了跳步,先对图像预处理,把224的图像转为了227:

这个网络比较大,需要的训练数据也是ImageNet的数据集(上百GB),训练十分耗时,真正做图像分类可以使用微调的方式,这个会在后面将slim的时候展开,所以这里先给出网络结构的代码,帮助大家理解上面的图,我已经在pycharm中调试过,尺寸都是正确的。

import tensorflow as tf

import numpy as np

#输入

x=tf.placeholder(tf.float32,[None,227,227,3])

keep_prob=tf.placeholder(tf.float32)

# ①与96个11*11*3的核,步长=4,valid卷积

w1=tf.Variable(tf.random_normal([11,11,3,96]),dtype=tf.float32,name='w1')

l1=tf.nn.conv2d(x,w1,[1,4,4,1],'VALID')

b1=tf.Variable(tf.random_normal([96]),dtype=tf.float32,name='b1')

l1=tf.nn.bias_add(l1,b1)

l1=tf.nn.relu(l1)

# 结果为55*55*96 # ②maxpool,3*3,步长=2,valid池化

pool_l1=tf.nn.max_pool(l1,[1,3,3,1],[1,2,2,1],'VALID')

# 结果为27*27*96 # ③与256个,5*5*96的核,步长=1,same卷积

w2=tf.Variable(tf.random_normal([5,5,96,256]),dtype=tf.float32,name='w2')

l2=tf.nn.conv2d(pool_l1,w2,[1,1,1,1],'SAME')

b2=tf.Variable(tf.random_normal([256]),dtype=tf.float32,name='b2')

l2=tf.nn.bias_add(l2,b2)

l2=tf.nn.relu(l2)

# 结果为27*27*256 # ④maxpool,3*3,步长=2,valid池化

pool_l2=tf.nn.max_pool(l2,[1,3,3,1],[1,2,2,1],'VALID')

# 结果为13*13*256 # ⑤与384个,3*3*256的核,步长=1,same卷积

w3=tf.Variable(tf.random_normal([3,3,256,384]),dtype=tf.float32,name='w3')

l3=tf.nn.conv2d(pool_l2,w3,[1,1,1,1],'SAME')

b3=tf.Variable(tf.random_normal([384]),dtype=tf.float32,name='b3')

l3=tf.nn.bias_add(l3,b3)

l3=tf.nn.relu(l3)

# 结果为13*13*384 # ⑥与384个,3*3*384的核,步长=1,same卷积

w4=tf.Variable(tf.random_normal([3,3,384,384]),dtype=tf.float32,name='w4')

l4=tf.nn.conv2d(l3,w4,[1,1,1,1],'SAME')

b4=tf.Variable(tf.random_normal([384]),dtype=tf.float32,name='b4')

l4=tf.nn.bias_add(l4,b4)

l4=tf.nn.relu(l4)

# 结果为13*13*384 # ⑦与256个,3*3*384的核,步长=1,same卷积

w5=tf.Variable(tf.random_normal([3,3,384,256]),dtype=tf.float32,name='w5')

l5=tf.nn.conv2d(l4,w5,[1,1,1,1],'SAME')

b5=tf.Variable(tf.random_normal([256]),dtype=tf.float32,name='b5')

l5=tf.nn.bias_add(l5,b5)

l5=tf.nn.relu(l5)

# 结果为13*13*256 # ⑧maxpool,3*3,步长=2,valid池化

pool_l5=tf.nn.max_pool(l5,[1,3,3,1],[1,2,2,1],'VALID')

# 结果为6*6*256 # ⑨拉伸为9216,全连接

pool_l5_shape=pool_l5.get_shape()

num=pool_l5_shape[1].value*pool_l5_shape[2].value*pool_l5_shape[3].value

flatten=tf.reshape(pool_l5,[-1,num])

# 结果为9216个神经元 # 第1个隐含层

fcW1=tf.Variable(tf.random_normal([num,4096]),dtype=tf.float32,name='fcW1')

fc_l1=tf.matmul(flatten,fcW1)

fcb1=tf.Variable(tf.random_normal([4096]),dtype=tf.float32,name='fcb1')

fc_l1=tf.nn.bias_add(fc_l1,fcb1)

fc_l1=tf.nn.relu(fc_l1)

fc_l1=tf.nn.dropout(fc_l1,keep_prob)

# 第2个隐含层

fcW2=tf.Variable(tf.random_normal([4096,4096]),dtype=tf.float32,name='fcW2')

fc_l2=tf.matmul(fc_l1,fcW2)

fcb2=tf.Variable(tf.random_normal([4096]),dtype=tf.float32,name='fcb2')

fc_l2=tf.nn.bias_add(fc_l2,fcb2)

fc_l2=tf.nn.relu(fc_l2)

fc_l2=tf.nn.dropout(fc_l2,keep_prob)

# 输出层

fcW3=tf.Variable(tf.random_normal([4096,1000]),dtype=tf.float32,name='fcW3')

out=tf.matmul(fc_l2,fcW3)

fcb3=tf.Variable(tf.random_normal([1000]),dtype=tf.float32,name='fcb3')

out=tf.nn.bias_add(out,fcb3)

out=tf.nn.relu(out)

#"创建会话"

session=tf.Session()

session.run(tf.global_variables_initializer())

result=session.run(out,feed_dict={x:np.ones([1,227,227,3],np.float32),

keep_prob:0.5})

#"打印最后的输出尺寸"

print(np.shape(result))

|

两大创新点 |

AlexNet有两个较大的创新点,一个是使用了Relu激活函数,加快了模型的学习过程,这个已经在《深度学习面试题05:激活函数sigmod、tanh、ReLU、LeakyRelu、Relu6》介绍过;另一个就是加入了dropout,可以防止模型的过拟合。

|

参考资料 |

《图解深度学习与神经网络:从张量到TensorFlow实现》_张平

AlexNet-imagenet-classification-with-deep-convolutional-neural-networks

深度学习面试题13:AlexNet(1000类图像分类)的更多相关文章

- 深度学习Keras框架笔记之AutoEncoder类

深度学习Keras框架笔记之AutoEncoder类使用笔记 keras.layers.core.AutoEncoder(encoder, decoder,output_reconstruction= ...

- 深度学习Keras框架笔记之TimeDistributedDense类

深度学习Keras框架笔记之TimeDistributedDense类使用方法笔记 例: keras.layers.core.TimeDistributedDense(output_dim,init= ...

- 深度学习Keras框架笔记之Dense类(标准的一维全连接层)

深度学习Keras框架笔记之Dense类(标准的一维全连接层) 例: keras.layers.core.Dense(output_dim,init='glorot_uniform', activat ...

- 深度学习面试题29:GoogLeNet(Inception V3)

目录 使用非对称卷积分解大filters 重新设计pooling层 辅助构造器 使用标签平滑 参考资料 在<深度学习面试题20:GoogLeNet(Inception V1)>和<深 ...

- 深度学习面试题27:非对称卷积(Asymmetric Convolutions)

目录 产生背景 举例 参考资料 产生背景 之前在深度学习面试题16:小卷积核级联卷积VS大卷积核卷积中介绍过小卷积核的三个优势: ①整合了三个非线性激活层,代替单一非线性激活层,增加了判别能力. ②减 ...

- 深度学习面试题17:VGGNet(1000类图像分类)

目录 VGGNet网络结构 论文中还讨论了其他结构 参考资料 2014年,牛津大学计算机视觉组(Visual Geometry Group)和Google DeepMind公司的研究员一起研发出了新的 ...

- 深度学习面试题20:GoogLeNet(Inception V1)

目录 简介 网络结构 对应代码 网络说明 参考资料 简介 2014年,GoogLeNet和VGG是当年ImageNet挑战赛(ILSVRC14)的双雄,GoogLeNet获得了第一名.VGG获得了第二 ...

- 深度学习面试题12:LeNet(手写数字识别)

目录 神经网络的卷积.池化.拉伸 LeNet网络结构 LeNet在MNIST数据集上应用 参考资料 LeNet是卷积神经网络的祖师爷LeCun在1998年提出,用于解决手写数字识别的视觉任务.自那时起 ...

- 深度学习面试题26:GoogLeNet(Inception V2)

目录 第一层卷积换为分离卷积 一些层的卷积核的个数发生了变化 多个小卷积核代替大卷积核 一些最大值池化换为了平均值池化 完整代码 参考资料 第一层卷积换为分离卷积 net = slim.separab ...

随机推荐

- UCOSIII事件标志组

两种同步机制 "或"同步 "与"同步 使能 #define OS_CFG_FLAG_EN 1u /* Enable (1) or Disable (0) cod ...

- c# MatchCollection类

- django配置*app*登录案例*orm简用

1.静态文件的配置和使用 1.静态文件的配置和使用 没有css样式: 添加样式 结果: <html lang="en"> <head> <meta c ...

- Proxmox 命令使用方法

proxmox 虚拟机使用命令介绍 qm <command> <vmid> [OPTIONS] ...

- Windows 远程访问 ubuntu 16 lts

remote access ubuntu 使用安装使用vncserver (除非必要,不要使用图形界面,底层码农真的应该关心效率) $ sudo apt-get install vncsever wi ...

- JDK源码那些事儿之LinkedTransferQueue

在JDK8的阻塞队列实现中还有两个未进行说明,今天继续对其中的一个阻塞队列LinkedTransferQueue进行源码分析,如果之前的队列分析已经让你对阻塞队列有了一定的了解,相信本文要讲解的Lin ...

- postgresql —— 数组类型

创建数组 CREATE TABLE sal_emp ( name text, pay_by_quarter integer[] --还可以定义为integer[4]或integer ARRAY[4] ...

- Spring Cloud 组件 —— hystrix

作用与功能 ① 资源隔离, 每个依赖配备单独的线程池,为每个依赖提供一个小的线程池(或信号),如果线程池已满调用将被立即拒绝,默认不采用排队.加速失败判定时间.② 依赖超时,可配置依赖调用超时时间,超 ...

- CentOS7添加/删除用户和用户组

1.新建用户 adduser testuser //新建testuser 用户 passwd testuser //给testuser 用户设置密码 2.建工作组 groupadd testgroup ...

- 十五.ProtoBuf3的基础总结

转自: https://blog.csdn.net/u011518120/article/details/54604615 定义一个消息类型 指定字段类型 分配标识号 指定字段规则 添加更多消息类型 ...