scrapy框架中的pipelines没有成功调用process_item方法

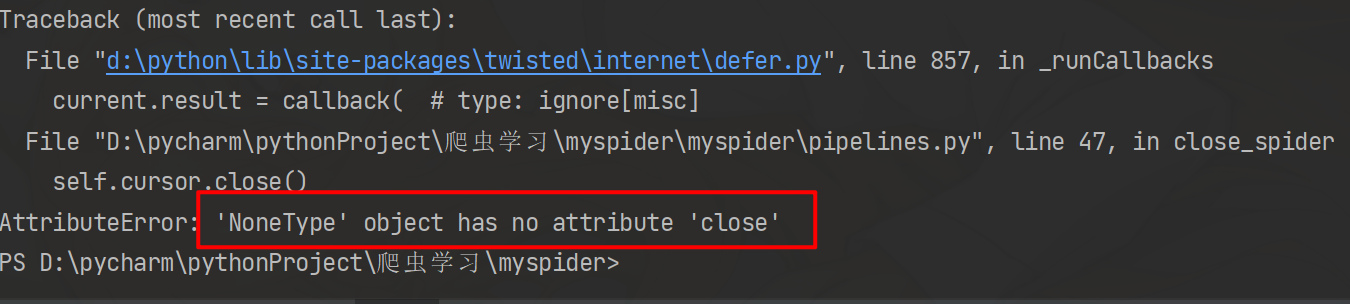

提示报错

原因:

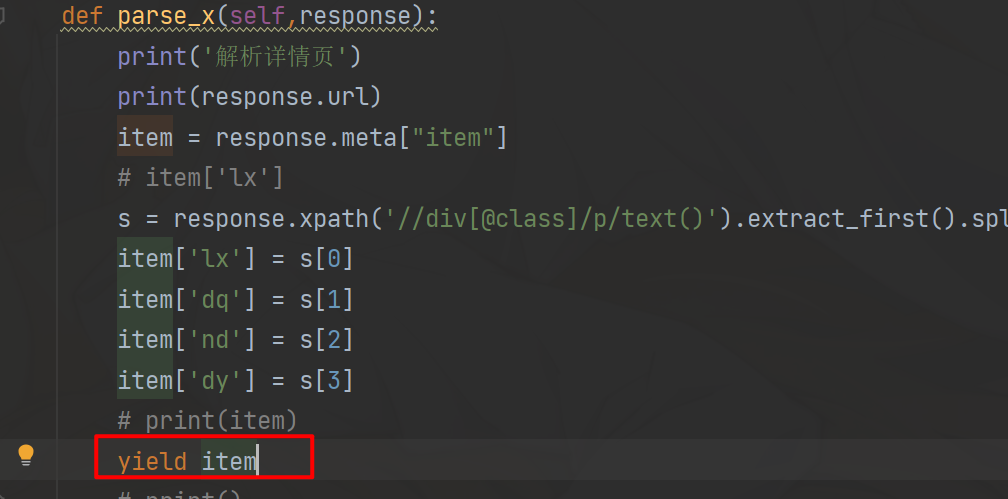

items没有接收到Spider的返回值,导致pipelines没有接收到items模块的返回值,检查Spider模块是否正确返回值,我这里的原因是,数据解析完成后没有yield item,导致pipelines不能执行数据处理操作

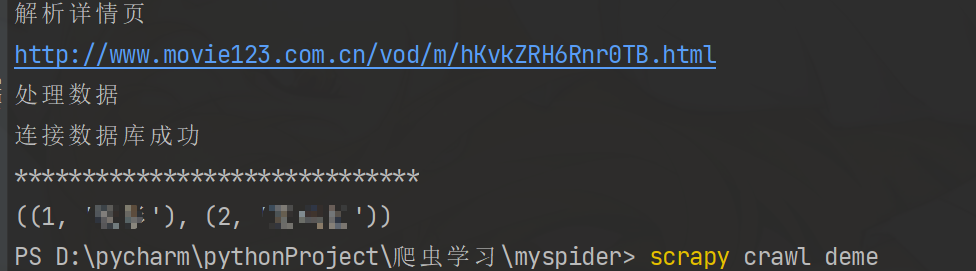

加上后就正常操作数据库了

scrapy框架中的pipelines没有成功调用process_item方法的更多相关文章

- scrapy框架中Download Middleware用法

scrapy框架中Download Middleware用法 Downloader Middleware处理的过程主要在调度器发送requests请求的时候以及网页将response结果返回给sp ...

- scrapy框架中Item Pipeline用法

scrapy框架中item pipeline用法 当Item 在Spider中被收集之后,就会被传递到Item Pipeline中进行处理 每个item pipeline组件是实现了简单的方法的pyt ...

- Scrapy框架中的CrawlSpider

小思考:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模块递归回调parse方法). 方法二: ...

- scrapy框架中Spiders用法

scrapy框架中Spiders用法 Spider类定义了如何爬去某个网站,包括爬取的动作以及如何从网页内容中提取结构化的数据 总的来说spider就是定义爬取的动作以及分析某个网页 工作流程分析 以 ...

- Scrapy框架中选择器的用法【转】

Python爬虫从入门到放弃(十四)之 Scrapy框架中选择器的用法 请给作者点赞 --> 原文链接 Scrapy提取数据有自己的一套机制,被称作选择器(selectors),通过特定的Xpa ...

- scrapy框架中选择器的用法

scrapy框架中选择器的用法 Scrapy提取数据有自己的一套机制,被称作选择器(selectors),通过特定的Xpath或者CSS表达式来选择HTML文件的某个部分Xpath是专门在XML文件中 ...

- Python的Django框架中forms表单类的使用方法详解

用户表单是Web端的一项基本功能,大而全的Django框架中自然带有现成的基础form对象,本文就Python的Django框架中forms表单类的使用方法详解. Form表单的功能 自动生成HTML ...

- DRF框架中链表数据通过ModelSerializer深度查询方法汇总

DRF框架中链表数据通过ModelSerializer深度查询方法汇总 一.准备测试和理解准备 创建类 class Test1(models.Model): id = models.IntegerFi ...

- scrapy框架中多个spider,tiems,pipelines的使用及运行方法

用scrapy只创建一个项目,创建多个spider,每个spider指定items,pipelines.启动爬虫时只写一个启动脚本就可以全部同时启动. 本文代码已上传至github,链接在文未. 一, ...

- Python爬虫从入门到放弃(十六)之 Scrapy框架中Item Pipeline用法

当Item 在Spider中被收集之后,就会被传递到Item Pipeline中进行处理 每个item pipeline组件是实现了简单的方法的python类,负责接收到item并通过它执行一些行为, ...

随机推荐

- postgresql 之修改psql log信息级别

1.修改当前使用的postgresql.conf文件vim /var/lib/pgsql/10/data/postgresql.conf 2.vim 下使用\notice 找到待修改项 client_ ...

- Java-面向对象基础 对象和方法

// 定义属性 String nick; String color; int age;// 定义类的方法 public void eat(){ System.out.println("在吃东 ...

- C# 使用多线程的几种方式

1.Thread 详细介绍:https://www.cnblogs.com/cheng8/p/16147918.html 使用Thread类通过ThreadStart(无参数)或Parameteriz ...

- Day 21 21.1:CrawlSpider(全站数据爬取)

CrawlSpider(全站数据爬取) 实现网站的全站数据爬取 就是将网站中所有页码对应的页面数据进行爬取. crawlspider其实就是scrapy封装好的一个爬虫类,通过该类提供的相关的方法和属 ...

- plsql和instantclient版本都对,依然不能初始化oci.dll解决办法

这里写到 "初始化错误,不能初始化 oci.dll, 请确认你安装的是64位的Oracle客户端 " ,这个描述还是非常的到位啊,我一检查,果然下载的客户端是32位的,在确保自己的 ...

- LaTex【八】latex公式不自动编号

latex使用 \begin{equation} 编辑公式时,会自动为公式进行编号 如果需要取消自动编号,只需要在公式后加上 \nonumber 命令即可 例子 \begin{equation} \b ...

- leetcode 655. 输出二叉树 【时间击败100.00%】 【内存击败96.49%】

1 public List<List<String>> printTree(TreeNode root) { 2 ArrayList<List<String> ...

- miscmisc --攻防世界

题目: (1)解压后将图片放入16进制编辑器,搜索字符串flag发现 图片应该还包含其他文件 (2)使用foremost进行分离,得到压缩包,打开压缩包又有一张图片 (3) 图片同样使用编辑器查看,也 ...

- Python打包时包含静态文件处理方法

Python打包时包含静态文件处理方法 使用场景 已搭建了PyPI私有库,上传公共库包含静态文件,如需要使用sql静态文件初始化数据库. 打包python包,给其他人使用,但项目中包含静态文件,如ht ...

- centos 7 安装rocketmq 主从

https://www.cnblogs.com/weianlai/p/14590533.html