Elasticsearch——分页查询From&Size VS scroll

Elasticsearch中数据都存储在分片中,当执行搜索时每个分片独立搜索后,数据再经过整合返回。那么,如果要实现分页查询该怎么办呢?

更多内容参考Elasticsearch资料汇总

按照一般的查询流程来说,如果我想查询前10条数据:

- 1 客户端请求发给某个节点

- 2 节点转发给个个分片,查询每个分片上的前10条

- 3 结果返回给节点,整合数据,提取前10条

- 4 返回给请求客户端

那么当我想要查询第10条到第20条的数据该怎么办呢?这个时候就用到分页查询了。

from-size"浅"分页

"浅"分页的概念是小博主自己定义的,可以理解为简单意义上的分页。它的原理很简单,就是查询前20条数据,然后截断前10条,只返回10-20的数据。这样其实白白浪费了前10条的查询。

查询的方法如:

{

"from" : 0, "size" : 10,

"query" : {

"term" : { "user" : "kimchy" }

}

}

其中,from定义了目标数据的偏移值,size定义当前返回的事件数目。

默认from为0,size为10,即所有的查询默认仅仅返回前10条数据。

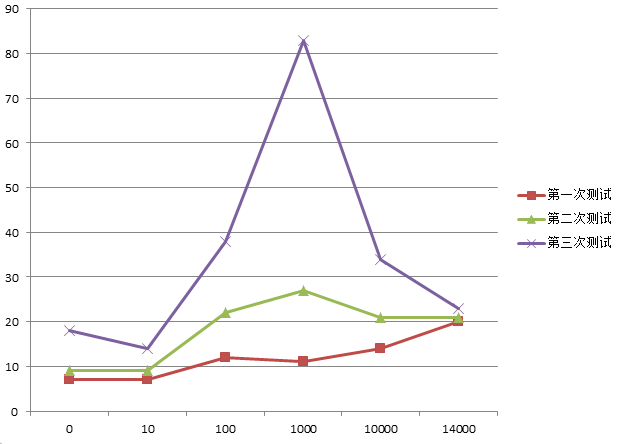

做过测试,越往后的分页,执行的效率越低。

通过下图可以看出,刨去一些异常的数据,总体上还是会随着from的增加,消耗时间也会增加。而且数据量越大,效果越明显!

也就是说,分页的偏移值越大,执行分页查询时间就会越长!

scroll“深”分页

相对于from和size的分页来说,使用scroll可以模拟一个传统数据的游标,记录当前读取的文档信息位置。这个分页的用法,不是为了实时查询数据,而是为了一次性查询大量的数据(甚至是全部的数据)。

因为这个scroll相当于维护了一份当前索引段的快照信息,这个快照信息是你执行这个scroll查询时的快照。在这个查询后的任何新索引进来的数据,都不会在这个快照中查询到。但是它相对于from和size,不是查询所有数据然后剔除不要的部分,而是记录一个读取的位置,保证下一次快速继续读取。

API使用方法如:

curl -XGET 'localhost:9200/twitter/tweet/_search?scroll=1m' -d '

{

"query": {

"match" : {

"title" : "elasticsearch"

}

}

}

'

会自动返回一个_scroll_id,通过这个id可以继续查询(实际上这个ID会很长哦!):

curl -XGET 'localhost:9200/_search/scroll?scroll=1m&scroll_id=c2Nhbjs2OzM0NDg1ODpzRlBLc0FXNlNyNm5JWUc1'

注意,我在使用1.4版本的ES时,只支持把参数放在URL路径里面,不支持在JSON body中使用。

有个很有意思的事情,细心的会发现,这个ID其实是通过base64编码的:

cXVlcnlUaGVuRmV0Y2g7MTY7MjI3NTp2dFhLSjhsblFJbWRpd2NEdFBULWtBOzIyNzQ6dnRYS0o4bG5RSW1kaXdjRHRQVC1rQTsyMjgwOnZ0WEtKOGxuUUltZGl3Y0R0UFQta0E7MjI4MTp2dFhLSjhsblFJbWRpd2NEdFBULWtBOzIyODM6dnRYS0o4bG5RSW1kaXdjRHRQVC1rQTsyMjgyOnZ0WEtKOGxuUUltZGl3Y0R0UFQta0E7MjI4Njp2dFhLSjhsblFJbWRpd2NEdFBULWtBOzIyODc6dnRYS0o4bG5RSW1kaXdjRHRQVC1rQTsyMjg5OnZ0WEtKOGxuUUltZGl3Y0R0UFQta0E7MjI4NDp2dFhLSjhsblFJbWRpd2NEdFBULWtBOzIyODU6dnRYS0o4bG5RSW1kaXdjRHRQVC1rQTsyMjg4OnZ0WEtKOGxuUUltZGl3Y0R0UFQta0E7MjI3Njp2dFhLSjhsblFJbWRpd2NEdFBULWtBOzIyNzc6dnRYS0o4bG5RSW1kaXdjRHRQVC1rQTsyMjc4OnZ0WEtKOGxuUUltZGl3Y0R0UFQta0E7MjI3OTp2dFhLSjhsblFJbWRpd2NEdFBULWtBOzA7

如果使用解码工具可以看到:

queryThenFetch;16;2275:vtXKJ8lnQImdiwcDtPT-kA;2274:vtXKJ8lnQImdiwcDtPT-kA;2280:vtXKJ8lnQImdiwcDtPT-kA;2281:vtXKJ8lnQImdiwcDtPT-kA;2283:vtXKJ8lnQImdiwcDtPT-kA;2282:vtXKJ8lnQImdiwcDtPT-kA;2286:vtXKJ8lnQImdiwcDtPT-kA;2287:vtXKJ8lnQImdiwcDtPT-kA;2289:vtXKJ8lnQImdiwcDtPT-kA;2284:vtXKJ8lnQImdiwcDtPT-kA;2285:vtXKJ8lnQImdiwcDtPT-kA;2288:vtXKJ8lnQImdiwcDtPT-kA;2276:vtXKJ8lnQImdiwcDtPT-kA;2277:vtXKJ8lnQImdiwcDtPT-kA;2278:vtXKJ8lnQImdiwcDtPT-kA;2279:vtXKJ8lnQImdiwcDtPT-kA;0;

虽然搞不清楚里面是什么内容,但是看到了一堆规则的键值对,总是让人兴奋一下!

测试from&size VS scroll的性能

首先呢,需要在java中引入elasticsearch-jar,比如使用maven:

<dependency>

<groupId>org.elasticsearch</groupId>

<artifactId>elasticsearch</artifactId>

<version>1.4.4</version>

</dependency>

然后初始化一个client对象:

private static TransportClient client;

private static String INDEX = "index_name";

private static String TYPE = "type_name";

public static TransportClient init(){

Settings settings = ImmutableSettings.settingsBuilder()

.put("client.transport.sniff", true)

.put("cluster.name", "cluster_name")

.build();

client = new TransportClient(settings).addTransportAddress(new InetSocketTransportAddress("localhost",9300));

return client;

}

public static void main(String[] args) {

TransportClient client = init();

//这样就可以使用client执行查询了

}

然后就是创建两个查询过程了 ,下面是from-size分页的执行代码:

System.out.println("from size 模式启动!");

Date begin = new Date();

long count = client.prepareCount(INDEX).setTypes(TYPE).execute().actionGet().getCount();

SearchRequestBuilder requestBuilder = client.prepareSearch(INDEX).setTypes(TYPE).setQuery(QueryBuilders.matchAllQuery());

for(int i=0,sum=0; sum<count; i++){

SearchResponse response = requestBuilder.setFrom(i).setSize(50000).execute().actionGet();

sum += response.getHits().hits().length;

System.out.println("总量"+count+" 已经查到"+sum);

}

Date end = new Date();

System.out.println("耗时: "+(end.getTime()-begin.getTime()));

下面是scroll分页的执行代码,注意啊!scroll里面的size是相对于每个分片来说的,所以实际返回的数量是:分片的数量*size

System.out.println("scroll 模式启动!");

begin = new Date();

SearchResponse scrollResponse = client.prepareSearch(INDEX)

.setSearchType(SearchType.SCAN).setSize(10000).setScroll(TimeValue.timeValueMinutes(1))

.execute().actionGet();

count = scrollResponse.getHits().getTotalHits();//第一次不返回数据

for(int i=0,sum=0; sum<count; i++){

scrollResponse = client.prepareSearchScroll(scrollResponse.getScrollId())

.setScroll(TimeValue.timeValueMinutes(8))

.execute().actionGet();

sum += scrollResponse.getHits().hits().length;

System.out.println("总量"+count+" 已经查到"+sum);

}

end = new Date();

System.out.println("耗时: "+(end.getTime()-begin.getTime()));

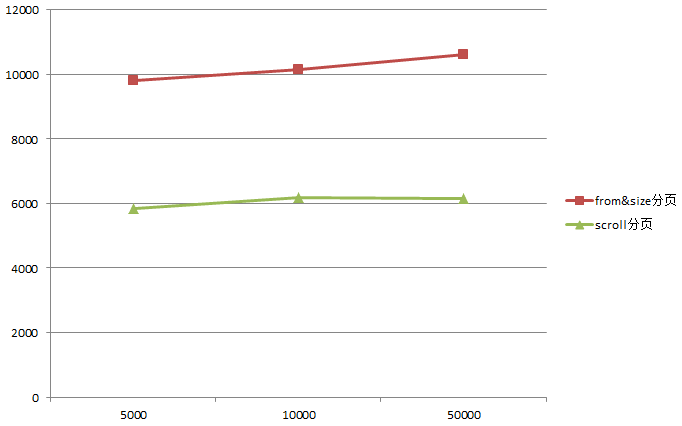

我这里总的数据有33万多,分别以每页5000,10000,50000的数据量请求,得到如下的执行时间:

可以看到仅仅30万,就相差接近一倍的性能,更何况是如今的大数据环境...因此,如果想要对全量数据进行操作,快换掉fromsize,使用scroll吧!

参考

1 简书:elasticsearch 的滚动(scroll)

2 16php:Elasticsearch Scroll API详解

3 elastic:from-size查询

4 elastic:scroll query

Elasticsearch——分页查询From&Size VS scroll的更多相关文章

- elasticsearch 分页查询实现方案——Top K+归并排序

elasticsearch 分页查询实现方案 1. from+size 实现分页 from表示从第几行开始,size表示查询多少条文档.from默认为0,size默认为10,注意:size的大小不能超 ...

- ElasticSearch—分页查询

ElasticSearch查询—分页查询详解 Elasticsearch中数据都存储在分片中,当执行搜索时每个分片独立搜索后,数据再经过整合返回.那么,如何实现分页查询呢? 按照一般的查询流程来说,如 ...

- elasticsearch 分页查询实现方案

1. from+size 实现分页 from表示从第几行开始,size表示查询多少条文档.from默认为0,size默认为10, 注意:size的大小不能超过index.max_result_wind ...

- ElasticSearch——分页查询

前言 ElasticSearch实现分页查询,有3种方式,他们在数据查询中各自占据着不同的优势,因此在搜索引擎的数据分页过程中,如何更好地利用各自的优势来进行数据查询是一个非常重要的过程. 传统分页( ...

- Elasticsearch 分页查询

目录 前言 from + size search after scroll api 总结 参考资料 前言 我们在实际工作中,有很多分页的需求,商品分页.订单分页等,在MySQL中我们可以使用limit ...

- Elasticsearch分页查询

global index global CLIENT index = "guajibao-ipused-2019.10.13" CLIENT = Elasticsearch(hos ...

- SpringBoot整合Elasticsearch游标查询(scroll)

游标查询(scroll)简介 scroll 查询 可以用来对 Elasticsearch 有效地执行大批量的文档查询,而又不用付出深度分页那种代价. 游标查询会取某个时间点的快照数据. 查询初始化之后 ...

- elasticsearch查询之大数据集分页查询

一. 要解决的问题 search命中的记录特别多,使用from+size分页,直接触发了elasticsearch的max_result_window的最大值: { "error" ...

- Elasticsearch from/size-浅分页查询-深分页 scroll-深分页search_after深度查询区别使用及应用场景

Elasticsearch调研深度查询 1.from/size 浅分页查询 一般的分页需求我们可以使用from和size的方式实现,但是这种的分页方式在深分页的场景下应该是避免使用的.深分页的页次增加 ...

随机推荐

- SQL入门经典(五) 之键和约束

这一篇博客主要讲键的创建,约束的创建.修改对象和删除对象. 主键:主键是每行的唯一标识符,必须包含唯一值(因此不能为NULL).由于主键在关系中数据库的重要性,因此它是所有键和约束中最重要的.一个表最 ...

- Redis 发布订阅

订阅: class Program { //版本2:使用Redis的客户端管理器(对象池) public static IRedisClientsManager redisClientManager ...

- 用JQ仿造礼德财富网的图片查看器

现在就职于一家P2P平台,自然也会关注同行其它网站的前端技术,今天要仿造的是礼德内页的一个图片查看器效果.不过说白了,无论人人贷也好礼德财富也好,很多地方的前端都做的不尽如人意,比如忽略细节.缺乏交互 ...

- objective-c(反射)

objective-c中提供类似JAVA的反射特性,给出基本例子如下: #import <Foundation/Foundation.h> @interface ClassA : NSOb ...

- 【源码笔记】Nop定时任务

网站需要定时执行不同的任务,比如清理无效的数据.定时发送mail等,Nop的这个定时任务设计比较好,简单的说就是将所有任务相同的属性持久化,具体的执行通过继承接口来实现. 持久化对象:Schedule ...

- Ehcache BigMemory: 摆脱GC困扰

问题 使用java开源项目经常需要调优jvm,以优化gc.对于gc,如果对象都是短时对象,那么jvm相对容易优化,假如碰上像solr使用自带java cache的项目,那么gc严重受限于cache,因 ...

- 难道只有我一个人想吐槽npm这种包管理方式么

实在忍不住吐槽 说实话有强迫症的我忍了很久了,实在是忍不住写篇文章来吐槽一下. 标题可能说的有点大了,我要吐槽的是:我可能只需要某一个小小的功能模块A,结果模块A依赖B-F这5个模块,然后B又依赖这1 ...

- Senparc.Weixin.MP SDK 微信公众平台开发教程(八):通用接口说明

一.基础说明 这里说的“通用接口(CommonAPIs)”是使用微信公众账号一系列高级功能的必备验证功能(应用于开发模式). 我们通过微信后台唯一的凭证,向通用接口发出请求,得到访问令牌(Access ...

- EF架构~在T4模版中为所有属性加默认值

回到目录 在项目开发过程中,出现了一个问题,就是新添加一个非空字段后,原来的程序逻辑需要被重新修改,即将原来的字段添加到程序里,这种作法是非常不提倡的,所以,我通过T4模版将原来的实体类小作修改,解决 ...

- iOS-旧项目中手动内存管理(MRC)转ARC

在ARC之前,iOS内存管理无论对资深级还是菜鸟级开发者来说都是一件很头疼的事.我参 加过几个使用手动内存管理的项目,印象最深刻的是一个地图类应用,由于应用本身就非常耗内存,当时为了解决内存泄露问题, ...