filebeat收集nginx的json格式日志

一、在nginx主机上安装filebeat组件

[root@zabbix_server nginx]# cd /usr/local/src/

[root@zabbix_server src]# wget https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-6.2.4-x86_64.rpm

[root@zabbix_server src]# yum localinstall filebeat-6.2.-x86_64.rpm

二、配置filebeat配置文件

[root@zabbix_server src]# vim /etc/filebeat/filebeat.yml

filebeat.prospectors:

- type: log

enabled: true

json.keys_under_root: true #json格式收集

json.overwrite_keys: true #json格式收集

paths:

- /var/log/nginx/access.log #需要收集的日志文件路径

fields:

log_topics: nginx-172.28.18.75 #设置日志标题 output.logstash:

hosts: ["172.28.18.69:10001"] #输出到logstash服务地址和端口

三、配置nginx.conf文件,设置json格式日志

[root@zabbix_server src]# vim /etc/nginx/nginx.conf

log_format access_json_log '{"@timestamp":"$time_local",'

'"http_host":"$http_host",'

'"clinetip":"$remote_addr",'

'"request":"$request",'

'"status":"$status",'

'"size":"$body_bytes_sent",'

'"upstream_addr":"$upstream_addr",'

'"upstream_status":"$upstream_status",'

'"upstream_response_time":"$upstream_response_time",'

'"request_time":"$request_time",'

'"http_referer":"$http_referer",'

'"http_user_agent":"$http_user_agent",'

'"http_x_forwarded_for":"$http_x_forwarded_for"}'; access_log /var/log/nginx/access.log access_json_log;

四、检查配置文件语法,并重载

[root@zabbix_server src]# nginx -tc /etc/nginx/nginx.conf

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

[root@zabbix_server src]# nginx -s reload

五、查看access.log日志输出

[root@zabbix_server src]# tail -f /var/log/nginx/access.log

{"@timestamp":"15/Jul/2019:10:33:23 +0800","http_host":"zabbix.9500.cn","clinetip":"219.239.8.14","request":"POST /zabbix.php?sid=311c76f6740bc2f7&action=widget.problems.view HTTP/1.1","status":"","size":"","upstream_addr":"127.0.0.1:9000","upstream_status":"","upstream_response_time":"1.103","request_time":"1.103","http_referer":"http://zabbix.9500.cn/zabbix.php?action=dashboard.view&ddreset=1","http_user_agent":"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0","http_x_forwarded_for":"-"}

{"@timestamp":"15/Jul/2019:10:33:23 +0800","http_host":"zabbix.9500.cn","clinetip":"219.239.8.14","request":"POST /zabbix.php?sid=9203532d28b920b3&action=widget.problems.view HTTP/1.1","status":"","size":"","upstream_addr":"127.0.0.1:9000","upstream_status":"","upstream_response_time":"0.759","request_time":"0.759","http_referer":"http://zabbix.9500.cn/zabbix.php?action=dashboard.view&ddreset=1","http_user_agent":"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36","http_x_forwarded_for":"-"}

已经变成json格式的日志输出了。

六、在logstash服务器上的/etc/logstash/conf.d/目录下,新建一个nginx.conf文件

用于监听10001端口,负责收集filebeat传递过来的日志数据,并向elasticseatch服务发送日志数据

[root@server- conf.d]# vim /etc/logstash/conf.d/nginx.conf

input {

beats {

port=>10001 #监听filebeat发送日志的端口

}

} output {

if[fields][log_topics]=="nginx-172.28.18.75"{ #判断是否是filebeat配置设置的fields字段,是则发送到elastcisearch

elasticsearch {

hosts=>["172.28.18.69:9200"]

index=>"nginx-172.28.18.75-%{+YYYY.MM.dd}" #设置索引名字

}

}

}

七、重启logstash服务,并查看端口

[root@server- conf.d]# systemctl restart logstash

[root@server- conf.d]# netstat -tunlp|grep

tcp6 ::: :::* LISTEN /java

启动成功

八、重启nginx主机上的filebeat服务

[root@zabbix_server src]# systemctl restart filebeat

九、查看elasticsearch服务器上是否有新建的索引

[root@zabbix_server etc]# curl 172.28.18.69:/_cat/indices?v

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open .kibana nQhtAX5YSSKzT1p0G-1XtA .2kb .2kb

yellow open nginx-172.28.5.214-2019.07. tH8oVfZhQy-TdnIPHyFgvQ .8mb .8mb

yellow open system-syslog-2019.07 REp7fM_gSaquo9PX2_sREQ .6gb .6gb

可以看到日志已经成功收集到elasticsearch服务器上了

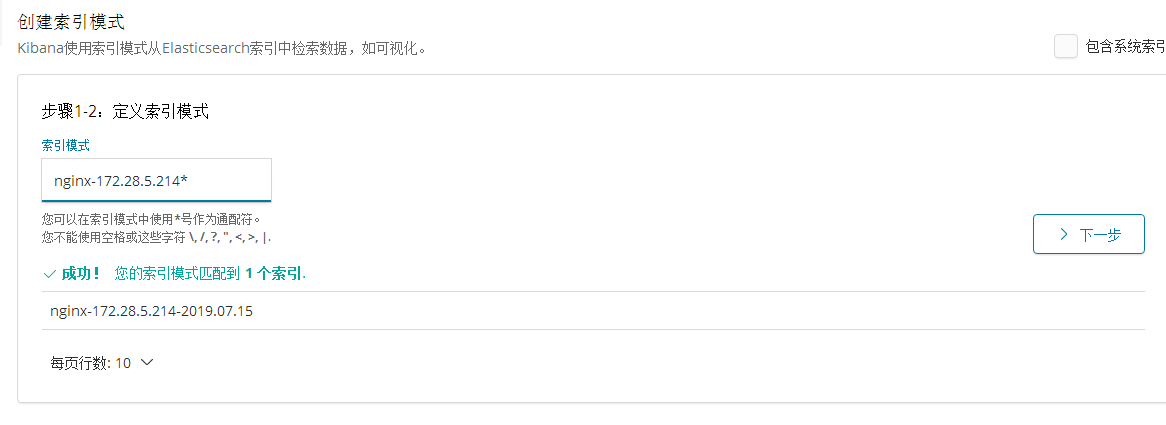

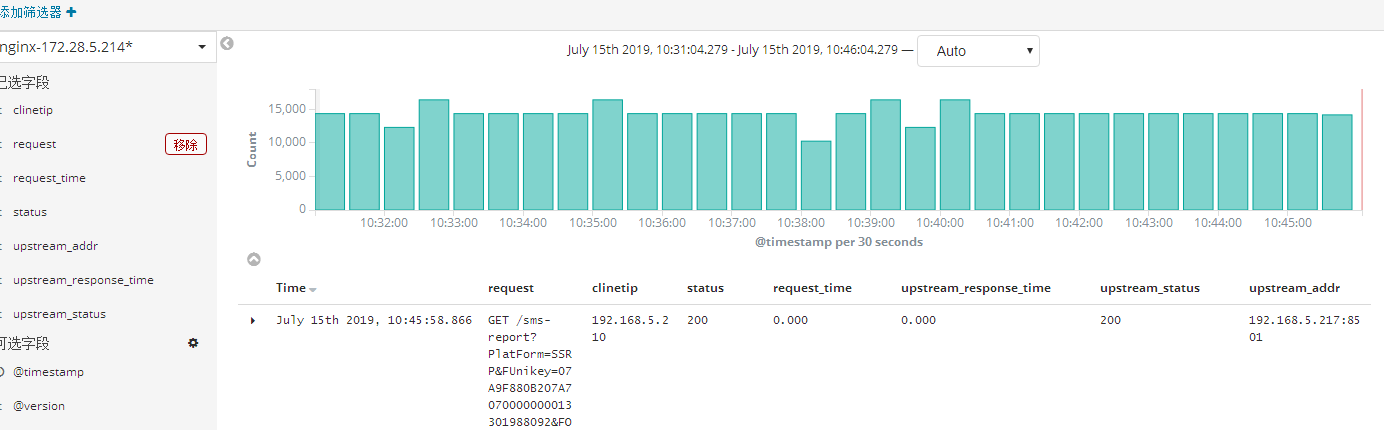

十、配置kibana,展示日志数据

系统管理---索引模式--创建索引模式

发现菜单里已经可以看到数据了

filebeat收集nginx的json格式日志的更多相关文章

- 使用filebeat解析nginx的json格式日志,并且保存原始message字段的值,输出到es中并通过grafana图形化显示

1.nginx日志调成json样式 log_format json '{"@timestamp":"$time_iso8601",' '"server ...

- 收集Nginx的json格式日志(五)

一.配置nginx [root@linux-node1 ~]# vim /etc/nginx/nginx.conf #修改日志格式为json格式,并创建一个nginxweb的网站目录 log_form ...

- Logstash动态模板映射收集Nginx的Json格式日志

Logstash传输给ES的数据会自动映射为5索引,5备份,字段都为text的的索引.这样基本上无法进行数据分析.所以必须将Logstash的数据按照既定的格式存储在ES中,这时候就要使用到ES模板技 ...

- ELK之收集Nginx、Tomcat的json格式日志

1.安装Nginx yum -y install nginx vim /etc/nginx/nginx.conf # 修改日志格式为json格式,并创建一个nginxweb的网站目录 log_form ...

- Nginx 高级配置-自定义json格式日志

Nginx 高级配置-自定义json格式日志 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 在大数据运维工作中,我们经常会使用flume,filebeat相关日志收集工具取收集日志 ...

- Docker安装ELK并实现JSON格式日志分析

ELK是什么 ELK是elastic公司提供的一套完整的日志收集以及前端展示的解决方案,是三个产品的首字母缩写,分别是ElasticSearch.Logstash和Kibana. 其中Logstash ...

- Maven项目配置Logback输出JSON格式日志

最近,项目提出需求,日志需要固定输出为JSON格式,以便后端Flink程序解析. 项目背景 项目为简单的Maven项目,日志由Filebeat采集,因此不需要配置输出至Logstash. 下面为pom ...

- 使用filebeat收集不同用应用的日志传输到redis,并加以区分

附加技巧 步骤流程: 使用filebeat收集一台主机上两个不同应用的日志,传递给redis,然后logstash从redis中拉去数据传递给elasticsearch 1.filebeat.yml文 ...

- nginx 返回json格式内容

例子: #如果访问的ip是192.168.1.1,就直接返回json格式的内容 location / { default_type application/json; #####格式 if ( $re ...

随机推荐

- 【转载】如何在 Kaggle 首战中进入前 10%

本文转载自如何在 Kaggle 首战中进入前 10% 转载仅出于个人学习收藏,侵删 Introduction 本文采用署名 - 非商业性使用 - 禁止演绎 3.0 中国大陆许可协议进行许可.著作权由章 ...

- redis 之django-redis

redis之django-redis 自定义连接池 这种方式跟普通py文件操作redis一样,代码如下: views.py import redis from django.shortcuts i ...

- 04 npm 命令大全

一.npm简介 npm(Node Package Manager)是随同node.js 一起安装的包管理工具,为了解决nodejs代码部署上的很多问题,常用以下场景: 允许用户从npm服务器下载别 ...

- 【转载】mysql行列转换方法总结

[转载]mysql行列转换方法总结 [MySQL] 行列转换变化各种方法实现总结(行变列报表统计.列变行数据记录统计等) Mysql 列转行统计查询 .行转列统计查询 在某些数据库中有交叉表,但在My ...

- C++学习笔记-多态

多态作为面向对象的重要概念,在如何一门面向对象编程语言中都有着举足轻重的作用,学习多态,有助于更好地理多态的行为 多态性(Polymorphism)是指一个名字,多种语义:或界面相同,多种实现. 重载 ...

- C++学习笔记-继承

类之间可以建立联系,这就使得类可以有某种关系 类之间的关系 has-A:包含关系,一个类使用另一个已经定义好的类的数据 uses-A:使用关系,友元或者对象参数传递 is-A:是的关系,这就是继承,具 ...

- 解决应用程序无法正常启动0xc0150002问题(转)

简述:使用VS2008写了一个MFC程序,结果传到别人的机子上(WIN7)出现应用程序正常初始化(0xc0150002)失败的问题.为什么我的机子上可以,而别人的机子上运行不了呢?下面是我找到的一个解 ...

- [c++] 计算太阳高度角

/* 输入参数: Longitude - 经度(单位"度") Latitude - 纬度(单位"度") Year - 年 Month - 月 Day - 日 H ...

- [python] a little deep learning case

from numpy import exp, array, random, dot class NeuralNetwork(): def __init__(self): random.seed(1) ...

- ADG环境搭建

一:实验环境介绍PC机系统: CentOS 6.5(64位)数据库版本: Oracle 11gR2 11.2.0.4 (64位)IP地址规划:主数据库10.110.9.41 SID:orapridb_ ...