python网络爬虫之scrapy 调试以及爬取网页

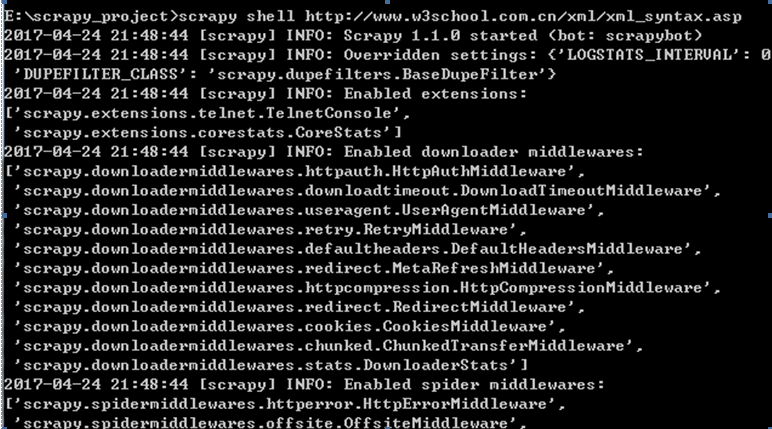

Shell调试:

进入项目所在目录,scrapy shell “网址”

如下例中的:

scrapy shell http://www.w3school.com.cn/xml/xml_syntax.asp

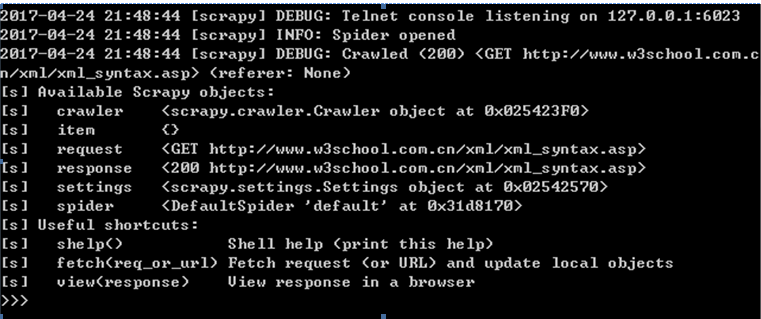

可以在如下终端界面调用过程代码如下所示:

相关的网页代码:

我们用scrapy来爬取一个具体的网站。以迅读网站为例。

如下是首页的内容,我想要得到文章列表以及对应的作者名称。

首先在items.py中定义title, author. 这里的Test1Item和Django中的modul作用类似。这里可以将Test1Item看做是一个容器。这个容器继承自scrapy.Item.

而Item又继承自DictItem。因此可以认为Test1Item就是一个字典的功能。其中title和author可以认为是item中的2个关键字。也就是字典中的key

class Item(DictItem):

class Test1Item(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

title=Field()

author=Field()

下面就在test_spider.py中开始写网页解析代码

from scrapy.spiders import Spider

from scrapy.selector import Selector

from test1.items import Test1Item

class testSpider(Spider):

name="test1" #这里的name必须和创建工程的名字一致,否则会提示找不到爬虫项目

allowd_domains=['http://www.xunsee.com']

start_urls=["http://www.xunsee.com/"]

def parse(self, response):

items=[]

sel=Selector(response)

sites = sel.xpath('//*[@id="content_1"]/div') #这里是所有数据的入口。下面所有的div都是存储的文章列表和作者

for site in sites:

item=Test1Item()

title=site.xpath('span[@class="title"]/a/text()').extract()

h=site.xpath('span[@class="title"]/a/@href').extract()

item['title']=[t.encode('utf-8') for t in title]

author=site.xpath('span[@class="author"]/a/text()').extract()

item['author']=[a.encode('utf-8') for a in author]

items.append(item)

return items

获取到title以及author的内容后,存储到item中。再将所有的item存储在items的列表中

在pipelines.py中修改Test1Pipeline如下。这个类中实现的是处理在testSpider中返回的items数据。也就是存储数据的地方。我们将items数据存储到json文件中去

class Test1Pipeline(object):

def __init__(self):

self.file=codecs.open('xundu.json','wb',encoding='utf-8')

def process_item(self, item, spider):

line=json.dumps(dict(item)) + '\n'

self.file.write(line.decode("unicode_escape"))

return item

工程运行后,可以看到在目录下生成了一个xundu.json文件。其中运行日志可以在log文件中查看

从这个爬虫可以看到,scrapy的结构还是比较简单。主要是三步:

1 items.py定义内容存储的关键字

2 自定义的test_spider.py中进行网页数据的爬取并返回数据

3 pipelines.py中对tes_spider.py中返回的内容进行存储

python网络爬虫之scrapy 调试以及爬取网页的更多相关文章

- 爬虫(二)Python网络爬虫相关基础概念、爬取get请求的页面数据

什么是爬虫 爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程. 哪些语言可以实现爬虫 1.php:可以实现爬虫.php被号称是全世界最优美的语言(当然是其自己号称的,就是王婆 ...

- 【Python网络爬虫四】通过关键字爬取多张百度图片的图片

最近看了女神的新剧<逃避虽然可耻但有用>,同样男主也是一名程序员,所以很有共鸣 被大只萝莉萌的一脸一脸的,我们来爬一爬女神的皂片. 百度搜索结果:新恒结衣 本文主要分为4个部分: 1.下载 ...

- Python网络爬虫第三弹《爬取get请求的页面数据》

一.urllib库 urllib是Python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在Python3中的为urllib.request和urllib. ...

- Python网络爬虫案例(二)——爬取招聘信息网站

利用Python,爬取 51job 上面有关于 IT行业 的招聘信息 版权声明:未经博主授权,内容严禁分享转载 案例代码: # __author : "J" # date : 20 ...

- [Python]网络爬虫(一):抓取网页的含义和URL基本构成

一.网络爬虫的定义 网络爬虫,即Web Spider,是一个很形象的名字. 把互联网比喻成一个蜘蛛网,那么Spider就是在网上爬来爬去的蜘蛛.网络蜘蛛是通过网页的链接地址来寻找网页的. 从网站某一个 ...

- Python网络爬虫之Scrapy框架(CrawlSpider)

目录 Python网络爬虫之Scrapy框架(CrawlSpider) CrawlSpider使用 爬取糗事百科糗图板块的所有页码数据 Python网络爬虫之Scrapy框架(CrawlSpider) ...

- Python使用urllib,urllib3,requests库+beautifulsoup爬取网页

Python使用urllib/urllib3/requests库+beautifulsoup爬取网页 urllib urllib3 requests 笔者在爬取时遇到的问题 1.结果不全 2.'抓取失 ...

- python网络爬虫之scrapy 工程创建以及原理介绍

执行scrapy startproject XXXX的命令,就会在对应的目录下生成工程 在pycharm中打开此工程目录:并在Run中选择Edit Configuration 点击+创建一个Pytho ...

- 16.Python网络爬虫之Scrapy框架(CrawlSpider)

引入 提问:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模块递归回调parse方法). 方法 ...

随机推荐

- Hibernate级联及控制反转的增删改查

在JavaHibernate中,双向多对一的操作一直是一个重点难点,本篇文章就是来探讨这个问题. 双向多对一:一个班级对应多个学生,多个学生同属于一个班级,通过班级信息可以查到班级内的学生,通过学生可 ...

- Linux(Centos)——下升级python3.3

CentOS下的Python版本一般都比较低,很多应用都需要升级python来完成.我装的centOS的默认的python版本是V2.4.3,但运行node.js需要的版本是2.5以上. 1.下载py ...

- react-native 项目实战 -- 新闻客户端(5) -- 完善首页列表数据

1.Home.js: /** * 首页 */ import React, { Component } from 'react'; import { AppRegistry, StyleSheet, T ...

- 仿IOS中下拉刷新的“雨滴”效果

在IOS中,有非常赞的"水滴"下拉效果.非常久之前也想在Android上实现,可是苦于能力有限,一直未能付诸行动.这几天趁着空隙时间.写了一版初步实现,基本达到了"水滴& ...

- 转载(Asp.net Core 中试使用ZKWeb.System.Drawing)

完美 原文Link: https://www.yanning.wang/archives/644.html 记录下做备份. 很少用Linux服务器. 这下可给整的够呛, 特别是按照官网竟然还不行, 所 ...

- sql server内置函数

MSDN标准文档:https://msdn.microsoft.com/zh-cn/library/ff848784(v=sql.120).aspx 配置函数 select @@servername ...

- 如何快速复制BAT级的DevOps工具链

1.流水线改变世界 1910年,福特汽车在引入流水线生产之后,Model-T 的组装时间缩短了8倍,从12.5小时降到了1.5小时,这就是流水线改变世界的神话,造就了汽车上的国家! 那流水线怎么改变软 ...

- lvs+keepalived+bind实现负载均衡高可用智能dns

整体架构: 1.IP地址规划: Dns1:172.28.0.54 Dns2:172.28.0.55 Dr服务器主:172.28.0.57 Dr服务器从:172.28.0.67 Vip:172.28.0 ...

- mysql中把字符串转成时间戳进行对比

::") ");

- SpringCloud系列四:实现Eureka Server的高可用并将应用注册到Eureka Sever集群上

1. 回顾 上一篇博客中,实现了单节点的Eureka Server.Eureka Client会定时连接Eureka Server,获取注册表中的信息并缓存到本地.微服务在消费远程API时总是使用本地 ...