Python爬虫01——第一个小爬虫

Python小爬虫——贴吧图片的爬取

在对Python有了一定的基础学习后,进行贴吧图片抓取小程序的编写。

目标:

- 首先肯定要实现图片抓取这个基本功能

- 然后实现对用户所给的链接进行抓取

- 最后要有一定的交互,程序不能太傻吧

一、页面获取

要让python可以进行对网页的访问,那肯定要用到urllib之类的包。So先来个 import urllib

urllib中有 urllib.urlopen(str) 方法用于打开网页并返回一个对象,调用这个对象的read()方法后能直接获得网页的源代码,内容与浏览器右键查看源码的内容一样。

#coding:utf-8

import urllib page = urllib.urlopen('http://tieba.baidu.com/p/1753935195')#打开网页

htmlcode = page.read()#读取页面源码

print htmlcode#在控制台输出

运行结果与查看源码其实差不多

运行结果就不放上来了

也可以写到文本文档中:

#coding:utf-8

import urllib page = urllib.urlopen('http://tieba.baidu.com/p/1753935195')

htmlcode = page.read()

#print htmlcode pageFile = open('pageCode.txt','w')#以写的方式打开pageCode.txt

pageFile.write(htmlcode)#写入

pageFile.close()#开了记得关

运行一遍,txt就出现在了getJpg.py 的目录下

的目录下

好了别闹,我们把它封装成方法:

def get_html(url):

page = urllib.urlopen(url)

html = page.read()

return html

然后我们的页面获取代码就K.O.了

二、图片(目标)的提取

做完上面步骤,你打开txt一看,我去!这都是什么跟什么啊,根本找不到图片在哪好伐?

客官别急啊,我这就去给你叫我们的小。。。图片!图片!

首先我们要一个正则表达式 (什么你不会?请看菜鸟入门教程-->Go)

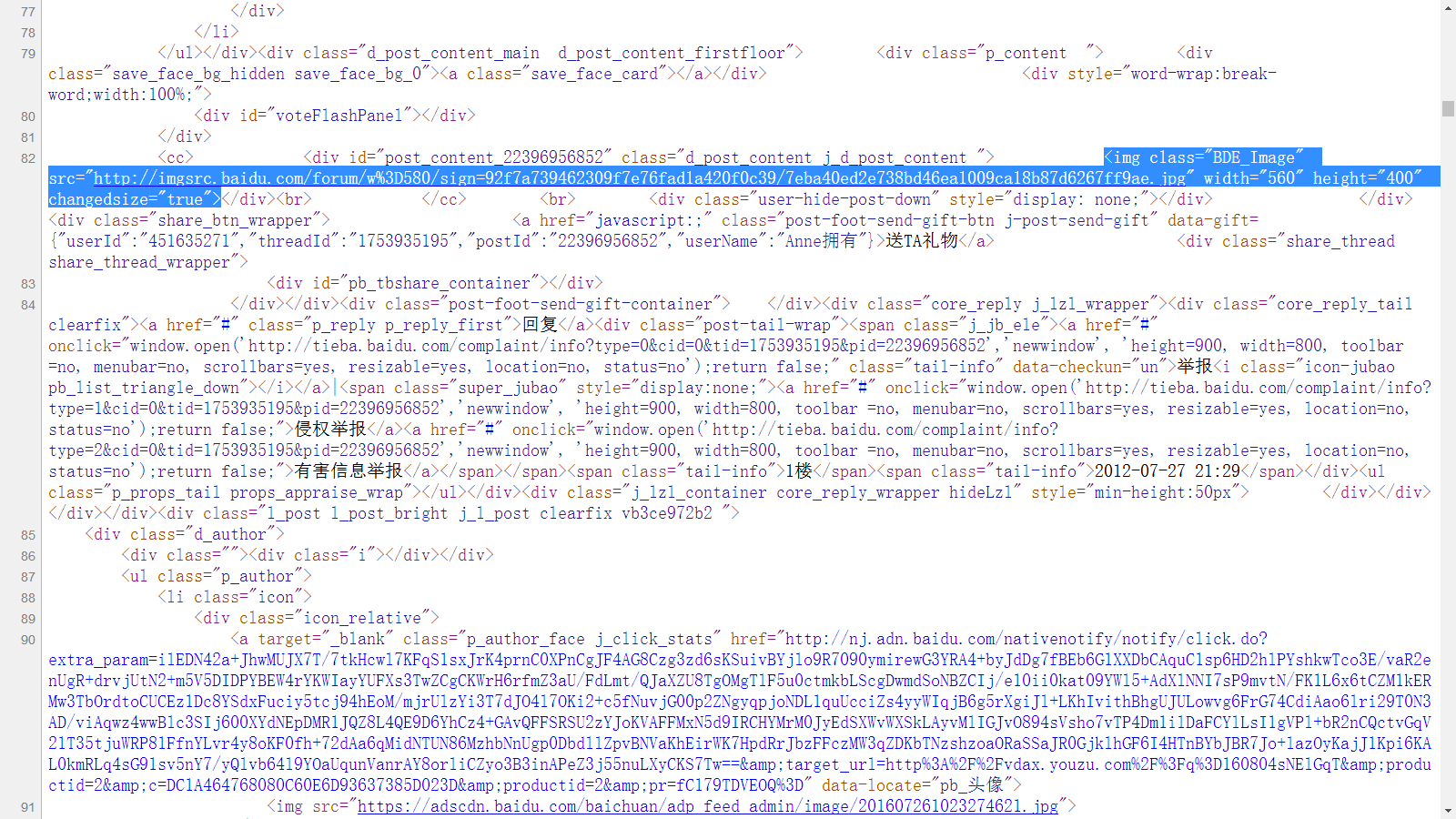

然后我们看源代码,Yeah 我们找到了其中一张图片是这样的

写出图片的正则表达式: reg = r'src="(.+?\.jpg)" width'

解释下吧——匹配以src="开头然后接一个或多个任意字符(非贪婪),以.jpg" width结尾的字符串。比如图中红框内src后 双引号里的链接就是一个匹配的字符串。

接着我们要做的就是从get_html方法返回的辣么长一串字符串中 拿到 满足正则表达式的 字符串。

用到python中的re库中的 re.findall(str) 它返回一个满足匹配的字符串组成的列表

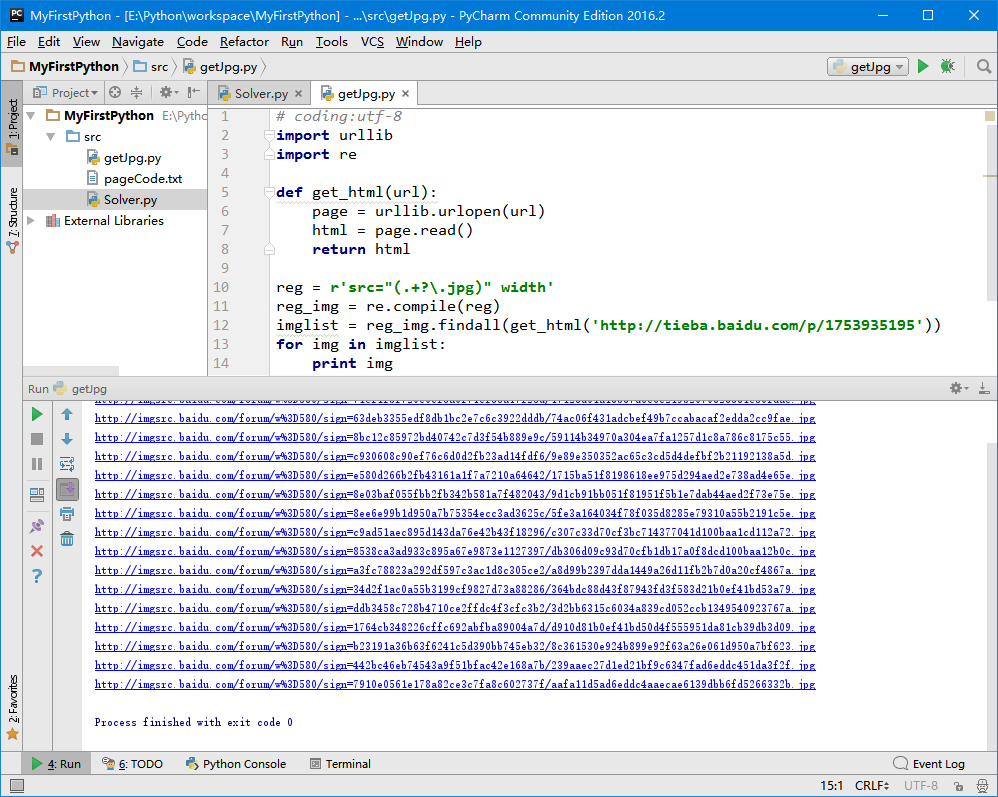

# coding:utf-8

import urllib

import re def get_html(url):

page = urllib.urlopen(url)

html = page.read()

return html reg = r'src="(.+?\.jpg)" width'#正则表达式

reg_img = re.compile(reg)#编译一下,运行更快

imglist = reg_img.findall(get_html('http://tieba.baidu.com/p/1753935195'))#进行匹配

for img in imglist:

print img

打印出这么多图片链接

光把链接拿出来没用啊,我们的目标是下载下来~

urllib库中有一个 urllib.urlretrieve(链接,名字) 方法,它的作用是以第二个参数为名字下载链接中的内容,我们来试用一下

在上面代码循环中加上 urllib.urlretrieve(img, 'tieba.jpg')

卧槽!!!怎么只下了一张

至少它下载了不是?啪啪啪啪啪(掌声)

检查下问题出在哪。。。。

没错我们只给了一个tieba.jpg的名字,后来的把前面的覆盖了。

调整下代码:

# coding:utf-8

import urllib

import re def get_html(url):

page = urllib.urlopen(url)

html = page.read()

return html reg = r'src="(.+?\.jpg)" width'

reg_img = re.compile(reg)

imglist = reg_img.findall(get_html('http://tieba.baidu.com/p/1753935195'))

x = 0

for img in imglist:

urllib.urlretrieve(img, '%s.jpg' %x)

x += 1

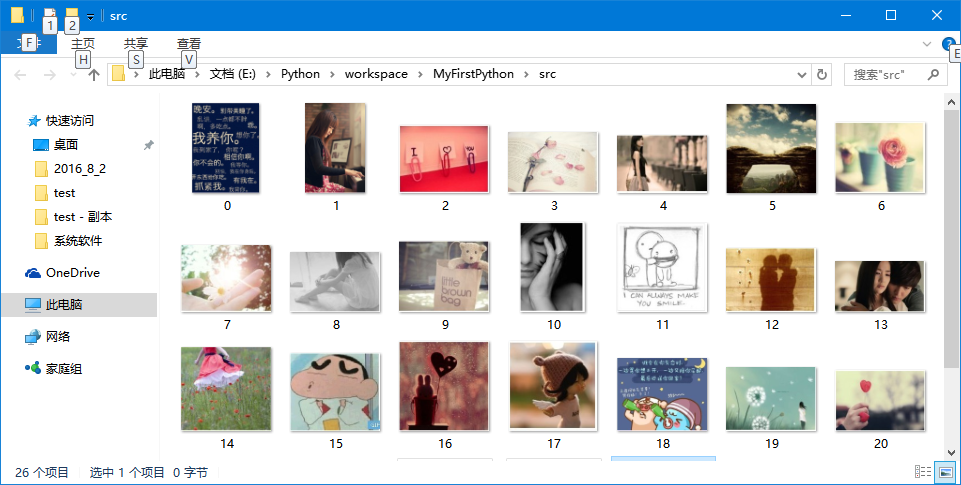

啪啪啪啪啪

第一步完成~

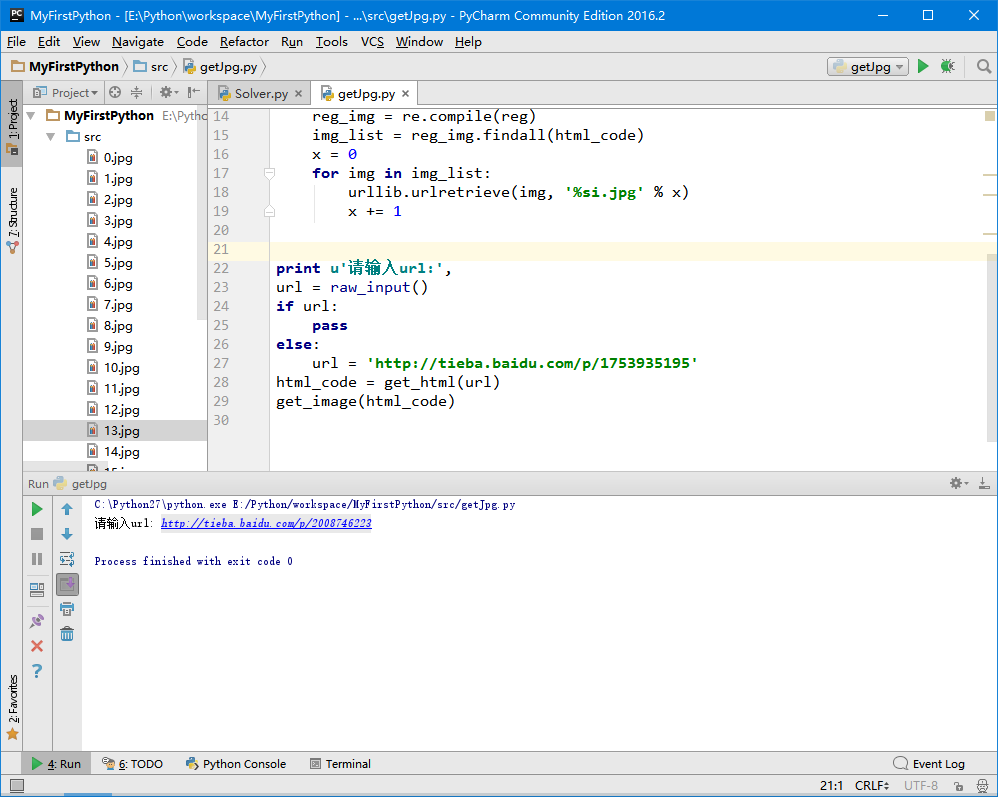

三、指定链接抓取

我想要抓另一个帖子,总不能打开源代码,然后把那段地址改了在运行吧。

只是一个小程序,那也不行欸,加一个让用户指定地址的交互。

先把提取图片的那段代码打包下:

def get_image(html_code):

reg = r'src="(.+?\.jpg)" width'

reg_img = re.compile(reg)

img_list = reg_img.findall(html_code)

x = 0

for img in img_list:

urllib.urlretrieve(img, '%s.jpg' % x)

x += 1

最后来个请输入:

print u'请输入url:',

url = raw_input()

if url:

pass

else:

url = 'http://tieba.baidu.com/p/1753935195'

html_code = get_html(url)

get_image(html_code)

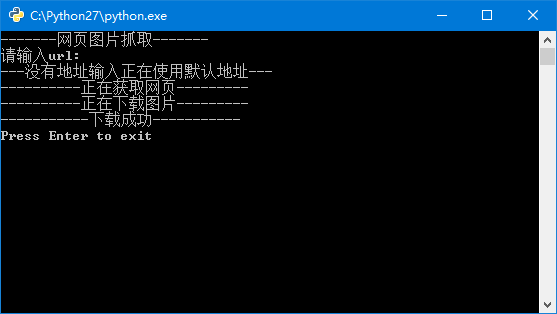

运行一下,试试另一个帖子:

完美~~

四、交互的添加

虽然写的是一个简单的小程序,但有强迫症的我还是给他加上了交互(不然多难受啊:双击,屏幕一闪,下载完了。。。)

最后的代码

# coding:utf-8

import urllib

import re def get_html(url):

page = urllib.urlopen(url)

html_code = page.read()

return html_code def get_image(html_code):

reg = r'src="(.+?\.jpg)" width'

reg_img = re.compile(reg)

img_list = reg_img.findall(html_code)

x = 0

for img in img_list:

urllib.urlretrieve(img, '%s.jpg' % x)

x += 1 print u'-------网页图片抓取-------'

print u'请输入url:',

url = raw_input()

if url:

pass

else:

print u'---没有地址输入正在使用默认地址---'

url = 'http://tieba.baidu.com/p/1753935195'

print u'----------正在获取网页---------'

html_code = get_html(url)

print u'----------正在下载图片---------'

get_image(html_code)

print u'-----------下载成功-----------'

raw_input('Press Enter to exit')

相对来说比较舒服的交互体验,大功告成~

Python爬虫01——第一个小爬虫的更多相关文章

- Python 学习(1) 简单的小爬虫

最近抽空学了两天的Python,基础知识都看完了,正好想申请个联通日租卡,就花了2小时写了个小爬虫,爬一下联通日租卡的申请页面,看有没有好记一点的手机号~ 人工挑眼都挑花了. 用的IDE是PyCh ...

- 使用Python写的第一个网络爬虫程序

今天尝试使用python写一个网络爬虫代码,主要是想訪问某个站点,从中选取感兴趣的信息,并将信息依照一定的格式保存早Excel中. 此代码中主要使用到了python的以下几个功能,因为对python不 ...

- 利用python写一个简单的小爬虫 爬虫日记(1)(好好学习)

打开py的IDLE >>>import urllib.request >>>a=urllib.request.urlopen("http://www.ba ...

- 从Python小白到第一个小游戏发布

1.安装必要的环境(附图两张) 直接下载安装程序,本人win10系统,根据电脑系统下载并安装对应的python.exe,安装路径可以选择D盘的,具体安装细节这里就不说了,不知道的可以留言或者找度娘 2 ...

- python3速查参考- python基础 1 -> python版本选择+第一个小程序

题外话: Python版本:最新的3.6 安装注意点:勾选添加路径后自定义安装到硬盘的一级目录,例如本人的安装路径: F:\Python 原因:可以自动添加python环境变量,自动关联.py文件,其 ...

- Python做的第一个小项目-模拟登陆

1. 用户输入帐号密码进行登陆 2. 用户信息保存在文件内 3. 用户密码输入错误三次后锁定用户 主要采用循环语句和条件语句进行程序流程的控制,加入文件的读写操作 while True: choice ...

- 用Python 3写的一个Spider小爬虫(使用内置urllib模块and正则表达式)

用Python写了一个Spider小爬虫,爬一爬斗鱼“王者荣耀”在线直播的主播及人气

- Python爬虫02——贴吧图片爬虫V2.0

Python小爬虫——贴吧图片爬虫V2.0 贴吧图片爬虫进阶:在上次的第一个小爬虫过后,用了几次发现每爬一个帖子,都要自己手动输入帖子链接,WTF这程序简直反人类!不行了不行了得改进改进. 思路: 贴 ...

- python 10 min系列三之小爬虫(一)

python10min系列之小爬虫 前一篇可视化大家表示有点难,写点简单的把,比如命令行里看论坛的十大,大家也可以扩展为抓博客园的首页文章 本文原创,同步发布在我的github上 据说去github右 ...

随机推荐

- 微信小程序登录数据解密以及状态维持

学习过小程序的朋友应该知道,在小程序中是不支持cookie的,借助小程序中的缓存我们也可以存储一些信息,但是对于一些比较重要的信息,我们需要通过登录状态维持来保存,同时,为了安全起见,用户的敏感信息, ...

- 脚本语言:Xmas(一)

很偶然的一个想法,在从北京回成都的高铁上:我想要一个计算器.于是在火车上花了十来个小时,完成了一个模型:能够处理+-*/的优先级,以及"()",比如:1+(3+2)*4.这已是一年 ...

- 使用Dockerfile制作自己的Docker镜像

一.背景 一直以来的开发流程都是先从Docker Hub中获取到基础镜像,之后在这个镜像的基础上做开发,以满足一定的需求或者提供某种服务,并由此产生新的镜像,然后就可以push到Docker Hub中 ...

- 设置spring-boot的logging

spring-boot默认使用logback来记录logger,spring-boot的包里面org.springframework.boot.logging.logback路径下面有一些配置文件,默 ...

- phpmyadmin 免登陆

第一步: 打开 phpmyadmin/libraries/plugins/auth/AuthenticationCookie.class.php 找到 authCheck 和 authSetUser ...

- 基于jQuery的自定义插件:实现整屏分页转换的功能

动态创建jQuery插件 一.实现功能: 1.基本功能:自适应式整屏分页功能的实现 2.通过鼠标点击标签页转换分页,支持键盘上下左右键的转换分页,同样支持 鼠标滚轮上下滑动转换分页 3.切屏时的动画效 ...

- java:Comparable比较器

/*Comparable 是java.lang中的一个接口,所以是默认导入的,不需要显示的导入. *如果你先直接在本类中实现排序,那么可以直接实现该接口(例如:public class Compara ...

- redis持久化快速回忆手册

Redis提供的持久化机制: 1). RDB持久化:该机制是指在指定的时间间隔内将内存中的数据集快照写入磁盘. 2). AOF持久化:该机制将以日志的形式记录服务器所处理的每一个写操作,在Redis服 ...

- 一个大数据平台省了20个IT人力——敦奴数据平台建设案例分享

认识敦奴 敦奴集团创立于1987年,主营服装.酒店.地产,总部位于中国皮都-海宁.浙江敦奴联合实业股份有限公司(以下简称"敦奴")是一家集开发.设计.生产.销售于一体的大型专业服装 ...

- openresty源码剖析——lua代码的执行

上一篇文章中我们讨论了openresty是如何加载lua代码的 那么加载完成之后的lua代码又是如何执行的呢 ##代码的执行 在init_by_lua等阶段 openresty是在主协程中通过lu ...