hbase 安装(集群模式)

环境:jdk 1.8 + hadoop2.7.6+zookeeper3.4.9+centos7

一.安装zookeeper(集群模式)

0.安装机器

ip hostname

192.168.100.9 ns1

192.168.100.10 dn1

2.zookeeper tar包一栋至 ns1的 /usr/local,解压

tar -zxvf zookeeper-3.4..tar.gz

3.修改zk配置文件

cd /usr/local/zookeeper-3.4./conf cp zoo_sample.cfg zoo.cfg

修改配置文件zoo.cfg(所有节点的配置文件相同)

#tickTime这个时间是作为zookeeper服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是说每个tickTime时间就会发送一个心跳

tickTime=

#initLimit这个配置项是用来配置zookeeper接受客户端(这里所说的客户端不是用户连接zookeeper服务器的客户端,而是zookeeper服务器集群中连接到leader的follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数

initLimit=

#syncLimit这个配置项标识leader与follower之间发送消息,请求和应答时间长度,最长不能超过多少个tickTime的时间长度,总的时间长度就是5*=10秒

syncLimit=

#dataDir顾名思义就是zookeeper保存日志的目录

dataLogDir=/usr/local/zookeeper-3.4./logs

#dataDir顾名思义就是zookeeper保存数据的目录

dataDir=/usr/local/zookeeper-3.4./data

#clientPort这个端口就是客户端连接Zookeeper服务器的端口,Zookeeper会监听这个端口接受客户端的访问请求;

clientPort=

#这个参数指定了需要保留的文件数目

autopurge.snapRetainCount=

#3.4.0及之后版本,ZK提供了自动清理事务日志和快照文件的功能,这个参数指定了清理频率,单位是小时,需要配置一个1或更大的整数,默认是0,表示不开启自动清理功能。(No Java system property) New in 3.4.

autopurge.purgeInterval=

#server.A=B:C:D中的A是一个数字,表示这个是第几号服务器,B是这个服务器的IP地址,C第一个端口用来集群成员的信息交换,表示这个服务器与集群中的leader服务器交换信息的端口,D是在leader挂掉时专门用来进行选举leader所用的端口。

server.= 192.168.100.9::

server.= 192.168.100.10::

新建配置中的log data目录

4.配置myid

除了修改zoo.cfg配置文件外,zookeeper集群模式下还要配置一个myid文件,这个文件需要放在dataDir目录下。

这个文件里面有一个数据就是A的值(该A就是zoo.cfg文件中server.A=B:C:D中的A),在zoo.cfg文件中配置的dataDir路径中创建myid文件。

#在192.168.1.148服务器上面创建myid文件,并设置值为1,同时与zoo.cfg文件里面的server.1保持一致,如下

echo "" > /usr/local/zookeeper-3.4./data/myid

在 dn1 上执行如下命令

echo "" > /usr/local/zookeeper-3.4./data/myid

5.添加环境变量

在两个节点的 /etc/profile中添加如下语句

export ZOOKEEPER_HOME=/usr/local/zookeeper-3.4.

export PATH=${ZOOKEEPER_HOME}/bin:${PATH}

刷新环境变量

source /etc/profile

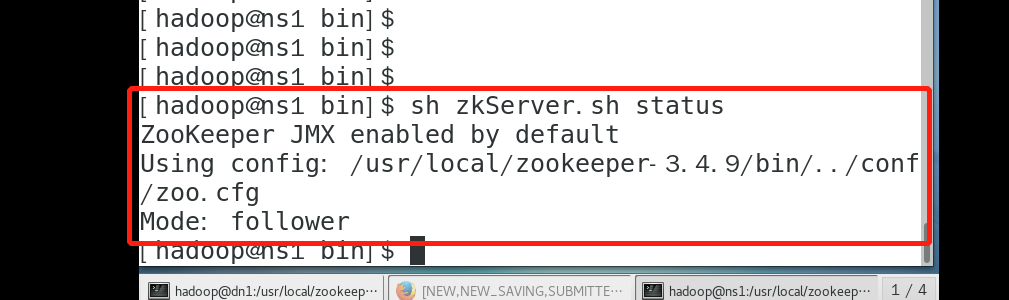

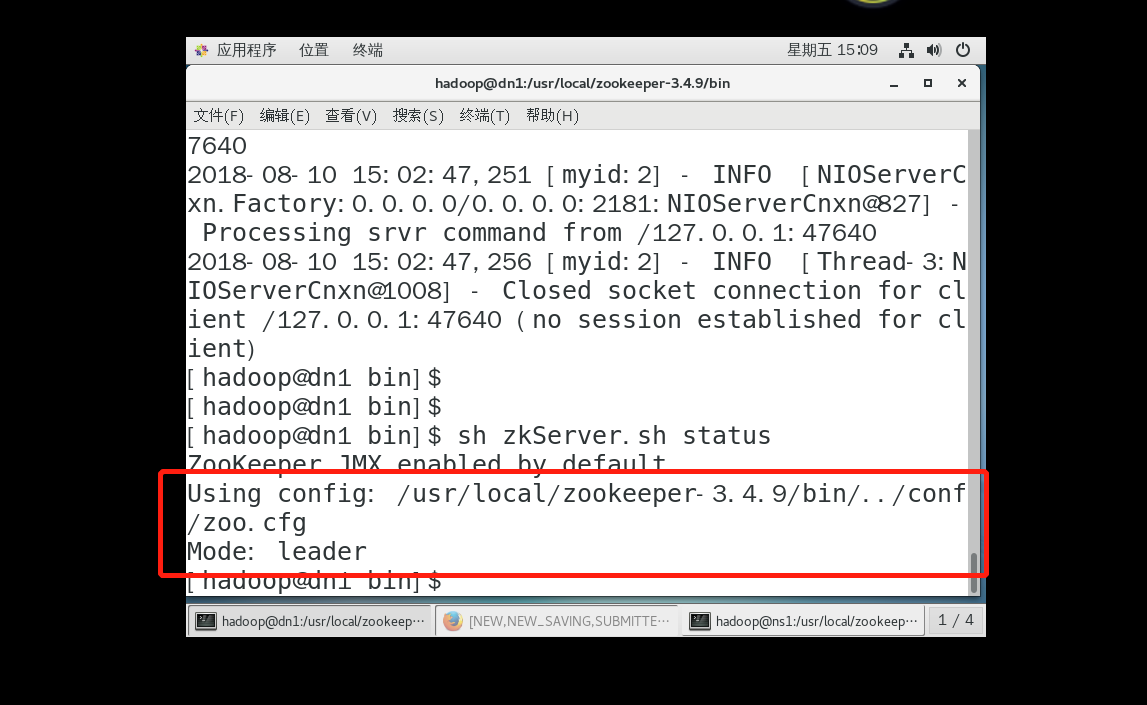

6.每个节点都启动zk 进行测试

sh /usr/local/zookeeper-3.4./bin/zkServer.sh start

查看状态:

sh /usr/local/zookeeper-3.4./bin/zkServer.sh status

二 hbase 安装

1.下载hbase

2.解压到/user/local

tar -zxvf hbase-2.1.-bin.tar.gz

3.配置

cd /usr/local/hbase-2.1.0/conf

hbase-site.xml 修改如下

<configuration>

<!--此处的bx为以前搭建hdfs集群时,使用的那个集群代号-->

<property>

<name>hbase.rootdir</name>

<value>hdfs://ns1:9000/hbase</value>

</property>

<!--指定集群的几台zookeeper主机名-->

<property>

<name>hbase.zookeeper.quorum</name>

<value>ns1,dn1</value>

</property>

<!--设置使用zookeeper集群,true为使用-->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property> <property>

<name>hbase.tmp.dir</name>

<value>/usr/local/hbase-2.1./tmp</value>

</property>

<!--ui端口,可通过ns1:60010访问web-->

<property>

<name>hbase.master.info.port</name>

<value>60010</value>

</property>

</configuration>

hbase-env.sh 修改如下

#设置补充hbase 自带的zk

export HBASE_MANAGES_ZK=false

export JAVA_HOME=/usr/local/jdk

regionservers 添加节点

ns1

dn1

赋值hadoop core-site.xml ,hdfs-site.xml 到 /usr/local/hbase-2.1.0/conf

4.启动

ns1 上执行

sh /usr/local/hbase-2.1./bin/start-hbase.sh

5,查看状态

ns1 查看

[hadoop@ns1 bin]$ jps

HRegionServer

SecondaryNameNode

JobHistoryServer

HistoryServer

DataNode

Worker

Jps

38408 HMaster #hbase master

QuorumPeerMain

NameNode

Master

NodeManager

dn1 查看

[hadoop@dn1 local]$ jps

26754 HRegionServer #regionserver 已启动

Worker

Jps

QuorumPeerMain

DataNode

NodeManager

hbase 安装(集群模式)的更多相关文章

- Eclipse的下载、安装和WordCount的初步使用(本地模式和集群模式)

包括: Eclipse的下载 Eclipse的安装 Eclipse的使用 本地模式或集群模式 Scala IDE for Eclipse的下载.安装和WordCount的初步使用(本地模式和集群 ...

- IntelliJ IDEA的下载、安装和WordCount的初步使用(本地模式和集群模式)

包括: IntelliJ IDEA的下载 IntelliJ IDEA的安装 IntelliJ IDEA中的scala插件安装 用SBT方式来创建工程 或 选择Scala方式来创建工程 本地模式或集群 ...

- IntelliJ IDEA(Community版本)的下载、安装和WordCount的初步使用(本地模式和集群模式)

不多说,直接上干货! 对于初学者来说,建议你先玩玩这个免费的社区版,但是,一段时间,还是去玩专业版吧,这个很简单哈,学聪明点,去搞到途径激活!可以看我的博客. 包括: IntelliJ IDEA(Co ...

- Greenplum源码编译安装(单机及集群模式)完全攻略

公司有个项目需要安装greenplum数据库,让我这个gp小白很是受伤,在网上各种搜,结果找到的都是TMD坑货帖子,但是经过4日苦战,总算是把greenplum的安装弄了个明白,单机及集群模式都部署成 ...

- Scala IDE for Eclipse的下载、安装和WordCount的初步使用(本地模式和集群模式)

包括: Scala IDE for Eclipse的下载 Scala IDE for Eclipse的安装 本地模式或集群模式 我们知道,对于开发而言,IDE是有很多个选择的版本.如我们大部分人经常 ...

- Hadoop学习笔记(4)hadoop集群模式安装

具体的过程参见伪分布模式的安装,集群模式的安装和伪分布模式的安装基本一样,只有细微的差别,写在下面: 修改masers和slavers文件: 在hadoop/conf文件夹中的配置文件中有两个文件ma ...

- 1.8分布式集群模式基础(VM安装多台服务器)

前言 一晃就是10几天,学习的过程是断断续续的,对个人来说,这并不是一个良好的状态.在这10几天了,迷恋起了PS... 从今天起,坚持一周4篇,额.希望吧 在之前的随笔中,我安装了Xshell 和 C ...

- Hbase的集群安装

hadoop集群的搭建 搭建真正的zookeeper集群 Hbase需要安装在成功部署的Hadoop平台,并且要求Hadoop已经正常启动. 同时,HBase需要集群部署,我们分别把HBase 部署到 ...

- IntelliJ IDEA(Ultimate版本)的下载、安装和WordCount的初步使用(本地模式和集群模式)

不多说,直接上干货! IntelliJ IDEA号称当前Java开发效率最高的IDE工具.IntelliJ IDEA有两个版本:社区版(Community)和旗舰版(Ultimate).社区版时免费的 ...

随机推荐

- File upload - MIME type

Your goal is to hack this photo galery by uploading PHP code.Retrieve the validation password in the ...

- MongoDB Shell db.runCommand

db.runCommand()示例 我们使用MongoDB Shell登录到mongos,添加Shard节点 [root@100 shard]# /usr/local/mongoDB/bin/mong ...

- 验证码破解 | Selenium模拟登陆12306

12306官网登录的验证码破解比较简单,验证码是常规的点触类型验证码,使用超级鹰识别率比较高. 思路: (1)webdriver打开浏览器: (2)先对整个屏幕截屏,通过标签定位找到验证码图片,并定位 ...

- shell习题训练

shell习题训练 求2个数之和 计算1-100的和 将一目录下所有的文件的扩展名改为bak 编译当前目录下的所有.c文件: 打印root可以使用可执行文件数,处理结果: root's bins: 2 ...

- 洛谷 P5269 欧稳欧再次学车 题解

P5269 欧稳欧再次学车 题目背景 请自行脑补一张欧稳欧学车的图 题目描述 欧稳欧学车时经常用一辆橡树车练习.这辆橡树车共有 \(N\) 个挡位,欧稳欧每秒可以把挡位增加或减少 \(1\),初始时( ...

- DNN的BP算法Python简单实现

BP算法是神经网络的基础,也是最重要的部分.由于误差反向传播的过程中,可能会出现梯度消失或者爆炸,所以需要调整损失函数.在LSTM中,通过sigmoid来实现三个门来解决记忆问题,用tensorflo ...

- cgdsR 下载TCGA数据

TCGA 的数据可以在5个组织机构获取,它们都提供了类似的接口来供用户下载数据. cgdsR 包是cBioPortal 提供的R包 http://www.cbioportal.org/rmatlab ...

- c# 画正态分布图

/// <summary> /// 提供正态分布的数据和图片 /// </summary> public class StandardDistribution { /// &l ...

- select readonly 不能看到其他选项解决方案

在html中是select readonly后,依然可以下拉选择,不想做disabled增加隐藏域,下面提供两种解决方案 解决方案1: [javascript] view plain copy ...

- Features Track[STL map]

目录 题目地址 题干 代码和解释 参考 题目地址 Features Track(ACM-ICPC 2018 徐州赛区网络预赛 ) 题干 代码和解释 题意:一个动画有许多 n 帧,每帧有 k 个点,点的 ...