Learning Invariant Deep Representation for NIR-VIS Face Recognition

查找异质图像匹配的过程中,发现几篇某组的论文,都是关于NIR-VIS的识别问题,提到了许多处理异质图像的处理方法,网络结构和idea都很不错,记录其中一篇。

其余两篇:

Wasserstein CNN: Learning Invariant Features for NIR-VIS Face Recognition

A Light CNN for Deep Face Representation with Noisy Labels

摘要

VIS-NIR(可见光与近红外)面部识别仍然是异质图像识别中的挑战。本文只用一个网络来映射NIR和VIS图像至一个紧凑的欧式空间。网络的低级层仅仅在大规模VIS数据中训练。每个卷积层由简单的maxout operator实现。网络的高级层被划分为两个正交的子空间,分别包括模态不变身份信息(modality-invariant identity information)和模态变化光谱信息(modality-variant spectrum information)。我们的联合公式在训练时引导交替最小化方法得到深度表示,测试时高效计算异质数据。实验证明了在CASIA NIR-VIS 2.0面部识别数据中实现94 percent的正确率,仅仅有64D大小的表示,比之前低了58 percent的错误率。

1. 介绍

NIR图像提供了廉价且简单的方式来提高在低光照情况下的面部识别能力。对于光照变换没有VIS那么敏感,所以被广泛应用于安检等。在真实应用中,NIR往往需要和VIS一起使用,导致了两者之间的匹配问题。这个问题可称为:NIR-VIS 异质面部识别问题。

NIR与VIS属于不同光谱,自然有很大的外表差异。所以深度网络在VIS数据训练后不含有NIR光谱信息,所以无法很好的解决NIR问题。怎样利用大规模VIS面部数据来探索NIR和VIS面部模态不变表示值得思考。得益于网络数据,我们可以容易获得大量VIS面部数据,然而成对的NIR数据难以获得。怎样在小规模NIR-VIS数据中学习也是一个中心问题。

之前的NIR-VIS匹配方法经常利用trick来减轻外观差异,通过移除一些可能含有光谱信息的主子空间。Chen在2012提出面部外观由身份信息(identity information)和变化信息(variation information eg.,lighting,poses,expressions)组成。受启发于此,本文提出一个网络来学习Invariant Deep Representation (IDR)同时包含NIR和VIS人脸信息,利用一个单一网络来将NIR和VIS图像同时映射到一个压缩后的欧式空间,使得NIR和VIS图像在嵌入空间embedding space中可以直接对应到面部相似性。

我们的网络首先在大规模VIS数据中训练,卷积层和全连接由简化形式的maxout operator实现。 这个网络使得我们学习的到的表示对于类内个体变化很鲁棒。然后,网络底层固定,微调NIR数据。高层划分为两个正交子空间:模态不变身份信息(modality-invariant identity information)和模态变化光谱信息(modality-variant spectrum information)。这个正交限制和maxout operator在高层可以缩减参数空间,因此避免了在小的NIR-VIS数据集上的过拟合。本文提出的IDR达到了SOTA,贡献如下:

- 一个高效深度网络结构学习模态不变表示,交替最小化高效优化。这个结构可以自然结合之前的不变特征提取和子空间学习到一个统一网络。

- 两个正交子空间嵌入网络中来建模身份和光谱信息。使得可以提取压缩后的表示,减小了小数据中的过拟合问题。

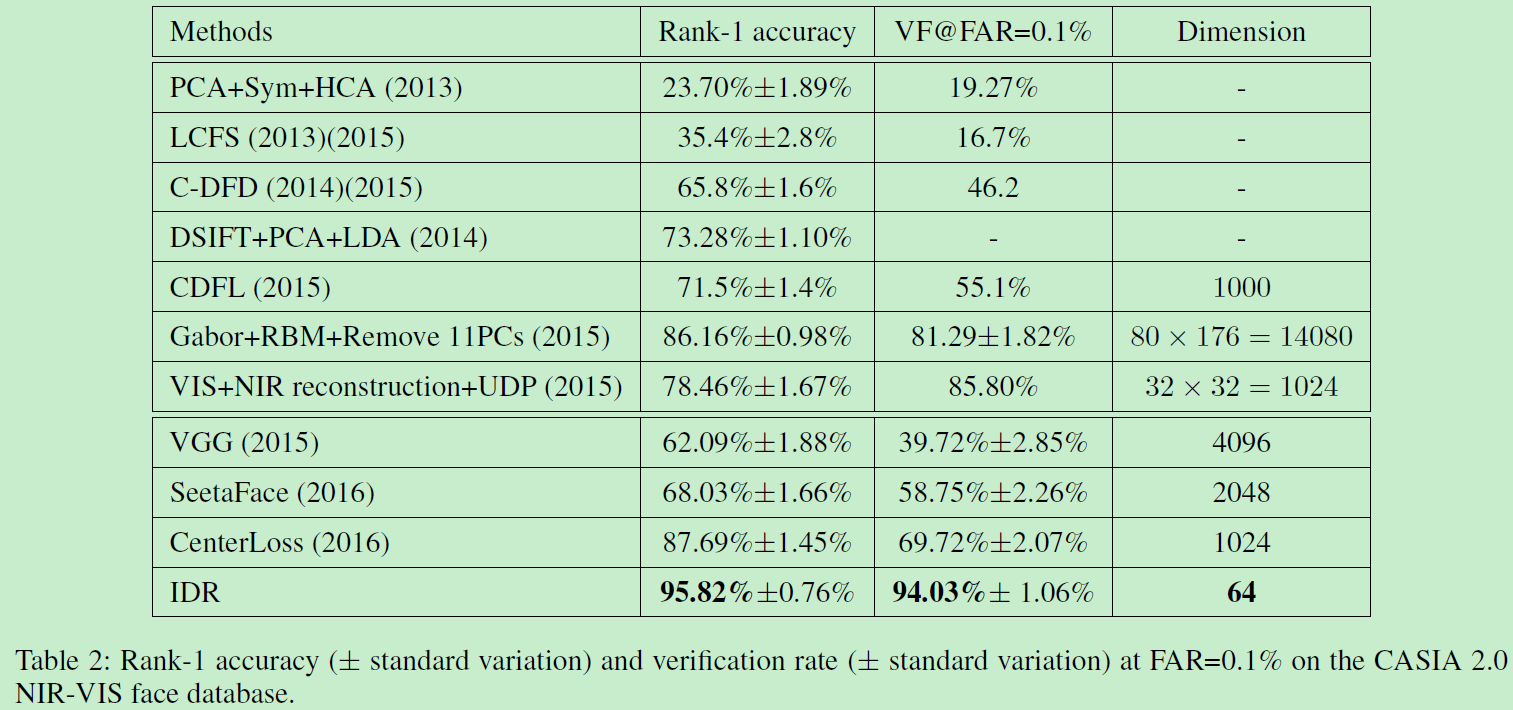

- 在数据集CASIA NIR-VIS 2.0面部数据上以64维的表示达到SOTA。

2. 相关工作

许多工作提出来减轻异质图像的外观差异。大多数方法可以分为三类:image synthesis, subspace learning、invariant feature extraction。

1)Image synthesis

主要从一个模态合成面部图像到另一个模态使得异质图像可在同一距离空间比较。

2)subspace learning

学习映射异质数据到一个共同的空间。当前sota方法是通过移除一些主子空间成分来解决。

3)Invariant feature extraction

即寻找模态不变特征使得对光照鲁棒。传统方法较多。

尽管很多方法,NIR-VIS识别表现仍然很low。远不如VIS数据结果好。很少有dl方法处理NIR-VIS,所以本文用DL方法来解决。

3. Invariant Deep Representation

本节介绍子空间分解和不变性特征提取,来学习模态不变深度表示。

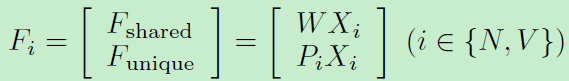

注意到移除光谱信息有助于提高NIR-VIS识别表现。我们进一步三个映射矩阵(W,P,见上图)来建模身份不变信息和不变光谱信息。所以特征表示可以表示如下:

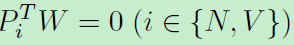

WX和PX分别代表共享特征和独立特征。考虑到子空间分解特性关于矩阵W和P:我们进一步提出一个正交限制使他们互相无关:

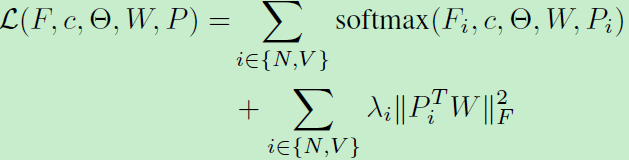

利用softmax函数来训练整个网络:

优化方法:

上式包含一些非凸变量,我们利用一种交替优化方法来最小化目标函数。首先根据朗格朗日乘子,重写上述函数:

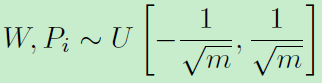

待优化参数有网络参数、W、P。利用交替优化更新,网络参数初始化利用Xavier,W和P初始化:

网络结构:lightened CNN B network(同作者另一作品:A Light CNN for Deep Face Representation with Noisy Labels)网络包括9个卷积层+4个最大池化层+全连接。Dropout设为0.7。初始学习率0.001,降到0.00001。基于该网络实现本文,特征层用来映射低级特征到两个正交子空间。

4. 其他要点

算法分析:分析本文提出的不变性深度表征: invariant deep representation (IDR)

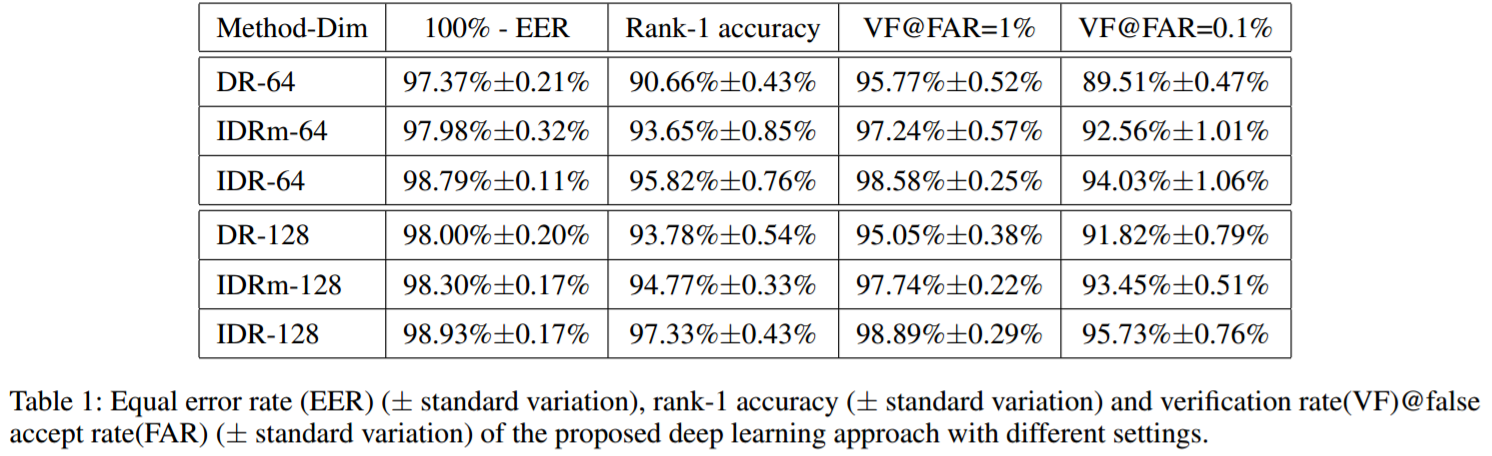

我们实现了两种版本的IDR:DR表示IDR没有NIR特征和VIS特征。即仅仅训练卷积网络,没有子空间分解。这会导致大量参数在全连接和特征层,导致在小数据NIR-VIS上过拟合。特征层的maxout operator也有助于减少过拟合。因此,IDRm表示IDR没有maxout operator在特征层。

上图表明IDR是最好的结果。对比IDR和IDRm,注意到maxout operator在最后一个卷积层可进一步降低equal error rate,并提高表现。

最后再附两张碾压性能图:

Learning Invariant Deep Representation for NIR-VIS Face Recognition的更多相关文章

- 论文笔记之:UNSUPERVISED REPRESENTATION LEARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS

UNSUPERVISED REPRESENTATION LEARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS ICLR 2 ...

- Wasserstein CNN: Learning Invariant Features for NIR-VIS Face Recognition

承接上上篇博客,在其基础上,加入了Wasserstein distance和correlation prior .其他相关工作.网络细节(maxout operator).训练方式和数据处理等基本和前 ...

- (转)Understanding, generalisation, and transfer learning in deep neural networks

Understanding, generalisation, and transfer learning in deep neural networks FEBRUARY 27, 2017 Thi ...

- A Gentle Introduction to Transfer Learning for Deep Learning | 迁移学习

by Jason Brownlee on December 20, 2017 in Better Deep Learning Transfer learning is a machine learni ...

- [译]深度神经网络的多任务学习概览(An Overview of Multi-task Learning in Deep Neural Networks)

译自:http://sebastianruder.com/multi-task/ 1. 前言 在机器学习中,我们通常关心优化某一特定指标,不管这个指标是一个标准值,还是企业KPI.为了达到这个目标,我 ...

- paper 124:【转载】无监督特征学习——Unsupervised feature learning and deep learning

来源:http://blog.csdn.net/abcjennifer/article/details/7804962 无监督学习近年来很热,先后应用于computer vision, audio c ...

- 论文笔记之:Learning Cross-Modal Deep Representations for Robust Pedestrian Detection

Learning Cross-Modal Deep Representations for Robust Pedestrian Detection 2017-04-11 19:40:22 Moti ...

- 转:无监督特征学习——Unsupervised feature learning and deep learning

http://blog.csdn.net/abcjennifer/article/details/7804962 无监督学习近年来很热,先后应用于computer vision, audio clas ...

- Incentivizing exploration in reinforcement learning with deep predictive models

Stadie, Bradly C., Sergey Levine, and Pieter Abbeel. "Incentivizing exploration in reinforcemen ...

随机推荐

- str

print('字符串操作') s='abc DEF hij' print('首字母大写') print(s.capitalize()) print('全大写') print(s.upper()) pr ...

- 【.net】在ASP.NET中,IE与Firefox下载文件名中带中文汉字的文件,文件名乱码的问题

#问题:客户端为ie或Firefox,服务端为asp.net时,下载文件名中包含中文汉字时,下载下来的文件的文件名是乱码: #解决方案: 示例代码:下载名称中带汉字的文件: public void P ...

- Selenium模块的使用

Selenium是一个Web的自动化测试工具,最初是为网站自动化测试而开发的,类型像我们玩游戏用的按键精灵,可以按指定的命令自动操作,不同是Selenium 可以直接运行在浏览器上,它支持所有主流的浏 ...

- HDU 1034(传递糖果 模拟)

题意是一群孩子围成一个圈,每个人把手中的糖果分一半给右边的人,若分过之后手中的糖果数是奇数,则由老师提供一颗糖果给他,问这样传递多少圈所有人的糖果数都能相等,最终每人手里的糖果数是多少. 由于题中已经 ...

- HDU 1035(走迷宫 模拟)

题意是给定初始位置在一个迷宫中按照要求前进,判断多少步能离开迷宫或者多少步会走入一个长达多少步的循环. 按要求模拟前进的位置,对每一步在 vis[ ] 数组中进行已走步数的记录,走出去或走到已走过的位 ...

- Golang入门教程(十四)结构体和类详解

golang中并没有明确的面向对象的说法,实在要扯上的话,可以将struct比作其它语言中的class. 类声明 type Book struct { Title string Author stri ...

- ifconfig: command not found(CentOS 7,其他的可以参考)

ifconfig: command not found 查看path配置(echo相当于c中的printf,C#中的Console.WriteLine) 1 echo $PATH 解决方案1:先看看是 ...

- vue-router中query与params区别

query和params两者都是在Vue路由中传参. 用法: query用path来引入,params只能用name来传递,不能使用path 展示效果:query更像ajax中get请求(会在地址栏显 ...

- [Android] Android RxBus 用法学习总结

事件总线的好处在于方便组件之间的交互,RxBus不是一个库,而是使用RxJava实现事件总线的一种思想. rxbus和eventbus相比较: RxJava 主要做异步.网络的数据处理,强大之处就是对 ...

- vim学习之改头换面(基础配置)

还记得在线有个维护博客园的学长说过,这网站的前端做的贼丑,今日一看果真如此.其实我想说毕竟干货多,没有那么多花花肠子.下面开始进入正题. 在入坑了sublime.vscode.atom.notepad ...