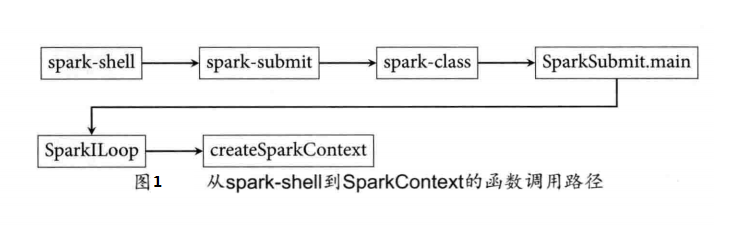

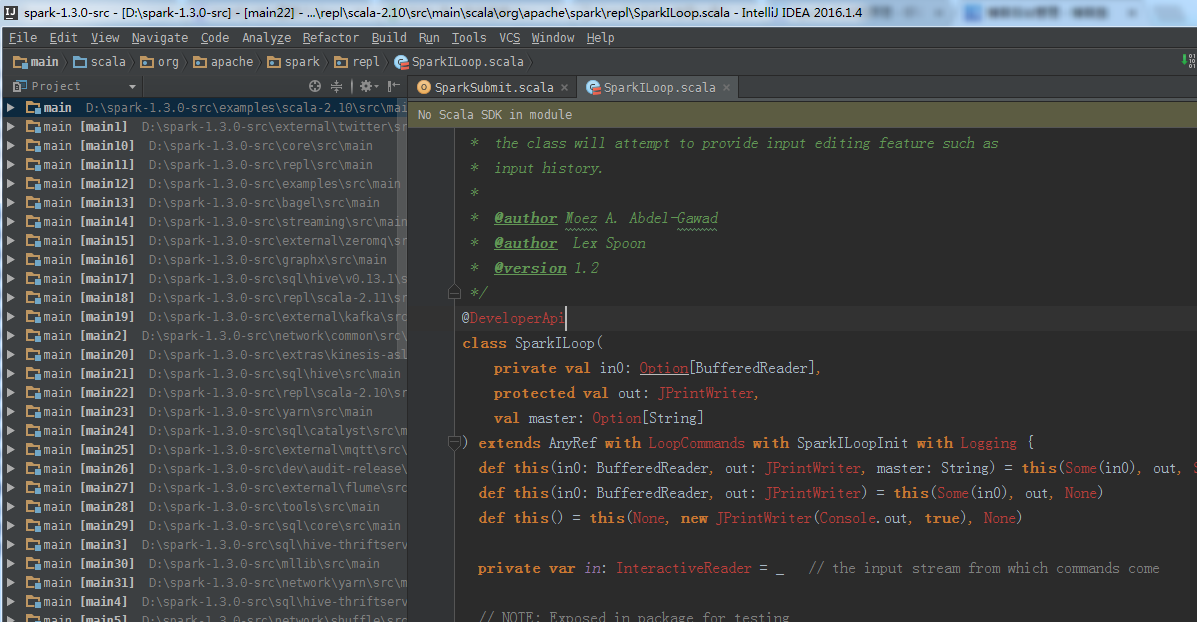

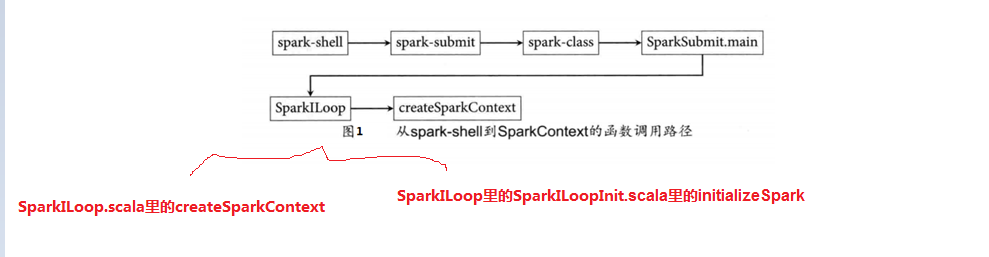

从Spark-Shell到SparkContext的函数调用路径过程分析(源码)

不急,循序渐进,先打好基础

Spark shell的原理

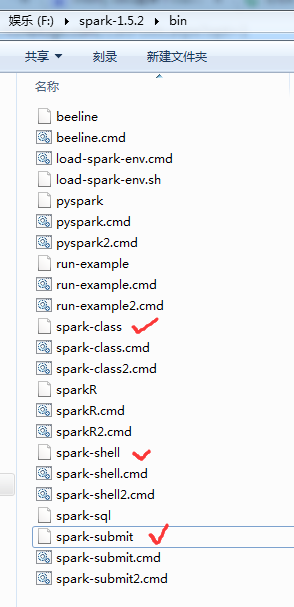

首先,我们清晰定位找到这几个。

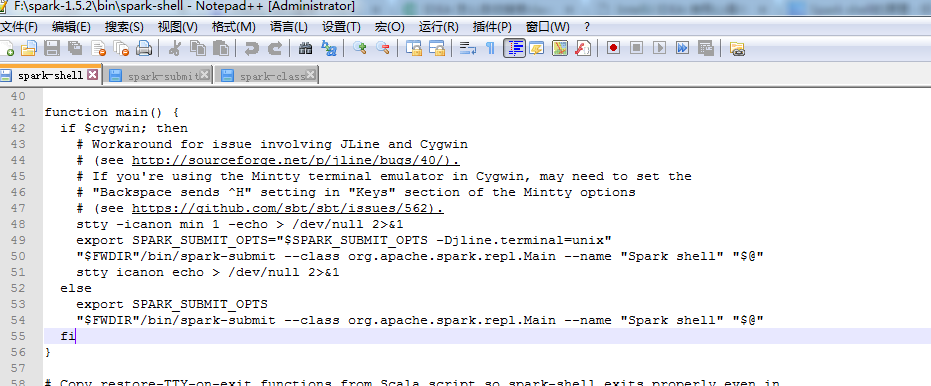

1、spark-shell

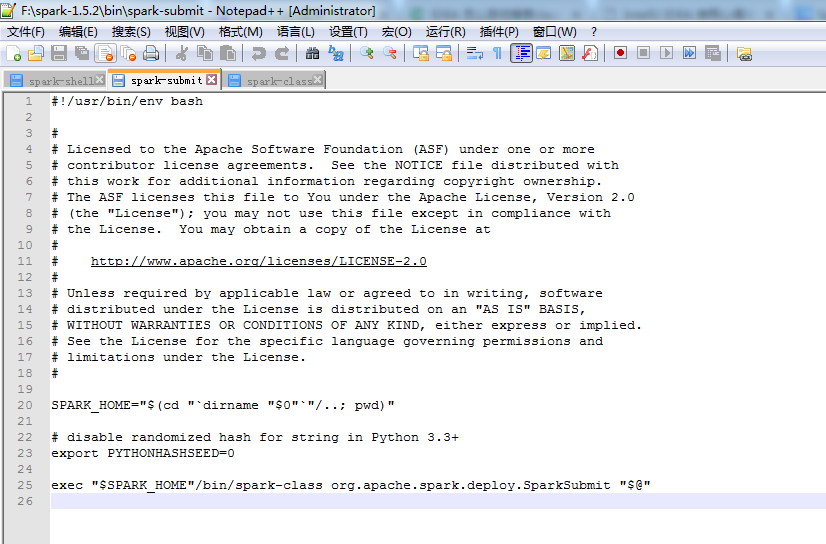

2、 spark-submit

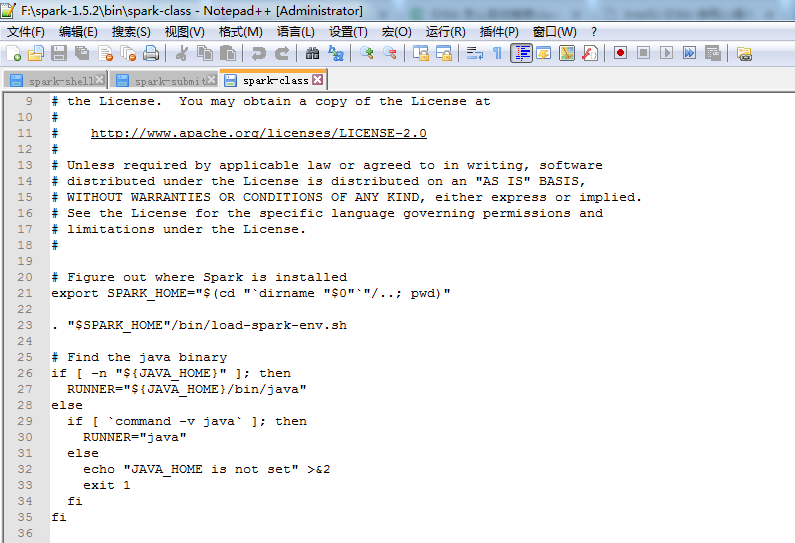

3、spark-class

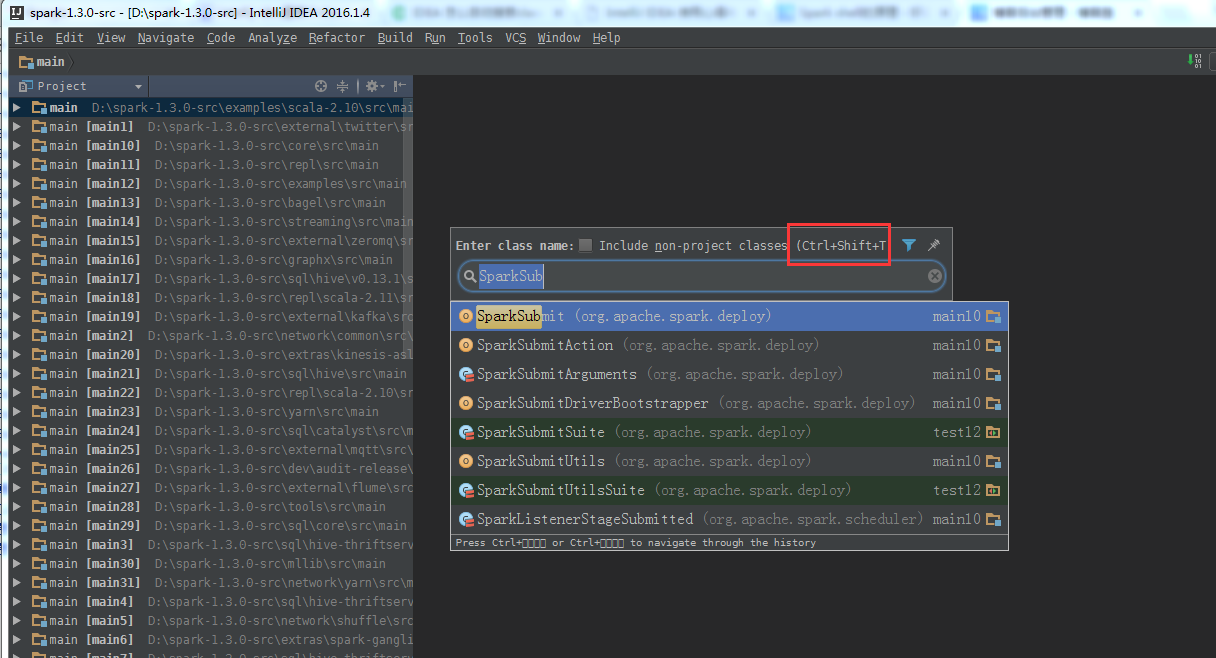

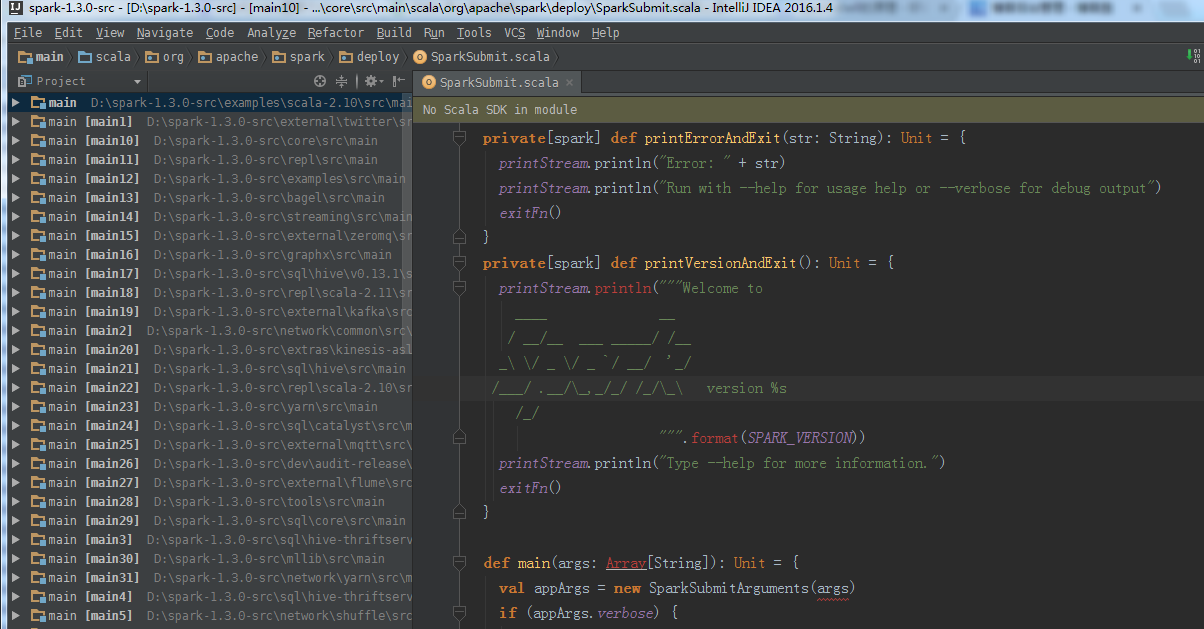

4、SparkSubmit.scala

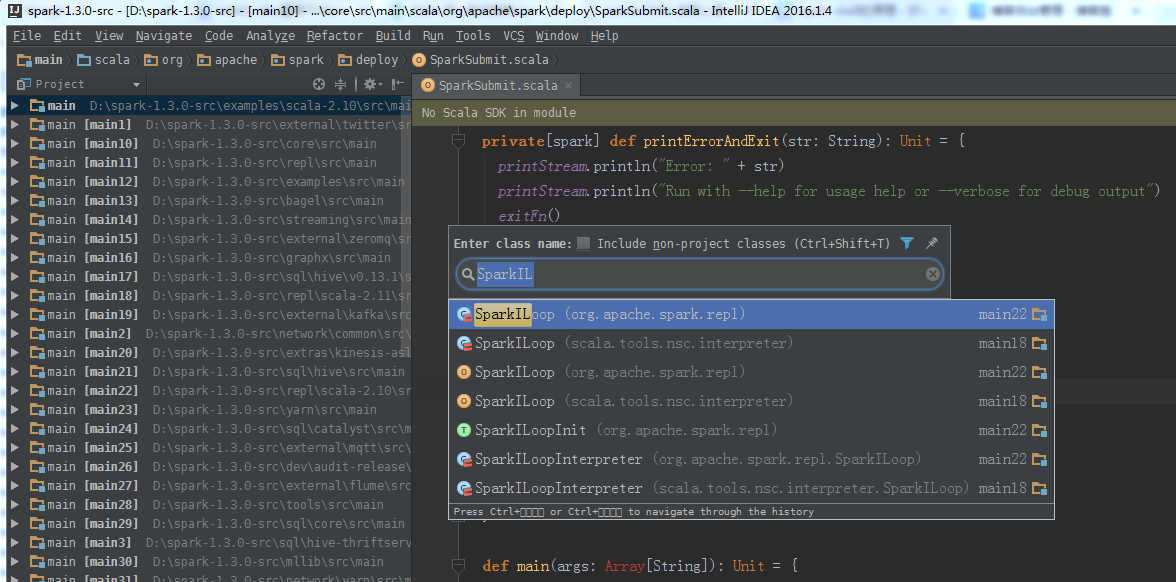

5、SparkILoop.scala

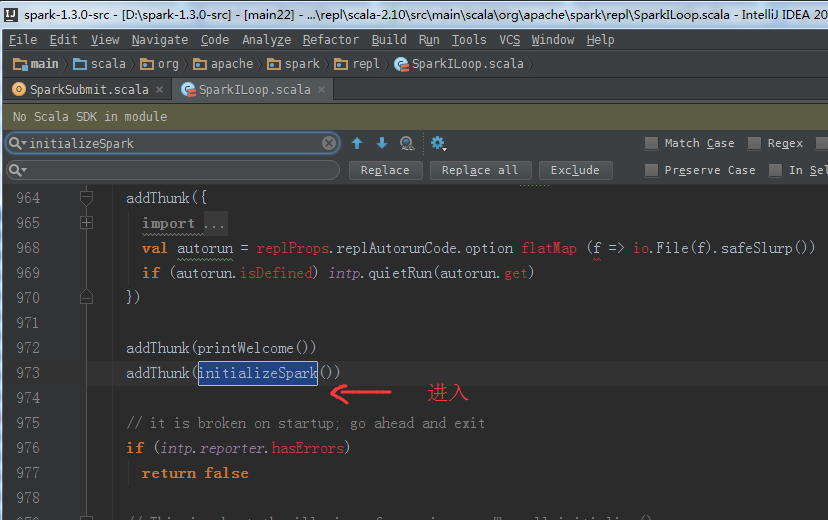

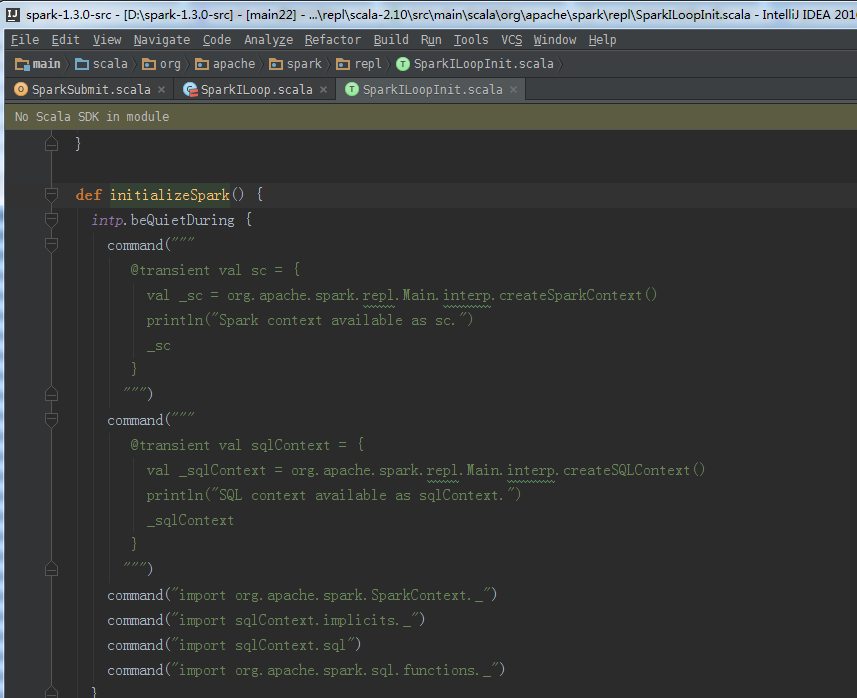

initializeSpark的源码

def initializeSpark() {

intp.beQuietDuring {

command("""

@transient val sc = {

val _sc = org.apache.spark.repl.Main.interp.createSparkContext()

println("Spark context available as sc.")

_sc

}

""")

command("""

@transient val sqlContext = {

val _sqlContext = org.apache.spark.repl.Main.interp.createSQLContext()

println("SQL context available as sqlContext.")

_sqlContext

}

""")

command("import org.apache.spark.SparkContext._")

command("import sqlContext.implicits._")

command("import sqlContext.sql")

command("import org.apache.spark.sql.functions._")

}

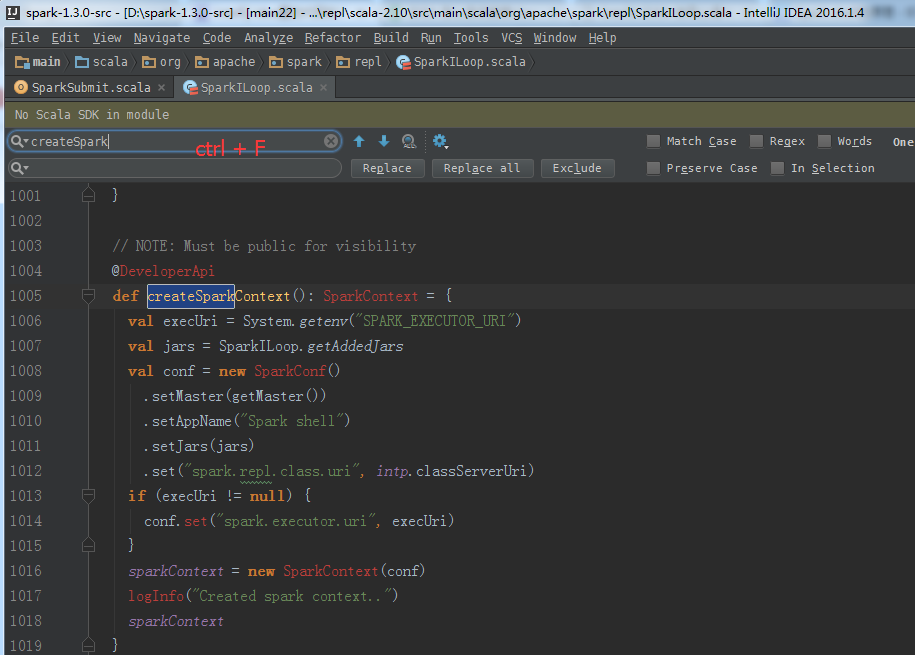

createSparkContext的源码

// NOTE: Must be public for visibility

@DeveloperApi

def createSparkContext(): SparkContext = {

val execUri = System.getenv("SPARK_EXECUTOR_URI")

val jars = SparkILoop.getAddedJars

val conf = new SparkConf()

.setMaster(getMaster())

.setAppName("Spark shell")

.setJars(jars)

.set("spark.repl.class.uri", intp.classServerUri)

if (execUri != null) {

conf.set("spark.executor.uri", execUri)

}

sparkContext = new SparkContext(conf)

logInfo("Created spark context..")

sparkContext

}

总结

从Spark-Shell到SparkContext的函数调用路径过程分析(源码)的更多相关文章

- Spark技术内幕:Stage划分及提交源码分析

http://blog.csdn.net/anzhsoft/article/details/39859463 当触发一个RDD的action后,以count为例,调用关系如下: org.apache. ...

- Spark技术内幕: Task向Executor提交的源码解析

在上文<Spark技术内幕:Stage划分及提交源码分析>中,我们分析了Stage的生成和提交.但是Stage的提交,只是DAGScheduler完成了对DAG的划分,生成了一个计算拓扑, ...

- Spark Streaming揭秘 Day25 StreamingContext和JobScheduler启动源码详解

Spark Streaming揭秘 Day25 StreamingContext和JobScheduler启动源码详解 今天主要理一下StreamingContext的启动过程,其中最为重要的就是Jo ...

- Spark BlockManager的通信及内存占用分析(源码阅读九)

之前阅读也有总结过Block的RPC服务是通过NettyBlockRpcServer提供打开,即下载Block文件的功能.然后在启动jbo的时候由Driver上的BlockManagerMaster对 ...

- Spark MLlib 之 StringIndexer、IndexToString使用说明以及源码剖析

最近在用Spark MLlib进行特征处理时,对于StringIndexer和IndexToString遇到了点问题,查阅官方文档也没有解决疑惑.无奈之下翻看源码才明白其中一二...这就给大家娓娓道来 ...

- Spark大师之路:广播变量(Broadcast)源码分析

概述 最近工作上忙死了……广播变量这一块其实早就看过了,一直没有贴出来. 本文基于Spark 1.0源码分析,主要探讨广播变量的初始化.创建.读取以及清除. 类关系 BroadcastManager类 ...

- Twitter Storm中Bolt消息传递路径之源码解读

本文初次发表于storm-cn的google groups中,现以blog的方式再次发表,表明本人徽沪一郎确实读过这些代码,:). Bolt作为task被executor执行,而executor是一个 ...

- 65、Spark Streaming:数据接收原理剖析与源码分析

一.数据接收原理 二.源码分析 入口包org.apache.spark.streaming.receiver下ReceiverSupervisorImpl类的onStart()方法 ### overr ...

- Spark系列(一)Spark1.0.0源码编译及安装

最近想对自己学的东西做些回顾,想到写博客是个不错的方式,方便他人也有利自己,刚开始写不足之处大家多担待. 编译前需要安装JDK1.6以上.scala.Maven.Ant.hadoop2.20 如下图( ...

随机推荐

- [C#]Base使用小记

base 关键字用于从派生类中访问基类的成员: • 调用基类上已被其他方法重写的方法. • 指定创建派生类实例时应调用的基类构造函数. 基类访问只能在构造函数.实例方法或实例属性访问器中进行. 从静态 ...

- DISC免费性格测试题

现在给大家推荐一款世界500强和猎头公司招聘人才时用的DISC性格测评,用在找对象方面也比较合适.大家不妨看下自己的性格,就知道该找什么样的意中人啦--- 在每一个大标题中的四个选择题中只选择一个最符 ...

- Android Context创建过程

特定的资源或者类构成了Android应用程序的运行上下文环境 PackageManager, ClassLoader, Assert等等 Android应用程序窗口的运行上下文环境是通过Con ...

- What is Windows Clustering

A cluster is a group of independent computer systems, referred to as nodes, working together as a un ...

- Python Tips and Traps(一)

1.如果想得到一个列表的index和内容,可以通过enumerate快速实现 drinks = ['coffee','tea', 'milk', 'water'] for index, drink i ...

- sql性能优化总结(转)

网上看到一篇sql优化的文章,整理了一下,发现很不错,虽然知道其中的部分,但是没有这么全面的总结分析过…… 一. 目的 数据库参数进行优化所获得的性能提升全部加起来只占数据库应用系统性能提升的40 ...

- c#中struct和class的区别 z

1.struct 是值类型,class是对象类型 2.struct 不能被继承,class可以被继承 3.struct 默认的访问权限是public,而class默认的访问权限是private. 4. ...

- 23个.NET开源项目

Castle是.NET里走过了三年的开源框架,下载地址如:http://www.castleproject.org/index.html ,当然如果你是从事过JAVA开发并用过spring,hiber ...

- leetcode第八题 String to Integer (atoi) (java)

String to Integer (atoi) time=272ms accepted 需考虑各种可能出现的情况 public class Solution { public int atoi( ...

- 如何解决jquery版本冲突

<!-- 引入1.6.4版的jq --> <script src="<a href="http://ajax.googleapis.com/ajax/lib ...