Hadoop2的FN安装(federated namespace)

尝试了简单的安装hadoop2后,我们再来尝试一下hdfs的一项新功能:FN。这项技术可以解决namenode容量不足的问题。它采用多个namenode来共享datanode的方式,每个namenode属于不同的namespace。

下面是我们的安装信息

Hadoop 版本:2.2.0

OS 版本: Centos6.4

Jdk 版本: jdk1.6.0_32

机器配置

|

机器名 |

Ip地址 |

功能 |

|

Hadoop1 |

192.168.124.135 |

NameNode, DataNode, ResourceManager, NodeManager |

|

Hadoop2 |

192.168.124.136 |

NameNode DataNode, NodeManager |

|

Hadoop3 |

192.168.124.137 |

DataNode, NodeManager |

配置

vi etc/hadoop/hadoop-env.sh 修改jdk位置

export JAVA_HOME=/home/hadoop/jdk1.6.0_32

vi etc/hadoop/mapred-env.sh修改jdk位置

export JAVA_HOME=/home/hadoop/jdk1.6.0_32

vi etc/hadoop/yarn-env.sh修改jdk位置

export JAVA_HOME=/home/hadoop/jdk1.6.0_32

vi etc/hadoop/core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/repo2/tmp</value>

<description>A base for other temporary

directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop1:9000</value>

</property>

</configuration>

vi etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/hadoop/repo2/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/hadoop/repo2/data</value>

</property>

<property>

<name>dfs.nameservices</name>

<value>ns1,ns2</value>

</property>

<property>

<name>dfs.namenode.rpc-address.ns1</name>

<value>hadoop1:9000</value>

</property>

<property>

<name>dfs.namenode.http-address.ns1</name>

<value>hadoop1:50070</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address.ns1</name>

<value>hadoop1:50090</value>

</property>

<property>

<name>dfs.namenode.rpc-address.ns2</name>

<value>hadoop2:9000</value>

</property>

<property>

<name>dfs.namenode.http-address.ns2</name>

<value>hadoop2:50070</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address.ns2</name>

<value>hadoop2:50090</value>

</property>

</configuration>

vi etc/hadoop/yarn-site.xml

<configuration>

<property>

<description>the valid service name</description>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<description>The hostname of the RM.</description>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop1</value>

</property>

</configuration>

vi etc/hadoop/mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

vi etc/hadoop/slaves

hadoop1

hadoop2

hadoop3

格式化namenode

在hadoop1和hadoop2上运行:bin/hdfs namenode -format -clusterid mycluster

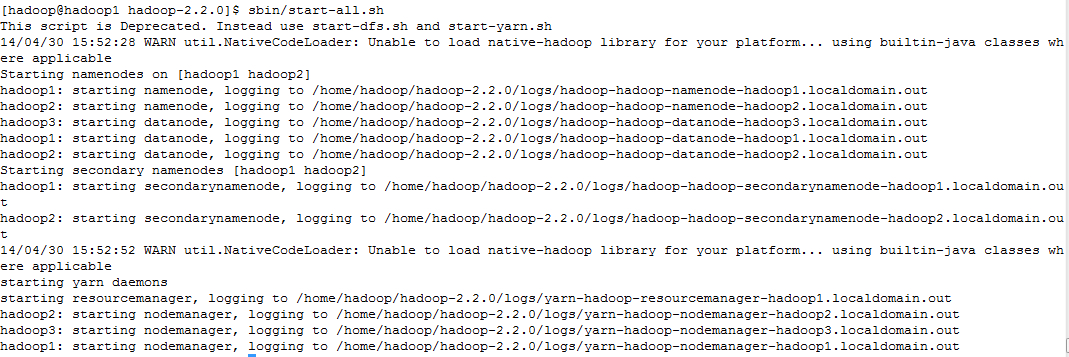

启动hadoop集群

cd /home/hadoop/hadoop-2.2.0

sbin/start-all.sh

从图上可以看出,先启动namenode,再启动datanode, 再启动secondarynamenode, 再启动resourcemanger, 最后启动nodemanager。

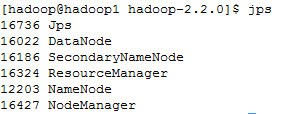

使用jps查看启动的进程

在hadoop1上运行jps

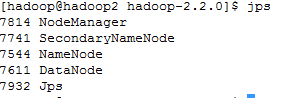

在hadoop2上运行jps

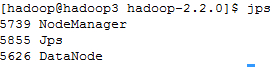

在hadoop3上运行jps

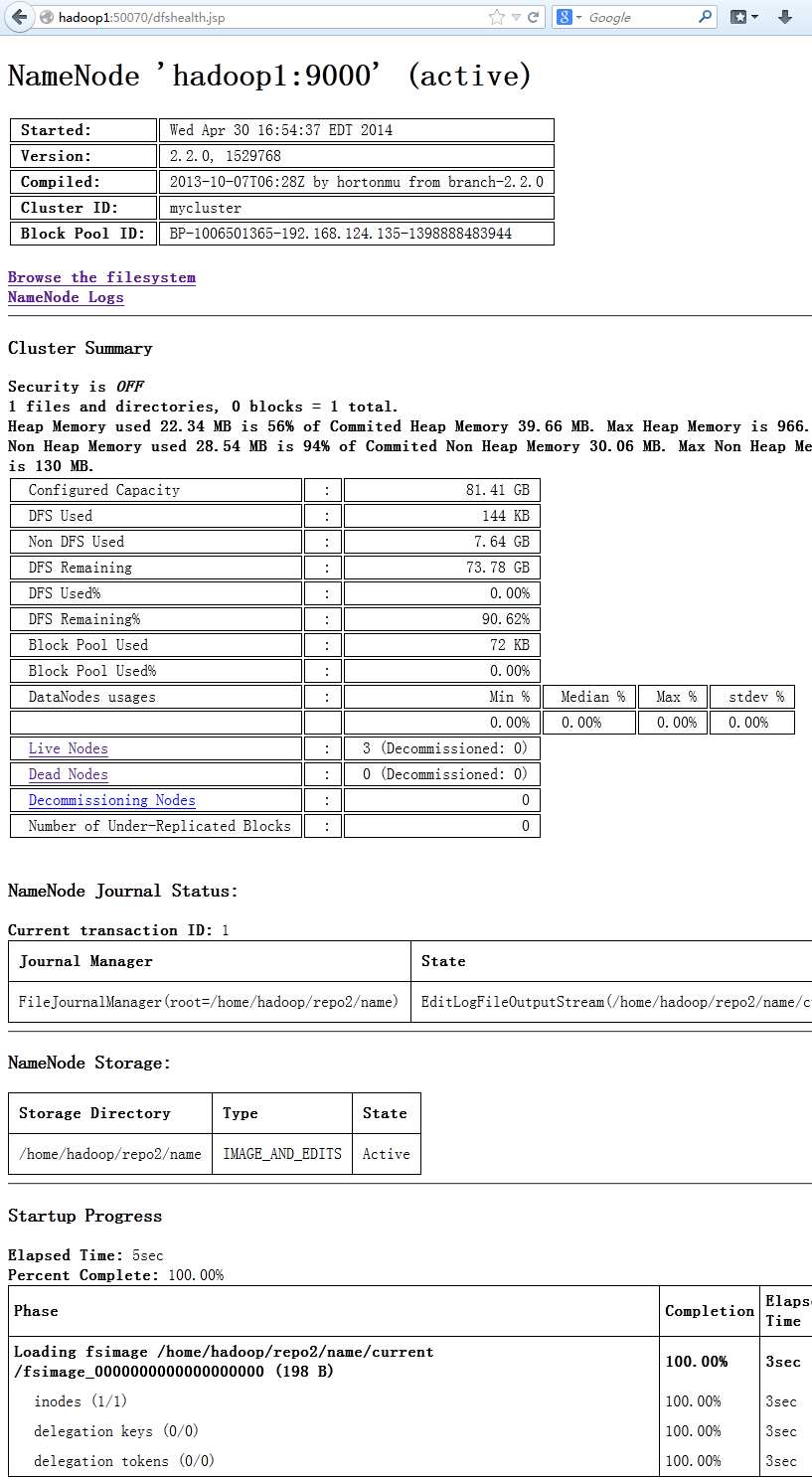

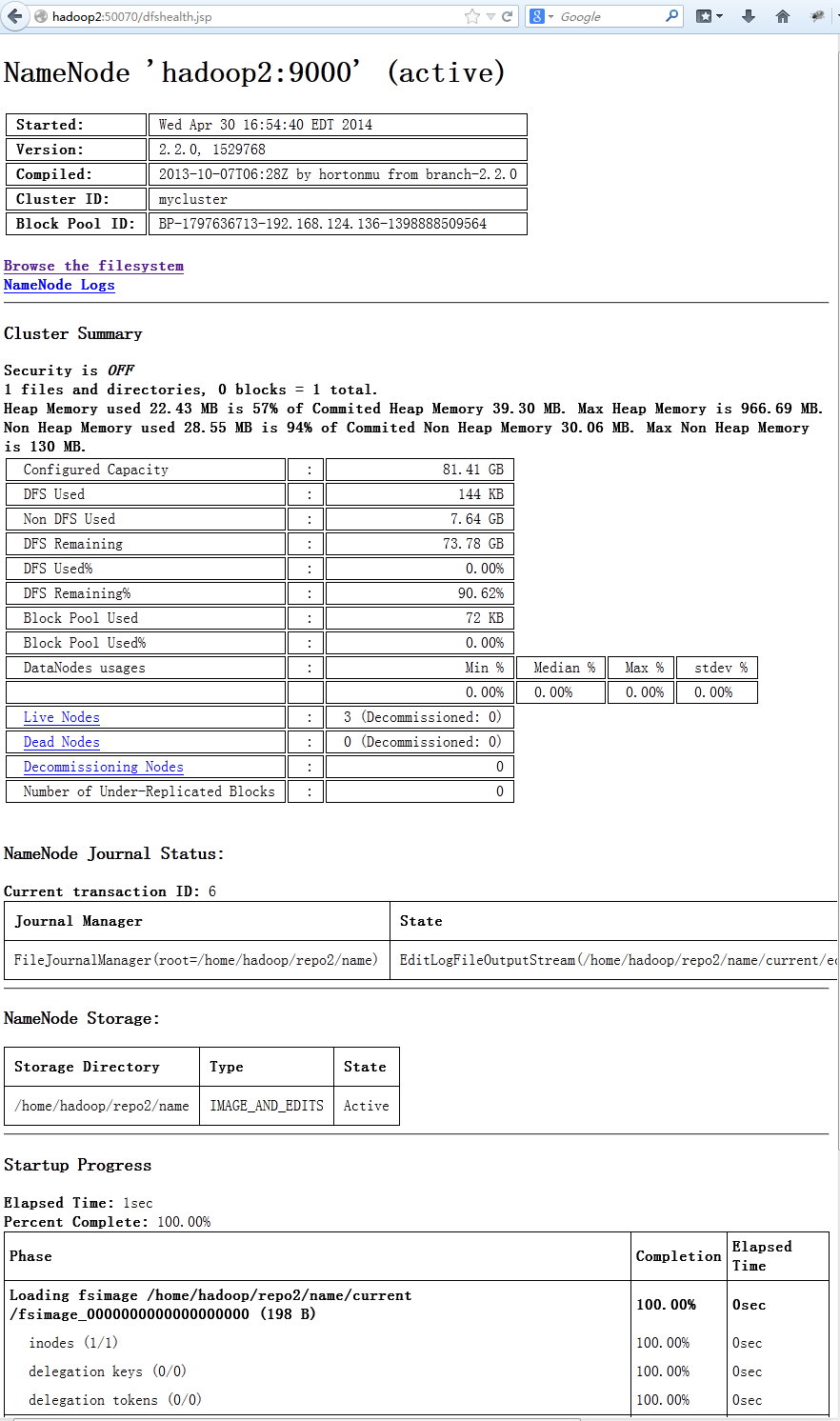

从图上可以看出hadoop2和hadoop1上的namenode都处于active状态,他们两个同时在线工作。

通过Hadoop的web界面可以看到,hadoop1和hadoop2都处于active状态,他们当前都是可以工作的,只是hadoop1工作在命名ns1,hadoop2工作在ns2上

在浏览器里输入http://hadoop1:50070

在浏览器里输入http://hadoop2:50070

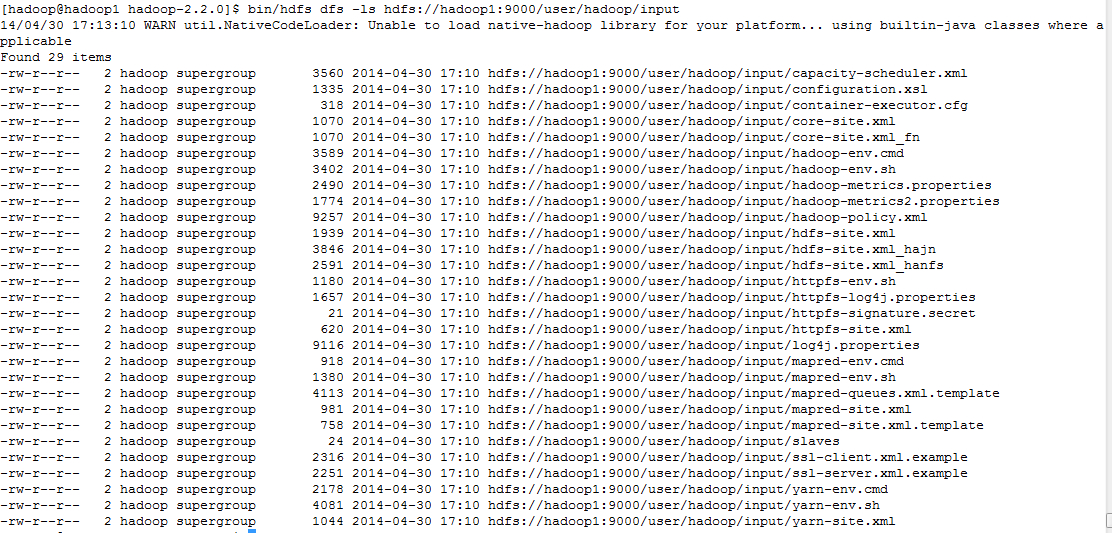

通过命令行看这两个namenode数据

bin/hdfs dfs -mkdir hdfs://hadoop1:9000/user/hadoop/input

bin/hdfs dfs -copyFromLocal etc/hadoop/* hdfs://hadoop1:9000/user/hadoop/input

bin/hdfs dfs -ls hdfs://hadoop1:9000/user/hadoop/input

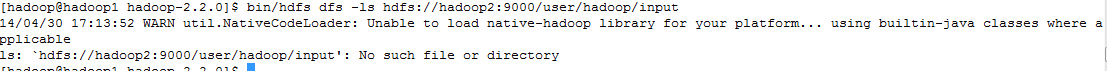

bin/hdfs dfs -ls hdfs://hadoop2:9000/user/hadoop/input

从上面可以看出对hadoop1上的namenode操作,不会影响到hadoop2上的namenode,因此采用federated namespace可以存储两倍或者更多的metadata信息。当发现namespace空间成瓶颈时,可以再添加一台来扩展namespace空间。目前有一个小的问题,当添加一个namespace节点时,需要重启整个集群。通常工作中hadoop集群是不能重启的,这有可能将是一个问题。我认为解决这个问题不存在技术上的问题,可能在后面的版本中解决这个问题。

Hadoop2的FN安装(federated namespace)的更多相关文章

- Linux Hadoop2.7.3 安装(单机模式) 一

Linux Hadoop2.7.3 安装(单机模式) 一 Linux Hadoop2.7.3 安装(单机模式) 二 java环境安装 http://www.cnblogs.com/zeze/p/590 ...

- Apache Hadoop2.x 边安装边入门

完整PDF版本:<Apache Hadoop2.x边安装边入门> 目录 第一部分:Linux环境安装 第一步.配置Vmware NAT网络 一. Vmware网络模式介绍 二. NAT模式 ...

- Linux Hadoop2.7.3 安装(单机模式) 二

Linux Hadoop2.7.3 安装(单机模式) 一 Linux Hadoop2.7.3 安装(单机模式) 二 YARN是Hadoop 2.0中的资源管理系统,它的基本设计思想是将MRv1中的Jo ...

- Hadoop2.6.0安装 — 集群

文 / vincentzh 原文连接:http://www.cnblogs.com/vincentzh/p/6034187.html 这里写点 Hadoop2.6.0集群的安装和简单配置,一方面是为自 ...

- Hadoop第3周练习--Hadoop2.X编译安装和实验

作业题目 位系统下进行本地编译的安装方式 选2 (1) 能否给web监控界面加上安全机制,怎样实现?抓图过程 (2)模拟namenode崩溃,例如将name目录的内容全部删除,然后通过secondar ...

- hadoop2.7.1安装

Hadoop2.7.1安装与配置 http://www.oschina.net/question/117352_247251 http://www.cnblogs.com/wayne1017/arch ...

- Hadoop-2.4.0安装和wordcount执行验证

Hadoop-2.4.0安装和wordcount执行验证 下面描写叙述了64位centos6.5机器下,安装32位hadoop-2.4.0,并通过执行 系统自带的WordCount样例来验证服务正确性 ...

- hadoop2.5.2安装部署

0x00 说明 此处已经省略基本配置步骤参考Hadoop1.0.3环境搭建流程,省略主要步骤有: 建立一般用户 关闭防火墙和SELinux 网络配置 0x01 配置master免密钥登录slave 生 ...

- Hadoop2.2.0安装过程记录

1 安装环境1.1 客户端1.2 服务端1.3 安装准备 2 操作系统安装2.1.1 BIOS打开虚拟化支持2.1.2 关闭防火墙2.1.3 安装 ...

随机推荐

- C、C++中如何成功嵌入python

修改lib文件名称,拷贝修改C:\Python27\libs目录下原来的python27.lib为python27_d.lib 包含头文件在C:\Python27\include目录下 包含lib文件 ...

- vs2005下面编译自己的luars232.dll

vc6在win7下用不了,大家建议使用vs2005...所以就装了,但是还是提示有不兼容,不过是可以用的.先凑合用,装了个2012,庞然大物!而且折腾了半天不知所云.先这样吧. 简单记录操作过程,参考 ...

- JDBC 使用SimpleJdbcTemplate实现Dao

public interface UserDao { public void addUser(User user); public User getUser(int userId); ...

- Docker exec与Docker attach

转载博客地址:http://blog.csdn.net/halcyonbaby 新浪微博:@寻觅神迹 内容系本人学习.研究和总结,如有雷同,实属荣幸! ================== Docke ...

- 使用Monkeyrunner进行Android自动化的总结

http://www.2cto.com/kf/201411/356056.html 使用Monkeyrunner进行Android自动化的总结 使用Android自动化的方式,不仅可以用来对Andro ...

- poj - 1953 - World Cup Noise(dp)

题意:n位长的01序列(0 < n < 45),但不能出现连续的两个1,问序列有多少种. 题目链接:id=1953" target="_blank">h ...

- kettle--组件(2)--计算器

组件如下: 对计算类型的说明如下: The table below contains descriptions associated with the calculator step: Functio ...

- JS JSOP跨域请求实例详解

JSONP(JSON with Padding)是JSON的一种“使用模式”,可用于解决主流浏览器的跨域数据访问的问题.这篇文章主要介绍了JS JSOP跨域请求实例详解的相关资料,需要的朋友可以参考下 ...

- 【搞机】Apple Pencil 开箱

前言 上次入手了新的iPad Pro .好开心呢. 然后发现官方的笔不错呢~ 后来,苹果官方的12期免息分期又回来啦~ 买买买!!! 上图 体验 官方的笔真的不愧叫Pencil ,完美模拟铅笔的手感. ...

- CentOS添加新网卡network-scripts目录下找不到网卡配置文件

问题描述: 使用VMware Workstation虚拟机,安装好CentOS7虚拟机后(原本只有一张网卡ifcfg-ens33),重新添加了一个新的网卡. 进入CentOS7系统后,使用ip add ...