PYTHON 爬虫笔记一:爬虫基本原理梳理

知识点一:爬虫的基本原理梳理

一、什么是爬虫?

请求网站并提取数据的自动化程序

二、爬虫的基本流程

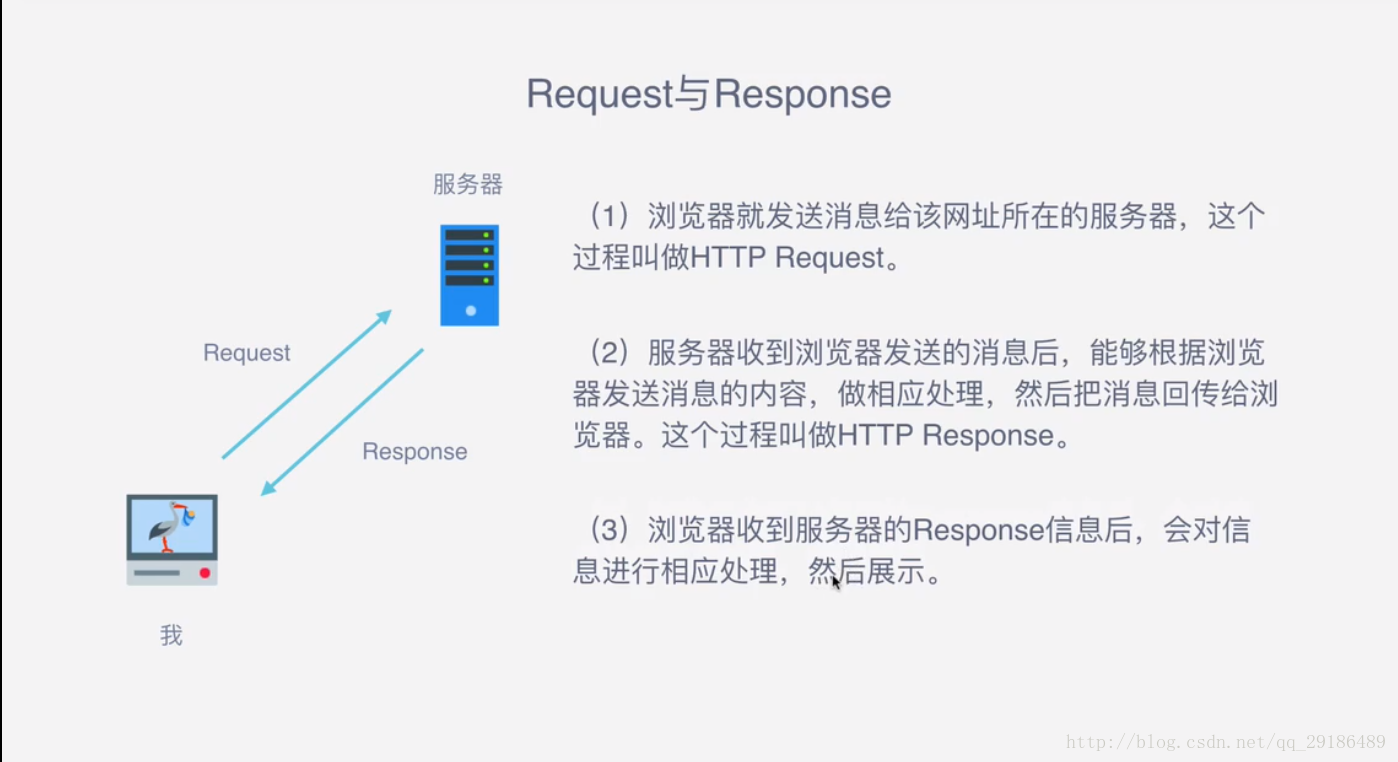

1:向服务器发起请求

通过HTTP库向目标站点发起请求,即发送一个Request,请求可以包含额外的headers等信息,等待服务器的响应。

2:获取响应内容

如果服务器正常响应,会得到一个Response,Response的内容便是所要获取的页面内容,类型可能有HTML、JSON、二进制文件(如图片、视频等类型)。

3:解析内容

得到的内容可能是HTML,可以用正则表达式、网页解析库进行解析。可能是JSON,可以直接转成JOSN对象进行解析,可能是二进制数据,可以保存或者进一步处理

4:保存内容

保存形式多样,可以保存成文本,也可以保存至数据库,或者保存成特定格式的文件。

三、什么是Response和Request ?

四、Request中包含哪些内容?

1:请求方式

主要是GET、POST两种类型,另外还有HEAD、PUT、DELETE、OPTIONS等。

2:请求URL

URL全称是统一资源定位符,如一个网页文档、一张图片、一个视频等都可以用URL来唯一来确定

3:请求头

包含请求时的头部信息,如User-Agent、Host、Cookies等信息

4:请求体

请求时额外携带的数据,如表单提交时的表单数据

五、Response中包含哪些内容?

1:响应状态

有多种响应状态,如200代表成功,301代表跳转,404代表找不到页面,502代表服务器错误等

2:响应头

如内容类型、内容长度、服务器信息、设置cookies等等

3:响应体

最主要的部分,包含了请求资源的内容,如网页HTML、图片二进制数据等。

六、能抓到怎样的数据?

1:网页文本

如HTML文档、JSON格式文本等

2:图片文件

获取的是二进制文件,保存为图片格式

3:视频

同为二进制文件,保存为视频格式即可

4:其他

只要能够请求到的,都能够获取到

import requests

response = requests.get('http://www.baidu.com')

print(response.text) #text:获取返回的响应体

print(response.headers) #headers:获取返回的响应头

print(response.status_code)#status_code:获取返回的状态码

requests模块请求

import requests

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.75 Safari/537.36'}

response = requests.get('http://www.baidu.com', headers=headers)

print(response.text)

print(response.headers)

print(response.status_code)

带请求头的爬取

import requests

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.75 Safari/537.36'}

response = requests.get('https://www.baidu.com/img/bd_logo1.png', headers=headers)

print(response.content) #获取响应体的二进制流

with open('E:/1.png','wb') as f:

f.write(response.content)

f.close()

视频,图片的下载方式

七、解析的方式

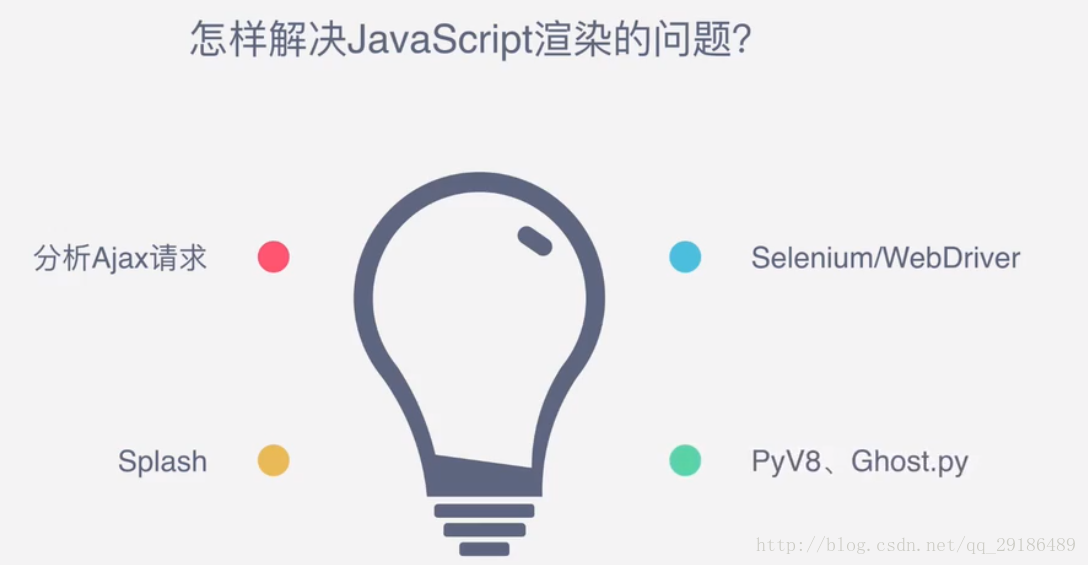

八、为什么我们抓到的有时候和浏览器看到的不一样?

有时候,网页返回是JS动态加载的,直接用请求库访问获取到的是JS代码,不是渲染后的结果。

九、怎样保存数据?

PYTHON 爬虫笔记一:爬虫基本原理梳理的更多相关文章

- Python学习笔记之爬虫

爬虫调度端:启动爬虫,停止爬虫,监视爬虫运行情况 URL管理器:对将要爬取的和已经爬取过的URL进行管理:可取出带爬取的URL,将其传送给“网页下载器”网页下载器:将URL指定的网页下载,存储成一个字 ...

- Python爬虫笔记(一):爬虫基本入门

最近在做一个项目,这个项目需要使用网络爬虫从特定网站上爬取数据,于是乎,我打算写一个爬虫系列的文章,与大家分享如何编写一个爬虫.这是这个项目的第一篇文章,这次就简单介绍一下Python爬虫,后面根据项 ...

- 吴裕雄--python学习笔记:爬虫基础

一.什么是爬虫 爬虫:一段自动抓取互联网信息的程序,从互联网上抓取对于我们有价值的信息. 二.Python爬虫架构 Python 爬虫架构主要由五个部分组成,分别是调度器.URL管理器.网页下载器.网 ...

- Python学习笔记——与爬虫相关的网络知识

1 关于URL URL(Uniform / Universal Resource Locator):统一资源定位符,用于完整地描述Internet上网页和其他资源的地址的一种标识方法 URL是爬虫的入 ...

- python学习笔记:"爬虫+有道词典"实现一个简单的英译汉程序

1.有道的翻译 网页:www.youdao.com Fig1 Fig2 Fig3 Fig4 再次点击"自动翻译"->选中'Network'->选中'第一项',如下: F ...

- 吴裕雄--python学习笔记:爬虫包的更换

python 3.x报错:No module named 'cookielib'或No module named 'urllib2' 1. ModuleNotFoundError: No module ...

- 吴裕雄--python学习笔记:爬虫

import chardet import urllib.request page = urllib.request.urlopen('http://photo.sina.com.cn/') #打开网 ...

- Python学习笔记_爬虫数据存储为xlsx格式的方法

import requests from bs4 import BeautifulSoup import openpyxl wb=openpyxl.Workbook() sheet=wb.active ...

- [Python爬虫笔记][随意找个博客入门(一)]

[Python爬虫笔记][随意找个博客入门(一)] 标签(空格分隔): Python 爬虫 2016年暑假 来源博客:挣脱不足与蒙昧 1.简单的爬取特定url的html代码 import urllib ...

随机推荐

- upper_bound——自己的实现

int BSearch() { int ln(1),rn(n+1); while(ln+1<rn) { int mid=(ln+rn)>>1; if (Check(mid)) { l ...

- 设置linux编码utf-8

#vim /etc/sysconfig/i18n LANG="en_US.UTF-8" SYSFONT="latarcyrheb-sun16" source / ...

- [转] DataSet的的几种遍历

1. 多表多行多列的情况 foreach (DataTable dt in YourDataset.Tables) //遍历所有的datatable { foreach (DataRow dr in ...

- 织梦dedecms 去掉后台登陆验证码的方法

那么有什么办法解决呢? 那么现在就给大家解决织梦去掉后台登陆验证码. 这里面分两种版本 一个是织梦5.6的程序 那么织梦5.6程序的解决办法是: 在织梦DedeCms5.6版本可以通过下面路径对验 ...

- 随想录(fatfs的学习)

[ 声明:版权全部,欢迎转载,请勿用于商业用途. 联系信箱:feixiaoxing @163.com] 上学的时候就对文件系统非常有兴趣.可是苦于没有合适的fs代码能够学习.市面上的fs代码,要么太 ...

- 文本聚类——Kmeans

上两篇文章分别用朴素贝叶斯算法和KNN算法对newgroup文本进行了分类測试.本文使用Kmeans算法对文本进行聚类. 1.文本预处理 文本预处理在前面两本文章中已经介绍,此处(略). 2.文本向量 ...

- 使用excel进行数据挖掘(5)---- 应用场景分析

使用excel进行数据挖掘(5)---- 应用场景分析 在配置环境后,能够使用excel进行数据挖掘. 环境配置问题可參阅: http://blog.csdn.net/xinxing__8185/ar ...

- mysql drop table命令使用总结

drop性能 drop table(innodb引擎) 数量2000w,只需要5m

- PCIE、UART、I2C、SMBUS、SPI、eSPI、USB、PS2、CAN、SDIO等数据传输协议

M.2 wife一般支持USB.SDIO.PCIE三种传输

- 如何使Htm页面使用IE9文档模式

修改Htm页面的方法之一是,在Head->Title下添加<META http-equiv="X-UA-Compatible" content="IE=9&q ...