The Expressive Power of Neural Networks: A View from the Width

@article{lu2017the,

title={The expressive power of neural networks: a view from the width},

author={Lu, Zhou and Pu, Hongming and Wang, Feicheng and Hu, Zhiqiang and Wang, Liwei},

pages={6232--6240},

year={2017}}

概

Universal approximation theorem-wiki, 这个定理分成俩个部分, 第一个部分是Unbounded Width Case, 这篇文章是Bounded Width Case (ReLu网络).

主要内容

定理1

另外, 定理1中的网络由若干个(视\(\epsilon\)而定) blocks排列而成, 每个block具有以下性质:

- depth: 4n+1, width: n+4 的神经网络

- 在一个范围外其“函数值”为0

- 它能够存储样本信息

- 它会加总自身的信息和前面的逼近信息

定理2

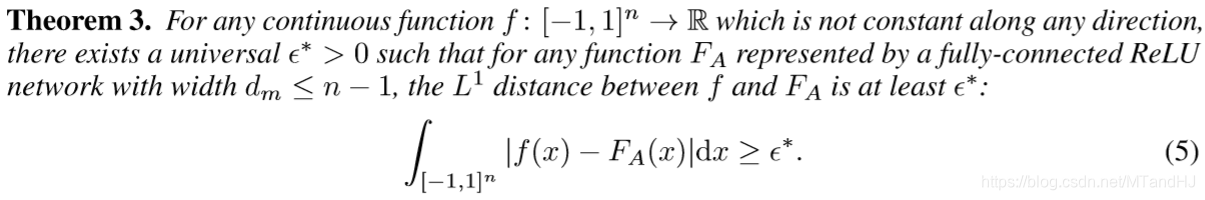

定理3

定理4

定理1的证明

因为主要关注定理1, 所以讲下这个部分的证明(实际上是因为其它懒得看了).

假设\(x = (x_1, x_2,\ldots, x_n)\)为输入, \(f\)是\(L^1\)可积的, 对于任意的\(\epsilon > 0\), 存在\(N > 0\)满足

\]

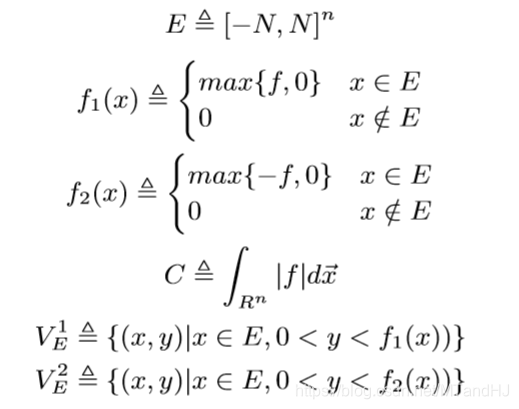

定义下列符号:

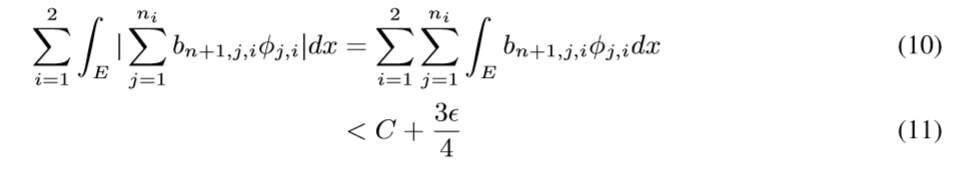

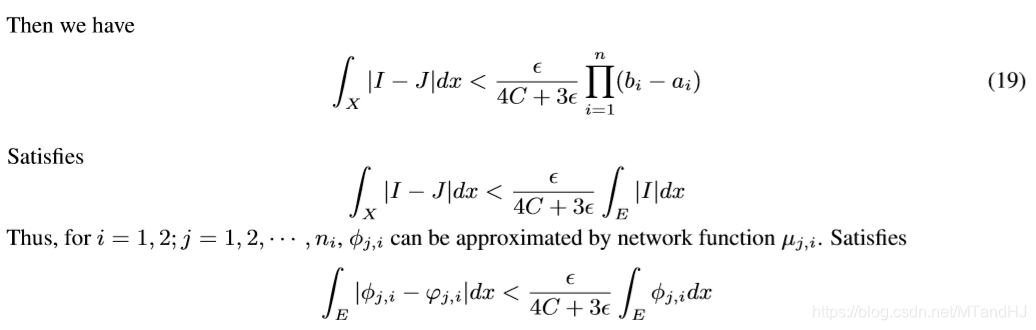

则我们有:

\]

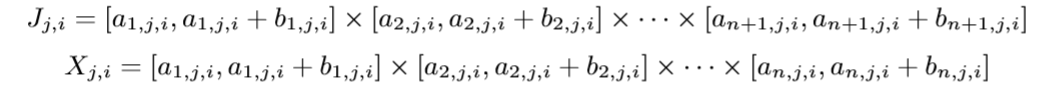

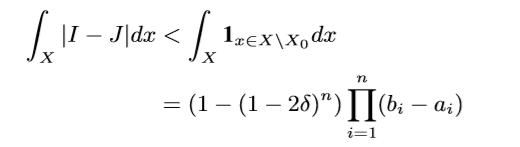

对于\(i=1, 2\), 既然\(V_E^i\)是可测的(且测度小于\(+\infty\)), 则我们能找到有限个\(n+1\)维的矩体去逼近(原文用了cover, 但是我感觉这里用互不相交的矩体才合理), 并有

\]

不出意外\(\Delta\)应该就是\.

假设\(J_{j,i}\)有\(n_i\)个, 且

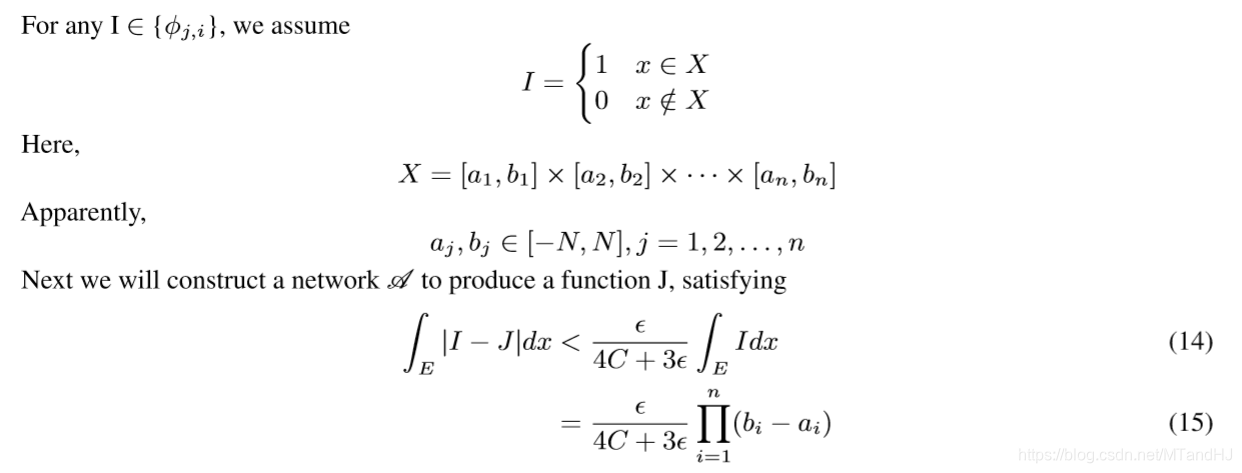

每一个\(J_{j, i}\)对应一个指示函数:

\begin{array}{ll}

1 & x \in X_{j,i} \\

0 & x \not \in X_{j,i}.

\end{array} \right.

\]

则

这个在实变函数将多重积分, 提到的下方图形集有讲到.

于是我们有(\(-f_1-f_2+f_1+f_2-f+f\)然后拆开来就可以得到不等式)

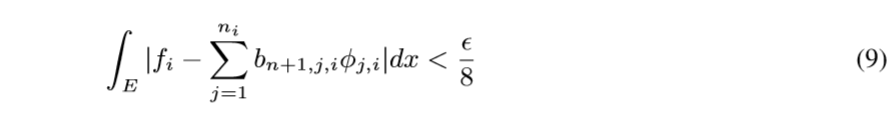

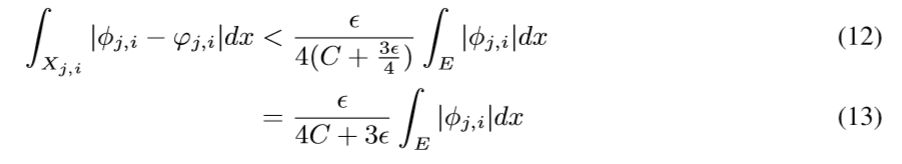

现在我们要做的就是通过神经网络拟合\(\varphi_{j,i}\)去逼近\(\phi_{j,i}\), 使得

现在来讲, 如果构造这个神经网络:

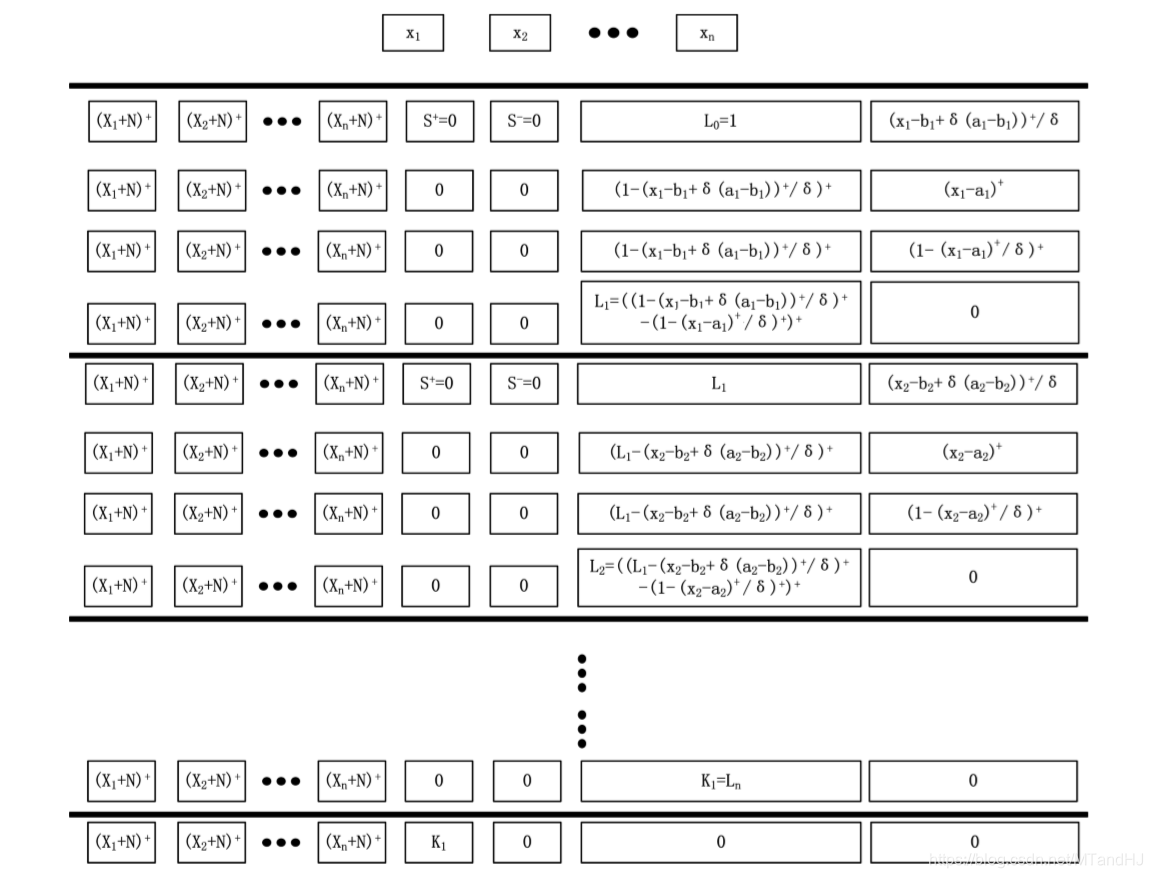

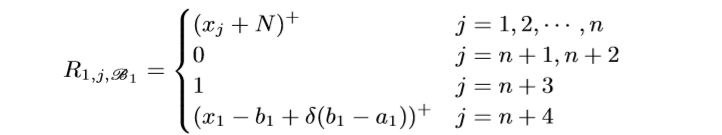

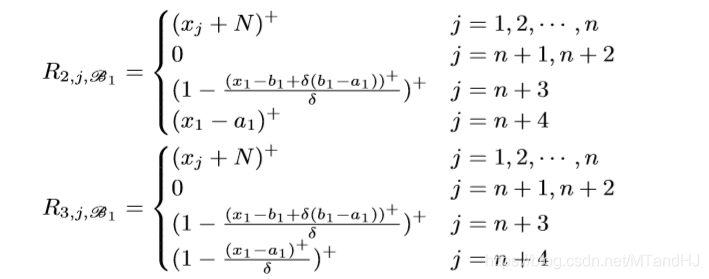

一个block有4n+1层, 每层的width是n+4, 注意到所有层的前n个Node都是一样的用来保存样本信息. 我们用\(R_{i, j, \mathscr{B_k}}, i=1, 2, 3, 4, j=1,\ldots,n+4, k=1,\ldots, n,\) 表示第\(k\)个Unit(每个Unit有4层)的第\(i\)层的第\(j\)个Node.

注意: \(R_{2, n+3, \mathscr{B_1}}\)应该是\((x_1-a_1)^+/\delta\), 最开始的结构图中的对的. 我们来看一下, 什么样的\(x=(x_1, \ldots, x_n)\), 会使得\(L_1\)不为0.

如果\(x_1=a_1+\delta(b_1-a_1)+\epsilon\), 这里\(\epsilon>0\)是一个任意小量, 和上文中的\(\epsilon\)没有关系. 此时(当\(\delta<1/2\))

\]

当\(\delta\)足够小的时候

\]

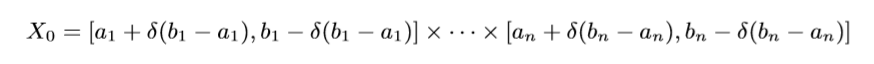

此时\(L_1=1\), 类似地, 可以证明, 当\(\delta \rightarrow 0\)的时候, \(x_1 \in (a_1+\delta(b_1-a_1),b_1-\delta(b_1-a_1))\)时, \(L_1=1\), 否则为0.

\(R_{i, j, \mathscr{B_k}}\)的定义是类似的, 只是

\]

可以证明, 当\(\delta\rightarrow 0\), 且\(x_t \in (a_t + \delta(b_t-a_t),b_t-\delta(b_t-a_t)), t=1,2,\ldots, k\)的时候, \(L_k=1.\), 这样我们就构造了一个指示函数, 如果这个这函数对应的\(i\)为1则将\(L_n\)存入n+1 Node, 否则 n+2 Node (实际上, 我感觉应该存的是\(b_{n+1,j,i}L_n\)), 则

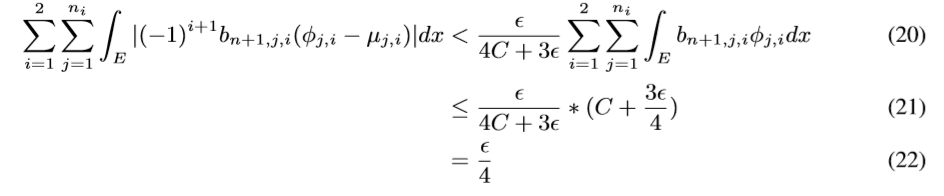

这里\(\mu\)相当于\(L_n\). 所以多个blocks串联起来后, 我们就得到了一个函数, 且这个函数是我们想要的.

这个直接通过超距体体积计算得来的, 我们只需要取:

最后

令\(g:=\sum_{i=1}^2\sum_{j=1}^{n_i}(-1)^{i+1}b_{n+1,j,i}\mu_{j,i}\),便有

此即定理1的证明.

The Expressive Power of Neural Networks: A View from the Width的更多相关文章

- Deep learning_CNN_Review:A Survey of the Recent Architectures of Deep Convolutional Neural Networks——2019

CNN综述文章 的翻译 [2019 CVPR] A Survey of the Recent Architectures of Deep Convolutional Neural Networks 翻 ...

- 课程一(Neural Networks and Deep Learning),第一周(Introduction to Deep Learning)—— 2、10个测验题

1.What does the analogy “AI is the new electricity” refer to? (B) A. Through the “smart grid”, AI i ...

- Non-local Neural Networks

1. 摘要 卷积和循环神经网络中的操作都是一次处理一个局部邻域,在这篇文章中,作者提出了一个非局部的操作来作为捕获远程依赖的通用模块. 受计算机视觉中经典的非局部均值方法启发,我们的非局部操作计算某一 ...

- tensorfolw配置过程中遇到的一些问题及其解决过程的记录(配置SqueezeDet: Unified, Small, Low Power Fully Convolutional Neural Networks for Real-Time Object Detection for Autonomous Driving)

今天看到一篇关于检测的论文<SqueezeDet: Unified, Small, Low Power Fully Convolutional Neural Networks for Real- ...

- [C3] Andrew Ng - Neural Networks and Deep Learning

About this Course If you want to break into cutting-edge AI, this course will help you do so. Deep l ...

- 提高神经网络的学习方式Improving the way neural networks learn

When a golf player is first learning to play golf, they usually spend most of their time developing ...

- 深度卷积神经网络用于图像缩放Image Scaling using Deep Convolutional Neural Networks

This past summer I interned at Flipboard in Palo Alto, California. I worked on machine learning base ...

- 卷积神经网络用于视觉识别Convolutional Neural Networks for Visual Recognition

Table of Contents: Architecture Overview ConvNet Layers Convolutional Layer Pooling Layer Normalizat ...

- Image Scaling using Deep Convolutional Neural Networks

Image Scaling using Deep Convolutional Neural Networks This past summer I interned at Flipboard in P ...

随机推荐

- Django url中可以使用类视图.as_view()进行映射的原因

说明:在练习天天生鲜项目时,对利用类视图去与正则匹配到的url做映射有点疑惑,经过查看他人博客以及自我分析算是整明白了,所以记录一下 参考:https://www.zmrenwu.com/post/5 ...

- 零基础学习java------39---------json格式交互,Restful(不懂),静态资源映射,SSM整合(ssm整合思想,application.xml文件详解(声明式事务管理),)

一. json格式交互(知道) 1 . 回顾ajax基本语法 $.ajax({ url:"", // 请求的后台路径 data:{"":"" ...

- Gradle—Android配置详解

参考[1]彻底弄明白Gradle相关配置 [2]Android Studio gradle配置详解

- MySQL学习(一)——创建新用户、数据库、授权

一.创建用户 1.登录mysql mysql -u root -p 2.创建本地用户>/font> use mysql; //选择mysql数据库 create user 'test'@' ...

- 【SpringBoot】几种定时任务的实现方式

SpringBoot 几种定时任务的实现方式 Wan QingHua 架构之路 定时任务实现的几种方式: Timer:这是java自带的java.util.Timer类,这个类允许你调度一个java ...

- linux查询健康状态,如何直观的判断你的Linux系统是否健康

一提到对于查看系统运行的健康状况,可能大多数朋友考虑到的就是查看进程或者打开任务管理器,但是对于应用在真实生产环境中服务器的linux系统来说,以上两种方式都不是***效的查看方式,那么今天就给大家推 ...

- Cnblog博客美化

具体的使用教程文档在这里 BNDong/Cnblogs-Theme-SimpleMemory 简要的操作如下: 博客园 - 管理 - 设置 值得注意得是: 要想JS代码要申请才可以使用 博客侧边栏 可 ...

- 【Java 8】Stream API

转自 Java 8 Stream Java8的两个重大改变,一个是Lambda表达式,另一个就是本节要讲的Stream API表达式.Stream 是Java8中处理集合的关键抽象概念,它可以对集合进 ...

- 【力扣】649. Dota2 参议院

Dota2 的世界里有两个阵营:Radiant(天辉)和 Dire(夜魇) Dota2 参议院由来自两派的参议员组成.现在参议院希望对一个 Dota2 游戏里的改变作出决定.他们以一个基于轮为过程的投 ...

- windows 显示引用账户已被锁定,且可能无法登录

今天遇到一个比较尴尬的事情,清理笔记本键盘时,在锁屏界面多次碰到enter键,在登录界面被锁定无法登录. 一开始慌了,因为没遇到过这样的问题.百度一看方法不少,便开始尝试, 有的说是重启进入安全模式, ...