CVPR顶会论文爬取存入MySQL数据库(标题、摘要、作者、PDF链接和原地址)

main.py

import pymysql

import re

import requests # 连接数据库函数

from bs4 import BeautifulSoup def insertCvpr(value): try:

db = pymysql.connect(host="localhost", user="root", password="password", database="article",charset="utf8")

print("数据库连接成功!")

cur = db.cursor()

sql = 'INSERT INTO cvpr(title,ab,author,hotword,pdf,path) VALUE (%s,%s,%s,%s,%s,%s)'

cur.execute(sql, value)

db.commit()

print("增加数据成功!")

except pymysql.Error as e:

print("增加数据失败: " + str(e))

db.rollback() db.close() #主函数

print("1")

url = "https://openaccess.thecvf.com/CVPR2020.py?day=2020-06-16"

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.92 Safari/537.36"}

res = requests.get(url,headers=headers)

res.encoding = "utf-8"

# 先爬取每个论文的网址

web = re.findall("""<dt class="ptitle"><br><a href="(.*?)">.*?</a></dt>""", res.text, re.S)

print("2")

for each in web:

try:

each = "http://openaccess.thecvf.com/" + each

print("3")

print(each)

res = requests.get(each, headers=headers, timeout=(3, 7))

paper = BeautifulSoup(res.text)

res.encoding = "utf-8"

# 在各各论文网站中爬取详细信息

title = re.findall("""<div id="papertitle">(.*?)</div>""", res.text, re.S)#标题

ab = re.findall("""<div id="abstract" >(.*?)</div>""", res.text, re.S)#摘要

author = paper.find("div", {"id": "authors"}).find("b").find("i").text#作者

pdf = re.findall("""\[<a href="\.\./\.\./(.*?)">pdf</a>\]""", res.text, re.S)#pdf下载地址

path = each#论文简述页面

if (len(title) > 0):

title = title[0].replace("\n", "")

ab = ab[0].replace("\n", "")

pdf = "http://openaccess.thecvf.com/" + pdf[0]

print(title)

print(author)

value = (title, ab, author, "", pdf, path)

insertCvpr(value)

except:

print("异常")

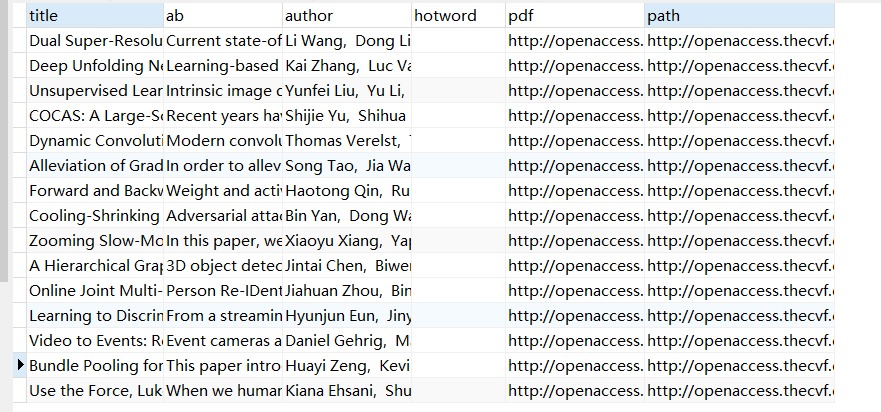

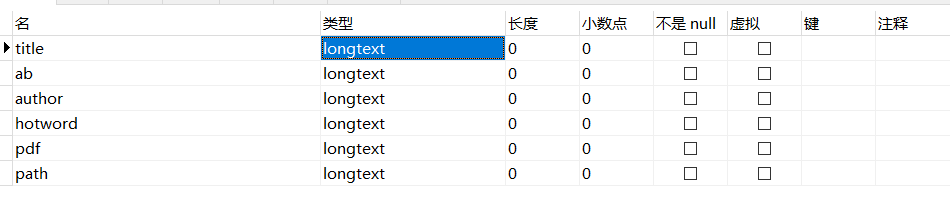

2.数据库

遇到的问题:

注意varchar最大长度为255,数据长度可能不够,使用longtext类型存储。

MySQL中tinytext、text、mediumtext和longtext等各个类型详解

CVPR顶会论文爬取存入MySQL数据库(标题、摘要、作者、PDF链接和原地址)的更多相关文章

- 个人作业——CVPR顶会论文爬取

main.py #保存单个界面数据 def getInfo(url): # url='https://openaccess.thecvf.com/WACV2021' header={ 'User-Ag ...

- 论文爬取 & 词频统计2.0

一.Github地址 课程项目要求 队友博客 二.具体分工 031602225 林煌伟 :负责C++部分主要功能函数的编写,算法的设计以及改进优化 031602230 卢恺翔 : 爬虫 ...

- 用Python获取沪深两市上市公司股票信息,提取创近10天股价新高的、停牌的、复牌不超过一天或者新发行的股票,并存入mysql数据库

#该脚本可以提取沪深两市上市公司股票信息,并按以下信息分类:(1)当天股价创近10个交易日新高的股票:(2)停牌的股票:(3)复牌不超过一个交易日或者新发行的股票 #将分类后的股票及其信息(股价新高. ...

- JSON文件存入MySQL数据库

目标:将不同格式的JSON文件存入MySQL数据库 涉及的点有: 1. java处理JSON对象,直接见源码. 2. java.sql.SQLException: Incorrect string v ...

- tensorflow利用预训练模型进行目标检测(三):将检测结果存入mysql数据库

mysql版本:5.7 : 数据库:rdshare:表captain_america3_sd用来记录某帧是否被检测.表captain_america3_d用来记录检测到的数据. python模块,包部 ...

- mysql数据库可以远程连接或者说用IP地址可以访问

mysql数据库可以远程连接或者说用IP地址可以访问 一般情况不建议直接修改root的权限, 先看下,自己mysql数据库的用户级权限 mysql -u root -p----->用root登陆 ...

- 操作服务器及MySQL数据库可以使其远程链接

转自原文操作服务器及MySQL数据库可以使其远程链接 一般情况分三个地方准备,MySQL数据库,防火墙,还有你的服务器主机的准备 操作系统为centos6.5.其他系统大致差不多. 1:在服务器中安装 ...

- <爬虫>利用BeautifulSoup爬取百度百科虚拟人物资料存入Mysql数据库

网页情况: 代码: import requests from requests.exceptions import RequestException from bs4 import Beautiful ...

- Python+Scrapy+Crawlspider 爬取数据且存入MySQL数据库

1.Scrapy使用流程 1-1.使用Terminal终端创建工程,输入指令:scrapy startproject ProName 1-2.进入工程目录:cd ProName 1-3.创建爬虫文件( ...

随机推荐

- JS实现自定义工具类,隔行换色、复选框全选、隔行高亮等

很多功能都可以放在js的工具类中,在使用的时候直接调用 本次实现的功能包括: /** 0.当点击表的整行的任意位置时,第一列的复选框或者单选框均选中 1.隔行换色 2.复选框的全选效果 3.实现表格 ...

- 跟我一起写 Makefile(十二)

隐含规则 ---- 在我们使用Makefile时,有一些我们会经常使用,而且使用频率非常高的东西,比如,我们编译C/C++的源程序为中间目标文件(Unix下是[.o]文件,Windows下是[.obj ...

- GO Time 类型方法处理集合

1.判断2个时间是否超时 package main import ( "fmt" "time" ) func main() { //获取1秒后时间 var No ...

- 结合场景使用Redis缓存与数据库同步

Redis缓存与MySQL数据库与同步 什么场景用到了Redis缓存? 1.广告数据 2.搜索时,分类品牌名称,分类名称和规格数据 3.购物车 4.支付 问题:如何实现? 1.广告数据 先查询Redi ...

- IP网络地址的计算

IP地址与子网掩码进行"与"运算,得到网络地址

- 心态崩了,我怎么知道实际生产环境的 B+ 树索引有多少层?

Q:在实际生产环境中,InnoDB 中一棵 B+ 树索引一般有多少层?可以存放多少行数据? 关于这个问题最近好像在牛客上经常看到,感觉没啥意义,可能主要考察的是对 B+ 索引的理解吧.先上答案: A: ...

- 微信小程序全局数据globalData的使用问题

如果在A页面设置全局属性,但在B页面无法使用的话,可能是这个问题: app.js globalData: { helpPage:0, }, A页面 A(e) { getApp().globalData ...

- Java使用Lettuce操作redis

maven包 # 包含了lettuce jar <dependency> <groupId>org.springframework.boot</groupId> & ...

- httpClient 下载

private void button2_Click(object sender, EventArgs e) { get(); } private async Task get() { await D ...

- mysql行转列 问题 SUM(IF(条件,列值,0))

sum(if(条件,列值,0))语法用例: select name,sum(if(subject="语文",score,0)) as "语文" from gra ...