大数据应用期末总评——Hadoop综合大作业

作业要求来自:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339

Hadoop综合大作业 要求:

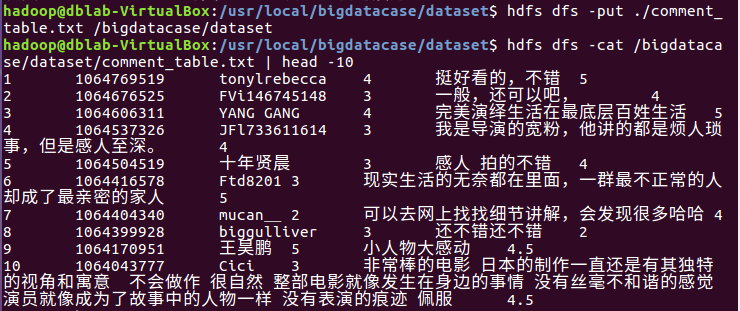

1.将爬虫大作业产生的csv文件上传到HDFS

此处选取的是爬虫大作业——对猫眼电影上《小偷家族》电影的影评。

此处选取的是comment.csv文件,共计20865条数据。

将comment.csv上传到HDFS

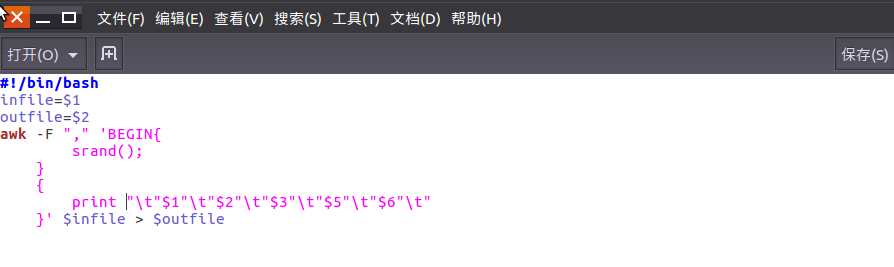

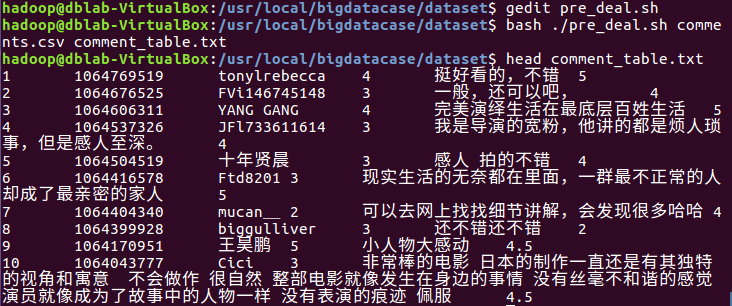

2.对CSV文件进行预处理生成无标题文本文件

编辑pre_deal.sh文件对csv文件进行数据预处理。

使得pre_deal.sh中的内容生效。

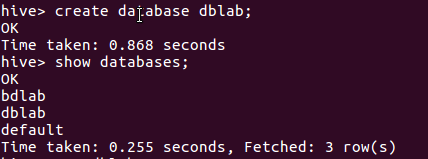

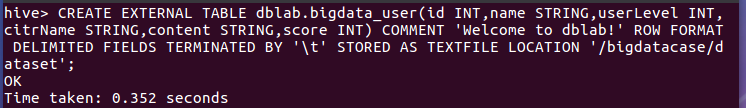

3.把hdfs中的文本文件最终导入到数据仓库Hive中

创建数据库dblab;

在数据库dblab中创建相应的表,此处是bigdata_user。

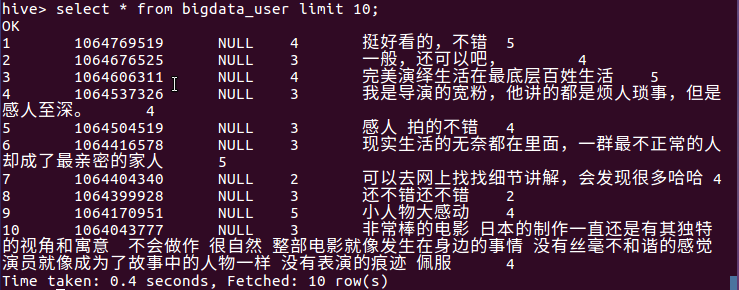

4.在Hive中查看并分析数据

5.用Hive对爬虫大作业产生的进行数据分析,写一篇博客描述你的分析过程和分析结果。(10条以上的查询分析)

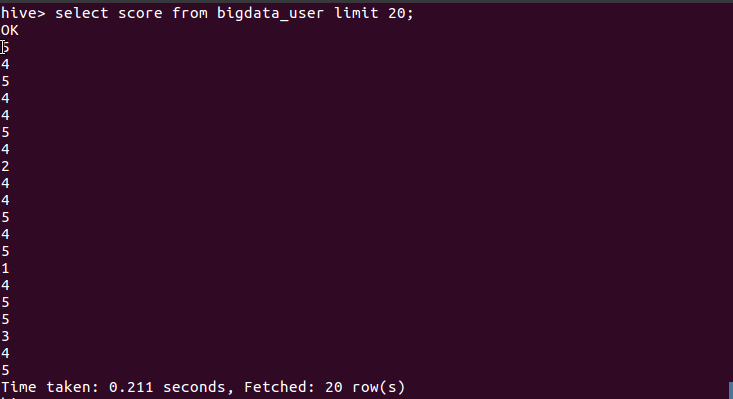

- 查询前20位猫眼电影用户对《小偷家族》电影的评分

由上图可以看出大部分用户评分都在4分以上(5分评分为满分),这也就说明大部分用户对此部电影的评价都非常高。

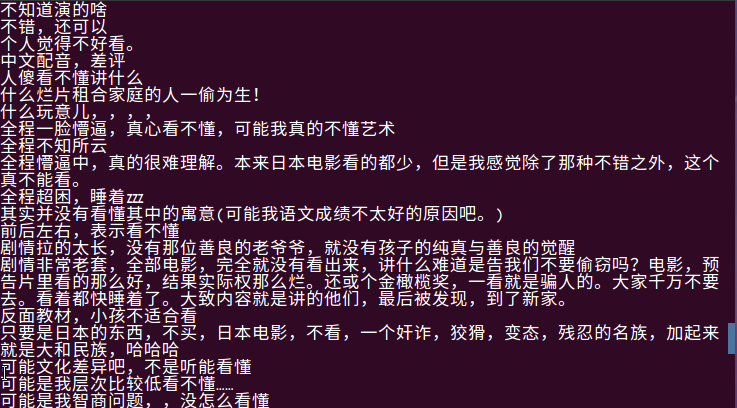

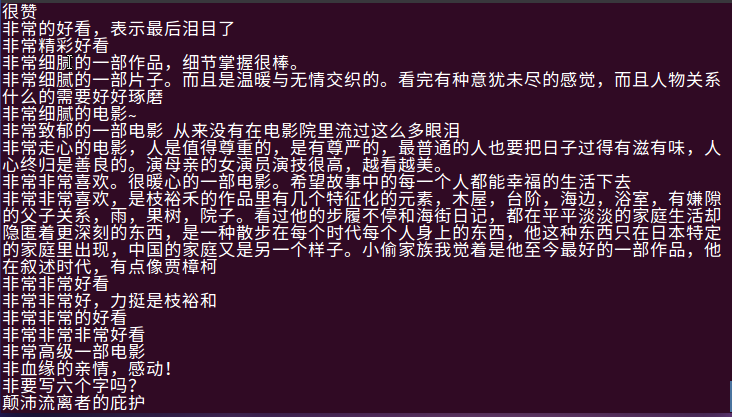

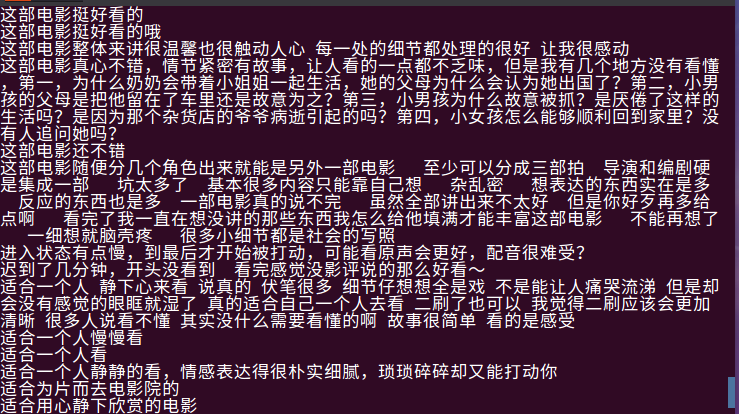

- 查询给此电影1分评分的用户的评论

由上图可以看出给低分评价的用户多半为没看懂与难以理解所给出的低评分,由此可以得出用户对于电影的理解都不完全相同,一千个读者就有一千个哈姆雷特,大部分用户都是靠着主观意识来给与电影评分。

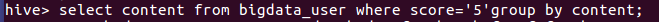

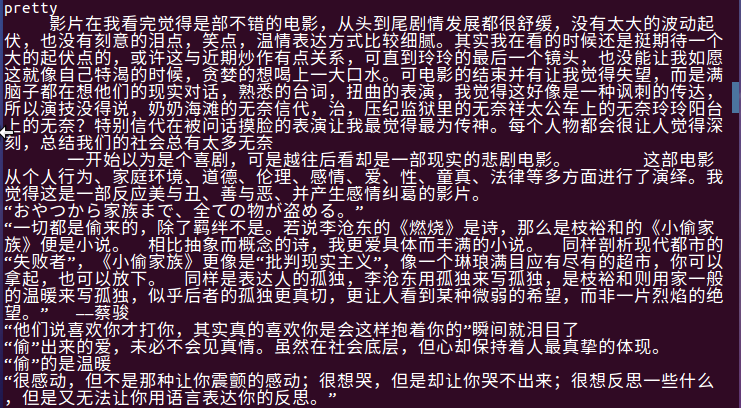

- 查询给此电影5分评分的用户的评论

由5分评价也可以得出此部电影的主旨与想向观众表达的东西,可看出此部电影主要是围绕着亲情,感动为主题来叙述的。

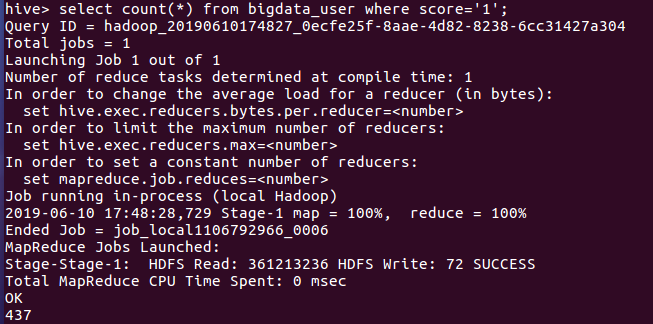

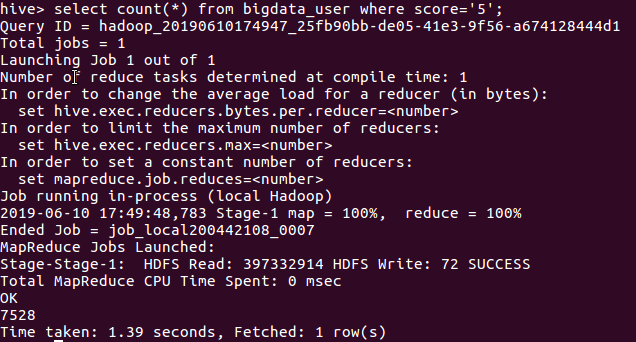

- 查询对比5评分用户与1分评分用户的人数

由上图可知给5分高分评价的用户人数为7528人,给1分低分评价用户人数为437人。由此可以知道这是一部优秀的电影。

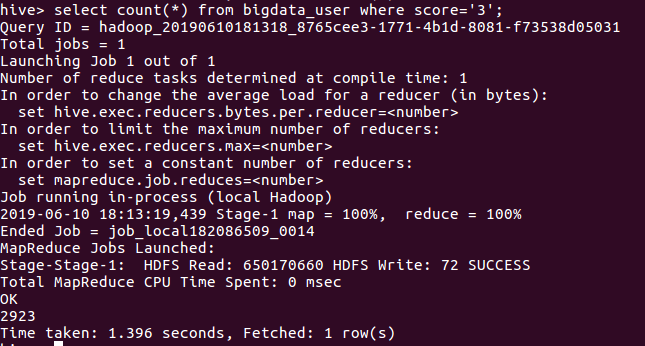

- 查询评分为3的用户人数

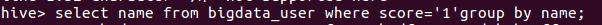

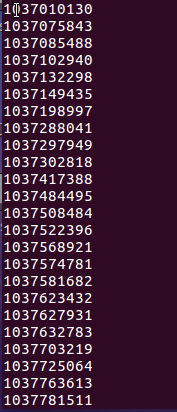

- 查询评分为1的用户id

- 查询评分为4的用户的评论

与评分为5的评论相差不多,基本都是对整个电影的好评与受到的感动。

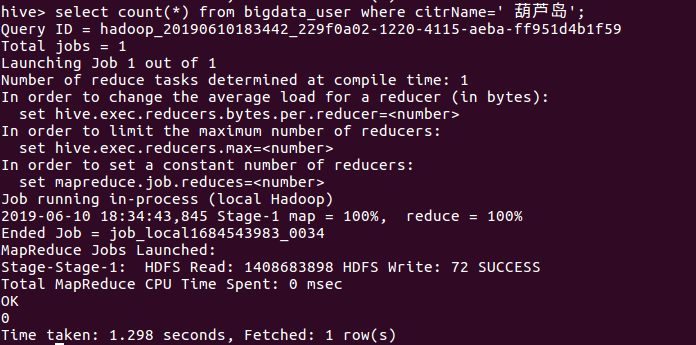

- 查询城市葫芦岛的评论用户人数

由此可看出此部电影还是比较小众,在较为不发达的城市基本无人问津。

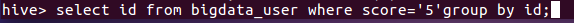

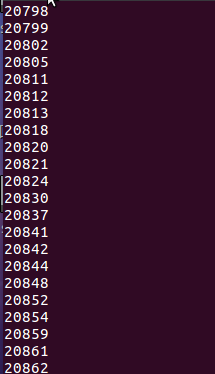

- 查询评分为5的处于表格的序号

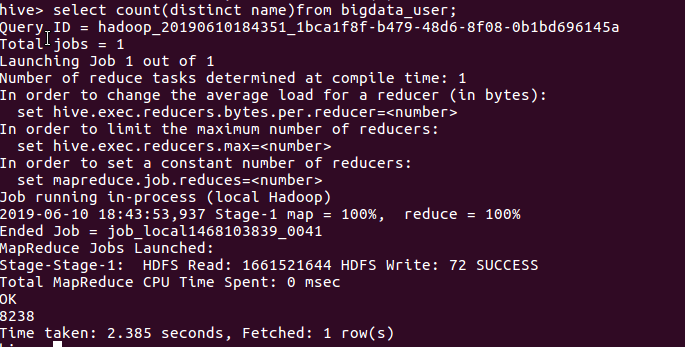

- 查询表格的数据中名字不重合的数据的数量

由上图可以看出由8238名用户没有重复评论数据的产生。说明爬取的数据仍然具备较大的重复性,需要注意。

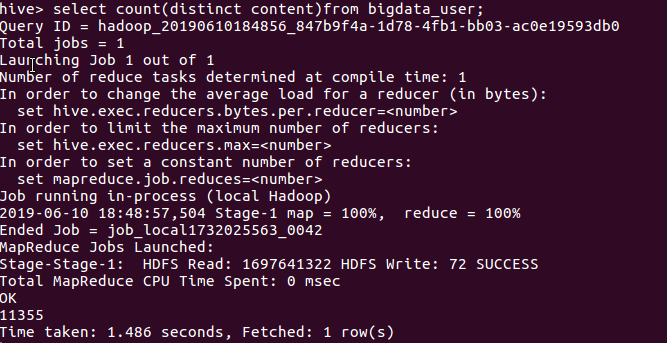

- 查询表格数据中评论未重合的数据数量

由上图可看出11355名用户评论没有重复数据的产生,基本可以视为有效数据。

总结:对于此次作业的完成,最大的问题就在于对于整个Hadoop环境的配置,就算是按部就班的按照步骤走,在这个过程中也遇到了非常多的问题,只要有一步的配置出现错误,会导致整个环境的配置失败。

但是总体来说还是基本按照要求完成了本次作业,在这个过程中我也是受益匪浅。

大数据应用期末总评——Hadoop综合大作业的更多相关文章

- 大数据应用期末总评Hadoop综合大作业

作业要求来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 1.将爬虫大作业产生的csv文件上传到HDFS 此次作业选取的 ...

- 【大数据应用期末总评】Hadoop综合大作业

作业要求来自:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 一.Hadoop综合大作业 要求: 1.将爬虫大作业产生的csv ...

- 大数据应用期末总评(hadoop综合大作业)

作业要求源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 一.将爬虫大作业产生的csv文件上传到HDFS (1)在/usr ...

- Hadoop综合大作业

Hadoop综合大作业 要求: 用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)词频统计. 用Hive对爬虫大作业产生的csv文件进行数据分析 1. 用Hive对爬虫大作业产 ...

- 《Hadoop综合大作业》

作业要求来自于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 我主要的爬取内容是关于热门微博文章“996”与日剧<我要 ...

- 菜鸟学IT之Hadoop综合大作业

Hadoop综合大作业 作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 1.将爬虫大作业产生的csv文件上传到HDF ...

- Hadoop综合大作业1

本次作业来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 一.课程评分标准: 分数组成: 考勤 10 平时作业 30 爬 ...

- 大数据平台搭建(hadoop+spark)

大数据平台搭建(hadoop+spark) 一.基本信息 1. 服务器基本信息 主机名 ip地址 安装服务 spark-master 172.16.200.81 jdk.hadoop.spark.sc ...

- 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机)

引言 在大数据学习系列之一 ----- Hadoop环境搭建(单机) 成功的搭建了Hadoop的环境,在大数据学习系列之二 ----- HBase环境搭建(单机)成功搭建了HBase的环境以及相关使用 ...

随机推荐

- Shallow copy and Deep copy

Shallow copy and Deep copy 第一部分: 一.来自wikipidia的解释: Shallow copy One method of copying an object is t ...

- RSA算法一:数学原理

- 如何进行SQL注入攻击?

1.数字注入 2.字符串注入 3. #后边全部为注释,字符串拼装后绕过密码验证. 4. 同样绕过密码验证

- ReqMan — 需求提取和协同处理工具

ReqMan是由德国engineering method AG公司开发的一款高效的.可自由定制的需求提取和协同处理工具.ReqMan 能够将PDF.Word.Excel等格式的文档提取 ...

- docker学习1-CentOS 7安装docker环境

前言 Docker 提供轻量的虚拟化,你能够从Docker获得一个额外抽象层,你能够在单台机器上运行多个Docker微容器,而每个微容器里都有一个微服务或独立应用,例如你可以将Tomcat运行在一个D ...

- vue 中 axios 使用

前言 在对接接口的时候时常会有传参问题调调试试很多,是 JSON.From Data还是 URL 传参,没有搞清楚就浪费很多时间. 本文中就结合 axios 来说明这些的区别,以便在以后工作更好对接. ...

- 6、Python基础语法

一.Python输出 print是python输出的关键字,默认是输出内容后换行. 如果不想换行,需要在变量末尾加上 end="" . a = 'hello' b = 'world ...

- Linux——CentOS7没有第二张网卡的配置信息

前言 为了一个实验做测试,在VMware中配置了环境,但是配置了双网卡后发现第二张网卡没有配置文件. 都是些基本命令就不写了,图里也有. 系统 : CentOS7.6 步骤 查看网卡信息 使用ip a ...

- BM递推杜教版【扩展】

也就是模数不是质数的时候, //下面的板子能求质数和非质数,只需要传不同的参数. #include <cstdio> #include <cstdlib> #include & ...

- 决策树——C4.5

-- coding: utf-8 -- """ Created on Thu Aug 2 17:09:34 2018 决策树ID3,C4.5的实现 @author: we ...