用jieba库统计文本词频及云词图的生成

一、安装jieba库

:\>pip install jieba #或者 pip3 install jieba

二、jieba库解析

jieba库主要提供提供分词功能,可以辅助自定义分词词典。

jieba库中包含的主要函数如下:

jieba.cut(s) 精确模式,返回一个可迭代的数据类型

jieba.cut(s,cut_all=True) 全模式,输出文本s中所有可能的单词

jieba.cut_for_search(s) 搜索引擎模式,适合搜索引擎建立索引的分词结果

jieba.lcut(s) 精确模式,返回一个列表类型,建议使用

jieba.lcut(s,cut_all=True) 全模式,返回一个列表类型,建议使用

jieba.lcut_for_search(s) 搜索引擎模式,返回一个列表类型,建议使用

jieba.add_word(w) 向分词词典中增加新词w

三、用jieba库统计文本的词频

《流浪地球》是刘慈欣的一部作品。该书讲述了庞大的地球逃脱计划,逃离太阳系,前往新家园。从网上获取该书的文本文件,保存于桌面上,命名为“流浪地球。”

现统计其文本中出现次数最多的是个词语,源代码如下:

import jieba

txt = open("C:\\Users\\Administrator\\Desktop\\流浪地球.txt", "r", encoding='utf-8').read()

words = jieba.lcut(txt)

counts = {}

for word in words:

if len(word) == 1: #排除单个字符的分词结果

continue

else:

counts[word] = counts.get(word,0) + 1

items = list(counts.items())

items.sort(key=lambda x:x[1], reverse=True)

for i in range(10):

word, count = items[i]

print ("{0:<10}{1:>5}".format(word, count))

运行程序后,输出结果如下:

故容易得知流浪地球中出现频次较高的词语

四、结合jieba库的词频统计制作词云图

1、准备工作:pip 安装 jieba , wordcloud ,matplotlib

2以阿Q正传为例:

源代码为:

from wordcloud import WordCloud

import matplotlib.pyplot as plt

import jieba #生成词云

def create_word_cloud(filename):

text = open("{}.txt".format(filename)).read()

# 结巴分词

wordlist = jieba.cut(text, cut_all=True)

wl = " ".join(wordlist) # 设置词云

wc = WordCloud(

# 设置背景颜色

background_color="white",

# 设置最大显示的词云数

max_words=2000,

# 这种字体都在电脑字体中,一般路径

font_path='C:\Windows\Fonts\simfang.ttf',

height=1200,

width=1600,

# 设置字体最大值

max_font_size=200,

# 设置有多少种随机生成状态,即有多少种配色方案

random_state=100,

) myword = wc.generate(wl) # 生成词云

# 展示词云图

plt.imshow(myword)

plt.axis("off")

plt.show()

wc.to_file('p.png') # 把词云保存下 if __name__ == '__main__':

create_word_cloud('C:\\Users\\Administrator\\Desktop\\阿Q正传')

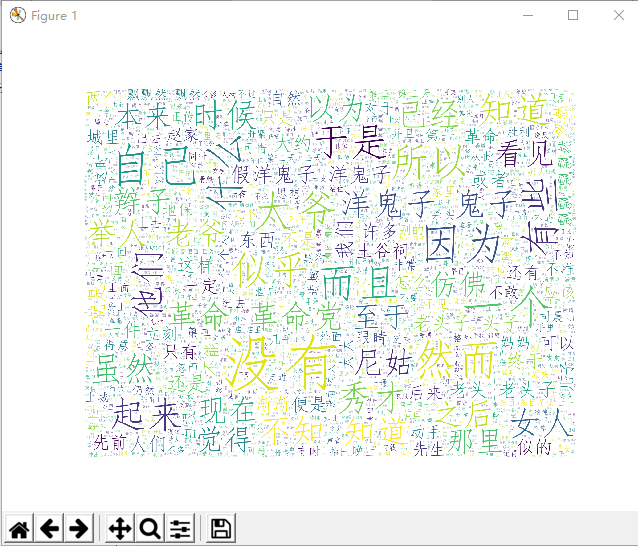

运行程序后,输出结果如下:

故可得出文本的云词图。

用jieba库统计文本词频及云词图的生成的更多相关文章

- 用Python搞出自己的云词图 | 【带你装起来】

作者:AI算法与图像处理 参考:http://www.sohu.com/a/149657007_236714 云词图简介 什么词云 由词汇组成类似云的彩色图形.“词云”就是对网络文本中出现频率较高的“ ...

- 利用python jieba库统计政府工作报告词频

1.安装jieba库 舍友帮装的,我也不会( ╯□╰ ) 2.上网寻找政府工作报告 3.参照课本三国演义词频统计代码编写 import jieba txt = open("D:\政府工作报告 ...

- jieba库的使用和好玩的词云

1.jieba库基本介绍 (1).jieba库概述 jieba是优秀的中文分词第三方库 - 中文文本需要通过分词获得单个的词语 - jieba是优秀的中文分词第三方库,需要额外安装 - ...

- jieba 库的使用和好玩的词云

jieba库的使用: (1) jieba库是一款优秀的 Python 第三方中文分词库,jieba 支持三种分词模式:精确模式.全模式和搜索引擎模式,下面是三种模式的特点. 精确模式:试图将语句最精 ...

- 运用jieba库统计词频及制作词云

一.对中国十九大报告做词频分析 import jieba txt = open("中国十九大报告.txt.txt","r",encoding="utf ...

- jieba库初级应用

1.jieba库基本介绍 (1).jieba库概述 jieba是优秀的中文分词第三方库 - 中文文本需要通过分词获得单个的词语 - jieba是优秀的中文分词第三方库,需要额外安装 - ...

- 广师大学习笔记之文本统计(jieba库好玩的词云)

1.jieba库,介绍如下: (1) jieba 库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过图结构和动态规划方法找到最大概率的词组:除此之外,jieba 库还提供了增加自定 ...

- jieba库词频统计

一.jieba 库简介 (1) jieba 库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过图结构和动态规划方法找到最大概率的词组:除此之外,jieba 库还提供了增加自定义中文 ...

- python实例:利用jieba库,分析统计金庸名著《倚天屠龙记》中人物名出现次数并排序

本实例主要用到python的jieba库 首先当然是安装pip install jieba 这里比较关键的是如下几个步骤: 加载文本,分析文本 txt=open("C:\\Users\\Be ...

随机推荐

- Linux 一 些常用的命令

查看当前系统JAVA的安装路径: echo $JAVA_HOME: 查看内核版本: uname -a ubuntu的防火墙 关闭:ufw disable开启:ufw enable 卸载了 iptabl ...

- TIME_WAIT 太多的解决办法

TIME_WAIT 客户端与服务器端建立TCP/IP连接后关闭SOCKET后,服务器端连接的端口状态为TIME_WAIT.主动关闭的一方在发送最后一个 ack 后 就会进入 TIME_WAIT 状态 ...

- python学习记录20181207

1.python中函数指针的用法 直接把函数名赋值给变量,不需要加上()和形参 如: def add(num1,num2): return num1+num2 fun = add 2.打印输出列表需要 ...

- django 实战篇之视图层

视图层(views.py) django必会三板斧 HttpResponse >>> 返回字符串 render >>> 支持模板语法,渲染页面,并返回给前端 red ...

- VS2010 开发 VB6.0 activeX控件 dll

项目源码 https://download.csdn.net/download/csdn_z_s/10427764 开发环境 操作系统: win7 64位 旗舰版 Java语言开发环境: Eclip ...

- vue中html模板使用绑定的全局函数

我们知道在script中使用vue绑定的全局函数时, 我们需要用这种方式使用: this.Util.Fun(e) 那在模板中, 比如v-if中想使用Fun函数怎么办呢?你应该这样做 <i v-i ...

- Eclipse连接HBase 报错:org.apache.hadoop.hbase.PleaseHoldException: Master is initializing

在eclipse中连接到HBase报错org.apache.hadoop.hbase.PleaseHoldException: Master is initializing,搜索了好久,网上其它人说的 ...

- thread - 传递引用参数

当给 thread 的执行函数传递指针参数时,没有任何问题,但是如果想传递引用,按照普通函数的调用方法会遇到编译失败: #include <iostream> #include <t ...

- 不装插件,查看.rp文件

AxShare国内平台地址:http://share.axure.org临时急用可以使用公用帐户.用户名:axure@webppd.com,密码:webppd123 上传.rp文件,点击 url 地址 ...

- oracle下查询的sql已经超出IIS响应时间

场景: 最近一直发生oracle下查询的sql已经超出IIS响应时间,但是后台DB的SQL查询还未终止,一直在查询.这对DB是造成很大的压力. 解决办法 增加OracleCommand 中的Comma ...