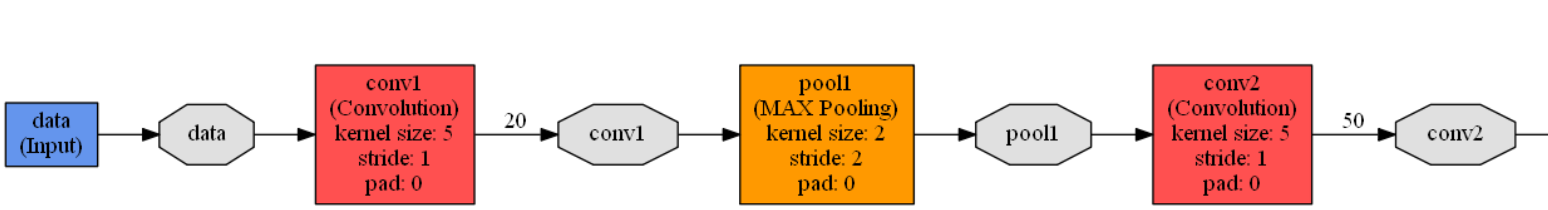

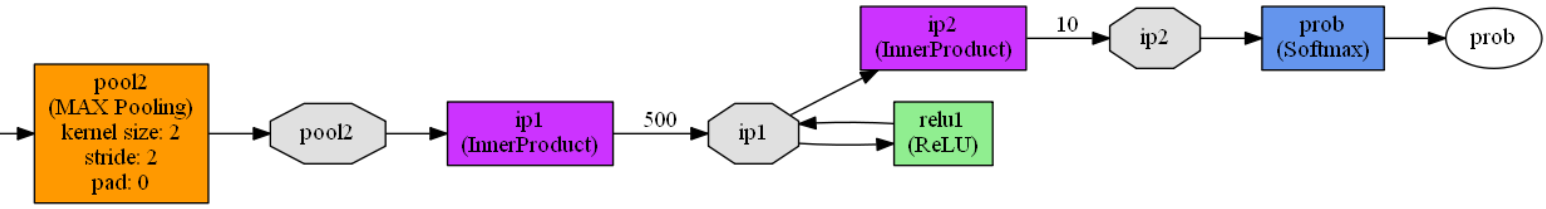

caffe中LetNet-5卷积神经网络模型文件lenet.prototxt理解

caffe在 .\examples\mnist文件夹下有一个 lenet.prototxt文件,这个文件定义了一个广义的LetNet-5模型,对这个模型文件逐段分解一下。

name: "LeNet" //网络的名称是LeNet

layer { //定义一个网络层

name: "data" //定义该网络层的名称为 data

type: "Input" //定义网络层的类型是 输入层

top: "data" //定义网络层的输出名称为data

//定义该网络层的训练参数

input_param {

//如果同时读取过多张图片进行训练,训练耗时比较久

//所以CNN中分组读入训练图片

//shape中第一个参数定义每组中包含图片数量

//第二个参数定义组数

//第三和第四个参数定义图片大小

//定义读取数据维度是: 64 1 28 28

shape: { dim: 64 dim: 1 dim: 28 dim: 28 }

}

}

//第一卷积层定义

layer { //定义一个网络层

name: "conv1" //网络层的名称是conv1

type: "Convolution" //网络层的类型是 卷积层

//模型结构图有两种常用画法,一种是从左到右,一种是从下到上

//caffe中使用从下到上画法,所以“bottom”表示的是上一层(输入层)

bottom: "data" //网络层的输入层是 data层

//同理,输出层在上,“top”表示输出

top: "conv1" //该层的输出层名称为conv1

//param定义权重和偏置的学习率,学习率大,迭代速度快,但是容易找不到最优解

//学习率小,迭代速度慢,耗时久

//如果有两个lr_mult参数,第一个表示权重(卷积核)的学习率系数,第二个表示偏置的学习率系数

//lr_mult定义的只是学习率系数,最终的值需要乘以solver.prototxt配置文件中配置的base_lr的值

//一般偏置的学习率系数是权重学习率系数的2倍

param {

lr_mult: 1 //该层权重学习率的系数为1

}

param {

lr_mult: 2 //该层偏置学习率的系数为2

}

//卷积操作的参数设置

convolution_param {

num_output: 20 //卷积输出特征图的数量为20

kernel_size: 5 //卷积核的大小是5*5

stride: 1 //卷积操作的步长是1,即卷积核逐个移动

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //卷积完成之后,数据的维度变成 64 20 24 24

//第一池化层定义

layer {

name: "pool1" //网络层的名称是pool1

type: "Pooling" //网络层的类型是池化层

bottom: "conv1" //网络层的输入时conv1(第一卷积层)

top: "pool1" //网络层的输出名称是 pool1

//池化操作的参数设置

pooling_param {

pool: MAX //最大值池化

kernel_size: 2 //池化核尺寸 是2*2

stride: 2 //池化步长是2

}

} //第一池化完成之后,数据的维度变成 64 20 12 12

//第二卷积层定义

layer {

name: "conv2" //网络层的名称是conv2

type: "Convolution" //网络层的类型是卷积层

bottom: "pool1" //网络层的输入时 pool1(第一池化层)

top: "conv2" //网络层的输出名称是 conv2

param {

lr_mult: 1 //卷积核的学习率系数是1

}

param {

lr_mult: 2 //偏置的学习率系数是2

}

//第二卷积层参数设置

convolution_param {

num_output: 50 //输出特征图的数量

kernel_size: 5 //卷积核的尺寸是5*5

stride: 1 //卷积操作步长是1

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //第二卷积操作完成之后,数据维度是 64 50 8 8

//第二池化层

layer {

name: "pool2" //网络层的名称是 pool2

type: "Pooling" //网络层的类型是池化层

bottom: "conv2" //网络层的输入时 conv2(第二卷积层)

top: "pool2" //网络层的输出名称是 pool2

pooling_param {

pool: MAX //池化方式是最大值池化

kernel_size: 2 //池化核大小是2*2

stride: 2 //池化步长是2

}

} //第二池化层完成之后,数据维度是 64 50 4 4

//第一层全连接层定义

layer {

name: "ip1" //网络层的名称是ip1

type: "InnerProduct" //网络层的类型是 全连接层

bottom: "pool2" //网络层的输入时 pool2(第二池化层)

top: "ip1" //网络层的输出名称是ip1

param {

lr_mult: 1 //卷积核的学习率系数是1

}

param {

lr_mult: 2 //偏置的学习率系数是2

}

//第一全连接层参数设置

inner_product_param {

num_output: 500 //输出向量维度,500个输出神经元

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //第一全连接层完成之后数据的维度是 1 500 1 1

//激活函数层的定义

layer {

name: "relu1" //网络层的名称是relu1

type: "ReLU" //网络层的类型是ReLU激活函数

bottom: "ip1" //网络层的输入时ip1(第一全连接层)

top: "ip1" //网络层的输出名称是 ip1,跟输入名称一样

} //激活层完成之后,数据的维度是 1 500 1 1

//第二全连接层定义

//数据的分类判断在本层完成

layer {

name: "ip2" //网络层的名称是 ip2

type: "InnerProduct" //网络层的类型是全连接层

bottom: "ip1" //网络层的输入时 ip1(激活函数层)

top: "ip2" //网络层的输出名称是 ip2

param {

lr_mult: 1 //卷积核的学习率系数是1

}

param {

lr_mult: 2 //偏置的学习率系数是2

}

//第二全连接层参数设置

inner_product_param {

num_output: 10 //输出维度是10,分别是0~9的数字

weight_filler {

type: "xavier" //卷积核参数采用xavier方法初始化

}

bias_filler {

type: "constant" //偏置初始值为0

}

}

} //第二全连接层完成之后,数据的维度是 1 10 1 1

//输出层定义

layer {

name: "prob" //网络的名称是 prob

type: "Softmax" //网络的类型是损失函数

bottom: "ip2" //网络的输入是 ip2(第二全连接层)

top: "prob" //网络的输出名称是 prob

}lenet.prototxt模型可视化,可以作为对比:

caffe中LetNet-5卷积神经网络模型文件lenet.prototxt理解的更多相关文章

- 使用PyTorch简单实现卷积神经网络模型

这里我们会用 Python 实现三个简单的卷积神经网络模型:LeNet .AlexNet .VGGNet,首先我们需要了解三大基础数据集:MNIST 数据集.Cifar 数据集和 ImageNet 数 ...

- CNN-1: LeNet-5 卷积神经网络模型

1.LeNet-5模型简介 LeNet-5 模型是 Yann LeCun 教授于 1998 年在论文 Gradient-based learning applied to document ...

- 手写数字识别 ----卷积神经网络模型官方案例注释(基于Tensorflow,Python)

# 手写数字识别 ----卷积神经网络模型 import os import tensorflow as tf #部分注释来源于 # http://www.cnblogs.com/rgvb178/p/ ...

- 利用Tensorflow实现卷积神经网络模型

首先看一下卷积神经网络模型,如下图: 卷积神经网络(CNN)由输入层.卷积层.激活函数.池化层.全连接层组成,即INPUT-CONV-RELU-POOL-FC池化层:为了减少运算量和数据维度而设置的一 ...

- 【TensorFlow/简单网络】MNIST数据集-softmax、全连接神经网络,卷积神经网络模型

初学tensorflow,参考了以下几篇博客: soft模型 tensorflow构建全连接神经网络 tensorflow构建卷积神经网络 tensorflow构建卷积神经网络 tensorflow构 ...

- CNN-4: GoogLeNet 卷积神经网络模型

1.GoogLeNet 模型简介 GoogLeNet 是2014年Christian Szegedy提出的一种全新的深度学习结构,该模型获得了ImageNet挑战赛的冠军. 2.GoogLeNet 模 ...

- CNN-2: AlexNet 卷积神经网络模型

1.AlexNet 模型简介 由于受到计算机性能的影响,虽然LeNet在图像分类中取得了较好的成绩,但是并没有引起很多的关注. 知道2012年,Alex等人提出的AlexNet网络在ImageNet大 ...

- CNN-3: VGGNet 卷积神经网络模型

1.VGGNet 模型简介 VGG Net由牛津大学的视觉几何组(Visual Geometry Group)和 Google DeepMind公司的研究员一起研发的的深度卷积神经网络,在 ILSVR ...

- 吴裕雄--天生自然python Google深度学习框架:经典卷积神经网络模型

import tensorflow as tf INPUT_NODE = 784 OUTPUT_NODE = 10 IMAGE_SIZE = 28 NUM_CHANNELS = 1 NUM_LABEL ...

随机推荐

- word2010无法显示endnote x7插件及破解endnote x7

最近本人由于要写文章需要使用endnotex7,相比于mendeley和noteexpress,文献管理和引用我喜欢endnote x7,阅读喜欢mendeley.可是由于之前用的正版30天到期了,破 ...

- EOJ 3 玩具谜题

小南有一套可爱的玩具小人,它们各有不同的职业. 有一天,这些玩具小人把小南的眼镜藏了起来.小南发现玩具小人们围成了一个圈,它们有的面朝圈内,有的面朝圈外.如下图: 这时 singer 告诉小南一个谜题 ...

- 深度理解Jquery 中 scrollTop() 方法

这是工作遇到scrollTop() 方法.为了强化自己,把它记录在博客园当中. 下面就开始scrollTop 用法讲解: scrollTop() 定义和用法 scrollTop() 方法设置或返回被选 ...

- 由mitab学到一些关于编译和运行的理解

今天上午在鼓捣一个地图绘图程序,程序写到一半,在windows下写不下去了,原因是需要引入的第三方的mitab类库进行.mif文件的读写操作,而这个类库的windows下的.lib文件和.dll文件都 ...

- BI中事实表与维度表的定义

一个典型的例子是,把逻辑业务比作一个立方体,产品维.时间维.地点维分别作为不同的坐标轴,而坐标轴的交点就是一个具体的事实.也就是说事实表是多个维度表的一个交点.而维度表是分析事实的一个窗口. 首先介绍 ...

- 一个vue的全局提示框组件

<template> <!-- 全局提示框 --> <div v-show="visible" class="dialog-tips dia ...

- Windos下的6种IO模型简要介绍

windows进行数据的收发有6种IO模型.分别是阻塞(blocking)模型,选择(select)模型,异步选择(WSAAsyncSelect)模型,事件选择(WSAEventSelect )模型, ...

- 最新消息,CDRX7冰点价再返现,你知道么?

一年一度的七夕又到来了,这不很多的单身狗朋友们都已经自备好了狗粮,准备在家里宅上一天呢? 开个玩笑今天小编就为各位带来了 一个劲爆大消息... Deng/deng/deng/deng..就是备受万众瞩 ...

- CentOS安装记录

决定开始复习Linux系统编程,这次我不再折腾Linux下的各种工具,直接使用VS2017进行代码编写与调试. 配置项 值 VM VMware® Workstation 15 Pro OS CentO ...

- 虚拟机安装mac

没成功,把几篇不错的文章先记录下地址 http://bbs.pcbeta.com/forum.php?mod=viewthread&tid=1437039 http://bbs.pcbeta. ...