【Storm篇】--Storm分组策略

一、前述

Storm由数源泉spout到bolt时,可以选择分组策略,实现对spout发出的数据的分发。对多个并行度的时候有用。

二、具体原理

1. Shuffle Grouping

随机分组,随机派发stream里面的tuple,保证每个bolt task接收到的tuple数目大致相同。

轮询,平均分配

2. Fields Grouping(相同fields去分发到同一个Bolt)

按字段分组,比如,按"user-id"这个字段来分组,那么具有同样"user-id"的 tuple 会被分到相同的Bolt里的一个task, 而不同的"user-id"则可能会被分配到不同的task。

3. All Grouping

广播发送,对于每一个tuple,所有的bolts都会收到

4. Global Grouping

全局分组,把tuple分配给task id最低的task 。

5. None Grouping

不分组,这个分组的意思是说stream不关心到底怎样分组。目前这种分组和Shuffle grouping是一样的效果。 有一点不同的是storm会把使用none grouping的这个bolt放到这个bolt的订阅者同一个线程里面去执行(未来Storm如果可能的话会这样设计)。

6. Direct Grouping

指向型分组, 这是一种比较特别的分组方法,用这种分组意味着消息(tuple)的发送者指定由消息接收者的哪个task处理这个消息。只有被声明为 Direct Stream 的消息流可以声明这种分组方法。而且这种消息tuple必须使用 emitDirect 方法来发射。消息处理者可以通过 TopologyContext 来获取处理它的消息的task的id (OutputCollector.emit方法也会返回task的id)

7. Local or shuffle grouping

本地或随机分组。如果目标bolt有一个或者多个task与源bolt的task在同一个工作进程中,tuple将会被随机发送给这些同进程中的tasks。否则,和普通的Shuffle Grouping行为一致

8.customGrouping

自定义,相当于mapreduce那里自己去实现一个partition一样。

总结:前4种用的多些,后面4种用的少些。

三、具体案例

Spout(产生数据):

package com.sxt.storm.grouping; import java.io.BufferedReader;

import java.io.FileInputStream;

import java.io.InputStreamReader;

import java.util.Map; import backtype.storm.spout.SpoutOutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.IRichSpout;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Values; public class MySpout implements IRichSpout { private static final long serialVersionUID = 1L; FileInputStream fis;

InputStreamReader isr;

BufferedReader br; SpoutOutputCollector collector = null;

String str = null; @Override

public void nextTuple() {//真正发的逻辑

try {

while ((str = this.br.readLine()) != null) {

// 过滤动作

collector.emit(new Values(str, str.split("\t")[1]));//发出数据,一行和一行切分完后第二个字段。

}

} catch (Exception e) {

} } @Override

public void close() {//释放资源

try {

br.close();

isr.close();

fis.close();

} catch (Exception e) {

e.printStackTrace();

}

} @Override

public void open(Map conf, TopologyContext context, SpoutOutputCollector collector) {//初始化(方法只调用一次)

try {

this.collector = collector;

this.fis = new FileInputStream("track.log");

this.isr = new InputStreamReader(fis, "UTF-8");

this.br = new BufferedReader(isr);

} catch (Exception e) {

e.printStackTrace();

}

} @Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {//声明发出去的字段

declarer.declare(new Fields("log", "session_id"));

} @Override

public Map<String, Object> getComponentConfiguration() {

return null;

} @Override

public void ack(Object msgId) {

System.out.println("spout ack:" + msgId.toString());

} @Override

public void activate() {

} @Override

public void deactivate() {

} @Override

public void fail(Object msgId) {

System.out.println("spout fail:" + msgId.toString());

} }

Bolt:(处理单元)

package com.sxt.storm.grouping; import java.util.Map; import backtype.storm.task.OutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.IRichBolt;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Tuple; public class MyBolt implements IRichBolt { private static final long serialVersionUID = 1L; OutputCollector collector = null;

int num = 0;

String valueString = null; @Override

public void cleanup() { } @Override

public void execute(Tuple input) {

try {

valueString = input.getStringByField("log");//通过fields接收数据 if (valueString != null) {

num++;

System.err.println(input.getSourceStreamId() + " " + Thread.currentThread().getName() + "--id="//打印当前进程名字

+ Thread.currentThread().getId() + " lines :" + num + " session_id:"//打印当前进程id

+ valueString.split("\t")[1]);//这行词的第二个字母

}

collector.ack(input);

// Thread.sleep(2000);

} catch (Exception e) {

collector.fail(input);

e.printStackTrace();

} } @Override

public void prepare(Map stormConf, TopologyContext context, OutputCollector collector) {

this.collector = collector;

} @Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields(""));//声明空即可

} @Override

public Map<String, Object> getComponentConfiguration() {

return null;

} }

Main方法:

package com.sxt.storm.grouping; import backtype.storm.Config;

import backtype.storm.LocalCluster;

import backtype.storm.StormSubmitter;

import backtype.storm.generated.AlreadyAliveException;

import backtype.storm.generated.InvalidTopologyException;

import backtype.storm.topology.TopologyBuilder;

import backtype.storm.tuple.Fields; public class Main { /**

* @param args

*/

public static void main(String[] args) { TopologyBuilder builder = new TopologyBuilder(); builder.setSpout("spout", new MySpout(), 1);//拓扑名,数据源,并行度 builder.setBolt("bolt", new MyBolt(), 2).allGrouping("spout");//两个spot并行 所有都分发 //builder.setBolt("bolt", new MyBolt(), 2).shuffleGrouping("spout");// shuffleGrouping其实就是随机往下游去发,不自觉的做到了负载均衡

//builder.setBolt("bolt", new MyBolt(), 2).fieldsGrouping("spout", new Fields("session_id")); // fieldsGrouping其实就是MapReduce里面理解的Shuffle,根据fields求hash来取模 //builder.setBolt("bolt", new MyBolt(), 2).globalGrouping("spout"); // 只往一个里面发,往taskId小的那个里面去发送 // builder.setBolt("bolt", new MyBolt(), 2).noneGrouping("spout"); // 等于shuffleGrouping // Map conf = new HashMap();

// conf.put(Config.TOPOLOGY_WORKERS, 4);

Config conf = new Config();

conf.setDebug(false);

conf.setMessageTimeoutSecs(30); if (args.length > 0) {

try {

StormSubmitter.submitTopology(args[], conf, builder.createTopology());//集群方式

} catch (AlreadyAliveException e) {

e.printStackTrace();

} catch (InvalidTopologyException e) {

e.printStackTrace();

}

} else {

LocalCluster localCluster = new LocalCluster();

localCluster.submitTopology("mytopology", conf, builder.createTopology());// 本地模拟参数分别为名称,配置,构建拓扑结构。

} } }

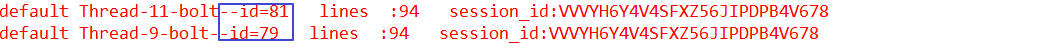

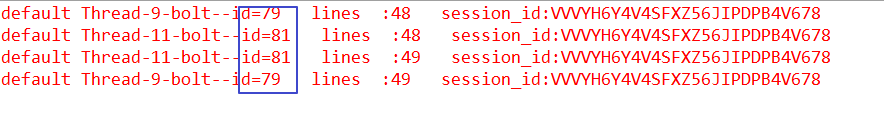

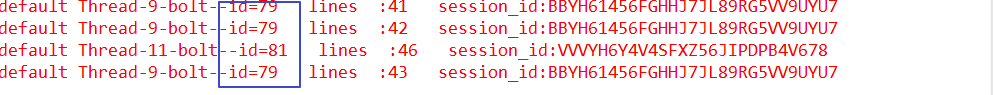

结果:

1. builder.setBolt("bolt", new MyBolt(), 2).allGrouping("spout");//两个spot并行 所有都分发

2. builder.setBolt("bolt", new MyBolt(), 2).shuffleGrouping("spout")其实就是随机往下游去发,不自觉的做到了负载均衡

3.builder.setBolt("bolt", new MyBolt(), 2).fieldsGrouping("spout", new Fields("session_id")); // fieldsGrouping其实就是MapReduce里面理解的Shuffle,根据fields求hash来取模,相同的名称的fields分发到一个bolt里面。

4.builder.setBolt("bolt", new MyBolt(), 2).globalGrouping("spout"); // 只往一个里面发,往taskId小的那个里面去发送

企业中常用的也就是这几个!!!

【Storm篇】--Storm分组策略的更多相关文章

- 简单聊聊Storm的流分组策略

简单聊聊Storm的流分组策略 首先我要强调的是,Storm的分组策略对结果有着直接的影响,不同的分组的结果一定是不一样的.其次,不同的分组策略对资源的利用也是有着非常大的不同,本文主要讲一讲loca ...

- Storm Grouping —— 流分组策略

Storm Grouping: Shuffle Grouping :随机分组,尽量均匀分布到下游Bolt中 将流分组定义为混排.这种混排分组意味着来自Spout的输入将混排,或随机分发给此Bolt中的 ...

- storm 的分组策略深入理解(-)

目录 storm的分组策略 根据实例来分析分组策略 common配置: Shuffle grouping shuffle grouping的实例代码 ShuffleGrouping 样例分析 Fiel ...

- 亿级流量场景下,大型架构设计实现【2】---storm篇

承接之前的博:亿级流量场景下,大型缓存架构设计实现 续写本博客: ****************** start: 接下来,我们是要讲解商品详情页缓存架构,缓存预热和解决方案,缓存预热可能导致整个系 ...

- Storm流计算之项目篇(Storm+Kafka+HBase+Highcharts+JQuery,含3个完整实际项目)

1.1.课程的背景 Storm是什么? 为什么学习Storm? Storm是Twitter开源的分布式实时大数据处理框架,被业界称为实时版Hadoop. 随着越来越多的场景对Hadoop的MapRed ...

- 【Storm篇】--Storm从初始到分布式搭建

一.前述 Storm是一个流式处理框架,相比较于SparkStreaming是一个微批处理框架,hadoop是一个批处理框架. 二 .搭建流程 1.集群规划 Nimbus Supervisor ...

- 分布式流式处理框架:storm简介 + Storm术语解释

简介: Storm是一个免费开源.分布式.高容错的实时计算系统.它与其他大数据解决方案的不同之处在于它的处理方式.Hadoop 在本质上是一个批处理系统,数据被引入 Hadoop 文件系统 (HDFS ...

- 【Storm】Storm实战之频繁二项集挖掘

一.前言 针对大叔据实时处理的入门,除了使用WordCount示例之外,还需要相对更深入点的示例来理解Storm,因此,本篇博文利用Storm实现了频繁项集挖掘的案例,以方便更好的入门Storm. 二 ...

- 【Storm】Storm实战之频繁二项集挖掘(附源码)

一.前言 针对大叔据实时处理的入门,除了使用WordCount示例之外,还需要相对更深入点的示例来理解Storm,因此,本篇博文利用Storm实现了频繁项集挖掘的案例,以方便更好的入门Storm. 二 ...

随机推荐

- Spring boot 学习笔记 1 - 自定义错误

Spring Boot提供了WebExceptionHandler一个以合理的方式处理所有错误的方法.它在处理顺序中的位置就在WebFlux提供的处理程序之前,这被认为是最后一个处理程序. 对于机器客 ...

- AngualrJS之自定义指令

一.指令 指令directive是AngularJS的核心之一 包括 - 用于扩展HTML元素.属性的指令 - 执行特定功能的指令 - 自定义指令 内置指令基本上都是以ng-开头 二.内置指令 1.属 ...

- 自动化设计模式Page Object

https://blog.csdn.net/qq_37546891/article/details/79052054#t1

- qt之数据库对照片的存取

需要确保数据库连接上 QOCI为驱动 //oracle 数据库连接 //需要在执行文件目录添加 oci.dll oraociei11.dll QSqlDatabase db = QSqlDatabas ...

- java自动化-数据驱动junit演示,下篇

本文旨在帮助读者介绍,如何使用excle实现数据驱动 本文是上文https://www.cnblogs.com/xuezhezlr/p/9096063.html的继续,如果没看上文建议自己看一下,对理 ...

- 跟大家谈一谈:涛舅舅家的微信域名检测api的心路历程

微信域名检测,这是近一年来兴起来的一种网络服务,可以通过api接口来对域名进行批量检测,以确认该域名有没有被微信拦截(见红),然后通过编程来实现域名切换保障链接可以正常打开. 涛舅舅工作室从事微信域名 ...

- 巨坑npm run dev 报错 终于找到正确答案 Error: EPERM: operation not permitted, open '/data/public/build/css/add.p

Windows10环境 npm run dev 报错 终于找到正确答案 Error: EPERM: operation not permitted, open '/data/public/build ...

- DEDECMS织梦文章摘要批量更改方法

我们建站有时候需要直接把数据库导入,只要修改一下基本的名称信息就可以直接用,但是遇用到一些问题.比如文章摘要不会随着文章内容的更新而更新.织梦(dede)在添加文章的时候会自动生成文章摘要,如果重新修 ...

- 自定义类在PropertyGrid上的展示方法

自定义类在PropertyGrid上的展示方法 零.引言 PropertyGrid用来显示某一对象的属性,但是并不是所有的属性都能编辑,基本数据类型(int, double等)和.Net一些封装的类型 ...

- position属性sticky和fixed的区别比较

position属性之fixed fixed总是以body为定位时的对象,总是根据浏览器窗口来进行元素的定位,通过left,right,top,bottom属性进行定位. <!DOCTYPE h ...