Python爬虫连载3-Post解析、Request类

一、访问网络的两种方法

1.get:利用参数给服务器传递信息;参数为dict,然后parse解码

2.post:一般向服务器传递参数使用;post是把信息自动加密处理;如果想要使用post信息,需要使用到data参数

3.Content-Type:application/x-www.form-urlencode

4.Content-Length:数据长度

5.简而言之,一旦更改请求方法,请注意其他请求头信息相适应

6.urllib.parse.urlencode可以将字符串自动转换为上面的信息。

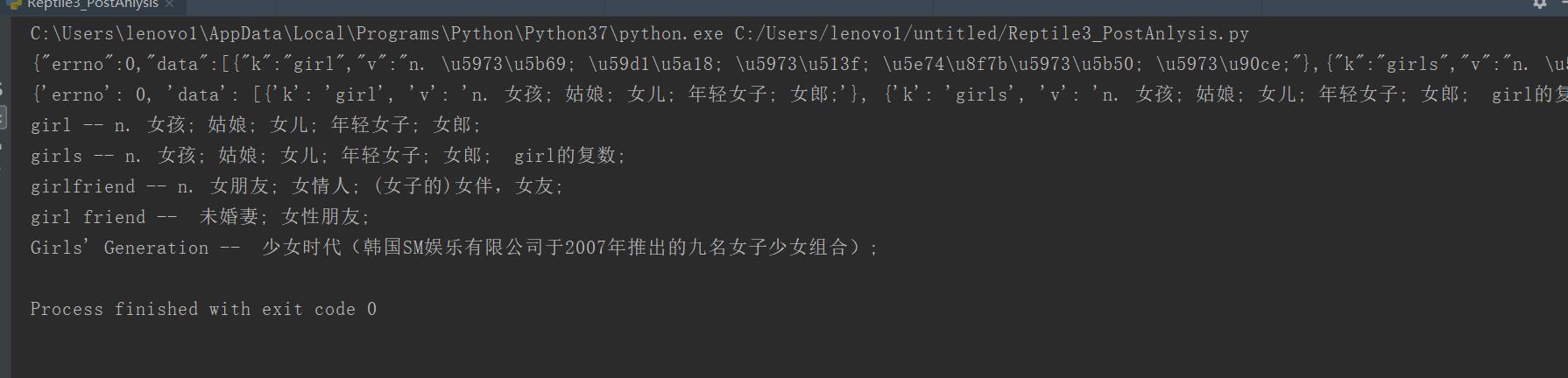

案例:利用parse模块模拟post请求分析百度翻译:分析步骤:

(1)打开谷歌浏览器,F12

(2)尝试输入单词girl,发想每敲击一个字母后都会有一个请求

(3)请求地址是:http://fanyi.baidu.com/sug

(4)打开network-XHR-sug

from urllib import request,parse

#负责处理json格式的模块

import json

"""

大致流程:

(1)利用data构造内容,然后urlopen打开

(2)返回一个json格式的结果

(3)结果就应该是girl的释义

"""

baseurl = "https://fanyi.baidu.com/sug"

#存放迎来模拟form的数据一定是dict格式

data = {

#girl是翻译输入的英文内容,应该是由用户输入,此处使用的是硬编码

"kw":"girl"

}

#需要使用parse模块对data进行编码

data = parse.urlencode(data).encode("utf-8")

#我们需要构造一个请求头,请求头应该至少包含传入的数据的长度

#request要求传入的请求头是一个dict格式

headers = {

#因为使用了post,至少应该包含content-length字段

"Content-length":len(data)

}

#有了headers,data,url就可以尝试发出请求了

rsp = request.urlopen(baseurl,data=data)#,headers=headers

json_data = rsp.read().decode()

print(json_data)

#把json字符串转化为字典

json_data = json.loads(json_data)

print(json_data)

for item in json_data["data"]:

print(item["k"],"--",item["v"])

二、为了更多的设置请求信息,单纯的通过urlopen函数已经不太好用了;需要利用request.Request类

这里只修改一部分代码,其他的代码都不变,依然可以得到相同的结果。

#构造一个Request的实例,就是借用这个类,来把能够传入的头信息进行封装扩展 req = request.Request(url=baseurl,data=data,headers=headers) #有了headers,data,url就可以尝试发出请求了 rsp = request.urlopen(req)#,headers=headers

三、源码

Reptile3_PostAnlysis.py

https://github.com/ruigege66/PythonReptile/blob/master/Reptile3_PostAnlysis.py

2.CSDN:https://blog.csdn.net/weixin_44630050

3.博客园:https://www.cnblogs.com/ruigege0000/

4.欢迎关注微信公众号:傅里叶变换,个人公众号,仅用于学习交流,后台回复”礼包“,获取大数据学习资料

Python爬虫连载3-Post解析、Request类的更多相关文章

- python爬虫的页面数据解析和提取/xpath/bs4/jsonpath/正则(1)

一.数据类型及解析方式 一般来讲对我们而言,需要抓取的是某个网站或者某个应用的内容,提取有用的价值.内容一般分为两部分,非结构化的数据 和 结构化的数据. 非结构化数据:先有数据,再有结构, 结构化数 ...

- Python爬虫教程-18-页面解析和数据提取

本篇针对的数据是已经存在在页面上的数据,不包括动态生成的数据,今天是对HTML中提取对我们有用的数据,去除无用的数据 Python爬虫教程-18-页面解析和数据提取 结构化数据:先有的结构,再谈数据 ...

- Python爬虫之Beautiful Soup解析库的使用(五)

Python爬虫之Beautiful Soup解析库的使用 Beautiful Soup-介绍 Python第三方库,用于从HTML或XML中提取数据官方:http://www.crummv.com/ ...

- Python爬虫beautifulsoup4常用的解析方法总结(新手必看)

今天小编就为大家分享一篇关于Python爬虫beautifulsoup4常用的解析方法总结,小编觉得内容挺不错的,现在分享给大家,具有很好的参考价值,需要的朋友一起跟随小编来看看吧摘要 如何用beau ...

- Python爬虫连载1-urllib.request和chardet包使用方式

一.参考资料 1.<Python网络数据采集>图灵工业出版社 2.<精通Python爬虫框架Scrapy>人民邮电出版社 3.[Scrapy官方教程](http://scrap ...

- Python爬虫之三种数据解析方式

一.引入 二.回顾requests实现数据爬取的流程 指定url 基于requests模块发起请求 获取响应对象中的数据 进行持久化存储 其实,在上述流程中还需要较为重要的一步,就是在持久化存储之前需 ...

- python爬虫(三) 用request爬取拉勾网职位信息

request.Request类 如果想要在请求的时候添加一个请求头(增加请求头的原因是,如果不加请求头,那么在我们爬取得时候,可能会被限制),那么就必须使用request.Request类来实现,比 ...

- Python爬虫连载5-Proxy、Cookie解析

一.ProxyHandler处理(代理服务器) 1.使用代理IP,是爬虫的常用手段 2.获取代理服务器的地址: www.xicidaili.com www.goubanjia.com 3.代理用来隐藏 ...

- 【Python爬虫】BeautifulSoup网页解析库

BeautifulSoup 网页解析库 阅读目录 初识Beautiful Soup Beautiful Soup库的4种解析器 Beautiful Soup类的基本元素 基本使用 标签选择器 节点操作 ...

随机推荐

- 项目SpringMVC+Spring+Mybatis 整合环境搭建(1)-> Spring+Mybatis搭建

目录结构 第一步:web.xml 先配置contextConfigLocation 对应的application-context.xml文件 打开webapp\WEB-INF\web.xml, 配置s ...

- input输入框联想功能

一直想找一个可以连接后台,可以根据后台内容的input输入框,可以实现联想功能,网上找到一个简单的静态页面的输入框联想,经过一番修改之后终于可以实现读取自己定义的数组的联想了,其实也比较简单就是格式的 ...

- linux系统中的硬链接和软链接

首先我们需要了解linux下硬链接以及软连接的基本概念.硬链接:新建的文件是已经存在的文件的一个别名,当原文件删除时,新建的文件仍然可以使用.软链接:也称为符号链接,新建的文件以“路径”的形式来表示另 ...

- winsocket入门学习

参考资料:http://c.biancheng.net/cpp/socket/ http://www.winsocketdotnetworkprogramming.com/ socket 是" ...

- selenium 操作下拉处理

操作下拉框处理 在网页中,有时候会遇到下拉框处理,这时候使用Webdriver提供的select类来处理. ##操作下拉框处理 #coding = utf-8 from selenium import ...

- Spacemacs安装

Spacemacs官网 为什么选择Spacemacs Spacemacs是一个已经配好的Emacs和Vim,正如官网所说的The best editor is neither Emacs nor Vi ...

- Loj 6002 最小路径覆盖(最大流)

题意: 求不相交的最小路径覆盖 思路: 连边跑二分图,匹配一条边相当于缩了一条边,答案为n-maxflow 如果是求可以相交的最小路径覆盖的话,先用Floyd跑出可达矩阵,然后所有可达的点连边跑二分图 ...

- Sklearn--(SVR)Regression学习笔记

今天介绍一个机器学习包,sklearn.其功能模块有regression\classification\clustering\Dimensionality reduction\data preproc ...

- Cmake知识----编写CMakeLists.txt文件编译C/C++程序(转)

1.CMake编译原理 CMake是一种跨平台编译工具,比make更为高级,使用起来要方便得多.CMake主要是编写CMakeLists.txt文件,然后用cmake命令将CMakeLists.txt ...

- 维基逃离MySQL 力挺开源数据库 MariaDB

近日全球著名百科类网站维基百科宣布,将不会再用MySQL数据库,据国外媒体报道,很多年,MySQL一直是热门的开源数据库,不过在被甲骨文收购后,面临闭源的风险.因此维基百科将切换到另外一款开源数据库M ...