流量分析系统---kafka集群部署

1、集群部署的基本流程

Storm上游数据源之Kakfa

下载安装包、解压安装包、修改配置文件、分发安装包、启动集群

2、基础环境准备

安装前的准备工作(zk集群已经部署完毕)

关闭防火墙

chkconfig iptables off && setenforce 0

创建工作目录并赋权

mkdir -p /export/servers

chmod 755 -R /export

3、集群部署

3.1下载安装包

wget http://mirrors.hust.edu.cn/apache/kafka/0.8.2.2/kafka_2.11-0.8.2.2.tgz

3.2解压安装包

tar -zxvf /export/software/kafka_2.11-0.8.2.2.tgz -C /export/servers/

cd /export/servers/

ln -s kafka_2.11-0.8.2.2 kafka

3.3修改配置文件

cp /export/servers/kafka/config/server.properties

/export/servers/kafka/config/server.properties.bak

vi /export/servers/kafka/config/server.properties

输入以下内容:

(提前创建好mkdir -p /export/servers/logs/kafka)

#broker的全局唯一编号,不能重复

broker.id=1 #每台机器递增 #用来监听链接的端口,producer或consumer将在此端口建立连接

port=9092 #处理网络请求的线程数量

num.network.threads=3 #用来处理磁盘IO的线程数量

num.io.threads=8 #发送套接字的缓冲区大小

socket.send.buffer.bytes=102400 #接受套接字的缓冲区大小

socket.receive.buffer.bytes=102400 #请求套接字的缓冲区大小

socket.request.max.bytes=104857600 #kafka运行日志存放的路径,需要提前创建好

log.dirs=/export/servers/logs/kafka #topic在当前broker上的分片个数

num.partitions=2 #用来恢复和清理data下数据的线程数量

num.recovery.threads.per.data.dir=1 #segment文件保留的最长时间,超时将被删除

log.retention.hours=168 #滚动生成新的segment文件的最大时间

log.roll.hours=168 #日志文件中每个segment的大小,默认为1G

log.segment.bytes=1073741824 #周期性检查文件大小的时间

log.retention.check.interval.ms=300000 #日志清理是否打开

log.cleaner.enable=true #broker需要使用zookeeper保存meta数据

zookeeper.connect=192.168.32.201:2181,192.168.32.202:2181,192.168.32.203:2181 #zookeeper链接超时时间

zookeeper.connection.timeout.ms=6000 #partion buffer中,消息的条数达到阈值,将触发flush到磁盘

log.flush.interval.messages=10000 #消息buffer的时间,达到阈值,将触发flush到磁盘

log.flush.interval.ms=3000 #删除topic需要server.properties中设置delete.topic.enable=true否则只是标记删除

delete.topic.enable=true #此处的host.name为本机IP(重要),如果不改,则客户端会抛出:Producer connection to localhost:9092

host.name=kafka01

advertised.host.name=192.168.32.201 #每台机子都要做相应修改

3.4分发安装包

scp -r /export/servers/kafka_2.11-0.8.2.2 kafka02:/export/servers

然后分别在各机器上创建软连

cd /export/servers/

ln -s kafka_2.11-0.8.2.2 kafka

3.5依次修改配置文件

依次修改各服务器上配置文件的的broker.id,分别是1,2,3不得重复。

host.name 改成自己的

advertised.host.name 改成自己的

配置环境变量

export KAFKA_HOME=/export/servers/kafka

export PATH=$PATH:$KAFKA_HOME/bin

3.6刷新环境变量

source /etc/profile

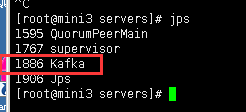

4、启动集群

启动集群各个节点启动zookeeper

各个节点启动集群

#启动

nohup kafka-server-start.sh /export/servers/kafka/config/server.properties &

#停止

kafka-server-stop.sh

流量分析系统---kafka集群部署的更多相关文章

- 流量分析系统--zookeeper集群部署

安装zookeeper mkdir apps tar -zxvf zookeeper-3.4.5.tar.gz -C apps [root@mini1 zookeeper-3.4.5]# rm -rf ...

- 分布式消息系统之Kafka集群部署

一.kafka简介 kafka是基于发布/订阅模式的一个分布式消息队列系统,用java语言研发,是ASF旗下的一个开源项目:类似的消息队列服务还有rabbitmq.activemq.zeromq:ka ...

- zookeeper集群+kafka集群 部署

zookeeper集群 +kafka 集群部署 1.Zookeeper 概述: Zookeeper 定义 zookeeper是一个开源的分布式的,为分布式框架提供协调服务的Apache项目 Zooke ...

- kafka 集群部署 多机多broker模式

kafka 集群部署 多机多broker模式 环境IP : 172.16.1.35 zookeeper kafka 172.16.1.36 zookeeper kafka 172.16 ...

- Zookeeper+Kafka集群部署(转)

Zookeeper+Kafka集群部署 主机规划: 10.200.3.85 Kafka+ZooKeeper 10.200.3.86 Kafka+ZooKeeper 10.200.3.87 Kaf ...

- 3、Kafka集群部署

Kafka集群部署 1)解压安装包 [ip101]$ tar -zxvf kafka_2.11-0.11.0.0.tgz -C /opt/app/ 2)修改解压后的文件名称 [ip101]$ mv k ...

- Zookeeper+Kafka集群部署

Zookeeper+Kafka集群部署 主机规划: 10.200.3.85 Kafka+ZooKeeper 10.200.3.86 Kafka+ZooKeeper 10.200.3.87 Kaf ...

- Kafka集群部署 (守护进程启动)

1.Kafka集群部署 1.1集群部署的基本流程 下载安装包.解压安装包.修改配置文件.分发安装包.启动集群 1.2集群部署的基础环境准备 安装前的准备工作(zk集群已经部署完毕) 关闭防火墙 c ...

- Kafka集群部署以及使用

Kafka集群部署 部署步骤 hadoop102 hadoop103 hadoop104 zk zk zk kafka kafka kafka http://kafka.apache.org/down ...

随机推荐

- github使用和推送到服务器端。。。

Alan Alan -- :: 第二节:创建一个仓库(Create A Repo Repositories) 直接在自己的登录后进入 github.com 首页就可以看到, 下面一栏有四步.用来创建 ...

- Phaser 桌面和手机游戏HTML5框架

Phaser是一个流行的2D开源游戏框架,可以用来开发桌面或手机浏览器HTML5游戏,适合侧视或顶视风格: Phaser同时支持Canvas和WebGL渲染引擎,预置了完备的精灵动画.输入 管理.瓦片 ...

- Gold Balanced Lineup - poj 3274 (hash)

这题,看到别人的解题报告做出来的,分析: 大概意思就是: 数组sum[i][j]表示从第1到第i头cow属性j的出现次数. 所以题目要求等价为: 求满足 sum[i][0]-sum[j][0]=sum ...

- Mybatis在IDEA中使用generator逆向工程生成pojo,mapper

使用mybatis可以逆向生成pojo和mapper文件有很多种方式,我以前用的是mybtais自带的generator包来生成,连接如下:mybatis自己生成pojo 今天我用了IDEA上使用ma ...

- Java并发计数器探秘

前言 一提到线程安全的并发计数器,AtomicLong 必然是第一个被联想到的工具.Atomic* 一系列的原子类以及它们背后的 CAS 无锁算法,常常是高性能,高并发的代名词.本文将会阐释,在并发场 ...

- flex初始化方法

initalize是初始化,creationcomplete是创建完成,applicationComplete是应用程序中所有的实例都创建完成后才执行,三者的执行顺序是intalize creatio ...

- JavaScript 与 Java 是两种完全不同的语言,无论在概念还是设计上。

JavaScript 与 Java 是两种完全不同的语言,无论在概念还是设计上. Java(由 Sun 发明)是更复杂的编程语言. ECMA-262 是 JavaScript 标准的官方名称. Jav ...

- weixin oauth 授权

1. 先了解下请求授权页面的构造方式: https://open.weixin.qq.com/connect/oauth2/authorize?appid=APPID&redirect_u ...

- hibernate Session一级缓存 应该注意的地方

Session缓存 Hibernate的一级缓存是由Session提供的,因此它存在于Session的整个生命周期中,当程序调用save()/update()/saveOrupdate()/get() ...

- cvsba-1.0.0/utils/test_cvsba.cpp:.......error: ‘numeric_limits’ is not a member of ‘std’... error: expected primary-expression before ‘float’....

cvsba库http://www.uco.es/investiga/grupos/ava/node/39,不知道怎么回事,记得以前编译没有错误,不知道作者是否更新了还是怎么着,新的现在有以下错误: 解 ...