Python3爬虫之爬取某一路径的所有html文件

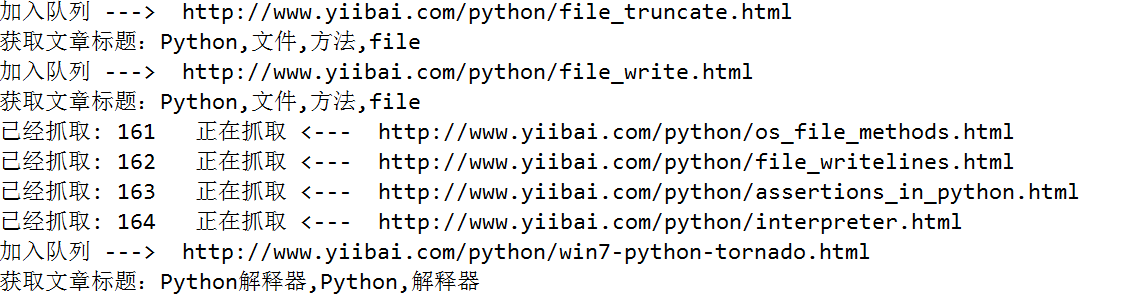

要离线下载易百教程网站中的所有关于Python的教程,需要将Python教程的首页作为种子url:http://www.yiibai.com/python/,然后按照广度优先(广度优先,使用队列;深度优先,使用栈),依次爬取每一篇关于Python的文章。为了防止同一个链接重复爬取,使用集合来限制同一个链接只处理一次。

使用正则表达式提取网页源码里边的文章标题和文章url,获取到了文章的url,使用Python根据url生成html文件十分容易。

-

import re

-

import urllib.request

-

import urllib

-

from collections import deque

-

# 保存文件的后缀

-

SUFFIX='.html'

-

# 提取文章标题的正则表达式

-

REX_TITLE=r'<title>(.*?)</title>'

-

# 提取所需链接的正则表达式

-

REX_URL=r'/python/(.+?).html'

-

# 种子url,从这个url开始爬取

-

BASE_URL='http://www.yiibai.com/python/'

-

-

-

# 将获取到的文本保存为html文件

-

def saveHtml(file_name,file_content):

-

# 注意windows文件命名的禁用符,比如 /

-

with open (file_name.replace('/','_')+SUFFIX,"wb") as f:

-

# 写文件用bytes而不是str,所以要转码

-

f.write(bytes(file_content, encoding = "utf8"))

-

# 获取文章标题

-

def getTitle(file_content):

-

linkre = re.search(REX_TITLE,file_content)

-

if(linkre):

-

print('获取文章标题:'+linkre.group(1))

-

return linkre.group(1)

-

-

# 爬虫用到的两个数据结构,队列和集合

-

queue = deque()

-

visited = set()

-

# 初始化种子链接

-

queue.append(BASE_URL)

-

count = 0

-

-

while queue:

-

url = queue.popleft() # 队首元素出队

-

visited |= {url} # 标记为已访问

-

-

print('已经抓取: ' + str(count) + ' 正在抓取 <--- ' + url)

-

count += 1

-

urlop = urllib.request.urlopen(url)

-

# 只处理html链接

-

if 'html' not in urlop.getheader('Content-Type'):

-

continue

-

-

# 避免程序异常中止

-

try:

-

data = urlop.read().decode('utf-8')

-

title=getTitle(data);

-

# 保存文件

-

saveHtml(title,data)

-

except:

-

continue

-

-

# 正则表达式提取页面中所有链接, 并判断是否已经访问过, 然后加入待爬队列

-

linkre = re.compile(REX_URL)

-

for sub_link in linkre.findall(data):

-

sub_url=BASE_URL+sub_link+SUFFIX;

-

# 已经访问过,不再处理

-

if sub_url in visited:

-

pass

-

else:

-

# 设置已访问

-

visited |= {sub_url}

-

# 加入队列

-

queue.append(sub_url)

-

print('加入队列 ---> ' + sub_url)

Python3爬虫之爬取某一路径的所有html文件的更多相关文章

- 【Python3爬虫】爬取美女图新姿势--Redis分布式爬虫初体验

一.写在前面 之前写的爬虫都是单机爬虫,还没有尝试过分布式爬虫,这次就是一个分布式爬虫的初体验.所谓分布式爬虫,就是要用多台电脑同时爬取数据,相比于单机爬虫,分布式爬虫的爬取速度更快,也能更好地应对I ...

- python3 爬虫之爬取安居客二手房资讯(第一版)

#!/usr/bin/env python3 # -*- coding: utf-8 -*- # Author;Tsukasa import requests from bs4 import Beau ...

- python3爬虫应用--爬取网易云音乐(两种办法)

一.需求 好久没有碰爬虫了,竟不知道从何入手.偶然看到一篇知乎的评论(https://www.zhihu.com/question/20799742/answer/99491808),一时兴起就也照葫 ...

- 使用htmlparse爬虫技术爬取电影网页的全部下载链接

昨天,我们利用webcollector爬虫技术爬取了网易云音乐17万多首歌曲,而且还包括付费的在内,如果时间允许的话,可以获取更多的音乐下来,当然,也有小伙伴留言说这样会降低国人的知识产权保护意识,诚 ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- from appium import webdriver 使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium)

使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium) - 北平吴彦祖 - 博客园 https://www.cnblogs.com/stevenshushu/p ...

- 使用htmlparser爬虫技术爬取电影网页的全部下载链接

昨天,我们利用webcollector爬虫技术爬取了网易云音乐17万多首歌曲,而且还包括付费的在内,如果时间允许的话,可以获取更多的音乐下来,当然,也有小伙伴留言说这样会降低国人的知识产权保护意识,诚 ...

- 【Python】【爬虫】爬取酷狗TOP500

好啦好啦,那我们来拉开我们的爬虫之旅吧~~~ 这一只小爬虫是爬取酷狗TOP500的,使用的爬取手法简单粗暴,目的是帮大家初步窥探爬虫长啥样,后期会慢慢变得健壮起来的. 环境配置 在此之前需要下载一个谷 ...

- Python爬虫之爬取站内所有图片

title date tags layut Python爬虫之爬取站内所有图片 2018-10-07 Python post 目标是 http://www.5442.com/meinv/ 如需在非li ...

随机推荐

- mysql-安全管理

一.管理用户 用户账号和信息存放在数据库中 use mysql; select user form user; mysql数据库中包含一个user的表,它包含所有用户账号. user表中右移个名为us ...

- WebView Js注入

注入前: 注入后: 主界面: package com.example.webviewjsdemo; import android.os.Bundle; import android.app.Activ ...

- Nginx服务器的反向代理proxy_pass配置方法讲解

Nginx的配置还是比较简单的,如: 1 2 3 4 location ~ /* { proxy_pass http://127.0.0.1:8008; } 或者可以 1 2 3 4 loca ...

- 6.boostTCP通信

客户端 #include <boost/asio.hpp> #include <iostream> #include <stdlib.h> using namesp ...

- 13.mutiset树每一个结点都是一个链表的指针,可以存储相同的数据

#include <iostream> //红黑树(自动保证平衡,自动生成平衡查找树) #include <set> #include <cstring> #inc ...

- 空值(NULL)和非空(NOT NULL)(十二)

不多说,直接上干货! NULL:表示字段可以为空 NOT NULL:表示字段不允许为空 注意:NULL和NOT NULL不可以同时用于一个字段上. create table tb2( username ...

- SecondaryNameNode合并元信息过程

- C# 引用DLL版本冲突

已解决,到官网上下载旧key版本,然后再重定向即可. 手动引用两个版本的DLL错误的原因是我 publicKeyToken 大小写的问题(竟然没校验~~) 但我想不明白,这样搞如果依赖一多的话,甚至那 ...

- 阿里云安装mysql数据库出现2002错误解决办法

在安装数据库的时候出现了如下错误: 解决办法如下: 1.在bin目录下 输入:kill -s 9 9907 再输入:ps -ef|grep mysql 显示如下: 2.回到lampp目录下,重启数据库 ...

- Mojo For Chromium Developers1

Mojo For Chromium Developers Overview This document contains the minimum amount of information neede ...