nodejs的简单爬虫

闲聊

看代码啦:

1.首先先安装node。

2.新建package.json:

在自己创建的一个工程目录下打开cmd ,在里面输入命令npm init

3.新建data和img文件夹

4.新建app.js

"use strict"; // 引入模块

var http = require('http');

var fs = require('fs');

var path = require('path');

var cheerio = require('cheerio'); // 爬虫的UR L信息

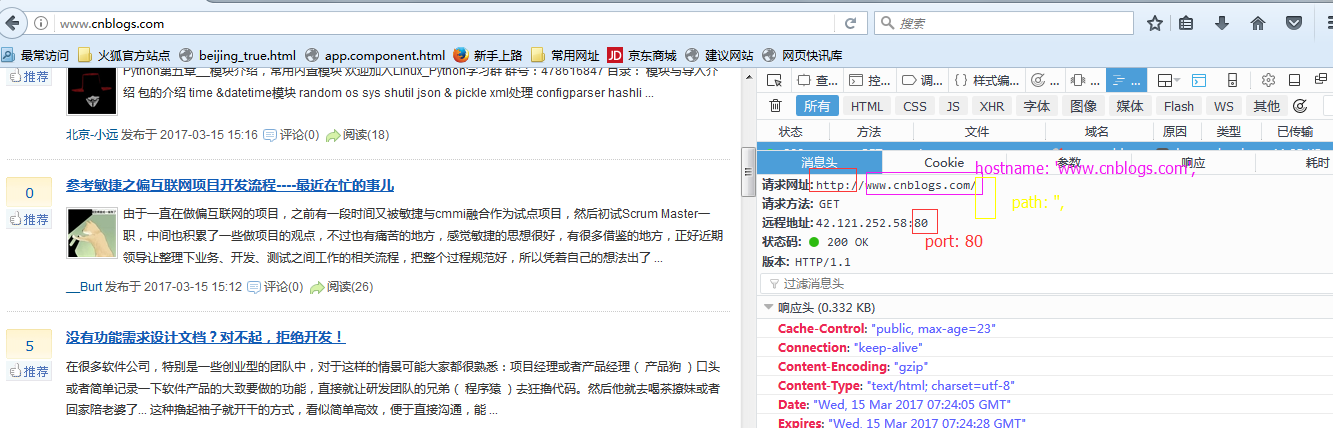

var opt = {

hostname: 'www.cnblogs.com',

path: '',

port: 80

}; // 创建http get请求

http.get(opt, function(res) {

var html = ''; // 保存抓取到的HTML源码

var blogs = []; // 保存解析HTML后的数据,即我们需要的电影信息 // 前面说过

// res 是 Class: http.IncomingMessage 的一个实例

// 而 http.IncomingMessage 实现了 stream.Readable 接口

// 所以 http.IncomingMessage 也有 stream.Readable 的事件和方法

// 比如 Event: 'data', Event: 'end', readable.setEncoding() 等 // 设置编码

res.setEncoding('utf-8'); // 抓取页面内容

res.on('data', function(chunk) {

html += chunk;

}); res.on('end', function() {

// 使用 cheerio 加载抓取到的HTML代码

// 然后就可以使用 jQuery 的方法了

// 比如获取某个class:$('.className')

// 这样就能获取所有这个class包含的内容

var $ = cheerio.load(html); // 解析页面

// 每篇文章都在 item class 中

$('#post_list .post_item .post_item_body').each(function() {

// 获取图片链接

var blog = {

title: $('.post_item_body .titlelnk', this).text(), // 获取文章标题

titleUrl: $('.post_item_body a', this).attr('href'), //文章链接地址

peopleUrl: $('.post_item_summary a', this).attr('href'), // 博客地址

peopleImg: $('.post_item_summary img', this).attr('src'),// 园友头像

intro: $('.post_item_summary', this).text(), // 获取文章简介

name: $('.post_item_foot .lightblue', this).text() // 获取文章简介

}; // 把所有文章放在一个数组里面

blogs.push(blog);

if (blog.peopleImg) {// 如果有图片则下载图片

downloadImg('img/', 'http:' + blog.peopleImg);

}

}); // 保存抓取到的文章数据

saveData('data/data.json', blogs);

});

}).on('error', function(err) {

console.log(err);

}); /**

* 保存数据到本地

*

* @param {string} path 保存数据的文件

* @param {array} blogs 文章信息数组

*/

function saveData(path, blogs) {

// 调用 fs.writeFile 方法保存数据到本地

fs.writeFile(path, JSON.stringify(blogs, null, 4), function(err) {

if (err) {

return console.log(err);

}

console.log('Data saved');

});

} /**

* 下载图片

*

* @param {string} imgDir 存放图片的文件夹

* @param {string} url 图片的URL地址

*/

function downloadImg(imgDir, url) {

http.get(url, function(res) {

var data = ''; res.setEncoding('binary'); res.on('data', function(chunk) {

data += chunk;

}); res.on('end', function() {

// 调用 fs.writeFile 方法保存图片到本地

fs.writeFile(imgDir + path.basename(url), data, 'binary',

function(err) {

if (err) {

return console.log(err);

}

console.log('Image downloaded: ', path.basename(url));

});

});

}).on('error', function(err) {

console.log(err);

});

}

5.打开cmd执行 node app.js

然后看data文件夹下会生成data.json文件,img文件夹下会生成许多图片。

补充

// 爬虫的UR L信息

var opt = {

hostname: 'www.cnblogs.com',

path: '',

port: 80

};

nodejs的简单爬虫的更多相关文章

- nodejs实现简单爬虫

nodejs结合cheerio实现简单爬虫 let cheerio = require("cheerio"), fs = require("fs"), util ...

- 用nodejs实现简单爬虫

前言 本喵最近工作中需要使用node,并也想晋升为全栈工程师,所以开始了node学习之旅,在学习过程中, 我会总结一些实用的例子,做成博文和视频教程,以实例形式来理解体会node的用法,所以跟小猫 ...

- NodeJS简单爬虫

NodeJS简单爬虫 最近一直在追火星的一本书,然后每次都要去网站看,感觉很麻烦,于是,想起用爬虫爬取章节,务实派,说干就干! 爬取思路 1.该网站的页面呈现出一定的规律 2.使用NodeJS的req ...

- 一次使用NodeJS实现网页爬虫记

前言 几个月之前,有同事找我要PHP CI框架写的OA系统.他跟我说,他需要学习PHP CI框架,我建议他学习大牛写的国产优秀框架QeePHP. 我上QeePHP官网,发现官方网站打不开了,GOOGL ...

- Python简单爬虫入门三

我们继续研究BeautifulSoup分类打印输出 Python简单爬虫入门一 Python简单爬虫入门二 前两部主要讲述我们如何用BeautifulSoup怎去抓取网页信息以及获取相应的图片标题等信 ...

- [Java]使用HttpClient实现一个简单爬虫,抓取煎蛋妹子图

第一篇文章,就从一个简单爬虫开始吧. 这只虫子的功能很简单,抓取到”煎蛋网xxoo”网页(http://jandan.net/ooxx/page-1537),解析出其中的妹子图,保存至本地. 先放结果 ...

- 简单爬虫,突破IP访问限制和复杂验证码,小总结

简单爬虫,突破复杂验证码和IP访问限制 文章地址:http://www.cnblogs.com/likeli/p/4730709.html 好吧,看题目就知道我是要写一个爬虫,这个爬虫的目标网站有 ...

- Python简单爬虫入门二

接着上一次爬虫我们继续研究BeautifulSoup Python简单爬虫入门一 上一次我们爬虫我们已经成功的爬下了网页的源代码,那么这一次我们将继续来写怎么抓去具体想要的元素 首先回顾以下我们Bea ...

- GJM : Python简单爬虫入门(二) [转载]

感谢您的阅读.喜欢的.有用的就请大哥大嫂们高抬贵手"推荐一下"吧!你的精神支持是博主强大的写作动力以及转载收藏动力.欢迎转载! 版权声明:本文原创发表于 [请点击连接前往] ,未经 ...

随机推荐

- 老司机教你下载tumblr上视频和图片的正确姿势

本文面向初学者. 很多同学问我:“我非常想学Python编程,但是找不到兴趣点”. 还有的同学呢,找到了很好的兴趣点,但是无从下手,“玄魂老师,我想下载tumblr上的视频, 怎么下载,Python能 ...

- android 获取日期

*/ public static HashMap<String, String> computeDate(){ Calendar cal =Calendar.getInstance(); ...

- 20个常用的Java程序块

1.字符串有整型的相互转换 String a = String.valueOf(2);//integer to numeric string Int i = Integer.parseInt(a);/ ...

- canvas小程序-快跑程序员

canvas不用说html5带来的好东西,游戏什么的,么么哒 记得有一天玩手机游戏,就是一个跳跃过柱子那种,其实元素很简单啊,app能开发,借助html5 canvas也可以啊, 于是就开始了. -- ...

- 【开源.NET】 分享一个前后端分离的轻量级内容管理框架

开发框架要考虑的面太多了:安全.稳定.性能.效率.扩展.整洁,还要经得起实践的考验,从零开发一个可用的框架,是很耗时费神的工作.网上很多开源的框架,为何还要自己开发?我是基于以下两点: 没找到合适的: ...

- Oracle 11g 的安装及配置详解

一.安装前的准备: 首先在这里给出本人的百度网盘的链接:http://pan.baidu.com/s/1c1WF1PQ:网速快的小伙伴建议到官网:http://www.oracle.com/techn ...

- js精要之构造函数

// 枚举对象 var obj = {} obj.name = "bob"; obj.age = "; obj.sex = "boy"; consol ...

- linux下读取系统内存的demo

#include <stdio.h> #define KIBIBYTE_SIZE 1024LL #define MEBIBYTE_SIZE 1048576LL #define GIBIBY ...

- java流和文件 保存字节级数据(写)

重要的知识点: 流的概念: 从数据源到I/O类的输入流(in) 从I/O类到数据接收器的输出流(out) I/O包含子类较多的有四大家族:InputStream,OutputStream,Re ...

- DOM解析,取得XML文件里面的信息

1 创建解析器工厂 DocumentBuilderFactory factory = DocumentBuilderFactory.newInstance(); 2 解析器工厂对象创建解析器对象 Do ...