Python Scrapy 验证码登录处理

一、Form表单分析

以豆瓣登录页面为例分析,豆瓣登录页是:https://accounts.douban.com/login,浏览器打开之后查看源码,查找登录的form表单HTML结构。如下:

包括了form_email、form_password、captcha-solution四个表单参数,需要注意之处是name,而不是id。

二、验证码图片处理

1、分析验证码参数图片的构建如下图,获取id为captcha_image的src图片即可。可以采用人工输入,或第三方图片验证码识别API获得。

2、点击该url,图片是:

获取url之后,使用urllib.request.urlretrieve(url,filename="d:/captcha.jpg")下载图片

3、接下来通过python脚本获取该图片,保存在本地,在python命令行中采用input()方式,人工识别后输入该验证码:captcha_value = credit。

三、登录参数构建

通过预先注册的用户名、密码,获得验证码,构建表单参数如下:

data={

"form_email":"XXXXX",

"form_password":"******",

"captcha-solution":captcha_value,

}

四、Session参数存储

1、cookiejar学习:http://cuiqingcai.com/968.html

2、在request参数中指定cookiejar,如下:

首次访问目标网站:

构建登录参数后,开始登录。

五、登录后数据爬取

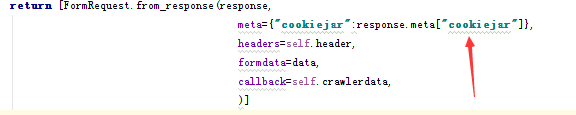

通过formdata认证通过后,在回调函数crawlerdata中处理爬取的网页,通过response对象进行数据解析。

六、主要代码

import scrapy

from scrapy.http import Request,FormRequest

import urllib.request

class DoubanSpider(scrapy.Spider):

name = "Douban"

allowed_domains = ["douban.com"] UserAgent = {"User-Agent:":"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.104 Safari/537.36 Core/1.53.2050.400 QQBrowser/9.5.10169.400"} def start_requests(self):

return [Request("https://accounts.douban.com/login",callback=self.Login,meta={"cookiejar":1})] def Login(self, response):

captcha = response.xpath("//img[@id='captcha_image']/@src").extract()

url = "https://accounts.douban.com/login"

print("正在保存验证码图片")

captchapicfile = "F:/20_Python/2000_PythonData/SelfStudy/douban/douban/captcha.png"

urllib.request.urlretrieve(captcha[0],filename = captchapicfile)

print("打开图片文件,查看验证码,输入单词......")

captcha_value = input() data = {

"form_email":"XXXX",

"form_password":"XXXX",

"captcha-solution":captcha_value,

}

print("正在登陆中……")

return [FormRequest.from_response(response,

meta={"cookiejar":response.meta["cookiejar"]},

headers = self.UserAgent,

formdata = data,

callback=self.crawlerdata,

)] def crawlerdata(self,response):

print("完成登录.........")

title = response.xpath("/html/head/title/text()").extract()

content2 = response.xpath("//meta[@name='description']/@content").extract()

print(title[0])

print(content2[0])

Python Scrapy 验证码登录处理的更多相关文章

- scrapy爬取验证码登录网页

scrapy 验证码登录程序, https://accounts.douban.com/login # -*- coding: utf-8 -*- import scrapy import urlli ...

- python爬虫之scrapy模拟登录

背景: 初来乍到的pythoner,刚开始的时候觉得所有的网站无非就是分析HTML.json数据,但是忽略了很多的一个问题,有很多的网站为了反爬虫,除了需要高可用代理IP地址池外,还需要登录.例如知乎 ...

- python爬虫scrapy之登录知乎

下面我们看看用scrapy模拟登录的基本写法: 注意:我们经常调试代码的时候基本都用chrome浏览器,但是我就因为用了谷歌浏览器(它总是登录的时候不提示我用验证码,误导我以为登录时不需要验证码,其实 ...

- Python - WebDriver 识别登录验证码

Python - WebDriver 识别登录验证码 没什么可说的直接上代码! #-*-coding:utf-8-*- # Time:2017/9/29 7:16 # Author:YangYangJ ...

- Python 实现简单图片验证码登录

朋友说公司要在测试环境做接口测试,登录时需要传入正确的图片的验证码,本着懒省事的原则,推荐他把测试环境的图片验证码写死,我们公司也是这么做的^_^.劝说无果/(ㄒoㄒ)/~~,只能通过 OCR 技术来 ...

- python接口自动化(Cookie_绕过验证码登录)

python接口自动化(Cookie_绕过验证码登录) 有些登录的接口会有验证码,例如:短信验证码,图形验证码等,这种登录的验证码参数可以从后台获取(或者最直接的可查数据库) 获取不到也没关系,可以 ...

- python自动化实现验证码登录过程

(自动化实现验证码登录,这里内容是入坑后,整合了几个文档的内容)|以下模块是使用时需要用到的首先:安装pillow库,它的作用是对图片进行简单的处理,在pytharm中使用pip install pi ...

- Python验证码登录(Tesseract安装配置)

1.安装py库:pytesseract,PIL pip install pytesseract pip install PILLOW 如果安装时,出现权限不足: pip install --user ...

- python scrapy版 极客学院爬虫V2

python scrapy版 极客学院爬虫V2 1 基本技术 使用scrapy 2 这个爬虫的难点是 Request中的headers和cookies 尝试过好多次才成功(模拟登录),否则只能抓免费课 ...

随机推荐

- java基础学习总结——GUI编程(一) 还未仔细阅读

一.AWT介绍

- USES_CONVERSION的使用和注意

USES_CONVERSION是用来转换类型的,比如我们很常见的问题: 在Socket编程时候,我们的IP地址从界面上输进去一般都使用CString类型的,可是在SOCKADDR_IN中的inet_a ...

- Docker入门二

容器管理 1.docker create创建一个容器,但容器并没启动,就和我们创建虚拟机一样,创建了虚拟机后没启动 [root@centos-02 ~]# docker create -it cent ...

- suid/guid用法 suid/guid详细解析

suid/guid 我们在前面曾经提到过s u i d和g u i d.这种权限位近年来成为一个棘手的问题.很多系统供应商不允许实现这一位,或者即使它被置位,也完全忽略它的存在,因为它会带来安全性风险 ...

- Atitit.注解and属性解析(2)---------语法分析 生成AST attilax总结 java .net

Atitit.注解and属性解析(2)---------语法分析 生成AST attilax总结 java .net 1. 应用场景:::因为要使用ui化的注解 1 2. 使用解释器方式来实现生成 ...

- Hystrix的用法demo

1.引入依赖 <dependency> <groupId>org.springframework.cloud</groupId> <artifactId> ...

- linux下tar.gz、tar、bz2、zip等解压缩、压缩命令小结(转载)

Linux下最常用的打包程序就是tar了,使用tar程序打出来的包我们常称为tar包,tar包文件的命令通常都是以.tar结尾的.生成tar包后,就可以用其它的程序来进 行压缩了,所以首先就来讲讲ta ...

- JS - caller,callee,call,apply

在提到上述的概念之前,首先想说说javascript中函数的隐含参数:arguments Arguments : 该对象代表正在执行的函数和调用它的函数的参数. [function.]argument ...

- Unity3D学习(九):C#和C++的相互调用

前言 不知不觉已经一年了,这一年来一直忙于公司项目疯狂加班,很少有自己的时间写下东西.不过好在项目最近也步入正轨了,正好抽空写点东西记录下学到的一些东西. 公司项目是一个端游IP移植手游,端游是基于C ...

- [debootstrap]制作基于arm平台的debian文件系统

之前用过的Linux文件系统是直接busybox制作的,而当前使用的是debian的Jessie,看了一些博客后,了解到如果使用debian,那么直接使用debootstrap来构建文件系统即可 -- ...