可视化自编码器训练结果&稀疏自编码器符号一览表

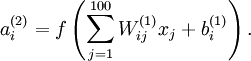

训练完(稀疏)自编码器,我们还想把这自编码器学习到的函数可视化出来,好弄明白它到底学到了什么。我们以在10×10图像(即n=100)上训练自编码器为例。在该自编码器中,每个隐藏单元i对如下关于输入的函数进行计算:

我们将要可视化的函数,就是上面这个以2D图像为输入,并由隐藏单元i计算出来的函数。它是依赖于参数 的(暂时忽略偏置项bi)。需要注意的是,

的(暂时忽略偏置项bi)。需要注意的是, 可看作输入

可看作输入 的非线性特征。不过还有个问题:什么样的输入图像x可以让可让

的非线性特征。不过还有个问题:什么样的输入图像x可以让可让 得到最大程度的激励?(通俗一点说,隐藏单元

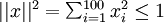

得到最大程度的激励?(通俗一点说,隐藏单元 要找个什么样的特征?)。这里我们必须给x加个约束,否则会得到平凡解。若假设输入有范数约束

要找个什么样的特征?)。这里我们必须给x加个约束,否则会得到平凡解。若假设输入有范数约束 ,则可证。令隐藏单元i得到最大激励的输入应该由下面公式计算的像素

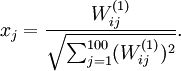

,则可证。令隐藏单元i得到最大激励的输入应该由下面公式计算的像素 给出(共需计算100个像素,j=1,...,100):

给出(共需计算100个像素,j=1,...,100):

当我们用上式算出各像素的值、把它们组成一幅图像、并将图像呈现在我们面前之时,隐藏单元i所追寻特征的真正含义也渐渐明朗起来???。

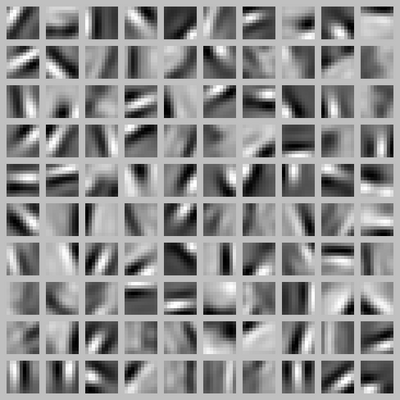

假如我们训练的自编码器有100个隐藏单元,可视化结果就会包含100幅这样的图像——每个隐藏单元都对应一幅图像。审视这100幅图像,我们可以试着体会这些隐藏单元学出来的整体效果是什么样的。

当我们对稀疏自编码器(100个隐藏单元,在10X10像素的输入上训练 )进行上述可视化处理之后,结果如下所示:

上图的每一个小方块都给出可一个(带有有界范数的)输入图像x,它可以使这100个隐藏单元中的某一个获得最大激励。我们可以看到,不同的隐藏单元学会了在图像的不同位置和方向进行边缘检测。

显而易见,这些特征对物体识别等计算视觉任务是十分有用的。若将其用于其他输入域(如音频),该算法也可学到对这些输入域有用的表示或特征。

稀疏自编码器符号一览表

下面是我们在推导sparse autoencoder时使用的符号一览表:

| 符号 | 含义 |

|

训练样本的输入特征, . . |

|

输出值/目标值. 这里  可以是向量. 在autoencoder中, 可以是向量. 在autoencoder中, . . |

|

第  个训练样本 个训练样本 |

|

输入为  时的假设输出,其中包含参数 时的假设输出,其中包含参数 . 该输出应当与目标值 . 该输出应当与目标值  具有相同的维数. 具有相同的维数. |

|

连接第  层 层  单元和第 单元和第  层 层  单元的参数. 单元的参数. |

|

第  层 层  单元的偏置项. 也可以看作是连接第 单元的偏置项. 也可以看作是连接第  层偏置单元和第 层偏置单元和第  层 层  单元的参数. 单元的参数. |

|

参数向量. 可以认为该向量是通过将参数 组合展开为一个长的列向量而得到. 组合展开为一个长的列向量而得到. |

|

网络中第  层 层  单元的激活(输出)值. 单元的激活(输出)值.

另外,由于 |

|

激活函数. 本文中我们使用  . . |

|

第  层 层  单元所有输入的加权和. 因此有 单元所有输入的加权和. 因此有  . . |

|

学习率 |

|

第  层的单元数目(不包含偏置单元). 层的单元数目(不包含偏置单元). |

|

网络中的层数. 通常  层是输入层, 层是输入层, 层是输出层. 层是输出层. |

|

权重衰减系数. |

|

对于一个autoencoder,该符号表示其输出值;亦即输入值  的重构值. 与 的重构值. 与  含义相同. 含义相同. |

|

稀疏值,可以用它指定我们所需的稀疏程度 |

|

(sparse autoencoder中)隐藏单元  的平均激活值. 的平均激活值. |

|

(sparse autoencoder目标函数中)稀疏值惩罚项的权重. |

可视化自编码器训练结果&稀疏自编码器符号一览表的更多相关文章

- 深度学习入门教程UFLDL学习实验笔记一:稀疏自编码器

UFLDL即(unsupervised feature learning & deep learning).这是斯坦福网站上的一篇经典教程.顾名思义,你将在这篇这篇文章中学习到无监督特征学习和 ...

- DL二(稀疏自编码器 Sparse Autoencoder)

稀疏自编码器 Sparse Autoencoder 一神经网络(Neural Networks) 1.1 基本术语 神经网络(neural networks) 激活函数(activation func ...

- Deep Learning学习随记(一)稀疏自编码器

最近开始看Deep Learning,随手记点,方便以后查看. 主要参考资料是Stanford 教授 Andrew Ng 的 Deep Learning 教程讲义:http://deeplearnin ...

- Sparse autoencoder implementation 稀疏自编码器实现

任务:在这个问题中,你将实现稀疏自编码器算法,并且展示它怎么发现边缘是自然图像的一个好的表示. 在文件 sparseae_exercise.zip中,我们已经提供了一些Matlab中的初始代码,你应该 ...

- 稀疏自编码器及TensorFlow实现

自动编码机更像是一个识别网络,只是简单重构了输入.而重点应是在像素级重构图像,施加的唯一约束是隐藏层单元的数量. 有趣的是,像素级重构并不能保证网络将从数据集中学习抽象特征,但是可以通过添加更多的约束 ...

- UFLDL教程(一)---稀疏自编码器

神经网络模型 简单的神经网络 前向传播 代价函数 对于单个例子 .其代价函数为: 给定一个包括m个例子的数据集,我们能够定义总体代价函数为: 以上公式中的第一项 是一个均方差项. 第二项是一个规则化 ...

- tesorflow - create neural network+结果可视化+加速神经网络训练+Optimizer+TensorFlow

以下仅为了自己方便查看,绝大部分参考来源:莫烦Python,建议去看原博客 一.添加层 def add_layer() 定义 add_layer()函数 在 Tensorflow 里定义一个添加层的函 ...

- sklearn 可视化模型的训练测试收敛情况和特征重要性

show the code: # Plot training deviance def plot_training_deviance(clf, n_estimators, X_test, y_test ...

- Deep Learning 教程(斯坦福深度学习研究团队)

http://www.zhizihua.com/blog/post/602.html 说明:本教程将阐述无监督特征学习和深度学习的主要观点.通过学习,你也将实现多个功能学习/深度学习算法,能看到它们为 ...

随机推荐

- Python前戏

1.Python解释器 官网:https://www.python.org/getit/ 因为Python的3.0和2.0版本有所差别,所以根据个人学习方向分别下载安装. 安装验证:打开命令提示符,执 ...

- python中利用少量代码快速实现从类对象中抽取所需属性的一种实践

项目中有可能会碰到这样一种场景: 根据一个id,查询得到和id对应的完整数据信息存储对象,比如书籍id到书籍详细信息,用户id到用户详细信息等,详细信息字段可能包括几十甚至上百个数据字段,真正需要返回 ...

- [hdu 6184 Counting Stars(三元环计数)

hdu 6184 Counting Stars(三元环计数) 题意: 给一张n个点m条边的无向图,问有多少个\(A-structure\) 其中\(A-structure\)满足\(V=(A,B,C, ...

- rm 删除不掉文件,报错解决 以及 chattr的介绍

rm 强制删除一个文件 居然删除不掉! 出现这个错误: rm: cannot remove ‘default/.user.ini’: Operation not permitted 原来呀: 然后呢 ...

- 一、Lambda表达式

一.Lambda是什么? Lambda是一个匿名函数,我们可以把Lambda理解为是一段可以传递的代码.可以写出简洁.灵活的代码.作为一种更紧凑的代码风格,使java的语言表达能力得到提升. 二.La ...

- MyBatis-自定义结果映射规则

1.自定义结果集映射规则 ①查询 <!-- public Employee getEmpById(Integer id); --> <select id="getEmpBy ...

- Windows系统常用修复命令 无须重装系统

1.0 netsh int ipv4 reset 2.0 netsh winsock reset winsock是Windows网络编程接口,winsock工作在应用层,它提供与底层传输协议无关的高层 ...

- 软件测试的基础-摘自《selenium实践-基于电子商务平台》

软件测试的方法 一.等价类划分法 等价类划分法是把所有可能的输入数据,即程序的输入域划分成若干部分(子集),然后从每一个子集中选取少量具有代表性的数据作为测试用例. 有两种不同的情况:有效等价和无效等 ...

- lintcode First Unique Number In Stream

First Unique Number In Stream 描述: Given a continuous stream of numbers, write a function that return ...

- lintcode 平面列表

问题描述: 给定一个列表,该列表中的每个要素要么是个列表,要么是整数.将其变成一个只包含整数的简单列表. 样例: 给定 [1,2,[1,2]],返回 [1,2,1,2]. 给定 [4,[3,[2,[1 ...

.

.