二十二 Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy模拟登陆和知乎倒立文字验证码识别

第一步。首先下载,大神者也的倒立文字验证码识别程序

下载地址:https://github.com/muchrooms/zheye

注意:此程序依赖以下模块包

Keras==2.0.1

Pillow==3.4.2

jupyter==1.0.0

matplotlib==1.5.3

numpy==1.12.1

scikit-learn==0.18.1

tensorflow==1.0.1

h5py==2.6.0

numpy-1.13.1+mkl

我们用豆瓣园来加速安以上依赖装如:

pip install -i https://pypi.douban.com/simple h5py==2.6.0

如果是win系统,可能存在安装失败的可能,如果那个包安装失败,就到 http://www.lfd.uci.edu/~gohlke/pythonlibs/ 找到win对应的版本下载到本地安装,如:

pip install h5py-2.7.0-cp35-cp35m-win_amd64.whl

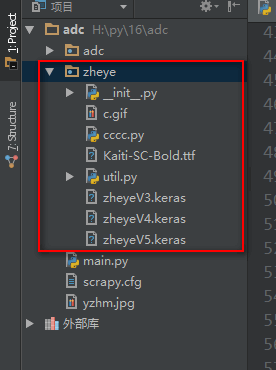

第二步,将者也的,验证码识别程序的zheye文件夹放到工程目录里

第三步,爬虫实现

start_requests()方法,起始url函数,会替换start_urls

Request()方法,get方式请求网页

url=字符串类型url

headers=字典类型浏览器代理

meta=字典类型的数据,会传递给回调函数

callback=回调函数名称

scrapy.FormRequest()post方式提交数据

url=字符串类型url

headers=字典类型浏览器代理

meta=字典类型的数据,会传递给回调函数

callback=回调函数名称

formdata=字典类型,要提交的数据字段

response.headers.getlist('Set-Cookie') 获取响应Cookies

response.request.headers.getlist('Cookie') 获取请求Cookies

# -*- coding: utf-8 -*-

import scrapy

from scrapy.http import Request,FormRequest

import re class PachSpider(scrapy.Spider): #定义爬虫类,必须继承scrapy.Spider

name = 'pach' #设置爬虫名称

allowed_domains = ['zhihu.com'] #爬取域名

# start_urls = [''] #爬取网址,只适于不需要登录的请求,因为没法设置cookie等信息 header = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:54.0) Gecko/20100101 Firefox/54.0'} #设置浏览器用户代理 def start_requests(self): #起始url函数,会替换start_urls

"""第一次请求一下登录页面,设置开启cookie使其得到cookie,设置回调函数"""

return [Request(

url='https://www.zhihu.com/#signin',

headers=self.header,

meta={'cookiejar':1}, #开启Cookies记录,将Cookies传给回调函数

callback=self.parse

)] def parse(self, response):

# 响应Cookies

Cookie1 = response.headers.getlist('Set-Cookie') #查看一下响应Cookie,也就是第一次访问注册页面时后台写入浏览器的Cookie

print('后台首次写入的响应Cookies:',Cookie1) #获取xsrf密串

xsrf = response.xpath('//input[@name="_xsrf"]/@value').extract()[0]

print('获取xsrf密串:' + xsrf) #获取验证码

import time

t = str(int(time.time()*1000))

captcha_url = 'https://www.zhihu.com/captcha.gif?r={0}&type=login&lang=cn'.format(t) #构造验证码请求地址

yield Request(url=captcha_url, #请求验证码图片

headers=self.header,

meta={'cookiejar':response.meta['cookiejar'],'xsrf':xsrf}, #将Cookies和xsrf密串传给回调函数

callback=self.post_tj

) def post_tj(self, response):

with open('yzhm.jpg','wb') as f: #打开图片句柄

f.write(response.body) #将验证码图片写入本地

f.close() #关闭句柄 #--------------------------------------------者也验证码识别------------------------------------------ from zheye import zheye #导入者也倒立文字验证码识别模块对象

z = zheye() #实例化对象

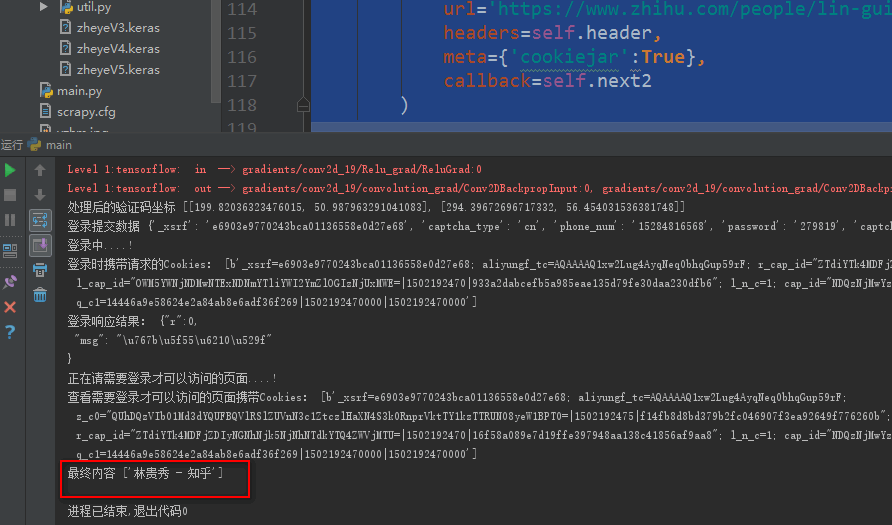

positions = z.Recognize('yzhm.jpg') #将验证码本地路径传入Recognize方法识别,返回倒立图片的坐标

# print(positions) #默认倒立文字的y坐标在前,x坐标在后 #知乎网要求的倒立文字坐标是x轴在前,y轴在后,所以我们需要定义一个列表来改变默认的,倒立文字坐标位置

pos_arr = []

if len(positions) == 2:

if positions[0][1] > positions[1][1]: #判断列表里第一个元祖里的第二个元素如果大于,第二个元祖里的第二个元素

pos_arr.append([positions[1][1],positions[1][0]])

pos_arr.append([positions[0][1], positions[0][0]])

else:

pos_arr.append([positions[0][1], positions[0][0]])

pos_arr.append([positions[1][1], positions[1][0]])

else:

pos_arr.append([positions[0][1], positions[0][0]]) print('处理后的验证码坐标',pos_arr) # --------------------------------------------者也验证码识别结束------------------------------------------ if len(pos_arr) == 2:

data = { # 设置用户登录信息,对应抓包得到字段

'_xsrf': response.meta['xsrf'],

'password': '279819',

'captcha': '{"img_size":[200,44],"input_points":[[%.2f,%f],[%.2f,%f]]}' %(

pos_arr[0][0] / 2, pos_arr[0][1] / 2, pos_arr[1][0] / 2, pos_arr[1][1] / 2), #因为验证码识别默认是400X88的尺寸所以要除以2

'captcha_type': 'cn',

'phone_num': '15284816568'

}

else:

data = { # 设置用户登录信息,对应抓包得到字段

'_xsrf': response.meta['xsrf'],

'password': '279819',

'captcha': '{"img_size":[200,44],"input_points":[[%.2f,%f]]}' %(

pos_arr[0][0] / 2, pos_arr[0][1] / 2),

'captcha_type': 'cn',

'phone_num': '15284816568'

} print('登录提交数据',data) print('登录中....!')

"""第二次用表单post请求,携带Cookie、浏览器代理、用户登录信息,进行登录给Cookie授权"""

return [scrapy.FormRequest(

url='https://www.zhihu.com/login/phone_num', #真实post地址

meta={'cookiejar':response.meta['cookiejar']}, #接收第传过来的Cookies

headers=self.header,

formdata=data,

callback=self.next

)] def next(self,response):

# 请求Cookie

Cookie2 = response.request.headers.getlist('Cookie')

print('登录时携带请求的Cookies:',Cookie2) jieg = response.body.decode("utf-8") #登录后可以查看一下登录响应信息

print('登录响应结果:',jieg) print('正在请需要登录才可以访问的页面....!') """登录后请求需要登录才能查看的页面,如个人中心,携带授权后的Cookie请求"""

yield Request(

url='https://www.zhihu.com/people/lin-gui-xiu-41/activities',

headers=self.header,

meta={'cookiejar':True},

callback=self.next2

) def next2(self,response):

# 请求Cookie

Cookie3 = response.request.headers.getlist('Cookie')

print('查看需要登录才可以访问的页面携带Cookies:',Cookie3) leir = response.xpath('/html/head/title/text()').extract() #得到个人中心页面

print('最终内容',leir)

# print(response.body.decode("utf-8"))

二十二 Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy模拟登陆和知乎倒立文字验证码识别的更多相关文章

- 第三百四十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy模拟登陆和知乎倒立文字验证码识别

第三百四十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy模拟登陆和知乎倒立文字验证码识别 第一步.首先下载,大神者也的倒立文字验证码识别程序 下载地址:https://gith ...

- 二十九 Python分布式爬虫打造搜索引擎Scrapy精讲—selenium模块是一个python操作浏览器软件的一个模块,可以实现js动态网页请求

selenium模块 selenium模块为第三方模块需要安装,selenium模块是一个操作各种浏览器对应软件的api接口模块 selenium模块是一个操作各种浏览器对应软件的api接口模块,所以 ...

- 二十六 Python分布式爬虫打造搜索引擎Scrapy精讲—通过downloadmiddleware中间件全局随机更换user-agent浏览器用户代理

downloadmiddleware介绍中间件是一个框架,可以连接到请求/响应处理中.这是一种很轻的.低层次的系统,可以改变Scrapy的请求和回应.也就是在Requests请求和Response响应 ...

- 二十八 Python分布式爬虫打造搜索引擎Scrapy精讲—cookie禁用、自动限速、自定义spider的settings,对抗反爬机制

cookie禁用 就是在Scrapy的配置文件settings.py里禁用掉cookie禁用,可以防止被通过cookie禁用识别到是爬虫,注意,只适用于不需要登录的网页,cookie禁用后是无法登录的 ...

- 二十五 Python分布式爬虫打造搜索引擎Scrapy精讲—Requests请求和Response响应介绍

Requests请求 Requests请求就是我们在爬虫文件写的Requests()方法,也就是提交一个请求地址,Requests请求是我们自定义的 Requests()方法提交一个请求 参数: ur ...

- 二十四 Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫和反爬的对抗过程以及策略—scrapy架构源码分析图

1.基本概念 2.反爬虫的目的 3.爬虫和反爬的对抗过程以及策略 scrapy架构源码分析图

- Python分布式爬虫打造搜索引擎完整版-基于Scrapy、Redis、elasticsearch和django打造一个完整的搜索引擎网站

Python分布式爬虫打造搜索引擎 基于Scrapy.Redis.elasticsearch和django打造一个完整的搜索引擎网站 https://github.com/mtianyan/Artic ...

- 四十四 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

1.elasticsearch(搜索引擎)的查询 elasticsearch是功能非常强大的搜索引擎,使用它的目的就是为了快速的查询到需要的数据 查询分类: 基本查询:使用elasticsearch内 ...

- 三十六 Python分布式爬虫打造搜索引擎Scrapy精讲—利用开源的scrapy-redis编写分布式爬虫代码

scrapy-redis是一个可以scrapy结合redis搭建分布式爬虫的开源模块 scrapy-redis的依赖 Python 2.7, 3.4 or 3.5,Python支持版本 Redis & ...

随机推荐

- memcache服务端与客户端的安装部署

1)安装memcached前需要先安装libevent [root@aliyun tools]# tar -zxf libevent-1.4.13-stable.tar.gz [root@aliyun ...

- vue2+koa2+mongodb分页

后端 const Koa = require('koa2'); const Router = require('koa-router'); const Monk = require('monk');/ ...

- hdu5558 Alice's Classified Message

地址:http://acm.split.hdu.edu.cn/showproblem.php?pid=5558 题目: Alice's Classified Message Time Limit: 1 ...

- ACM-ICPC 2018 南京赛区网络预赛 - L Magical Girl Haze (分层迪杰斯特拉)

题意:N个点,M条带权有向边,求可以免费K条边权值的情况下,从点1到点N的最短路. 分析:K<=10,用dist[i][j]表示从源点出发到点i,免费j条边的最小花费.在迪杰斯特拉的dfs过程中 ...

- CDH5离线安装简记

需要的介质如下:CM: cloudera-manager-el6-cm5.4.3_x86_64.tar.gzCDH parcel: CDH-5.4.0-1.cdh5.4.0.p0.27-el6.par ...

- 关于URL和http协议,http消息格式

转自:http://crystal2012.iteye.com/blog/1447845 在WWW(全球资讯网)中想要连结到某个网页,便需要给浏览器一个位址,而URL在此的功能就是告知浏览器某个资源在 ...

- Linux学习笔记之Linux修改或增加ssh端口

1.什么是SSH SSH 为 Secure Shell 由 IETF 的网络工作小组(Network Working Group)所制定: SSH 是建立在应用层和传输层基础上的一种安全协议. SSH ...

- 枚举转SelectList扩展方法

public enum Avbc { Red=1, Blue=2, Whilt=3, Black=4 } public st ...

- 一键安装lnmp(2)

all(){path=`pwd`cd $pathechoecho "exclude=*.i386 *.i686" >> /etc/yum.confrpm -ivh ht ...

- Jquery13 Ajax 进阶

学习要点: 1.加载请求 2.错误处理 3.请求全局事件 4.JSON 和 JSONP 5.jqXHR 对象 一.加载请求 在 Ajax 异步发送请求时,遇到网速较慢的情况,就会出现请求时间较长的问题 ...