神经网络一(用tensorflow搭建简单的神经网络并可视化)

微信公众号关注我,更多计算机知识告诉你!1 import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt #创建一个input数据,-1到1之间300个数,[:,np.newaxis]把x_data变成300维的

x_data=np.linspace(-1,1,300)[:,np.newaxis]

#添加噪点,把他变得更像真实数据

noise=np.random.normal(0,0.05,x_data.shape)

#创建一个input的数据

y_data=np.square(x_data)-0.5+noise

#这里定义了一个添加神经层的方法

def add_layer(inputs,in_size,out_size,n_layer,activation_function=None):

#定义layer_name是为了在可视化中可以看到这个模块的名字,这里传入的

#n_layer代表我们现在正创建第几个神经层

layer_name='layer%s' % n_layer

#在这里是我们layer_name模块,可视化的时候我们可以看到结果

with tf.name_scope(layer_name):

with tf.name_scope('weights'):

#这里定义的weights模块中,tf.random_normal方法从正态分布中输出随机值

#输出形状为[in_size,out_size]的矩阵,令其为初始值,名字为W

Weights=tf.Variable(tf.random_normal([in_size,out_size]),name='W')

#在这里将这个模块命名为layer_name+weights

#并用tf.summary.histogram输入到日志文件中

tf.summary.histogram(layer_name+'/weights',Weights) with tf.name_scope('biases'):

#在这里另一个形状为[1,out_size]的矩阵为初始值

#矩阵的每一个元素均为初始值

biases=tf.Variable(tf.zeros([1,out_size])+0.1,name='b')

tf.summary.histogram(layer_name+'/biases',biases) with tf.name_scope('Wx_plus_b'):

#这里定义的模块为Wx_plus_b

#之后加上biases时是矩阵的每一行都去加biases这个数组

Wx_plus_b=tf.matmul(inputs,Weights)+biases

#在这里如果没有激活函数则直接输出

#若有激活函数则用激活函数,然后给模块命名

if activation_function is None:

outputs=Wx_plus_b

else:

outputs=activation_function(Wx_plus_b)

tf.summary.histogram(layer_name+'/outputs',outputs)

#sess=tf.Session()

return outputs

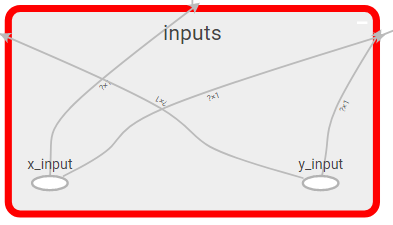

with tf.name_scope('inputs'):

#这里用tf.placeholder定义一个参数,方便后续为其传值

xs=tf.placeholder(tf.float32,[None,1],name='x_input')

ys=tf.placeholder(tf.float32,[None,1],name='y_input')

#这里第一层输入参数inputs=xs,Weights是一个1*10的矩阵

#激活函数为relu

l1=add_layer(xs,1,10,n_layer=1,activation_function=tf.nn.relu)

#这里第二层输入参数inputs=l1,Weights是一个1*10的矩阵

#激活函数为空

prediction=add_layer(l1,10,1,n_layer=2,activation_function=None)

#这里定义了一个损失函数,

with tf.name_scope('loss'):

loss=tf.reduce_mean(tf.reduce_sum(tf.square(ys-prediction),reduction_indices=[1]))

tf.summary.scalar('loss',loss)

#神经网络优化器,这里使用了梯度下降法

#使用优化器去减少每一步的误差

with tf.name_scope('train'):

train_step=tf.train.GradientDescentOptimizer(0.1).minimize(loss)

sess=tf.Session()

merged= tf.summary.merge_all()

#这里将神经网络结构输入到一个文件中

writer=tf.summary.FileWriter("logs/",sess.graph)

sess=tf.Session()

merged= tf.summary.merge_all()

#这里将神经网络结构输入到一个文件中

writer=tf.summary.FileWriter("logs/",sess.graph) sess.run(tf.global_variables_initializer())

for i in range(1000):

#开始训练,设置迭代次数为1000次

#这里输入的x_data参数为一个300*1的矩阵

#先在l1网络层运算,将300*10的矩阵Wx_plus_b输入到激活函数Relu中,然后输出

#输出结果也为300*10的矩阵

#然后在输出层prediction

#输入为300*10的矩阵,Weights为10*1的矩阵

#相乘后为300*1的矩阵然后加上1*1的biases

#输出为300*91的矩阵

#然后与之前的y_data去做loss误差分析

#计算误差

sess.run(train_step,feed_dict={xs:x_data,ys:y_data})

if i % 50==0:

#每迭代50次输出带日志文件,将所有日志文件都merged合并起来

result=sess.run(merged,feed_dict={xs:x_data,ys:y_data})

writer.add_summary(result,i)

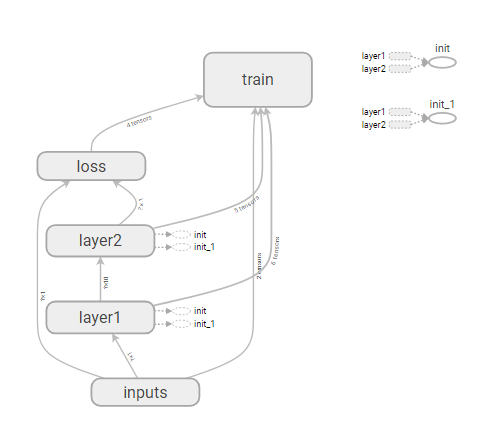

博文中的图都是tensorflow自带的可视化部件tensorboard展示出来的。我们用

writer=tf.summary.FileWriter("logs/",sess.graph)

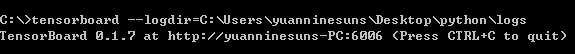

这个语句将结构输出到文件中,打开命令行,敲上语句

tensorboard --logdir=C:\Users\yuanninesuns\Desktop\python\logs

将控制台输出的这个网址敲到浏览器上就能看到可视化内容。

神经网络一(用tensorflow搭建简单的神经网络并可视化)的更多相关文章

- [DL学习笔记]从人工神经网络到卷积神经网络_3_使用tensorflow搭建CNN来分类not_MNIST数据(有一些问题)

3:用tensorflow搭个神经网络出来 为什么用tensorflow呢,应为谷歌是亲爹啊,虽然有些人说caffe更适合图像啊mxnet效率更高等等,但爸爸就是爸爸,Android都能那么火,一个道 ...

- 用pytorch1.0快速搭建简单的神经网络

用pytorch1.0搭建简单的神经网络 import torch import torch.nn.functional as F # 包含激励函数 # 建立神经网络 # 先定义所有的层属性(__in ...

- 用pytorch1.0搭建简单的神经网络:进行多分类分析

用pytorch1.0搭建简单的神经网络:进行多分类分析 import torch import torch.nn.functional as F # 包含激励函数 import matplotlib ...

- 用pytorch1.0搭建简单的神经网络:进行回归分析

搭建简单的神经网络:进行回归分析 import torch import torch.nn.functional as F # 包含激励函数 import matplotlib.pyplot as p ...

- 深度学习(五)基于tensorflow实现简单卷积神经网络Lenet5

原文作者:aircraft 原文地址:https://www.cnblogs.com/DOMLX/p/8954892.html 参考博客:https://blog.csdn.net/u01287127 ...

- (转)一文学会用 Tensorflow 搭建神经网络

一文学会用 Tensorflow 搭建神经网络 本文转自:http://www.jianshu.com/p/e112012a4b2d 字数2259 阅读3168 评论8 喜欢11 cs224d-Day ...

- 用Tensorflow搭建神经网络的一般步骤

用Tensorflow搭建神经网络的一般步骤如下: ① 导入模块 ② 创建模型变量和占位符 ③ 建立模型 ④ 定义loss函数 ⑤ 定义优化器(optimizer), 使 loss 达到最小 ⑥ 引入 ...

- 基于tensorflow搭建一个神经网络

一,tensorflow的简介 Tensorflow是一个采用数据流图,用于数值计算的 开源软件库.节点在图中表示数字操作,图中的线 则表示在节点间相互联系的多维数据数组,即张量 它灵活的架构让你可以 ...

- 一文学会用 Tensorflow 搭建神经网络

http://www.jianshu.com/p/e112012a4b2d 本文是学习这个视频课程系列的笔记,课程链接是 youtube 上的,讲的很好,浅显易懂,入门首选, 而且在github有代码 ...

随机推荐

- ZeroMQ API(一) 总序

序 zeromq是一个轻量级的消息库.它扩展了标准的套接字接口,其特性与传统的消息中间件不同,zeromq提供异步消息队列.多消息传递模式.消息过滤(订阅).无缝访问多个传输协议等的抽象. 本系列AP ...

- 配置ODBC DSN数据源,导出数据库数据到Excel过程记录

一.前言 工作中我们可能遇到这样的需要:查询数据库中的信息,并将结果导出到Excel文件.这本来没什么,但数据量比较大时,用PLSQL.toad导出Excel会出现内存不足等情况,使用odbc+Mic ...

- Python概念-__del__的悲伤

__del__了不得了,这个是在回收实例化对象时触发执行的方法 每当del 实例化对象时会触发 或者是程序结束时,会触发,总之就是实例化对象失效时都会执行__del__方法 代码示例: class F ...

- Linux基础-awk、变量、运算符、if

awk 程序的运行就是一些列状态的变量->用变量值的变化去表示 以字母或下划线开头,剩下的部分可以是:字母.数字.下划线. 最好遵循下述规范: 1.以字母开头2.使用中划线或者下划线做单词的连接 ...

- 快速修改Matlab默认启动路径(Windows/Mac)

如何修改Matlab启动路径/Windows or Mac 控制台内输入一下两行命令,之后重启MATLAB即可 newpath = '你所要设定的路径'; userpath(newpath) ...

- Anaconda3+python3环境下如何创建python2环境(win+Linux下适用,同一个anaconda下py2/3共存)

本人之前已经在anaconda环境下已经安装了python3的环境,现在因为一些需求,要安装python2环境 1.打开anaconda的anaconda prompt查看当前环境: conda in ...

- dropload的使用记录

这次做一个H5的页面,需要用到上拉加载,下拉刷新的功能,在网上看到ximen写的dropload.js可以满足需求(此处致谢作者),但是用的时候还是踩了一些坑,这里记录下来备忘. 一些小问题:1. m ...

- RabbitMQ--Publish/Subscribe(四)

先前例子中,我们创建了一个简单的日志系统,广播messages到consumer接收方. 但如果有日志错误级别的,不同的consumer接收不同错误级别的信息.比如consumer1接收info和wa ...

- 11 The Go Memory Model go语言内置模型

The Go Memory Model go语言内置模型 Version of May 31, 2014 Introduction 介绍 Advice 建议 Happens Before 在发生之前 ...

- Linux下实现ping功能

实现ping功能,就肯定要用到ping命令,那么在Linux下ping命令为: ping [-dfnqrRv][-c<完成次数>][-i<间隔秒数>][-I<网络界面&g ...