Spark 系列(七)—— 基于 ZooKeeper 搭建 Spark 高可用集群

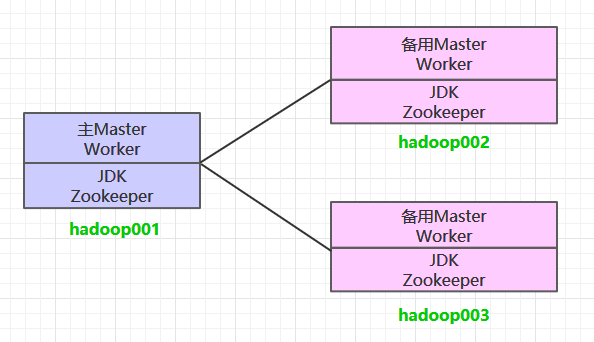

一、集群规划

这里搭建一个 3 节点的 Spark 集群,其中三台主机上均部署 Worker 服务。同时为了保证高可用,除了在 hadoop001 上部署主 Master 服务外,还在 hadoop002 和 hadoop003 上分别部署备用的 Master 服务,Master 服务由 Zookeeper 集群进行协调管理,如果主 Master 不可用,则备用 Master 会成为新的主 Master。

二、前置条件

搭建 Spark 集群前,需要保证 JDK 环境、Zookeeper 集群和 Hadoop 集群已经搭建,相关步骤可以参阅:

三、Spark集群搭建

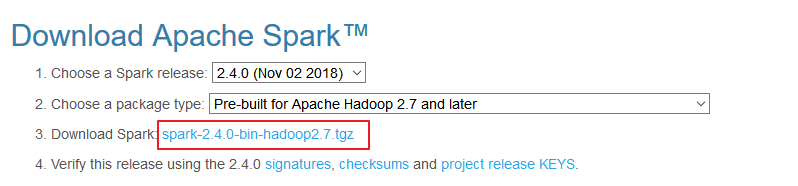

3.1 下载解压

下载所需版本的 Spark,官网下载地址:http://spark.apache.org/downloads.html

下载后进行解压:

# tar -zxvf spark-2.2.3-bin-hadoop2.6.tgz3.2 配置环境变量

# vim /etc/profile添加环境变量:

export SPARK_HOME=/usr/app/spark-2.2.3-bin-hadoop2.6

export PATH=${SPARK_HOME}/bin:$PATH使得配置的环境变量立即生效:

# source /etc/profile3.3 集群配置

进入 ${SPARK_HOME}/conf 目录,拷贝配置样本进行修改:

1. spark-env.sh

cp spark-env.sh.template spark-env.sh# 配置JDK安装位置

JAVA_HOME=/usr/java/jdk1.8.0_201

# 配置hadoop配置文件的位置

HADOOP_CONF_DIR=/usr/app/hadoop-2.6.0-cdh5.15.2/etc/hadoop

# 配置zookeeper地址

SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=hadoop001:2181,hadoop002:2181,hadoop003:2181 -Dspark.deploy.zookeeper.dir=/spark"2. slaves

cp slaves.template slaves配置所有 Woker 节点的位置:

hadoop001

hadoop002

hadoop0033.4 安装包分发

将 Spark 的安装包分发到其他服务器,分发后建议在这两台服务器上也配置一下 Spark 的环境变量。

scp -r /usr/app/spark-2.4.0-bin-hadoop2.6/ hadoop002:usr/app/

scp -r /usr/app/spark-2.4.0-bin-hadoop2.6/ hadoop003:usr/app/四、启动集群

4.1 启动ZooKeeper集群

分别到三台服务器上启动 ZooKeeper 服务:

zkServer.sh start4.2 启动Hadoop集群

# 启动dfs服务

start-dfs.sh

# 启动yarn服务

start-yarn.sh4.3 启动Spark集群

进入 hadoop001 的 ${SPARK_HOME}/sbin 目录下,执行下面命令启动集群。执行命令后,会在 hadoop001 上启动 Maser 服务,会在 slaves 配置文件中配置的所有节点上启动 Worker 服务。

start-all.sh分别在 hadoop002 和 hadoop003 上执行下面的命令,启动备用的 Master 服务:

# ${SPARK_HOME}/sbin 下执行

start-master.sh4.4 查看服务

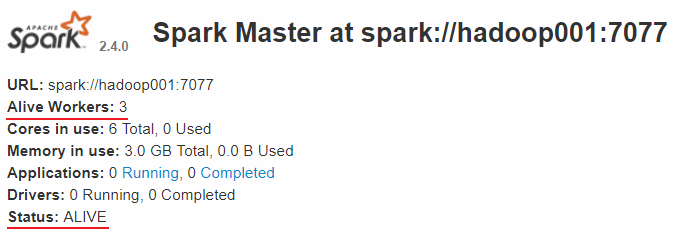

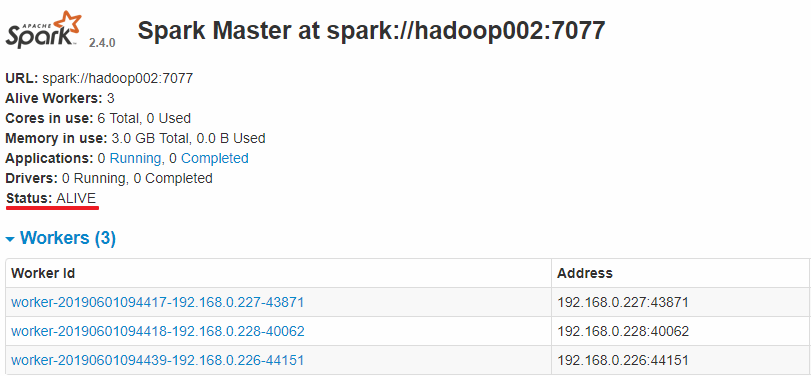

查看 Spark 的 Web-UI 页面,端口为 8080。此时可以看到 hadoop001 上的 Master 节点处于 ALIVE 状态,并有 3 个可用的 Worker 节点。

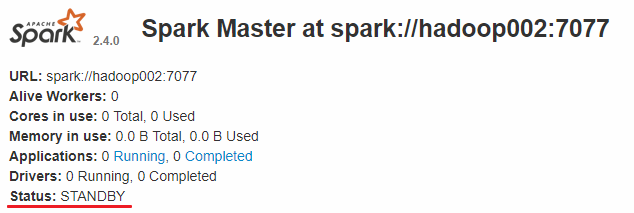

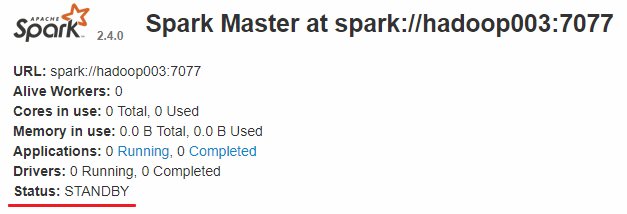

而 hadoop002 和 hadoop003 上的 Master 节点均处于 STANDBY 状态,没有可用的 Worker 节点。

五、验证集群高可用

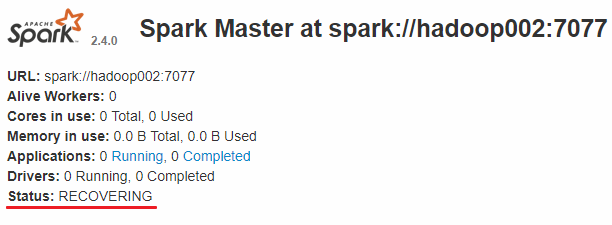

此时可以使用 kill 命令杀死 hadoop001 上的 Master 进程,此时备用 Master 会中会有一个再次成为 主 Master,我这里是 hadoop002,可以看到 hadoop2 上的 Master 经过 RECOVERING 后成为了新的主 Master,并且获得了全部可以用的 Workers。

Hadoop002 上的 Master 成为主 Master,并获得了全部可以用的 Workers。

此时如果你再在 hadoop001 上使用 start-master.sh 启动 Master 服务,那么其会作为备用 Master 存在。

六、提交作业

和单机环境下的提交到 Yarn 上的命令完全一致,这里以 Spark 内置的计算 Pi 的样例程序为例,提交命令如下:

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode client \

--executor-memory 1G \

--num-executors 10 \

/usr/app/spark-2.4.0-bin-hadoop2.6/examples/jars/spark-examples_2.11-2.4.0.jar \

100更多大数据系列文章可以参见 GitHub 开源项目: 大数据入门指南

Spark 系列(七)—— 基于 ZooKeeper 搭建 Spark 高可用集群的更多相关文章

- Hadoop 系列(八)—— 基于 ZooKeeper 搭建 Hadoop 高可用集群

一.高可用简介 Hadoop 高可用 (High Availability) 分为 HDFS 高可用和 YARN 高可用,两者的实现基本类似,但 HDFS NameNode 对数据存储及其一致性的要求 ...

- Kafka 系列(二)—— 基于 ZooKeeper 搭建 Kafka 高可用集群

一.Zookeeper集群搭建 为保证集群高可用,Zookeeper 集群的节点数最好是奇数,最少有三个节点,所以这里搭建一个三个节点的集群. 1.1 下载 & 解压 下载对应版本 Zooke ...

- 基于 ZooKeeper 搭建 Hadoop 高可用集群

一.高可用简介 二.集群规划 三.前置条件 四.集群配置 五.启动集群 六.查看集群 七.集群的二次启动 一.高可用简介 Hadoop 高可用 (High Availability) 分为 HDFS ...

- Hadoop 学习之路(八)—— 基于ZooKeeper搭建Hadoop高可用集群

一.高可用简介 Hadoop 高可用 (High Availability) 分为 HDFS 高可用和 YARN 高可用,两者的实现基本类似,但 HDFS NameNode 对数据存储及其一致性的要求 ...

- Kafka —— 基于 ZooKeeper 搭建 Kafka 高可用集群

一.Zookeeper集群搭建 为保证集群高可用,Zookeeper集群的节点数最好是奇数,最少有三个节点,所以这里搭建一个三个节点的集群. 1.1 下载 & 解压 下载对应版本Zookeep ...

- Kafka 学习之路(二)—— 基于ZooKeeper搭建Kafka高可用集群

一.Zookeeper集群搭建 为保证集群高可用,Zookeeper集群的节点数最好是奇数,最少有三个节点,所以这里搭建一个三个节点的集群. 1.1 下载 & 解压 下载对应版本Zookeep ...

- 入门大数据---基于Zookeeper搭建Kafka高可用集群

一.Zookeeper集群搭建 为保证集群高可用,Zookeeper 集群的节点数最好是奇数,最少有三个节点,所以这里搭建一个三个节点的集群. 1.1 下载 & 解压 下载对应版本 Zooke ...

- 基于keepalived搭建MySQL高可用集群

MySQL的高可用方案一般有如下几种: keepalived+双主,MHA,MMM,Heartbeat+DRBD,PXC,Galera Cluster 比较常用的是keepalived+双主,MHA和 ...

- 基于Docker-compose搭建Redis高可用集群-哨兵模式(Redis-Sentinel)

原文转载自「刘悦的技术博客」https://v3u.cn/a_id_110 我们知道,Redis的集群方案大致有三种:1)redis cluster集群方案:2)master/slave主从方案:3) ...

- 基于docker实现redis高可用集群

基于docker实现redis高可用集群 yls 2019-9-20 简介 基于docker和docker-compose 使用redis集群和sentinel集群,达到redis高可用,为缓存做铺垫 ...

随机推荐

- 微服务-springboot热部署

spring为开发者提供了一个名为spring-boot-devtools的模块来使Spring Boot应用支持热部署,提高开发者的开发效率,无需手动重启Spring Boot应用. IDEA进行热 ...

- WordPress教程之初识WordPress

你是否梦想过以极低的成本获得一个漂亮的网站,而无需聘请专业的开发和设计人员,也不必学习任何编程知识,并且网站功能可以无限扩展?对这些问题中的任何一个,如果你的答案是肯定的,那么 WordPress 将 ...

- Windows和linux环境下按文件名和字符串搜索命令

Windows 1.遍历C盘下所有txt 命令:for /r c:\ %i in (*.txt) do @echo %i 注释:for 循环的意思 /r 按照路径搜索 c:\ 路径 %i in ( ...

- 【JavaScript】深入理解call,以及与apply、bind的区别

一.call call有两个妙用 1.继承(我前面的文章有提到用call实现call继承,有兴趣可以看下.https://www.cnblogs.com/pengshengguang/p/105476 ...

- 微服务SpringCloud之熔断器

学习SpringCloud微服务是参考纯洁的微笑博客,看到他提到股市的熔断我也忍不住吐槽一下,记得当时实施熔断第一天就熔断了,现在想想也还是搞笑,从之前的全民炒股到现在的全民炒房,都是一个炒字,问题是 ...

- Java 7 源码学习系列(二)——Enum

Enum Enum类是java.lang包中一个类,他是Java语言中所有枚举类型的公共基类. 一.定义 public abstract class Enum<E extends Enum< ...

- SpringBoot工程热部署

SpringBoot工程热部署 1.在pom文件中添加热部署依赖 <!-- 热部署配置 --> <dependency> <groupId>org.springfr ...

- python函数知识一 函数初始、定义与调用、返回值、参数和函数的好处+菜中菜

第四章 函数 1.函数初识: def :关键字 -- 定义 函数名:和变量的定义方式一样 (): 用于参数传递,: 形参:函数的定义中()内的是形参 实参:调用的()内是实参 传参:调用时将实参传递给 ...

- FC游戏修改教程(hack)小白文。

FC(NES)红白机Family Computer(简称FAMICOM)(或Nintendo Entertainment System)是任天堂公司发行的第一代家用游戏机. 修改FC游戏需要的工具有 ...

- 洛谷P2299 Mzc和体委的争夺战 题解

题目 题目描述 mzc家很有钱(开玩笑),他家有n个男家丁(做过前三弹的都知道).但如此之多的男家丁吸引来了我们的体委(矮胖小伙),他要来与mzc争夺男家丁. mzc很生气,决定与其决斗,但cat的体 ...