Python爬虫爬取豆瓣读书

一,准备工作。

工具:win10+Python3.6

爬取目标:爬取图中红色方框的内容。

原则:能在源码中看到的信息都能爬取出来。

信息表现方式:CSV转Excel。

二,具体步骤。

先给出具体代码吧:

import requests

import re

from bs4 import BeautifulSoup

import pandas as pd def gethtml(url):

try:

r = requests.get(url,timeout = 30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "It is failed to get html!" def getcontent(url):

html = gethtml(url)

soup = BeautifulSoup(html,"html.parser")

# print(soup.prettify())

div = soup.find("div",class_="indent")

tables = div.find_all("table") price = []

date = []

nationality = []

nation = [] #standard

bookname=[]

link = []

score = []

comment = []

people = []

peo = [] #standard

author = []

for table in tables:

bookname.append(table.find_all("a")[1]['title']) #bookname

link.append(table.find_all("a")[1]['href']) #link

score.append(table.find("span",class_="rating_nums").string) #score

comment.append(table.find_all("span")[-1].string) #comment in a word people_info = table.find_all("span")[-2].text

people.append(re.findall(r'\d+', people_info)) #How many people comment on this book? Note:But there are sublist in the list. navistr = (table.find("p").string) #nationality,author,translator,press,date,price

infos = str(navistr.split("/")) #Note this info:The string has been interrupted.

infostr = str(navistr) #Note this info:The string has not been interrupted.

s = infostr.split("/")

if re.findall(r'\[', s[0]): # If the first character is "[",match the author.

w = re.findall(r'\s\D+', s[0])

author.append(w[0])

else:

author.append(s[0]) #Find all infomations from infos.Just like price,nationality,author,translator,press,date

price_info = re.findall(r'\d+\.\d+', infos)

price.append((price_info[0])) #We can get price.

date.append(s[-2]) #We can get date.

nationality_info = re.findall(r'[[](\D)[]]', infos)

nationality.append(nationality_info) #We can get nationality.Note:But there are sublist in the list.

for i in nationality:

if len(i) == 1:

nation.append(i[0])

else:

nation.append("中") for i in people:

if len(i) == 1:

peo.append(i[0]) print(bookname)

print(author)

print(nation)

print(score)

print(peo)

print(date)

print(price)

print(link) # 字典中的key值即为csv中列名

dataframe = pd.DataFrame({'书名': bookname, '作者': author,'国籍': nation,'评分': score,'评分人数': peo,'出版时间': date,'价格': price,'链接': link,}) # 将DataFrame存储为csv,index表示是否显示行名,default=True

dataframe.to_csv("C:/Users/zhengyong/Desktop/test.csv", index=False, encoding='utf-8-sig',sep=',') if __name__ == '__main__':

url = "https://book.douban.com/top250?start=0" #If you want to add next pages,you have to alter the code.

getcontent(url)

1,爬取大致信息。

选用如下轮子:

import requests

import re

from bs4 import BeautifulSoup def gethtml(url):

try:

r = requests.get(url,timeout = 30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "It is failed to get html!" def getcontent(url):

html = gethtml(url)

bsObj = BeautifulSoup(html,"html.parser") if __name__ == '__main__':

url = "https://book.douban.com/top250?icn=index-book250-all"

getcontent(url)

这样就能从bsObj获取我们想要的信息。

2,信息具体提取。

所有信息都在一个div中,这个div下有25个table,其中每个table都是独立的信息单元,我们只用造出提取一个table的轮子(前提是确保这个轮子的兼容性)。我们发现:一个div父节点下有25个table子节点,用如下方式提取:

div = soup.find("div",class_="indent")

tables = div.find_all("table")

书名可以直接在节点中的title中提取(原始代码确实这么丑,但不影响):

<a href="https://book.douban.com/subject/1770782/" onclick=""moreurl(this,{i:'0'})"" title="追风筝的人">

追风筝的人

</a>

据如下代码提取:

bookname.append(table.find_all("a")[1]['title']) #bookname

相似的不赘述。

评价人数打算用正则表达式提取:

people.append(re.findall(r'\d+', people_info)) #How many people comment on this book? Note:But there are sublist in the list.

people_info = 13456人评价。

在看其余信息:

<p class="pl">[美] 卡勒德·胡赛尼 / 李继宏 / 上海人民出版社 / 2006-5 / 29.00元</p>

其中国籍有个“【】”符号,如何去掉?第一行给出回答。

nationality_info = re.findall(r'[[](\D)[]]', infos)

nationality.append(nationality_info) #We can get nationality.Note:But there are sublist in the list.

for i in nationality:

if len(i) == 1:

nation.append(i[0])

else:

nation.append("中")

其中有国籍的都写出了,但是没写出的我们发现都是中国,所以我们把国籍为空白的改写为“中”:

for i in nationality:

if len(i) == 1:

nation.append(i[0])

else:

nation.append("中")

还有list中存在list的问题也很好解决:

for i in people:

if len(i) == 1:

peo.append(i[0])

长度为1证明不是空序列,就加上序号填写处具体值,使变为一个没有子序列的序列。

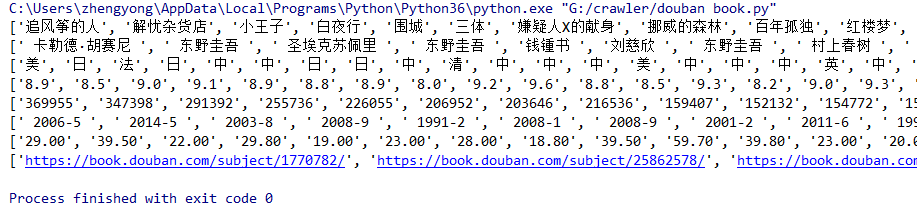

打印结果如下图:

基本是我们想要的了。

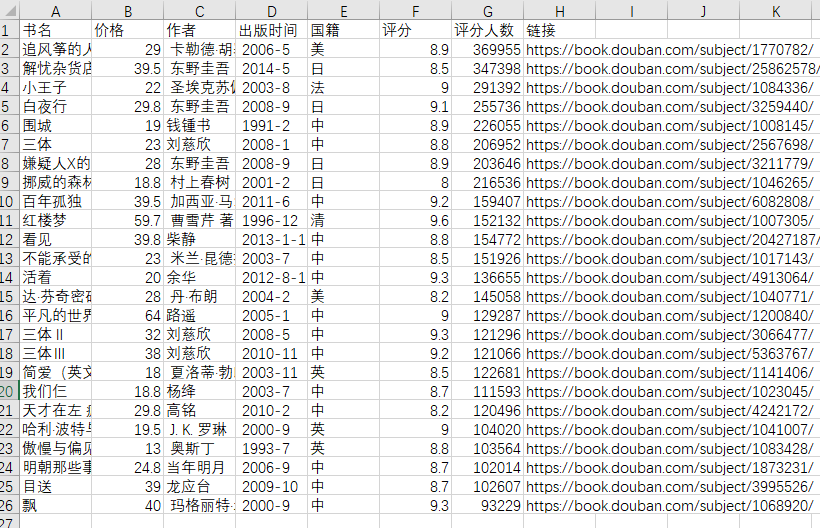

然后写入csv:

dataframe = pd.DataFrame({'书名': bookname, '作者': author,'国籍': nation,'评分': score,'评分人数': peo,'出版时间': date,'价格': price,'链接': link,})

# 将DataFrame存储为csv,index表示是否显示行名,default=True

dataframe.to_csv("C:/Users/zhengyong/Desktop/test.csv", index=False, encoding='utf-8-sig',sep=',')

注意:如果没有加上encoding='utf-8-sig'会存在乱码问题,所以这里必须得加,当然你用其他方法也可。

最后一个翻页的问题,这里由于我没做好兼容性问题,所以后面的页码中提取信息老是出问题,但是这里还是写一下方法:

for i in range(10):

url = "https://book.douban.com/top250?start=" + str(i*25)

getcontent(url)

注意要加上str。

效果图:

其实这里的效果图与我写入csv的传人顺序不一致,后期我会看看原因。

三,总结。

大胆细心,这里一定要细心,很多细节不好好深究后面会有很多东西修改。

Python爬虫爬取豆瓣读书的更多相关文章

- Python爬虫爬取豆瓣电影之数据提取值xpath和lxml模块

工具:Python 3.6.5.PyCharm开发工具.Windows 10 操作系统.谷歌浏览器 目的:爬取豆瓣电影排行榜中电影的title.链接地址.图片.评价人数.评分等 网址:https:// ...

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

- Python爬虫-爬取豆瓣图书Top250

豆瓣网站很人性化,对于新手爬虫比较友好,没有如果调低爬取频率,不用担心会被封 IP.但也不要太频繁爬取. 涉及知识点:requests.html.xpath.csv 一.准备工作 需要安装reques ...

- 2019-02-01 Python爬虫爬取豆瓣Top250

这几天学了一点爬虫后写了个爬取电影top250的代码,分别用requests库和urllib库,想看看自己能不能搞出个啥东西,虽然很简单但还是小开心. import requests import r ...

- python爬虫-爬取豆瓣电影数据

#!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:27# 文件 :spider_05.py# IDE :PyChar ...

- Python爬虫爬取豆瓣电影名称和链接,分别存入txt,excel和数据库

前提条件是python操作excel和数据库的环境配置是完整的,这个需要在python中安装导入相关依赖包: 实现的具体代码如下: #!/usr/bin/python# -*- coding: utf ...

- Python爬虫-爬取豆瓣电影Top250

#!usr/bin/env python3 # -*- coding:utf-8-*- import requests from bs4 import BeautifulSoup import re ...

- python爬虫:利用正则表达式爬取豆瓣读书首页的book

1.问题描述: 爬取豆瓣读书首页的图书的名称.链接.作者.出版日期,并将爬取的数据存储到Excel表格Douban_I.xlsx中 2.思路分析: 发送请求--获取数据--解析数据--存储数据 1.目 ...

- python定时器爬取豆瓣音乐Top榜歌名

python定时器爬取豆瓣音乐Top榜歌名 作者:vpoet mail:vpoet_sir@163.com 注:这些小demo都是前段时间为了学python写的,现在贴出来纯粹是为了和大家分享一下 # ...

随机推荐

- 《C#手札》--基础知识

第一记 C#基本语法: 语言分隔符: 分号 (;) :语句的分割,表示一句话结束: 花括号 ({}):表示一个代码号,是一个整体,花括号要成对使用: 方括号 ([]): 定义数组和访问数组元素时使用: ...

- MATLAB cftool工具数据拟合结果好坏判断

SSE和RMSE比较小 拟合度R接近于1较好 * 统计参数模型的拟合优度 1.误差平方和(SSE) 2. R-Square(复相关系数或复测定系数) 3. Adjusted R-Square(调整自由 ...

- 分享一个在线生成微信跳转链接实现微信内跳转浏览器打开URL的工具

前言 现如今微信对第三方推广链接的审核是越来越严格了,域名在微信中分享转发经常会被拦截,一旦被拦截用户就只能复制链接手动打开浏览器粘贴才能访问,要不然就是换个域名再推,周而复始.无论是哪一种情况都会面 ...

- further configuration avilable 不见了

Dynameic Web Module的further configuration avilable 不见了 打开目录下的 org.eclipse.wst.common.project.facet. ...

- pythonのdjango Form简单应用。

Form表单有两种应用场景: 1.生成HTML标签. 2.验证输入内容. 如果我们在django程序中使用form时,需要在views中导入form模块 from django import form ...

- c++ Qt向PHP接口POST文件流

Qt调用PHP写的接口,向其传递图片文件,并保存在服务器. 二进制文件无法直接传递,Qt采用Base64进行编码发送,PHP解码保存为文件. 注意:PHP收到数据之后会将POST过来的数据中的加号(+ ...

- spring mybatis mysql 事务不起作用

之前框架事务应该是好的,不过这次做了些修改,不知如何竟然不好用了,整理了好半天,java框架配置就是吓人,有一点不熟悉的就可能暴露问题,好处是又深入的了解了配置原理. 开始以为是mysql不支持事务的 ...

- 协议形式化分析Scyther 资料整理

1.性能分析 目前来说形式化的分析已经成为安全协议的一种很流行的方法,但是每种工具都用其不同适合的协议,Scyther软件是一种形式化分析工具,极大的促进了协议的分析和设计,scyther工具在运行界 ...

- Redis的学习

单线程架构可参考:https://blog.csdn.net/sunhuiliang85/article/details/73656830

- 设计模式 — 抽象工厂模式(Abstract Factory)

工厂模式已经分析了简单工厂模式和工厂方法模式.并且了解了工厂方法模式去简单工厂模式的延伸,工厂方法模式如果不把工厂类抽象的话,就是简单工厂模式.由前面两个工厂模式可以猜测出抽象工厂模式应该是这两种工厂 ...