tensorflow Tensorboard可视化-【老鱼学tensorflow】

tensorflow自带了可视化的工具:Tensorboard。有了这个可视化工具,可以让我们在调整各项参数时有了可视化的依据。

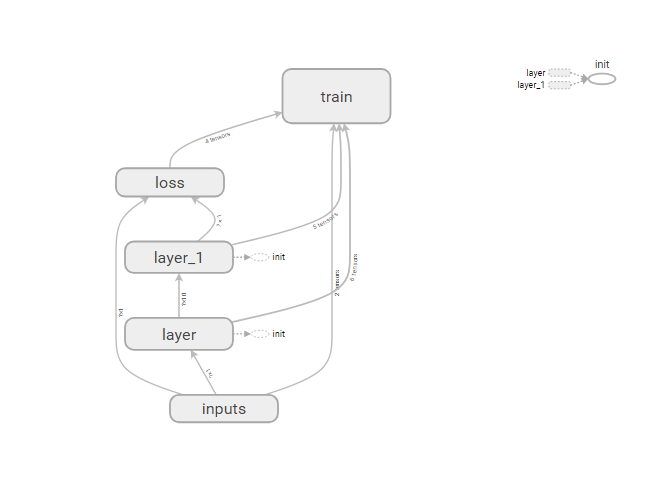

本次我们先用Tensorboard来可视化Tensorflow的结构。

在输出tensorflow结构的关键步骤是:

writer = tf.summary.FileWriter("E:/todel/data/tensorflow", sess.graph)

这个函数中把当前的tensorflow的结构图输出到指定的目录下。

而为了能够使输出的结构能够有一定的分组,可以使用:

with tf.name_scope("xxx"):

只要用tf.name_scope()包含起来的代码就会分在一组中显示。

因此全部的示例代码如下:

import tensorflow as tf

import matplotlib.pyplot as plt

def add_layer(inputs, in_size, out_size, activation_function=None):

"""

添加层

:param inputs: 输入数据

:param in_size: 输入数据的列数

:param out_size: 输出数据的列数

:param activation_function: 激励函数

:return:

"""

# 定义权重,初始时使用随机变量,可以简单理解为在进行梯度下降时的随机初始点,这个随机初始点要比0值好,因为如果是0值的话,反复计算就一直是固定在0中,导致可能下降不到其它位置去。

with tf.name_scope('layer'):

with tf.name_scope('weights'):

Weights = tf.Variable(tf.random_normal([in_size, out_size]), name='W')

with tf.name_scope('biases'):

# 偏置shape为1行out_size列

biases = tf.Variable(tf.zeros([1, out_size]) + 0.1, name='b')

with tf.name_scope("Wx_plus_b"):

# 建立神经网络线性公式:inputs * Weights + biases,我们大脑中的神经元的传递基本上也是类似这样的线性公式,这里的权重就是每个神经元传递某信号的强弱系数,偏置值是指这个神经元的原先所拥有的电位高低值

Wx_plus_b = tf.matmul(inputs, Weights) + biases

if activation_function is None:

# 如果没有设置激活函数,则直接就把当前信号原封不动地传递出去

outputs = Wx_plus_b

else:

# 如果设置了激活函数,则会由此激活函数来对信号进行传递或抑制

outputs = activation_function(Wx_plus_b)

return outputs

import numpy as np

# 创建一列(相当于只有一个属性值),300行的x值,这里np.newaxis用于新建出列数据,使其shape为(300, 1)

x_data = np.linspace(-1, 1, 300)[:,np.newaxis]

# 增加噪点,噪点的均值为0,标准差为0.05,形状跟x_data一样

noise = np.random.normal(0, 0.05, x_data.shape)

# 定义y的函数为二次曲线的函数,但同时增加了一些噪点数据

y_data = np.square(x_data) - 0.5 + noise

# 定义输入值,这里定义输入值的目的是为了能够使程序比较灵活,可以在神经网络启动时接收不同的实际输入值,这里输入的结构为输入的行数不国定,但列就是1列的值

with tf.name_scope("inputs"):

xs = tf.placeholder(tf.float32, [None, 1], name='x_input')

ys = tf.placeholder(tf.float32, [None, 1], name='y_input')

# 定义一个隐藏层,输入为xs,输入size为1列,因为x_data就只有1个属性值,输出size我们假定输出的神经元有10个神经元的隐藏层,激励函数用relu

l1 = add_layer(xs, 1, 10, tf.nn.relu)

# 定义输出层,输入为l1,输入size为10列,也就是l1的列数,输出size为1,因为这里直接输出为类似y_data了,因此为1列,假定没有激励函数,也就是输出是啥就直接传递出去了。

predition = add_layer(l1, 10, 1, activation_function=None)

with tf.name_scope("loss"):

# 定义损失函数为差值平方和的平均值

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - predition), axis=1))

with tf.name_scope("train"):

# 进行逐步优化的梯度下降优化器,学习效率为0.1,以最小化损失函数的方式进行优化

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

# 初始化所有定义的变量

init = tf.global_variables_initializer()

sess = tf.Session()

sess.run(init)

writer = tf.summary.FileWriter("E:/todel/data/tensorflow", sess.graph)

# 学习1000次

for i in range(1000):

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

# 打印期间的误差值,看这个误差值是否在减少

if i % 50 == 0:

# print(sess.run(loss, feed_dict={xs:x_data, ys:y_data}))

prediction_value = sess.run(predition, feed_dict={xs:x_data, ys:y_data})

执行以上代码后,会在指定的目录下生成相应的结构文件,而为了能够查看此文件,可以在命令行中输入:

tensorboard --logdir tensorflow

当然,上面的logdir根据读者自己设置的目录结构名来确定。

执行上面的命令后,会打印一个可以在浏览器中输入的URL,输入这个URL就会显示相应的tensorflow结构图:

大家也可以自己尝试一下如果不输入那些烦人的tf.name_scope()进行分组而直接用 tf.summary.FileWriter进行输出其结构图是长啥样的。

tensorflow Tensorboard可视化-【老鱼学tensorflow】的更多相关文章

- tensorflow分类-【老鱼学tensorflow】

前面我们学习过回归问题,比如对于房价的预测,因为其预测值是个连续的值,因此属于回归问题. 但还有一类问题属于分类的问题,比如我们根据一张图片来辨别它是一只猫还是一只狗.某篇文章的内容是属于体育新闻还是 ...

- tensorflow安装-【老鱼学tensorflow】

TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统,其命名来源于本身的运行原理.Tensor(张量)意味着N维数组,Flow(流)意味着基于数据流图的计算,Tensor ...

- tensorflow例子-【老鱼学tensorflow】

本节主要用一个例子来讲述一下基本的tensorflow用法. 在这个例子中,我们首先伪造一些线性数据点,其实这些数据中本身就隐藏了一些规律,但我们假装不知道是什么规律,然后想通过神经网络来揭示这个规律 ...

- tensorflow变量-【老鱼学tensorflow】

在程序中定义变量很简单,只要定义一个变量名就可以,但是tensorflow有点类似在另外一个世界,因此需要通过当前的世界中跟tensorlfow的世界中进行通讯,来告诉tensorflow的世界中定义 ...

- tensorflow激励函数-【老鱼学tensorflow】

当我们回到家,如果家里有异样,我们能够很快就会发现家中的异样,那是因为这些异常的摆设在我们的大脑中会产生较强的脑电波. 当我们听到某个单词,我们大脑中跟这个单词相关的神经元会异常兴奋,而同这个单词无关 ...

- tensorflow卷积神经网络-【老鱼学tensorflow】

前面我们曾有篇文章中提到过关于用tensorflow训练手写2828像素点的数字的识别,在那篇文章中我们把手写数字图像直接碾压成了一个784列的数据进行识别,但实际上,这个图像是2828长宽结构的,我 ...

- tensorflow结果可视化-【老鱼学tensorflow】

这次我们把上次的结果进行可视化显示,我们会把神经网络的优化过程以图像的方式展示出来,方便我们了解神经网络是如何进行优化的. 首先,我们把测试数据显示出来: # 显示测试数据 fig = plt.fig ...

- tensorflow用dropout解决over fitting-【老鱼学tensorflow】

在机器学习中可能会存在过拟合的问题,表现为在训练集上表现很好,但在测试集中表现不如训练集中的那么好. 图中黑色曲线是正常模型,绿色曲线就是overfitting模型.尽管绿色曲线很精确的区分了所有的训 ...

- tensorflow Tensorboard2-【老鱼学tensorflow】

前面我们用Tensorboard显示了tensorflow的程序结构,本节主要用Tensorboard显示各个参数值的变化以及损失函数的值的变化. 这里的核心函数有: histogram 例如: tf ...

随机推荐

- 逆FizzBuzz问题求最短序列

问题描述 FizzBuzz问题:一个大于0的自然数能整除3,将输出“Fizz”:能整除5,将输出“Buzz”:能整除3和5,将输出“FizzBuzz”:否则输出自己. 逆FizzBuzz问题最短序列: ...

- thinkphp 5.0 在appache下隐藏index.php入口代码

一.在appache的配置文件httpd.conf中开启rewrite_module 二.启用.htaccess的配置 启用.htaccess,需要修改httpd.conf,启用AllowOverri ...

- Java发布webservice应用并发送SOAP请求调用

webservice框架有很多,比如axis.axis2.cxf.xFire等等,做服务端和做客户端都可行,个人感觉使用这些框架的好处是减少了对于接口信息的解析,最主要的是减少了对于传递于网络中XML ...

- (Python)自动生成代码(方法一)

在写某个平台的自动化脚本时,笔者把全部的操作都封装到了两个类中,page.py和commonpage.py: page.py部分代码: class BasePage(object): ''' 页面基础 ...

- Typora 使用说明

目录 Typora是一款超简洁的markdown编辑器,具有如下特点: 完全免费,目前已支持中文 跨平台,支持windows,mac,linux 支持数学公式输入,图片插入 极其简洁,无多余功能 界面 ...

- Maven之阿里云镜像仓库配置

方式一:全局配置:修改maven的setting.xml配置 在mirrors节点下面添加子节点: <mirror> <id>nexus-aliyun</id> & ...

- java(11)带参数的方法

一.java中的包(package) 1.1 包,对应到磁盘中的文件夹 1.2 新建一个class,默认保存在缺省包中 1.3 声明包的关键字:package package语句,置顶位置 1.4 导 ...

- selenium定位方式-获取标签元素:find_element_by_xxx

定位方式取舍# 唯一定位方式.多属性定位.层级+角标定位(离目标元素越近,相对定位越好) # 推荐用css selector(很少用递进层次的定位)# 什么时候用xpath呢? 当你定位元素时,必须要 ...

- Python:python抓取豆瓣电影top250

一直对爬虫感兴趣,学了python后正好看到某篇关于爬取的文章,就心血来潮实战一把吧. 实现目标:抓取豆瓣电影top250,并输出到文件中 1.找到对应的url:https://movie.douba ...

- word20170106在机场 At the airport有用的词和句子

有用的词: airport terminal: 航站楼 domestic flight: 国内航班 international flight: 国际航班 checked luggage: 托运行李 c ...