Spark学习笔记——读写HDFS

使用Spark读写HDFS中的parquet文件

文件夹中的parquet文件

build.sbt文件

name := "spark-hbase" version := "1.0" scalaVersion := "2.11.8" libraryDependencies ++= Seq(

"org.apache.spark" %% "spark-core" % "2.1.0",

"mysql" % "mysql-connector-java" % "5.1.31",

"org.apache.spark" %% "spark-sql" % "2.1.0",

"org.apache.hbase" % "hbase-common" % "1.3.0",

"org.apache.hbase" % "hbase-client" % "1.3.0",

"org.apache.hbase" % "hbase-server" % "1.3.0",

"org.apache.hbase" % "hbase" % "1.2.1"

)

Scala实现方法

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.sql._

import java.util.Properties

import com.google.common.collect.Lists

import org.apache.spark.sql.types.{ArrayType, StringType, StructField, StructType}

import org.apache.hadoop.hbase.HBaseConfiguration

import org.apache.hadoop.hbase.client.{Result, Scan}

import org.apache.hadoop.hbase.io.ImmutableBytesWritable

import org.apache.hadoop.hbase.mapreduce.TableInputFormat

/**

* Created by mi on 17-4-11.

*/

case class resultset(name: String,

info: String,

summary: String)

case class IntroItem(name: String, value: String)

case class BaikeLocation(name: String,

url: String = "",

info: Seq[IntroItem] = Seq(),

summary: Option[String] = None)

case class MewBaikeLocation(name: String,

url: String = "",

info: Option[String] = None,

summary: Option[String] = None)

object MysqlOpt {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("WordCount").setMaster("local")

val sc = new SparkContext(conf)

val sqlContext = new SQLContext(sc)

import sqlContext.implicits._

//定义数据库和表信息

val url = "jdbc:mysql://localhost:3306/baidubaike?useUnicode=true&characterEncoding=UTF-8"

val table = "baike_pages"

//读取parquetFile,并写入Mysql

val sparkSession = SparkSession.builder()

.master("local")

.appName("spark session example")

.getOrCreate()

val parquetDF = sparkSession.read.parquet("/home/mi/coding/coding/baikeshow_data/baikeshow")

// parquetDF.collect().take(20).foreach(println)

//parquetDF.show()

//BaikeLocation是读取的parquet文件中的case class

val ds = parquetDF.as[BaikeLocation].map { line =>

//把info转换为新的case class中的类型String

val info = line.info.map(item => item.name + ":" + item.value).mkString(",")

//注意需要把字段放在一个case class中,不然会丢失列信息

MewBaikeLocation(name = line.name, url = line.url, info = Some(info), summary = line.summary)

}.cache()

ds.show()

// ds.take(2).foreach(println)

//写入Mysql

// val prop = new Properties()

// prop.setProperty("user", "root")

// prop.setProperty("password", "123456")

// ds.write.mode(SaveMode.Append).jdbc(url, "baike_location", prop)

//写入parquetFile

ds.repartition(10).write.parquet("/home/mi/coding/coding/baikeshow_data/baikeshow1")

}

}

df.show打印出来的信息,如果没放在一个case class中的话,name,url,info,summary这列信息会变成1,2,3,4

使用spark-shell查看写回去的parquet文件的信息

#进入spark-shell

import org.apache.spark.sql.SQLContext

val sqlContext = new SQLContext(sc)

val path = "file:///home/mi/coding/coding/baikeshow_data/baikeshow1"

val df = sqlContext.parquetFile(path)

df.show

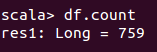

df.count

如果只想显示某一列的话,可以这么做

df.select("title").take(100).foreach(println) //只显示title这一列的信息

Spark学习笔记——读写HDFS的更多相关文章

- Spark学习笔记——读写Hbase

1.首先在Hbase中建立一张表,名字为student 参考 Hbase学习笔记——基本CRUD操作 一个cell的值,取决于Row,Column family,Column Qualifier和Ti ...

- Spark学习笔记——读写MySQL

1.使用Spark读取MySQL中某个表中的信息 build.sbt文件 name := "spark-hbase" version := "1.0" scal ...

- spark学习笔记总结-spark入门资料精化

Spark学习笔记 Spark简介 spark 可以很容易和yarn结合,直接调用HDFS.Hbase上面的数据,和hadoop结合.配置很容易. spark发展迅猛,框架比hadoop更加灵活实用. ...

- Spark学习笔记2——RDD(上)

目录 Spark学习笔记2--RDD(上) RDD是什么? 例子 创建 RDD 并行化方式 读取外部数据集方式 RDD 操作 转化操作 行动操作 惰性求值 Spark学习笔记2--RDD(上) 笔记摘 ...

- Spark学习笔记1——第一个Spark程序:单词数统计

Spark学习笔记1--第一个Spark程序:单词数统计 笔记摘抄自 [美] Holden Karau 等著的<Spark快速大数据分析> 添加依赖 通过 Maven 添加 Spark-c ...

- Spark学习笔记之SparkRDD

Spark学习笔记之SparkRDD 一. 基本概念 RDD(resilient distributed datasets)弹性分布式数据集. 来自于两方面 ① 内存集合和外部存储系统 ② ...

- Spark学习笔记2(spark所需环境配置

Spark学习笔记2 配置spark所需环境 1.首先先把本地的maven的压缩包解压到本地文件夹中,安装好本地的maven客户端程序,版本没有什么要求 不需要最新版的maven客户端. 解压完成之后 ...

- Spark学习笔记3(IDEA编写scala代码并打包上传集群运行)

Spark学习笔记3 IDEA编写scala代码并打包上传集群运行 我们在IDEA上的maven项目已经搭建完成了,现在可以写一个简单的spark代码并且打成jar包 上传至集群,来检验一下我们的sp ...

- Spark学习笔记-GraphX-1

Spark学习笔记-GraphX-1 标签: SparkGraphGraphX图计算 2014-09-29 13:04 2339人阅读 评论(0) 收藏 举报 分类: Spark(8) 版权声明: ...

随机推荐

- python——append与extend

编者注:本文主要参考了<Python核心编程(第二版)> 网上有很多对这两个函数的区别讲解,但我觉得都讲的不是很清楚,记忆不深刻.这样解释清楚且容易记住. list.append(obje ...

- [HDU1598]find the most comfortable road

思路: 考虑一个暴力:枚举最大的边权和最小的边权,然后将边权在这之间的边全拿出来构成一张无向图,剩下的就是判断是否存在一条从$S$到$T$的路径.相当于判$S$和$T$是否连通,用并查集连一下即可.时 ...

- Qt.常用代码整理

窗口全屏化(此方法只对顶级窗口有效,对子窗口无效) window.showFullScreen() 字符串处理 Qt还提供了一种方便的字符串组合方式,使用QString::arg()函数,此函数的重载 ...

- iOS离屏渲染之优化分析

在进行iOS的应用开发过程中,有时候会出现卡顿的问题,虽然iOS设备的性能越来越高,但是卡顿的问题还是有可能会出现,而离屏渲染是造成卡顿的原因之一.因此,本文主要分析一下离屏渲染产生的原因及避免的方法 ...

- Windows下的搜索神器 —— everything

介绍一款Windows下的神奇 -- everything,软件很小巧,但是搜索速度非常快,比Windows自带的搜索功能更强大.更快.掌握它的基本用法,在查找文件时能提升很高的效率 1.下载 2.基 ...

- BTrace使用简介

很多时候在online的应用出现问题时,很多时候我们需要知道更多的程序的运行细节,但又不可能在开发的时候就把程序中所有的运行细节都打印到日志上,通常这个时候能采取的就是修改代码,重新部署,然后再观察, ...

- Error-MVC:HTTP Error 500.19 - Internal Server Error 无法访问请求的页面,因为该页的相关配置数据无效。

ylbtech-Error-MVC:HTTP Error 500.19 - Internal Server Error 无法访问请求的页面,因为该页的相关配置数据无效. 1.返回顶部 1. IIS ...

- [Canvas]Bombman v1.04

Bombman是我仿造红白机上经典游戏爆破小人,用Canvas制作的一款网页版单机游戏, 自我感觉还是有一定的可玩性. 本游戏的胜利条件是用雷消灭所有怪物,但被怪物即使是擦边碰到或是炸弹火焰炸到就算失 ...

- linux下open和fopen的区别

二者返回值不同. fopen可以指定宽字符和ASCI.

- Hadoop2.2.0分布式安装配置详解[2/3]

前言 本文主要通过对hadoop2.2.0集群配置的过程加以梳理,所有的步骤都是通过自己实际测试.文档的结构也是根据自己的实际情况而定,同时也会加入自己在实际过程遇到的问题.搭建环境过程不重要,重要点 ...