python实现逻辑回归

首先得明确逻辑回归与线性回归不同,它是一种分类模型。而且是一种二分类模型。

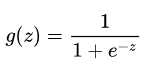

首先我们需要知道sigmoid函数,其公式表达如下:

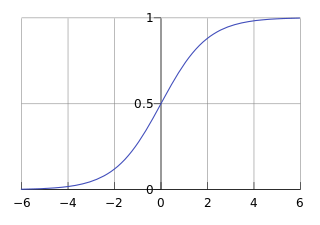

其函数曲线如下:

sigmoid函数有什么性质呢?

1、关于(0,0.5) 对称

2、值域范围在(0,1)之间

3、单调递增

4、光滑

5、中间较陡,两侧较平缓

6、其导数为g(z)(1-g(z)),即可以用原函数直接计算

于是逻辑回归的函数形式可以用以下公式表示:

其中θ表示权重参数,x表示输入。θTx为决策边界,就是该决策边界将不同类数据区分开来。

为什么使用sigmoid函数呢?

1、sigmoid函数本身的性质

2、推导而来

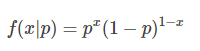

我们知道伯努利分布:

当x=1时,f(1|p) =p,当x=0时,f(0|p)=1-p

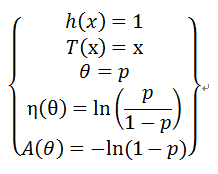

首先要明确伯努利分布也是指数族,指数族的一般表达式为:

由于:

则有:

所以:

因为:

则有:

则有:

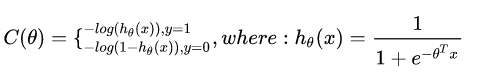

逻辑回归代价函数:

为什么这么定义呢?

以单个样本为例:

上面式子等价于:

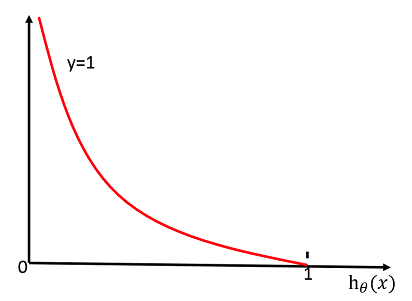

当y=1时,其图像如下:

也就是说当hθ(x)的值越接近1,C(θ) 的值就越小。

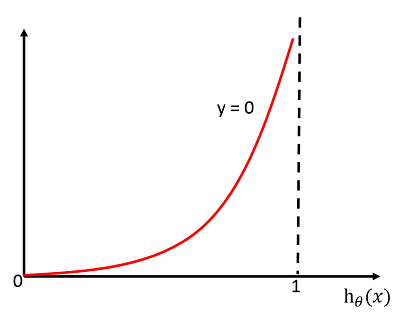

同理当y=0时,其图像如下:

也就是说当hθ(x)的值越接近0,C(θ) 的值就越小。

这样就可以将不同类区分开来。

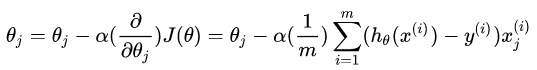

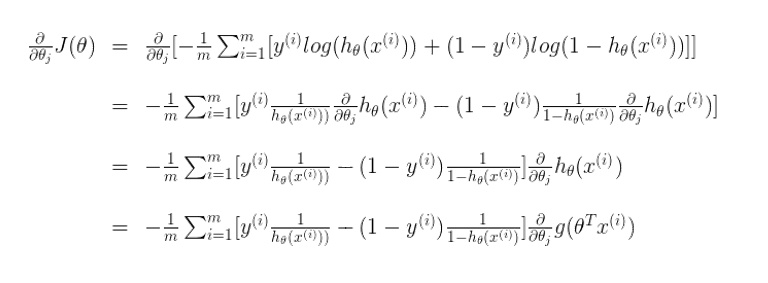

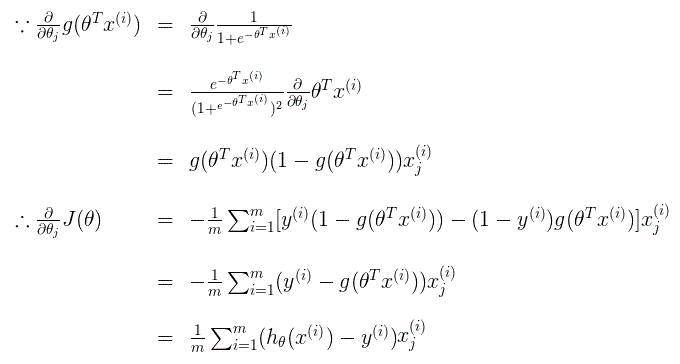

代价函数的倒数如下:

推导过程如下:

上面参考了:

https://blog.csdn.net/sun_wangdong/article/details/80780368

https://zhuanlan.zhihu.com/p/28415991

接下来就是代码实现了,代码来源: https://github.com/eriklindernoren/ML-From-Scratch

from __future__ import print_function, division

import numpy as np

import math

from mlfromscratch.utils import make_diagonal, Plot

from mlfromscratch.deep_learning.activation_functions import Sigmoid class LogisticRegression():

""" Logistic Regression classifier.

Parameters:

-----------

learning_rate: float

The step length that will be taken when following the negative gradient during

training.

gradient_descent: boolean

True or false depending if gradient descent should be used when training. If

false then we use batch optimization by least squares.

"""

def __init__(self, learning_rate=.1, gradient_descent=True):

self.param = None

self.learning_rate = learning_rate

self.gradient_descent = gradient_descent

self.sigmoid = Sigmoid() def _initialize_parameters(self, X):

n_features = np.shape(X)[1]

# Initialize parameters between [-1/sqrt(N), 1/sqrt(N)]

limit = 1 / math.sqrt(n_features)

self.param = np.random.uniform(-limit, limit, (n_features,)) def fit(self, X, y, n_iterations=4000):

self._initialize_parameters(X)

# Tune parameters for n iterations

for i in range(n_iterations):

# Make a new prediction

y_pred = self.sigmoid(X.dot(self.param))

if self.gradient_descent:

# Move against the gradient of the loss function with

# respect to the parameters to minimize the loss

self.param -= self.learning_rate * -(y - y_pred).dot(X)

else:

# Make a diagonal matrix of the sigmoid gradient column vector

diag_gradient = make_diagonal(self.sigmoid.gradient(X.dot(self.param)))

# Batch opt:

self.param = np.linalg.pinv(X.T.dot(diag_gradient).dot(X)).dot(X.T).dot(diag_gradient.dot(X).dot(self.param) + y - y_pred) def predict(self, X):

y_pred = np.round(self.sigmoid(X.dot(self.param))).astype(int)

return y_pred

说明:np.linalg.pinv()用于计算矩阵的pseudo-inverse(伪逆)。第一种方法求解使用随机梯度下降。

其中make_diagonal()函数如下:用于将向量转换为对角矩阵

def make_diagonal(x):

""" Converts a vector into an diagonal matrix """

m = np.zeros((len(x), len(x)))

for i in range(len(m[0])):

m[i, i] = x[i]

return m

其中Sigmoid代码如下:

class Sigmoid():

def __call__(self, x):

return 1 / (1 + np.exp(-x)) def gradient(self, x):

return self.__call__(x) * (1 - self.__call__(x))

最后是主函数运行代码:

from __future__ import print_function

from sklearn import datasets

import numpy as np

import matplotlib.pyplot as plt # Import helper functions

import sys

sys.path.append("/content/drive/My Drive/learn/ML-From-Scratch/")

from mlfromscratch.utils import make_diagonal, normalize, train_test_split, accuracy_score

from mlfromscratch.deep_learning.activation_functions import Sigmoid

from mlfromscratch.utils import Plot

from mlfromscratch.supervised_learning import LogisticRegression def main():

# Load dataset

data = datasets.load_iris()

X = normalize(data.data[data.target != 0])

y = data.target[data.target != 0]

y[y == 1] = 0

y[y == 2] = 1 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.33, seed=1) clf = LogisticRegression(gradient_descent=True)

clf.fit(X_train, y_train)

y_pred = clf.predict(X_test) accuracy = accuracy_score(y_test, y_pred)

print ("Accuracy:", accuracy) # Reduce dimension to two using PCA and plot the results

Plot().plot_in_2d(X_test, y_pred, title="Logistic Regression", accuracy=accuracy) if __name__ == "__main__":

main()

结果:

Accuracy: 0.9393939393939394

python实现逻辑回归的更多相关文章

- 机器学习_线性回归和逻辑回归_案例实战:Python实现逻辑回归与梯度下降策略_项目实战:使用逻辑回归判断信用卡欺诈检测

线性回归: 注:为偏置项,这一项的x的值假设为[1,1,1,1,1....] 注:为使似然函数越大,则需要最小二乘法函数越小越好 线性回归中为什么选用平方和作为误差函数?假设模型结果与测量值 误差满足 ...

- 机器学习之使用Python完成逻辑回归

一.任务基础 我们将建立一个逻辑回归模型来预测一个学生是否被大学录取.假设你是一个大学系的管理员,你想根据两次考试的结果来决定每个申请人的录取机会.你有以前的申请人的历史数据,你可以用它作为逻辑回归的 ...

- 吴裕雄 python 机器学习——逻辑回归

import numpy as np import matplotlib.pyplot as plt from matplotlib import cm from mpl_toolkits.mplot ...

- Python之逻辑回归模型来预测

建立一个逻辑回归模型来预测一个学生是否被录取. import numpy as np import pandas as pd import matplotlib.pyplot as plt impor ...

- python机器学习-逻辑回归

1.逻辑函数 假设数据集有n个独立的特征,x1到xn为样本的n个特征.常规的回归算法的目标是拟合出一个多项式函数,使得预测值与真实值的误差最小: 而我们希望这样的f(x)能够具有很好的逻辑判断性质,最 ...

- python机器学习——逻辑回归

我们知道感知器算法对于不能完全线性分割的数据是无能为力的,在这一篇将会介绍另一种非常有效的二分类模型--逻辑回归.在分类任务中,它被广泛使用 逻辑回归是一个分类模型,在实现之前我们先介绍几个概念: 几 ...

- Python使用逻辑回归估算OR值

第一种是统计学方法,需要用到 statsmodels包 statsmodels是统计和计量经济学的package,包含了用于参数评估和统计测试的实用工具 第二种是机器学习,需要使用sklearn中的L ...

- 用python实现逻辑回归

机器学习课程的一个实验,整理出来共享. 原理很简单,优化方法是用的梯度下降.后面有测试结果. # coding=utf-8 from math import exp import matplotlib ...

- Python之逻辑回归

代码: import numpy as np from sklearn import datasets from sklearn.linear_model import LogisticRegress ...

随机推荐

- 使用原生方法查询指定元素是否包含指定className

如果我们要查找某个指定元素是否包含指定的className,可以使用以下方法 eg:document.getElementById('Id').classList.contains('要查询的clas ...

- 浅谈Java接口(Interface)

浅谈Java接口 先不谈接口,不妨设想一个问题? 如果你写了个Animal类,有许多类继承了他,包括Hippo(河马), Dog, Wolf, Cat, Tiger这几个类.你把这几个类拿给别人用,但 ...

- .NET Core项目部署到Linux(Centos7)(十)总结

目录 1.前言 2.环境和软件的准备 3.创建.NET Core API项目 4.VMware Workstation虚拟机及Centos 7安装 5.Centos 7安装.NET Core环境 6. ...

- 下载腾讯视频mp4格式

import time import subprocess import argparse def command(cmd, timeout=60): ''' :param cmd: 执行命令cmd, ...

- 【数据库】MySQL数据库(二)

一.数据库文件的导出 1.在DOS命令行下导出数据库(带数据) mysqldump -u root -p 数据库名 > E:\wamp\www\lamp175\lamp175.sql 2.在DO ...

- C++ memset函数用法

#include<stdio.h>#include<string.h>int main(){ char buffer[] = "I love you!"; ...

- Linux系统安装Dos系统(虚拟机里装)

结合以下两篇优秀的文章就能完成任务. 1.https://www.jb51.net/os/609411.html 2.http://blog.51cto.com/6241809/1687361 所需要 ...

- MySQL学习之路6-数据表连接方式

内连接 关键字: inner join on 语句:select * from <a_table> inner join <b_table> on a.id = b.id ; ...

- defer使用小结

defer 前言 defer的定义 defer执行的规则 为什么需要defer defer进阶 作为匿名函数 作为函数参数 defer命令执行的时机 defer配合recover 总结 参考 defe ...

- AJ学IOS(31)UI之Quartz2D图形上下文栈

AJ分享,必须精品 首先,前面博客说过.qurza2d的上下文中有绘图信息和绘图的属性. 但是他是怎么绘制到上下午中的呢? 我们画图时候一半会用这三个步骤: (1)获取上下文 (2)绘图 (3)渲染 ...