Spark的安装及其配置

1.Spark下载

https://archive.apache.org/dist/spark/

2.上传解压,配置环境变量 配置bin目录

解压:tar -zxvf spark-2.4.5-bin-hadoop2.7.tgz -C /usr/local/soft/

改名:mv spark-2.4.5-bin-hadoop2.7/ spark-2.4.5

配置环境变量:vim /etc/profile

添加环境变量:

export SPARK_HOME=/usr/local/soft/spark-2.4.5

export PATH=$PATH:$SPARK_HOME/bin

保存配置:source /etc/profile

3.修改配置文件 conf

修改spark-env.sh: cp spark-env.sh.template spark-env.sh

增加配置:

export SPARK_MASTER_IP=master

export SPARK_MASTER_PORT=7077

export SPARK_WORKER_CORES=2

export SPARK_WORKER_INSTANCES=1

export SPARK_WORKER_MEMORY=2g

export JAVA_HOME=/usr/local/soft/jdk1.8.0_171

修改:cp slaves.template slaves

增加:

node1

node2

4.发放到其他节点

xsync spark-2.4.5

(xsync是自己写的脚本,在安装Hadoop的时候写过)

4、在主节点执行启动命令

启动集群,在master中执行

./sbin/start-all.sh

http://master:8080/ 访问spark ui

5.检验安装的Spark

1. standalone client模式 日志在本地输出,一班用于上线前测试(bin/下执行)

需要进入到spark-examples_2.11-2.4.5.jar 包所在的目录下执行

cd /usr/local/soft/spark-2.4.5/examples/jars

spark-submit --class org.apache.spark.examples.SparkPi --master spark://master:7077 --executor-memory 512m --total-executor-cores 1 spark-examples_2.11-2.4.5.jar 100

2. standalone cluster模式 上线使用,不会再本地打印日志

spark-submit --class org.apache.spark.examples.SparkPi --master spark://master:7077 --driver-memory 512m --deploy-mode cluster --supervise --executor-memory 512M --total-executor-cores 1 spark-examples_2.11-2.4.5.jar 100

spark-shell spark 提供的一个交互式的命令行,可以直接写代码

spark-shell master spark://master:7077

6.整合yarn

在公司一般不适用standalone模式,因为公司一般已经有yarn 不需要搞两个资源管理框架

停止spark集群

在spark sbin目录下执行 ./stop-all.sh

spark整合yarn只需要在一个节点整合, 可以删除node1 和node2中所有的spark 文件

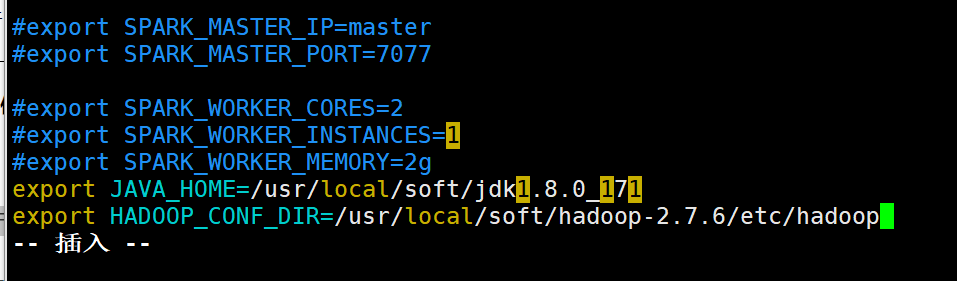

1、增加hadoop 配置文件地址

vim spark-env.sh

增加

export HADOOP_CONF_DIR=/usr/local/soft/hadoop-2.7.6/etc/hadoop

2、往yarn提交任务需要增加两个配置 yarn-site.xml(/usr/local/soft/hadoop-2.7.6/etc/hadoop/yarn-site.xml)

先关闭yarn

stop-yarn.sh

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

4、同步到其他节点,重启yarn

scp -r yarn-site.xml node1:`pwd`

scp -r yarn-site.xml node2:`pwd`

启动yarn

start-yarn.sh

cd /usr/local/soft/spark-2.4.5/examples/jars

3.spark on yarn client模式 日志在本地输出,一班用于上线前测试

spark-submit --class org.apache.spark.examples.SparkPi --master yarn-client --executor-memory 512M --num-executors 2 spark-examples_2.11-2.4.5.jar 100

4.spark on yarn cluster模式 上线使用,不会再本地打印日志 减少io

spark-submit --class org.apache.spark.examples.SparkPi --master yarn-cluster --executor-memory 512m --num-executors 2 --executor-cores 1 spark-examples_2.11-2.4.5.jar 100

获取yarn程序执行日志 执行成功之后才能获取到

yarn logs -applicationId application_1560967444524_0003

hdfs webui

http://node1:50070

yarn ui

http://node1:8088

在idea中使用spark做wordCount

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext} object Demo1WordCount {

def main(args: Array[String]): Unit = { // Spark配置文件对象

val conf: SparkConf = new SparkConf()

// 设置Spark程序的名字

conf.setAppName("Demo1WordCount")

// 设置运行模式为local模式 即在idea本地运行

conf.setMaster("local") // Spark的上下文环境,相当于Spark的入口

val sc: SparkContext = new SparkContext(conf) // 词频统计

// 1、读取文件

/**

* RDD : 弹性分布式数据集(可以先当成scala中的集合去使用)

*/

val linesRDD: RDD[String] = sc.textFile("spark/data/words") // 2、将每一行的单词切分出来

// flatMap: 在Spark中称为 算子

// 算子一般情况下都会返回另外一个新的RDD

val wordsRDD: RDD[String] = linesRDD.flatMap(line => line.split(",")) // 3、按照单词分组

val groupRDD: RDD[(String, Iterable[String])] = wordsRDD.groupBy(word => word) // 4、统计每个单词的数量

val countRDD: RDD[String] = groupRDD.map(kv => {

val word: String = kv._1

val words: Iterable[String] = kv._2

// words.size直接获取迭代器的大小

// 因为相同分组的所有的单词都会到迭代器中

// 所以迭代器的大小就是单词的数量

word + "," + words.size

}) // 5、将结果进行保存

countRDD.saveAsTextFile("spark/data/wordCount") } }

Spark的安装及其配置的更多相关文章

- Spark的安装及配置

title: Spark的安装及配置 summary: 关键词:Hadoop集群环境 Spark scala python ubuntu 安装和配置 date: 2019-5-19 13:56 aut ...

- Mac OSX系统中Hadoop / Hive 与 spark 的安装与配置 环境搭建 记录

Mac OSX系统中Hadoop / Hive 与 spark 的安装与配置 环境搭建 记录 Hadoop 2.6 的安装与配置(伪分布式) 下载并解压缩 配置 .bash_profile : ...

- Spark standlone安装与配置

spark的安装简单,去官网下载与集群hadoop版本相一致的文件即可. 解压后,主要需要修改spark-evn.sh文件. 以spark standlone为例,配置dn1,nn2为master,使 ...

- Spark(三): 安装与配置

参见 HDP2.4安装(五):集群及组件安装 ,安装配置的spark版本为1.6, 在已安装HBase.hadoop集群的基础上通过 ambari 自动安装Spark集群,基于hadoop yarn ...

- spark安装及配置

windows下spark的安装与配置教程 Windows下安装spark windows下搭建spark环境出现ChangeFileModeByMask error (3): ??????????? ...

- spark HA 安装配置和使用(spark1.2-cdh5.3)

安装环境如下: 操作系统:CentOs 6.6 Hadoop 版本:CDH-5.3.0 Spark 版本:1.2 集群5个节点 node01~05 node01~03 为worker. node04. ...

- Spark安装和配置

hadoop2的安装教程 Spark可以直接安装在hadoop2上面,主要是安装在hadoop2的yarn框架上面 安装Spark之前需要在每台机器上安装Scala,根据你下载的Spark版本,选择对 ...

- 01、Spark安装与配置

01.Spark安装与配置 1.hadoop回顾 Hadoop是分布式计算引擎,含有四大模块,common.hdfs.mapreduce和yarn. 2.并发和并行 并发通常指针对单个节点的应对多个请 ...

- Spark集群安装与配置

一.Scala安装 1.https://www.scala-lang.org/download/2.11.12.html下载并复制到/home/jun下解压 [jun@master ~]$ cd sc ...

随机推荐

- jdbc 数据库连接 长时间空闲 断开连接 ApplicationContext.xml

数据库连接 长时间空闲 断开连接solution: <property name="validationQuery" value="select 1"/& ...

- 网站优化之mysql优化

一,网站优化之mysql优化:1.前缀索引,可以通过前缀去识别唯一性,把这个前缀作为索引内容,可以节省存储索引的空间,从而提高索引的查询速度.distinct 排重操作2,2.in条件索引使用同时查询 ...

- 使用Postman做接口测试(学生信息的6个接口)

使用postman做接口测试,案例中涉及到接口有:获取学生信息.登录.添加学生信息.学生金币充值.获取所有学生信息.文件上传. 一.获取学生信息(get请求) 请求方式选择:get 直接在访问地址栏中 ...

- C# 在PPT中添加数学公式

本次内容介绍在C#程序中给PPT幻灯片添加Latex数学公式,添加公式前,首先需要在幻灯片中插入一个Shape形状,在形状的段落中通过方法Paragraphs.AddParagraphFromLate ...

- bootstrap inputfile 使用-上传,回显

近期用bootstrap 做前端的上传,功能涉及到上传时就是召网上的教程随便弄一搜一大把,但是做到修改页面时候不知道页面该如何回显,折腾了一阵子才完成遂记录下来希望能给看到的小伙伴有点启发吧. 首先是 ...

- 计算机网络-4-1-2-分类的IP地址

有关IP最重要的文档就是互联网的正式标准RFC 791 IP地址及其表示方法 整个互联网就是一个单一,抽象的网络,IP地址就是给互联网上的每一台主机(或者路由器)的每一个接口分配一个在全世界范围内都是 ...

- $\text {FWT}$学习笔记

\(\text {FWT}\) 学习笔记 正常项的\(\text {FWT}\) 在\(\text {OI}\)中,我们经常会碰到这种问题: 给出一个长度为\(n\)的序列\(a_{1,2,...,n ...

- Miller-Rabin学习笔记

首先给出两个定理: 1.费马小定理 设p是一个素数,a是一个整数,且不是p的倍数,那么 \(a^{p−1} \equiv\ 1 \pmod p\) 2.二次探测定理 若\(p\)是素数,\(x\)是一 ...

- mysql all_ip_test局域网IP测试工具,有需要的改一改.

1 import threading 2 import subprocess 3 import pymysql 4 # threading.Lock() 5 6 7 class Link(object ...

- 2020BUAA软工提问回顾和个人总结作业

2020BUAA软工提问回顾和个人总结作业 17373010 杜博玮 项目 内容 这个作业属于哪个课程 2020春季计算机学院软件工程(罗杰 任健) 这个作业的要求在哪里 提问回顾和个人总结作业 我在 ...