Kafka和SpringBoot

事先必备:

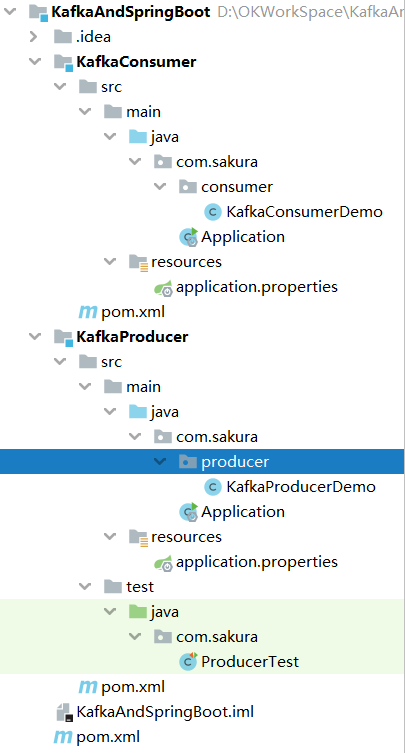

1.目录结构

2.父pom

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.5.RELEASE</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>

<groupId>org.example</groupId>

<artifactId>KafkaAndSpringBoot</artifactId>

<packaging>pom</packaging>

<version>1.0-SNAPSHOT</version>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding>

<java.version>1.8</java.version>

</properties>

<modules>

<module>KafkaProducer</module>

<module>KafkaConsumer</module>

</modules>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

</dependency>

</dependencies>

</project>

3.producer模块

A.application.properties

server.port=8081 #kafka节点

spring.kafka.bootstrap-servers=192.168.204.139:9092

#kafka发送消息失败后的重试次数

spring.kafka.producer.retries=0

#当消息达到该值后再批量发送消息.16kb

spring.kafka.producer.batch-size=16384

#设置kafka producer内存缓冲区大小.32MB

spring.kafka.producer.buffer-memory=33554432

#kafka消息的序列化配置

spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.value-serializer=org.apache.kafka.common.serialization.StringSerializer

#acks=0 : 生产者在成功写入消息之前不会等待任何来自服务器的响应。??

#acks=1 : 只要集群的leader节点收到消息,生产者就会收到一个来自服务器成功响应。

#acks=-1: 表示分区leader必须等待消息被成功写入到所有的ISR副本(同步副本)中才认为producer请求成功。

# 这种方案提供最高的消息持久性保证,但是理论上吞吐率也是最差的。

spring.kafka.producer.acks=1

B.producer代码

import lombok.Data;

import lombok.extern.slf4j.Slf4j;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.kafka.support.SendResult;

import org.springframework.stereotype.Component;

import org.springframework.util.concurrent.ListenableFuture;

import org.springframework.util.concurrent.ListenableFutureCallback; @Component

@Slf4j

@Data

public class KafkaProducerDemo {

private final KafkaTemplate<String, Object> kafkaTemplate; public void sendMsg(String topic, Object object) {

ListenableFuture<SendResult<String, Object>> send = kafkaTemplate.send(topic, object);

send.addCallback(new ListenableFutureCallback<SendResult<String, Object>>() {

@Override

public void onFailure(Throwable ex) {

log.error("消息发送失败:{}", ex.toString());

} @Override

public void onSuccess(SendResult<String, Object> result) {

log.info("消息发送成功:{}", result.toString());

}

});

}

}

C.启动类

D.producerTest

import com.sakura.producer.KafkaProducerDemo;

import org.junit.Test;

import org.junit.runner.RunWith;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import org.springframework.test.context.junit4.SpringRunner; @RunWith(SpringRunner.class)

@SpringBootTest

public class ProducerTest {

@Autowired

private KafkaProducerDemo kafkaProducerDemo; @Test

public void send() throws InterruptedException {

String topic = "firstTopic";

for (int i = 0; i < 6; i++) {

kafkaProducerDemo.sendMsg(topic, "Hello kafka," + i);

}

Thread.sleep(Integer.MAX_VALUE);

}

}

4.consumer模块

A.application.properties

server.port=8082

#kafka节点

spring.kafka.bootstrap-servers=192.168.204.139:9092

#consumer消息签收机制

spring.kafka.consumer.enable-auto-commit=false

spring.kafka.listener.ack-mode=manual

#如果没有设置offset或者设置的offset不存在时(例如数据被删除)采取的策略:

#earliest:使用最早的offset

#latest:使用最新的offset

#none:使用前一个offset,如果没有就向consumer抛异常

#anything else:直接向consumer抛出异常

spring.kafka.consumer.auto-offset-reset=earliest

## 序列化配置

spring.kafka.consumer.key-deserializer=org.apache.kafka.common.serialization.StringDeserializer

spring.kafka.consumer.value-deserializer=org.apache.kafka.common.serialization.StringDeserializer

#监听消息消费的线程数,值范围在[1,partitionCounts]之间.

#假如有3个partition,concurrency的值为4,@KafkaListener的数量为2.

#其中一个@KafkaListener会启动两个线程分配到两个partition

#另一个@KafkaListener会启动一个线程分配到另一个partition

#当有一个@KafkaListener挂掉之后会触发broker的再均衡,由剩余的@KafkaListener启动线程重新分配至partition.

#@KafkaListener就像是消费者一样的存在,当值为1时broker会认为只有一个消费者在消费topic.

spring.kafka.listener.concurrency=1

B.consumer代码

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.consumer.Consumer;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.kafka.support.Acknowledgment;

import org.springframework.stereotype.Component; @Slf4j

@Component

public class KafkaConsumerDemo {

@KafkaListener(topics = "firstTopic",groupId = "groupDemo")

public void receiveMsg(ConsumerRecord<String, Object> record,

Acknowledgment acknowledgment, Consumer<?, ?> consumer) {

log.info("消费消息:{}", record.value());

//手动ack

acknowledgment.acknowledge();

consumer.commitAsync();

}

}

C.启动类

略

Kafka和SpringBoot的更多相关文章

- kafka和springboot整合应用

加载依赖 <dependency> <groupId>org.springframework.kafka</groupId> <artifactId>s ...

- Kafka:Springboot整合Kafka消息队列

本文主要分享下Spring Boot和Spring Kafka如何配置整合,实现发送和接收来自Spring Kafka的消息. 项目结构 pom依赖包 <?xml version="1 ...

- kafka整合springboot

1.pom.xml添加依赖 <dependency> <groupId>org.springframework.kafka</groupId> <artifa ...

- springboot整合kafka应用

1.kafka在消息传递的使用非常普遍,相对于activemq来说kafka的分布式管理和使用更加灵活. 2.activemq的搭建和使用可以参考: activemq搭建和springmvc的整合:h ...

- Spring Boot 自定义kafka 消费者配置 ContainerFactory最佳实践

Spring Boot 自定义kafka 消费者配置 ContainerFactory最佳实践 本篇博文主要提供一个在 SpringBoot 中自定义 kafka配置的实践,想象这样一个场景:你的系统 ...

- springboot kafka集成(实现producer和consumer)

本文介绍如何在springboot项目中集成kafka收发message. 1.先解决依赖 springboot相关的依赖我们就不提了,和kafka相关的只依赖一个spring-kafka集成包 &l ...

- SpringBoot整合Kafka和Storm

前言 本篇文章主要介绍的是SpringBoot整合kafka和storm以及在这过程遇到的一些问题和解决方案. kafka和storm的相关知识 如果你对kafka和storm熟悉的话,这一段可以直接 ...

- SpringBoot+kafka+ELK分布式日志收集

一.背景 随着业务复杂度的提升以及微服务的兴起,传统单一项目会被按照业务规则进行垂直拆分,另外为了防止单点故障我们也会将重要的服务模块进行集群部署,通过负载均衡进行服务的调用.那么随着节点的增多,各个 ...

- SpringBoot整合Kafka

一.准备工作 提前启动zk,kafka,并且创建一个Topic("Hello-Kafk") bin/kafka-topics.sh --create --zookeeper 192 ...

随机推荐

- wsl环境下配置ubuntu16.04

wsl环境下配置ubuntu16.04 在公司同事的安利下,终于给自己用了8年的老笔记本(戴尔XPS L502X)换上了固态硬盘(WD500G,SATA3接口) 当然,系统重装了一遍,所有的软件也都没 ...

- linux系统配置常用命令top

本人测试系统:centos7 命令名称:top Linux top命令用于实时显示 process 的动态. 参数:-b 批处理 -c 显示完整的治命令 -I 忽略失效过程 -s 保密模式 -S 累积 ...

- 前端分页(js)

//前端分页 var limit = 10; //每页显示数据条数 var total = $('#host_table').find('tr').length; var allPage = tota ...

- Monkey and Banana 题解(动态规划)

Monkey and Banana 简单的动态规划 1.注: 本人第一篇博客,有啥不足还请多多包涵,有好的建议请指出.你以为有人读你博客,还给你提意见. 2.原题 Background: A grou ...

- Python——查看目录下所有的目录和文件

写程序我们经常会遇到需要遍历某一个目录下的所有文件这个操作,然而python有现成的库,只需要2个循环就可以搞定. import os def all_path(dirname): result = ...

- BJDCTF-2020-WRITEUP---TiKi小组

title: BJDCTF 2020 刷题记录categories: CTFtags: BJDCTF CTF2020 BJDCTF Web duangShell 根据提示,输入.index.php.s ...

- MySQL 对window函数执行sum函数疑似Bug

MySQL 对window函数执行sum函数疑似Bug 使用MySql的窗口函数统计数据时,发现一个小的问题,与大家一起探讨下. 环境配置: mysql-installer-community-8.0 ...

- day50 前端入门

目录 一.引子 1 前端学习的历程 2 浏览器与http协议 2.1 浏览器窗口输入网址回车后发生了几件事 2.2 http协议 二.html入门 1 标签的分类 2 head内常用的标签 3 bod ...

- 安装archlinux

arch安装步骤 archlinux官方安装wiki 1.分区and格式化分区 (分区用fdisk,格式化分区用mkfs) 2.挂载分区 (mount命令) 3.安装archlinux ...

- 【笔记】Java语法

Java语法 兜兜转转,又绕回到Java了. 最近在学习Java,其实以前也学过,但是技术发展太快了,Java都出到14了..是时候该更新一下知识体系了. 然后看的是网上好评如潮的<Java核心 ...