SOTA激活函数学习

除了之前较为流行的RELU激活函数,最近又新出了几个效果较好的激活函数

一、BERT激活函数 - GELU(gaussian error linear units)高斯误差线性单元

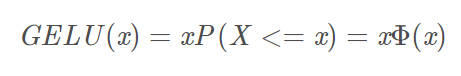

数学公式如下:

X是服从标准正态分布的变量。

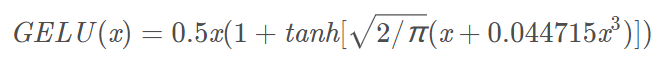

近似的数学计算公式如下:

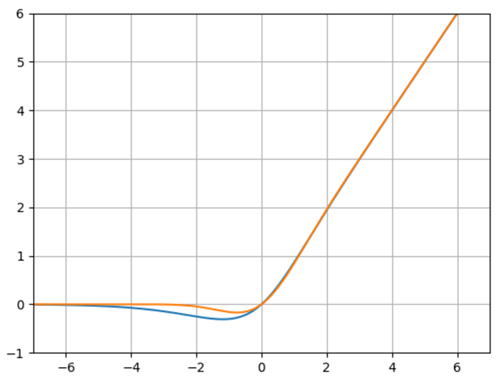

函数图如下:

橙色曲线为:GELU

蓝色曲线为:Mish函数

特性:当输入x减小的时候,输入会有一个更高的概率被dropout掉,这样的激活变换就会随机依赖于输入了,在激活中引入了随机正则的思想,是一种对神经元输入的概率描述。但是其实GELU相比Mish函数就要差一点,首先在大于0阶段,Mish函数的梯度是要略大于GELU,在负轴阶段Mish函数比GELU要晚一点趋近于0,也就是神经元能够晚一点死掉。

import math

import numpy as np

from matplotlib import pyplot as plt def mish(x):

return x * math.tanh(math.log(1+math.exp(x))) def GELU(x):

return 0.5*x*(1+math.tanh(math.sqrt(2/math.pi)*(x+0.044715*x**3))) x = np.linspace(-10,10,1000)

y=[]

z=[]

for i in x:

y.append(mish(i))

z.append(GELU(i))

plt.plot(x,y)

plt.plot(x,z)

plt.grid()

plt.ylim(-1,6)

plt.xlim(-7,7)

plt.show()

二、Mish激活函数

公式如下:

函数图如下:

橙色曲线为:ln(1+e^(x))

蓝色曲线为:Mish函数

import math

import numpy as np

from matplotlib import pyplot as plt def mish(x):

return x * math.tanh(math.log(1+math.exp(x))) def ln_e(x):

return math.log(1+math.exp(x)) x = np.linspace(-10,10,1000)

y=[]

z=[]

for i in x:

y.append(mish(i))

z.append(ln_e(i))

plt.plot(x,y)

plt.plot(x,z)

plt.grid()

plt.show()

SOTA激活函数学习的更多相关文章

- Mish:一个新的SOTA激活函数,ReLU的继任者

Mish:一个新的SOTA激活函数,ReLU的继任者 CVer 昨天 以下文章来源于AI公园 ,作者ronghuaiyang AI公园 专注分享干货的AI公众号,图像处理,NLP,深度学习,机器学 ...

- ML激活函数使用法则

sigmoid .tanh .ReLu tanh 函数或者双曲正切函数是总体上都优于 sigmoid 函数的激活函数. 基本已经不用 sigmoid 激活函数了,tanh 函数在所有场合都优于 sig ...

- deeplearning.ai课程学习(3)

第三周:浅层神经网络(Shallow neural networks) 1.激活函数(Activation functions) sigmoid函数和tanh函数两者共同的缺点是,在z特别大或者特别小 ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第三周:浅层神经网络(Shallow neural networks) -课程笔记

第三周:浅层神经网络(Shallow neural networks) 3.1 神经网络概述(Neural Network Overview) 使用符号$ ^{[

- [C1W3] Neural Networks and Deep Learning - Shallow neural networks

第三周:浅层神经网络(Shallow neural networks) 神经网络概述(Neural Network Overview) 本周你将学习如何实现一个神经网络.在我们深入学习具体技术之前,我 ...

- 论文阅读 | Text Processing Like Humans Do: Visually Attacking and Shielding NLP Systems

[code&data] [pdf] 主要工作 文章首先证明了对抗攻击对NLP系统的影响力,然后提出了三种屏蔽方法: visual character embeddings adversaria ...

- 《Neural Networks and Deep Learning》课程笔记

Lesson 1 Neural Network and Deep Learning 这篇文章其实是 Coursera 上吴恩达老师的深度学习专业课程的第一门课程的课程笔记. 参考了其他人的笔记继续归纳 ...

- [DeeplearningAI笔记]神经网络与深度学习3.2_3.11(激活函数)浅层神经网络

觉得有用的话,欢迎一起讨论相互学习~Follow Me 3.2 神经网络表示 对于一个由输入层,隐藏层,输出层三层所组成的神经网络来说,输入层,即输入数据被称为第0层,中间层被称为第1层,输出层被称为 ...

- 【深度学习】深入理解ReLU(Rectifie Linear Units)激活函数

论文参考:Deep Sparse Rectifier Neural Networks (很有趣的一篇paper) Part 0:传统激活函数.脑神经元激活频率研究.稀疏激活性 0.1 一般激活函数有 ...

随机推荐

- python爬虫(4)——scrapy框架

安装 urllib库更适合写爬虫文件,scrapy更适合做爬虫项目. 步骤: 先更改pip源,国外的太慢了,参考:https://www.jb51.net/article/159167.htm 升级p ...

- HBuilder创建app 基础

一.了解HBuilder HBuilder内封装了大量的书籍,极大方便了使用 官方文档: http://dev.dcloud.net.cn/mui/ui/ 关于布局: mhead 表头.mbody ...

- JS高阶---事件循环模式(事件轮询)

大纲: 相关知识点: 主体: (1)模型原理 JS部分:初始化代码执行 WebAPIS:执行上下文对象(不是一个真的对象,而是一个抽象的虚拟对象,可以看做栈里的一个区域,包含很多对象) setTime ...

- python27期day02:while循环、break、格式化、运算符、编码初始、作业题。

1.while循环:不断的重复着某件事就是循环 2.while循环图解: 3.break:终止当前循环. 4.continue就是跳出本次循环.继续下次循环. 下方代码都不会执行. 改变循环条件来终止 ...

- MyBatis Plus 将查询结果封装到指定实体

MyBatis Plus 将查询结果封装到指定实体 思路 自定义方法,使用Wrapper,自定义映射结果集 Mapper接口 package com.mozq.boot.mpsand01.dao; i ...

- echars vue 封装全局组件 曲线 柱状图 同v-chars绿色系 配置样式

Echars vue封装 ,曲线图 <!DOCTYPE html> <html lang="en"> <head> <meta chars ...

- java基础JDK jvm path环境变量

JDk=JRE +java的开发工具(javac.exe java.exe javadoc.exe)JRE =JVM +Java核心类库 2.为什么 要配置 path环境变量 ?如何配置?JAVA_H ...

- 11/6 <bit manipulation>

389. Find the Difference ^ (按位异或): 参加运算的两个数,如果两个相应位为“异”(值不同),则该位结果为1,否则为0. 抵消掉相同的位,剩下的就是多余的位. class ...

- [LeetCode] 236. Lowest Common Ancestor of a Binary Tree 二叉树的最小共同父节点

Given a binary tree, find the lowest common ancestor (LCA) of two given nodes in the tree. According ...

- copy running-config startup-config 与 copy startup-config running-config

1.copy running-config startup-config 与 copy startup-config running-config 两者有什么不同???ANS:running-conf ...