python爬虫之爬取糗事百科并将爬取内容保存至Excel中

本篇博文为使用python爬虫爬取糗事百科content并将爬取内容存入excel中保存·.

实验环境:Windows10 代码编辑工具:pycharm

使用selenium(自动化测试工具)+phantomjs(无界面的浏览器 也可以使用Firefox或者chrome)+beautiful soup来爬取并解析页面

代码如下:

#_*_coding:utf-8_*_

from selenium import webdriver

from bs4 import BeautifulSoup

import xlwt

import sys

reload(sys)

sys.setdefaultencoding("gbk")

driver=webdriver.PhantomJS();

driver.set_window_size(1120, 550)

wbk=xlwt.Workbook()

sheet=wbk.add_sheet("sheet1")

class Crawl_spider(object):

def __init__(self,page):

self.page=page

def crawl(self):

index=1

row=0

contents=[]

while self.page <= 2: #此处可根据要爬取的页面数量做修改

url='https://www.qiushibaike.com/8hr/page/'+str(self.page)

driver.get(url)

html = driver.page_source

soup = BeautifulSoup(html, "lxml")

print soup.title.string #打印每个页面的title

for item in soup.findAll("div", {"class": "content"}):

string = str(index) + ':'+ item.getText().strip()

sheet.write(row,0,string)

row+=1

index += 1

self.page+=1

wbk.save('lucky.xls')

spider1=Crawl_spider(1) #实例化一个对象

spider1.crawl()

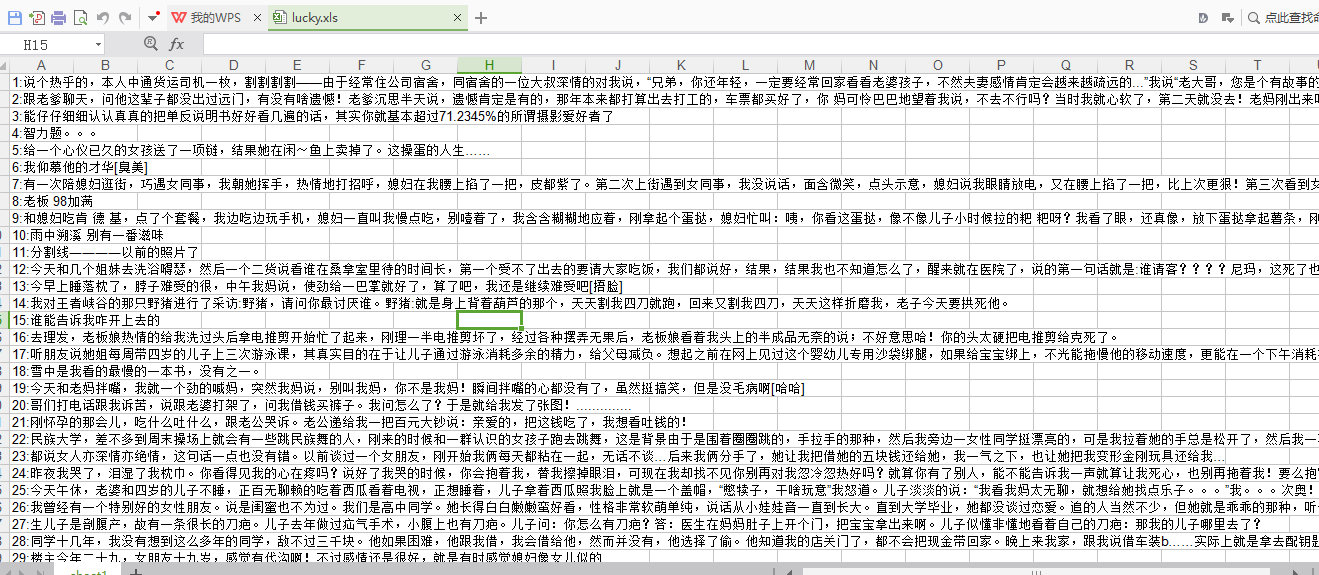

实验结果:生成一个名为lucky的xls文件

python爬虫之爬取糗事百科并将爬取内容保存至Excel中的更多相关文章

- 爬取糗事百科热门段子的数据并保存到本地,xpath的使用

和之前的爬虫类博客的爬取思路基本一致: 构造url_list,因为糗事百科的热门栏目默认是13页,所以这个就简单了 遍历发送请求获取响应 提取数据,这里用的是xpath提取,用的是Python的第三方 ...

- Python爬取糗事百科

import urllib import urllib.request from bs4 import BeautifulSoup """ 1.抓取糗事百科所有纯 ...

- 8.Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- python网络爬虫--简单爬取糗事百科

刚开始学习python爬虫,写了一个简单python程序爬取糗事百科. 具体步骤是这样的:首先查看糗事百科的url:http://www.qiushibaike.com/8hr/page/2/?s=4 ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- 转 Python爬虫实战一之爬取糗事百科段子

静觅 » Python爬虫实战一之爬取糗事百科段子 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致 ...

- python爬虫29 | 使用scrapy爬取糗事百科的例子,告诉你它有多厉害!

是时候给你说说 爬虫框架了 使用框架来爬取数据 会节省我们更多时间 很快就能抓取到我们想要抓取的内容 框架集合了许多操作 比如请求,数据解析,存储等等 都可以由框架完成 有些小伙伴就要问了 你他妈的 ...

- [爬虫]用python的requests模块爬取糗事百科段子

虽然Python的标准库中 urllib2 模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests 自称 “HTTP for Humans”,说明使用更 ...

- 初识python 之 爬虫:使用正则表达式爬取“糗事百科 - 文字版”网页数据

初识python 之 爬虫:使用正则表达式爬取"古诗文"网页数据 的兄弟篇. 详细代码如下: #!/user/bin env python # author:Simple-Sir ...

随机推荐

- 利用Fiddler对Android模拟器网络请求进行抓包

安装使用Fiddler 下载安装Fiddler的方法这里就略过了,一路Next就行了.装好之后运行软件,正常情况这个时候我们已经可以对电脑的网络请求进行抓包了.Fiddler默认的代理地址是127.0 ...

- BMP结构详解

位图BITMAPINFOHEADER 与BITMAPFILEHEADER: 先来看BITMAPINFOHEADER,只写几个主要的biSize包含的是这个结构体的大小(包括颜色表) biWidt ...

- spring.net 继承

. <object id="parent" type="Bll.Parent, HRABLL" > <property name=" ...

- JSON Web Token(JWT)学习笔记

1.JWT 的Token 标准的Token由三个部分并以.(点号)连接方式组成,即 header.payload.signature,如下 eyJhbGciOiJIUzI1NiIsInR5cCI6Ik ...

- 04 Rabbits and Recurrence Relations

Problem A sequence is an ordered collection of objects (usually numbers), which are allowed to repea ...

- Hadoop(HDFS、YARN、HBase、Hive和Spark等)默认端口表

端口 作用 9000 fs.defaultFS,如:hdfs://172.25.40.171:9000 9001 dfs.namenode.rpc-address,DataNode会连接这个端口 50 ...

- OpenNIDataGet 获取点云数据

运行后,采集的数据保存到:E:\OpenCVData目录下的color和depth文件夹下.接下来要求参数:内参 外参 这些参数最好优化后使用精度高 如何得到+保存格式 yaml 保存文件格式: 1. ...

- 【微服务架构】SpringCloud之Ribbon(四)

一:Ribbon是什么? Ribbon是Netflix发布的开源项目,主要功能是提供客户端的软件负载均衡算法,将Netflix的中间层服务连接在一起.Ribbon客户端组件提供一系列完善的配置项如连接 ...

- 理解Javascript中的事件绑定与事件委托

最近在深入实践js中,遇到了一些问题,比如我需要为动态创建的DOM元素绑定事件,那么普通的事件绑定就不行了,于是通过上网查资料了解到事件委托,因此想总结一下js中的事件绑定与事件委托. 事件绑定 ...

- TCP三次握手与防火墙规则

一个(tct)socket连接需要在客户端与服务端开启一个隧道,客户端提供一个端口(new时可指定,也可不指定,随机),服务端的端口和地址一定要指定.在win下,服务端创建监听端口时,防火墙会提示阻止 ...