Hudi 数据湖的插入,更新,查询,分析操作示例

Hudi 数据湖的插入,更新,查询,分析操作示例

作者:Grey

原文地址:

前置工作

首先,需要先完成

本文基于上述四个环境已经搭建完成的基础上进行 Hudi 数据湖的插入,更新,查询操作。

开发环境

Scala 2.11.8

JDK 1.8

需要熟悉 Maven 构建项目和 Scala 一些基础语法。

操作步骤

master 节点首先启动集群,执行:

stop-dfs.sh && start-dfs.sh

启动 yarn,执行:

stop-yarn.sh && start-yarn.sh

然后准备一个 Mave 项目,在 src/main/resources 目录下,将 Hadoop 的一些配置文件拷贝进来,分别是

$HADOOP_HOME/etc/hadoop/core-site.xml 文件

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>

</configuration>

注意,需要在你访问集群的机器上配置 host 文件,这样才可以识别 master 节点。

$HADOOP_HOME/etc/hadoop/hdfs-site.xml 文件

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

$HADOOP_HOME/etc/hadoop/yarn-site.xml 文件,目前还没有任何配置

<?xml version="1.0"?>

<configuration>

</configuration>

然后,设计实体的数据结构,

package git.snippet.entity

case class MyEntity(uid: Int,

uname: String,

dt: String

)

插入数据代码如下

package git.snippet.test

import git.snippet.entity.MyEntity

import git.snippet.util.JsonUtil

import org.apache.spark.SparkConf

import org.apache.spark.sql.{SaveMode, SparkSession}

object DataInsertion {

def main(args: Array[String]): Unit = {

System.setProperty("HADOOP_USER_NAME", "root")

val sparkConf = new SparkConf().setAppName("MyFirstDataApp")

.set("spark.serializer", "org.apache.spark.serializer.KryoSerializer")

.setMaster("local[*]")

val sparkSession = SparkSession.builder().config(sparkConf).enableHiveSupport().getOrCreate()

val ssc = sparkSession.sparkContext

ssc.hadoopConfiguration.set("dfs.client.use.datanode.hostname", "true")

insertData(sparkSession)

}

def insertData(sparkSession: SparkSession) = {

import org.apache.spark.sql.functions._

import sparkSession.implicits._

val commitTime = System.currentTimeMillis().toString //生成提交时间

val df = sparkSession.read.text("/mydata/data1")

.mapPartitions(partitions => {

partitions.map(item => {

val jsonObject = JsonUtil.getJsonData(item.getString(0))

MyEntity(jsonObject.getIntValue("uid"), jsonObject.getString("uname"), jsonObject.getString("dt"))

})

})

val result = df.withColumn("ts", lit(commitTime)) //添加ts 时间戳列

.withColumn("uuid", col("uid"))

.withColumn("hudipart", col("dt")) //增加hudi分区列

result.write.format("org.apache.hudi")

.option("hoodie.insert.shuffle.parallelism", 2)

.option("hoodie.upsert.shuffle.parallelism", 2)

.option("PRECOMBINE_FIELD_OPT_KEY", "ts") //指定提交时间列

.option("RECORDKEY_FIELD_OPT_KEY", "uuid") //指定uuid唯一标示列

.option("hoodie.table.name", "myDataTable")

.option("hoodie.datasource.write.partitionpath.field", "hudipart") //分区列

.mode(SaveMode.Overwrite)

.save("/snippet/data/hudi")

}

}

然后,在 master 节点先准备好数据

vi data1

输入如下数据

{'uid':1,'uname':'grey','dt':'2022/09'}

{'uid':2,'uname':'tony','dt':'2022/10'}

然后创建文件目录,

hdfs dfs -mkdir /mydata/

把 data1 放入目录下

hdfs dfs -put data1 /mydata/

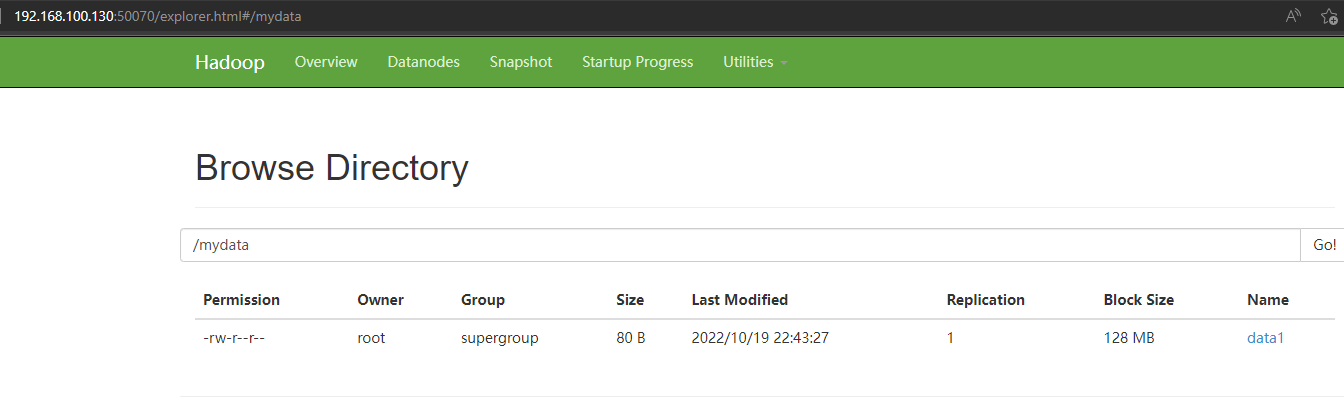

访问:http://192.168.100.130:50070/explorer.html#/mydata

可以查到这个数据

接下来执行插入数据的 scala 代码,执行完毕后,验证一下

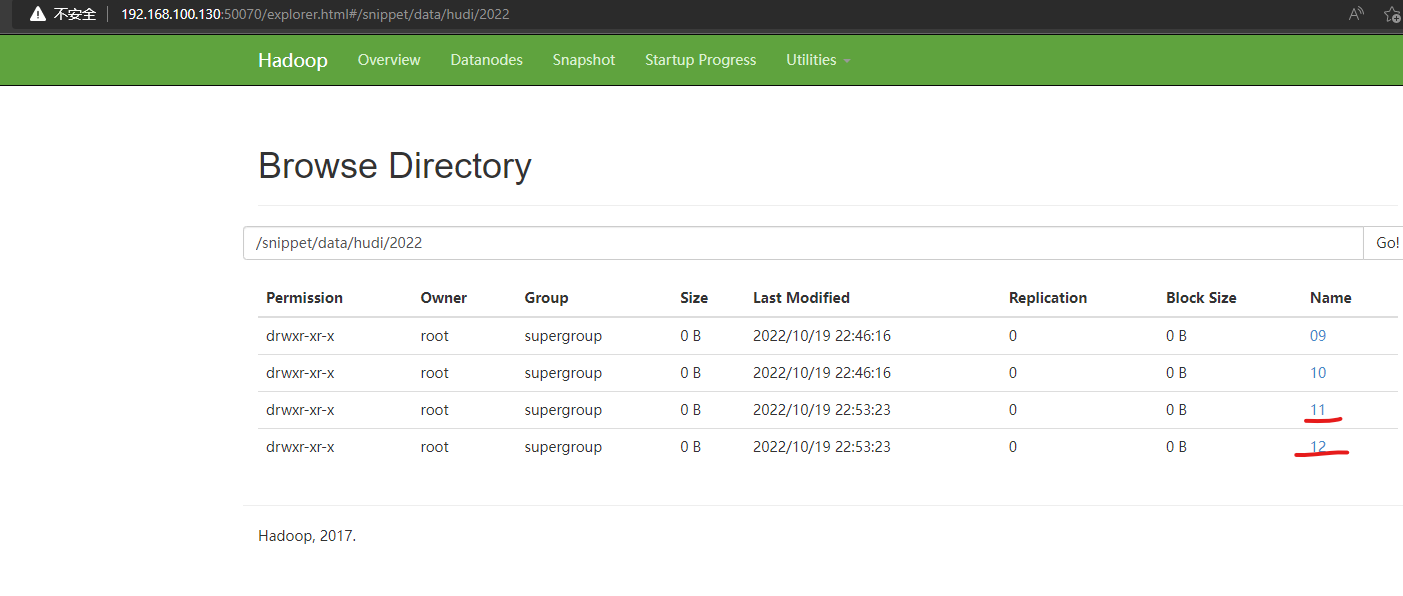

访问:http://192.168.100.130:50070/explorer.html#/snippet/data/hudi/2022

可以查看到插入的数据

准备一个 data2 文件

cp data1 data2 && vi data2

data2 的数据更新为

{'uid':1,'uname':'grey1','dt':'2022/11'}

{'uid':2,'uname':'tony1','dt':'2022/12'}

然后执行

hdfs dfs -put data2 /mydata/

更新数据的代码,我们可以做如下调整,完整代码如下

package git.snippet.test

import git.snippet.entity.MyEntity

import git.snippet.util.JsonUtil

import org.apache.hudi.{DataSourceReadOptions, DataSourceWriteOptions}

import org.apache.spark.SparkConf

import org.apache.spark.sql.{SaveMode, SparkSession}

object DataUpdate {

def main(args: Array[String]): Unit = {

System.setProperty("HADOOP_USER_NAME", "root")

val sparkConf = new SparkConf().setAppName("MyFirstDataApp")

.set("spark.serializer", "org.apache.spark.serializer.KryoSerializer")

.setMaster("local[*]")

val sparkSession = SparkSession.builder().config(sparkConf).enableHiveSupport().getOrCreate()

val ssc = sparkSession.sparkContext

ssc.hadoopConfiguration.set("dfs.client.use.datanode.hostname", "true")

updateData(sparkSession)

}

def updateData(sparkSession: SparkSession) = {

import org.apache.spark.sql.functions._

import sparkSession.implicits._

val commitTime = System.currentTimeMillis().toString //生成提交时间

val df = sparkSession.read.text("/mydata/data2")

.mapPartitions(partitions => {

partitions.map(item => {

val jsonObject = JsonUtil.getJsonData(item.getString(0))

MyEntity(jsonObject.getIntValue("uid"), jsonObject.getString("uname"), jsonObject.getString("dt"))

})

})

val result = df.withColumn("ts", lit(commitTime)) //添加ts 时间戳列

.withColumn("uuid", col("uid")) //添加uuid 列

.withColumn("hudipart", col("dt")) //增加hudi分区列

result.write.format("org.apache.hudi")

// .option(DataSourceWriteOptions.TABLE_TYPE_OPT_KEY, DataSourceWriteOptions.MOR_TABLE_TYPE_OPT_VAL)

.option("hoodie.insert.shuffle.parallelism", 2)

.option("hoodie.upsert.shuffle.parallelism", 2)

.option("PRECOMBINE_FIELD_OPT_KEY", "ts") //指定提交时间列

.option("RECORDKEY_FIELD_OPT_KEY", "uuid") //指定uuid唯一标示列

.option("hoodie.table.name", "myDataTable")

.option("hoodie.datasource.write.partitionpath.field", "hudipart") //分区列

.mode(SaveMode.Append)

.save("/snippet/data/hudi")

}

}

执行更新数据的代码。

验证一下,访问:http://192.168.100.130:50070/explorer.html#/snippet/data/hudi/2022

可以查看到更新的数据情况

数据查询的代码也很简单,完整代码如下

package git.snippet.test

import org.apache.spark.SparkConf

import org.apache.spark.sql.SparkSession

object DataQuery {

def main(args: Array[String]): Unit = {

System.setProperty("HADOOP_USER_NAME", "root")

val sparkConf = new SparkConf().setAppName("MyFirstDataApp")

.set("spark.serializer", "org.apache.spark.serializer.KryoSerializer")

.setMaster("local[*]")

val sparkSession = SparkSession.builder().config(sparkConf).enableHiveSupport().getOrCreate()

val ssc = sparkSession.sparkContext

ssc.hadoopConfiguration.set("dfs.client.use.datanode.hostname", "true")

queryData(sparkSession)

}

def queryData(sparkSession: SparkSession) = {

val df = sparkSession.read.format("org.apache.hudi")

.load("/snippet/data/hudi/*/*")

df.show()

println(df.count())

}

}

执行,输出以下信息,验证成功。

数据查询也支持很多查询条件,比如增量查询,按时间段查询等。

接下来是 flink 实时数据分析的服务,首先需要在 master 上启动 kafka,并创建 一个名字为 mytopic 的 topic,详见Linux 下搭建 Kafka 环境

相关命令如下

创建topic

kafka-topics.sh --zookeeper 127.0.0.1:2181 --replication-factor 1 --partitions 1 --create --topic mytopic

生产者启动配置

kafka-console-producer.sh --broker-list 127.0.0.1:9092 --topic mytopic

消费者启动配置

kafka-console-consumer.sh --bootstrap-server 127.0.0.1:9092 --topic mytopic

然后运行如下代码

package git.snippet.analyzer;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import java.util.Properties;

public class DataAnalyzer {

public static void main(String[] args) {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

Properties properties = new Properties();

properties.setProperty("bootstrap.servers", "192.168.100.130:9092");

properties.setProperty("group.id", "snippet");

//构建FlinkKafkaConsumer

FlinkKafkaConsumer<String> myConsumer = new FlinkKafkaConsumer<>("mytopic", new SimpleStringSchema(), properties);

//指定偏移量

myConsumer.setStartFromLatest();

final DataStream<String> stream = env.addSource(myConsumer);

env.enableCheckpointing(5000);

stream.print();

try {

env.execute("DataAnalyzer");

} catch (Exception e) {

e.printStackTrace();

}

}

}

其中

properties.setProperty("bootstrap.servers", "192.168.100.130:9092");

根据自己的配置调整,然后通过 kakfa 的生产者客户端输入一些数据,这边可以收到这个数据,验证完毕。

完整代码见

Hudi 数据湖的插入,更新,查询,分析操作示例的更多相关文章

- Apache Hudi数据跳过技术加速查询高达50倍

介绍 在 Hudi 0.10 中,我们引入了对高级数据布局优化技术的支持,例如 Z-order和希尔伯特空间填充曲线(作为新的聚类算法),即使在经常使用过滤器查询大表的复杂场景中,也可以在多个列而非单 ...

- C 线性表的链式存储实现及插入、删除等操作示例

一.链式存储的优势 线性表的存储可以通过顺序存储或链式存储实现,其中顺序存储基于数组实现(见本人上一篇博客),在进行插入删除等操作时,需对表内某一部分元素逐个移动,效率较低.而链式结构不依赖于地址连续 ...

- C 线性表的顺序存储实现及插入、删除等操作示例

一.线性表的定义 线性表(Linear List)是由同一类型元素构成的有序序列的线性结构.线性表中元素的个数称为线性表的长度:线性表内没有元素(长度为0)时,称为空表:表的起始位置称为表头,表的结束 ...

- 使用Apache Spark和Apache Hudi构建分析数据湖

1. 引入 大多数现代数据湖都是基于某种分布式文件系统(DFS),如HDFS或基于云的存储,如AWS S3构建的.遵循的基本原则之一是文件的"一次写入多次读取"访问模型.这对于处理 ...

- 数据湖框架选型很纠结?一文了解Apache Hudi核心优势

英文原文:https://hudi.apache.org/blog/hudi-indexing-mechanisms/ Apache Hudi使用索引来定位更删操作所在的文件组.对于Copy-On-W ...

- 使用Apache Hudi构建大规模、事务性数据湖

一个近期由Hudi PMC & Uber Senior Engineering Manager Nishith Agarwal分享的Talk 关于Nishith Agarwal更详细的介绍,主 ...

- Apache Hudi:云数据湖解决方案

1. 引入 开源Apache Hudi项目为Uber等大型组织提供流处理能力,每天可处理数据湖上的数十亿条记录. 随着世界各地的组织采用该技术,Apache开源数据湖项目已经日渐成熟. Apache ...

- 印度最大在线食品杂货公司Grofers的数据湖建设之路

1. 起源 作为印度最大的在线杂货公司的数据工程师,我们面临的主要挑战之一是让数据在整个组织中的更易用.但当评估这一目标时,我们意识到数据管道频繁出现错误已经导致业务团队对数据失去信心,结果导致他们永 ...

- 构建数据湖上低延迟数据 Pipeline 的实践

T 摘要 · 云原生与数据湖是当今大数据领域最热的 2 个话题,本文着重从为什么传统数仓 无法满足业务需求? 为何需要建设数据湖?数据湖整体技术架构.Apache Hudi 存储模式与视图.如何解决冷 ...

随机推荐

- Python算法之动态规划(Dynamic Programming)解析:二维矩阵中的醉汉(魔改版leetcode出界的路径数)

原文转载自「刘悦的技术博客」https://v3u.cn/a_id_168 现在很多互联网企业学聪明了,知道应聘者有目的性的刷Leetcode原题,用来应付算法题面试,所以开始对这些题进行" ...

- Odoo 14 Action URL 生成

from werkzeug.urls import url_encode url = '/web#%s' % url_encode({ 'action': 'hr.plan_wizard_action ...

- Java连接数据库从入门到入土

Java连接数据库 一.最原始的连接数据库 是没有导入任何数据源的:只导入了一个数据库驱动:mysql-connector-java-8.0.27.jar 首先是编写db.proterties文件 d ...

- Prometheus+Grafana+钉钉部署一个单机的MySQL监控告警系统

GreatSQL社区原创内容未经授权不得随意使用,转载请联系小编并注明来源. GreatSQL是MySQL的国产分支版本,使用上与MySQL一致. 目录 一.Prometheus 二.exporter ...

- 关于KeyFile的破解,含注册机源代码

程序来自于<加密与解密3>的第五章的PacMe.exe.书中并没有给出C语言实现的加密与解密代码,自己花了一些时间,把代码还原了,并且写了一个C语言的注册机. 加密原理:正如书中所说,此程 ...

- Luogu2798 爆弹虐场 (二分,Kruskal)

二分答案,判定连通性 #include <iostream> #include <cstdio> #include <cstring> #include <a ...

- 爬虫简介与excel表格操作

爬虫简介与excel表格操作 re模块简介 1.在python中使用正则表达式的话那么re模块就是选择之一 import re # 导入re模块 2.在re模块中使用findall找到所有我们给他的值 ...

- 【三维地图】开发攻略 —— 详解“GeoJSON”技术和应用场景

GeoJSON ,一个用于存储地理信息的数据格式.GoeJSON对象可以表示几何.特征或特征集合,支持:点.线.面.多点.多线.多面和几何集合.在基于平面地图,三维地图中都需要用到的一种数据类型. 由 ...

- Docker 安装 MySQL、Redis

1 Docker 中安装 Redis 1.1 创建目录 在硬盘上创建 redis 的数据目录: mkdir -p /Users/yygnb/dockerMe/redis/data 为该目录添加权限: ...

- SpringBoot 整合 MongoDB 实战介绍

一.介绍 在前面的文章中,我们详细的介绍了 MongoDB 的配置和使用,如果你对 MongoDB 还不是很了解,也没关系,在 MongoDB 中有三个比较重要的名词:数据库.集合.文档! 数据库(D ...