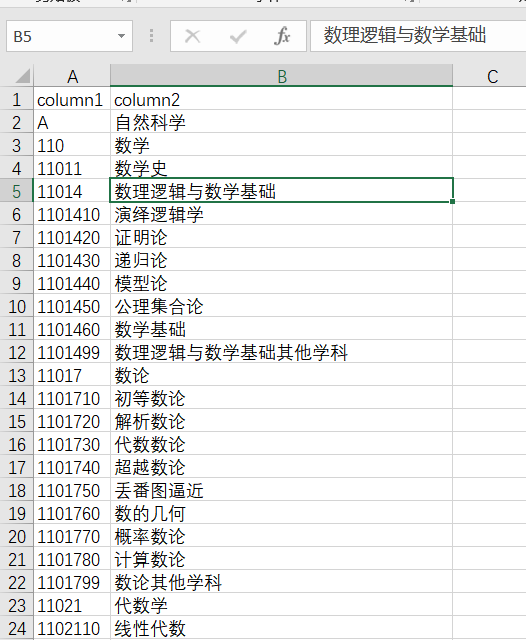

python 1992和2006年国家标准学科分类和代码标准化并存入MySQL数据库

数据表

代码

1 import pandas as pd

2 import pymysql

3

4

5 def get_subject_1992():

6 res={}

7 the_former_code = ""

8 layer1_code = "" # 一位

9 layer1_name = ""

10 layer2_code = "" # 三位

11 layer2_name = "" # 三位

12 layer3_code = "" # 五位

13 layer3_name = ""

14 layer4_code = "" # 七位

15 layer4_name = "" # 七位

16 df = pd.read_excel("std_subject_1992.xlsx")

17 for i in range(len(df.values)):

18 item=df.values[i]

19 # print(item[0],item[1])

20 if (len(str(item[0])) == 1):

21 layer1_code = str(item[0])

22 layer1_name = item[1]

23 # print(layer1_code,layer1_name)

24 if (len(str(item[0])) == 3):

25 layer2_code = str(item[0])

26 layer2_name = item[1]

27 # print(layer2_code, layer2_name)

28 if (len(str(item[0])) == 5):

29 layer3_code = str(item[0])

30 layer3_name = item[1]

31 if(i!=(len(df.values)-1)):

32 if(len(str(df.values[i+1][0]))!=7):

33 # print(layer1_code + layer3_code,layer1_name + "·" + layer2_name + "·" +layer3_name)

34 res.update({layer1_code + layer3_code+"00":layer1_name + "·" + layer2_name + "·" +layer3_name})

35 # print(layer3_code, layer3_name)

36 if (len(str(item[0])) == 6):

37 layer4_code = str(item[0])+"0"

38 layer4_name = item[1]

39 # print(layer4_code, layer4_name)

40 if (layer4_code[:5] == layer3_code):

41 # print(layer1_code + layer4_code,layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name)

42 res.update({layer1_code + layer4_code:layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name})

43 if (len(str(item[0])) == 7):

44 layer4_code = str(item[0])

45 layer4_name = item[1]

46 # print(layer4_code, layer4_name)

47 if (layer4_code[:5] == layer3_code):

48 # print(layer1_code + layer4_code,layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name)

49 res.update({layer1_code + layer4_code:layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name})

50 return res

51

52 """

53 ---------------------------------------------------------------------------------------

54 """

55 def get_subject_2009():

56 res={}

57 the_former_code = ""

58 layer1_code = "" # 一位

59 layer1_name = ""

60 layer2_code = "" # 三位

61 layer2_name = "" # 三位

62 layer3_code = "" # 五位

63 layer3_name = ""

64 layer4_code = "" # 七位

65 layer4_name = "" # 七位

66 df = pd.read_excel("std_subject_2009.xlsx")

67 for i in range(len(df.values)):

68 item=df.values[i]

69 # print(item[0],item[1])

70 if (len(str(item[0])) == 1):

71 layer1_code = str(item[0])

72 layer1_name = item[1]

73 # print(layer1_code,layer1_name)

74 if (len(str(item[0])) == 3):

75 layer2_code = str(item[0])

76 layer2_name = item[1]

77 # print(layer2_code, layer2_name)

78 if (len(str(item[0])) == 5):

79 layer3_code = str(item[0])

80 layer3_name = item[1]

81 if(i!=(len(df.values)-1)):

82 if(len(str(df.values[i+1][0]))!=7):

83 # print(layer1_code + layer3_code,layer1_name + "·" + layer2_name + "·" +layer3_name)

84 res.update({layer1_code + layer3_code+"00":layer1_name + "·" + layer2_name + "·" +layer3_name})

85 if (len(str(item[0])) == 7):

86 layer4_code = str(item[0])

87 layer4_name = item[1]

88 # print(layer4_code, layer4_name)

89 if (layer4_code[:5] == layer3_code):

90 # print(layer1_code + layer4_code,layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name)

91 res.update({layer1_code + layer4_code:layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name})

92 return res

93 """

94 ---------------------------------------------------------------------------------------------------------------

95 """

96 def get_conn():

97 """

98 :return: 连接,游标

99 """

100 # 创建连接

101 conn = pymysql.connect(host="127.0.0.1",

102 user="root",

103 password="000429",

104 db="data_cleaning",

105 charset="utf8")

106 # 创建游标

107 cursor = conn.cursor() # 执行完毕返回的结果集默认以元组显示

108 return conn, cursor

109

110 def close_conn(conn, cursor):

111 if cursor:

112 cursor.close()

113 if conn:

114 conn.close()

115

116

117 def into_mysql():

118 global conn, cursor

119 res=get_subject_2009()

120 for k,v in res.items():

121 print(k,v)

122 try:

123 conn,cursor=get_conn()

124 SQL="insert into std_subject_2009 (year,subject_code,subject_name) values (2009,'"+k+"','"+v+"')"

125 cursor.execute(SQL)

126 conn.commit()

127 except:

128 print(k,v+" 插入失败!")

129 conn,cursor.close()

130 return None

131 if __name__ == '__main__':

132 into_mysql()

获取标准学科分类表 请关注公众号【靠谱杨阅读人生】回复【学科】获取

python 1992和2006年国家标准学科分类和代码标准化并存入MySQL数据库的更多相关文章

- 用Python获取沪深两市上市公司股票信息,提取创近10天股价新高的、停牌的、复牌不超过一天或者新发行的股票,并存入mysql数据库

#该脚本可以提取沪深两市上市公司股票信息,并按以下信息分类:(1)当天股价创近10个交易日新高的股票:(2)停牌的股票:(3)复牌不超过一个交易日或者新发行的股票 #将分类后的股票及其信息(股价新高. ...

- Python之道1-环境搭建与pycharm的配置django安装及MySQL数据库配置

近期做那个python的开发,今天就来简单的写一下开发路线的安装及配置, 开发路线 Python3.6.1+Pycharm5.0.6+Django1.11+MySQL5.7.18 1-安装Python ...

- (转载)Python之道1-环境搭建与pycharm的配置django安装及MySQL数据库配置

近期做那个python的开发,今天就来简单的写一下开发路线的安装及配置, 开发路线 Python3.6.1+Pycharm5.0.6+Django1.11+MySQL5.7.18 1-安装Python ...

- python爬虫学习(2)__抓取糗百段子,与存入mysql数据库

import pymysql import requests from bs4 import BeautifulSoup#pymysql链接数据库 conn=pymysql.connect(host= ...

- Python+Scrapy+Crawlspider 爬取数据且存入MySQL数据库

1.Scrapy使用流程 1-1.使用Terminal终端创建工程,输入指令:scrapy startproject ProName 1-2.进入工程目录:cd ProName 1-3.创建爬虫文件( ...

- python爬取疫情数据存入MySQL数据库

import requests from bs4 import BeautifulSoup import json import time from pymysql import * def mes( ...

- python爬虫:爬取易迅网价格信息,并写入Mysql数据库

本程序涉及以下方面知识: 1.python链接mysql数据库:http://www.cnblogs.com/miranda-tang/p/5523431.html 2.爬取中文网站以及各种乱码处 ...

- MySQL数据库和Python的交互

一.缘由 这是之前学习的时候写下的基础代码,包含着MySQL数据库和Python交互的基本操作. 二.代码展示 import pymysql ''' 1.数据库的链接和创建视图 ''' # db=py ...

- Python pandas ERROR 2006 (HY000): MySQL server has gone away

之前在做python pandas大数据分析的时候,在将分析后的数据存入mysql的时候报ERROR 2006 (HY000): MySQL server has gone away 原因分析:在对百 ...

- python实现HOG+SVM对CIFAR-10数据集分类(上)

本博客只用于学习,如果有错误的地方,恳请指正,如需转载请注明出处. 看机器学习也是有一段时间了,这两天终于勇敢地踏出了第一步,实现了HOG+SVM对图片分类,具体代码可以在github上下载,http ...

随机推荐

- 硬件开发笔记(九): 硬件开发基本流程,制作一个USB转RS232的模块(八):创建asm1117-3.3V封装库并关联原理图元器件

前言 有了原理图,可以设计硬件PCB,在设计PCB之间还有一个协同优先动作,就是映射封装,原理图库的元器件我们是自己设计的.为了更好的表述封装设计过程,本文描述了一个创建asm1117-3.3V封 ...

- 并发与并行的区别---python

并发与并行的区别 Erlang 之父 Joe Armstrong 用一张5岁小孩都能看懂的图解释了并发与并行的区别 并发是两个队列交替使用一台咖啡机,并行是两个队列同时使用两台咖啡机 如果是串行,一个 ...

- 2021 虎符杯hate num 注入题

前言 今天遇到个有意思的SQL盲注,花了不少功夫,也学到了新姿势,遂记录下来以备后续碰到相同场景使用. 题目 这是2021 虎符杯的一道web题,有一个目标站点且附带了源码. 源码内容包括: 主要逻辑 ...

- 【Azure 应用服务】[App Service For Linux(Function) ] Python ModuleNotFoundError: No module named 'MySQLdb'

问题描述 在使用Azure Function创建新的Python Function时,使用MySQLdb连接数据库时候出现 ModuleNotFoundError: No module named ' ...

- 【Azure Redis 缓存】Redis导出数据文件变小 / 在新的Redis复原后数据大小压缩近一倍问题分析

问题描述 使用 Azure Cache for Redis 服务,在两个Redis服务之间进行数据导入和导出测试.在Redis中原本有7G的数据值,但是导出时候发现文件大小仅仅只有30MB左右,这个压 ...

- NebulaGraph v3.3.0 发布:支持子图过滤、和大量性能优化

NebulaGraph 3.3.0 支持了 GET SUBGRAPH 和 GetNeighbors 的点过滤.引入了大量性能优化,同时,开始对无 tag 顶点的支持默认关闭. 优化 优化了 k-hop ...

- 链接服务器导致SQL Server停止响应

概要 如果多个实例中同时存在数据源为对方实例的链接服务器,并且开启了"分发服务器"的属性,您可能会遇到这种情况. 1 现象 14:31时,在SSMS中检查HIS实例是否有复制订阅时 ...

- mysql添加联合唯一索引与删除索引

-- 添加联合唯一索引 alter table <表名> add unique index <索引名称> (name, no, org_id); -- 删除索引 ALTER T ...

- Netty笔记(6) - 粘包拆包问题及解决方案

Netty 中 TCP 粘包拆包问题 信息通过tcp传输过程中出现的状况 . TCP是个"流"协议,所谓流,就是没有界限的一串数据.TCP底层并不了解上层业务数据的具体含义,它会根 ...

- Codeforces Round 923 (Div. 3)(A~F)

目录 A B C D E F A #include <bits/stdc++.h> #define int long long #define rep(i,a,b) for(int i = ...