Hadoop 新生报道(二) hadoop2.6.0 集群系统版本安装和启动配置

本次基于Hadoop2.6版本进行分布式配置,Linux系统是基于CentOS6.5 64位的版本。在此设置一个主节点和两个从节点。

准备3台虚拟机,分别为:

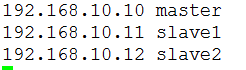

|

主机名 |

IP地址 |

|

master |

192.168.80.10 |

|

slave1 |

192.168.80.11 |

|

slave2 |

192.168.80.12 |

1.修改主机名称,把三个节点分别修改下面的文件,修改主机名为master,slave1,slave2(root用户操作),重启生效

vi /etc/sysconfig/network

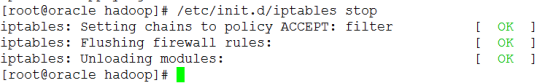

2.把三个节点的防火墙关闭,在三个节点分别执行(root用户操作)

/etc/init.d/iptables stop

3.在三个节点修改配置hosts文件,在hosts文件中分别配置三个节点的主机名 ip地址映射(root用户操作)

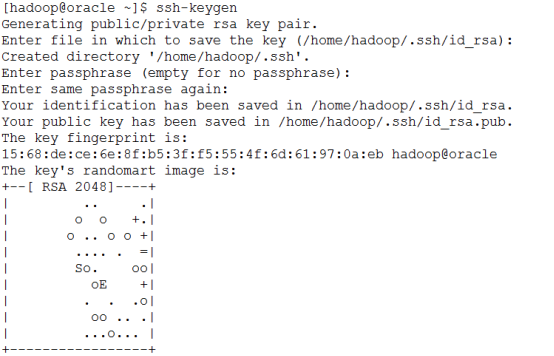

4.在master和slave之间配置SSH互信(hadoop用户操作)

分别在master和slave1,master和slave2,master和master之间配置互信

a) 分别在master、slave1、slave2执行下面的命令生成公钥和私钥

ssh-keygen

在hadoop用户根目录下,有一个.ssh目录

id_rsa 私钥

id_rsa.pub 公钥

known_hosts 通过SSH链接到本主机,都会在这里有记录

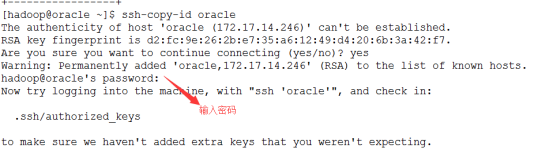

b) 在master输入下面的命令,和master,slave1,slave2创建互信

ssh-copy-id master

ssh-copy-id slave1

ssh-copy-id slave2

注意:复制的过程中需要输入信任主机的密码

!!!!每次ssh完都会进入其他的主机,千万在ssh完了以后退出对配置机器的远程控制,ctrl+d

5.把JDK和Hadoop安装包(资料包目录下的文件)上传到master节点系统(hadoop用户的根目录),用XFtp

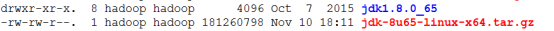

6.在三个节点下面配置jdk。在hadoop用户的根目录,Jdk解压,(hadoop用户操作)

tar -zxvf jdk-8u65-linux-x64.tar.gz

7.三个节点配置环境变量,需要修改/etc/profile文件(root用户操作)

切到root用户,输入su命令

su

vi /etc/profile

进去编辑器后,输入i,进入vi编辑器的插入模式,在profile文件最后添加

|

JAVA_HOME=/home/hadoop/jdk1.8.0_65 export PATH=$PATH:$JAVA_HOME/bin |

编辑完成后,按下esc退出插入模式

输入:,这时在左下角有一个冒号的标识

q 退出不保存

wq 保存退出

q! 强制退出

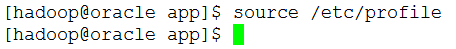

8.在三个节点把修改的环境变量生效(hadoop用户操作),jdk配置完成

source /etc/profile

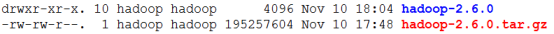

9.下面配置hadoop,在hadoop用户的根目录,解压(hadoop用户操作)

tar -zxvf hadoop-2.6.0.tar.gz

10.修改配置文件hadoop-2.6.0/etc/hadoop/slaves,输入下面内容,每一行是一个从节点主机名称(hadoop用户操作)

slave1

slave2

12.修改配置文件hadoop-2.6.0/etc/hadoop/hadoop-env.sh(hadoop用户操作)

export JAVA_HOME=/home/hadoop/jdk1.8.0_65

13.修改配置文件hadoop-2.6.0/etc/hadoop/core-site.xml,添加(hadoop用户操作)

|

<property> <name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property> <property> <name>io.file.buffer.size</name> <value>131072</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/home/hadoop/hadoop/tmp</value> <description>Abasefor other temporary directories.</description> </property> |

13.修改配置文件hadoop-2.6.0/etc/hadoop/hdfs-site.xml,添加(hadoop用户操作)

|

<property> <name>dfs.namenode.secondary.http-address</name> <value>master:9001</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>/home/hadoop/hadoop/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hadoop/hadoop/dfs/data</value> </property> <property> <name>dfs.replication</name> <value>2</value> </property> |

14.修改修改配置文件hadoop-2.6.0/etc/hadoop/mapred-site.xml (hadoop用户操作),这个文件没有,需要复制一份

cp etc/hadoop/mapred-site.xml.template etc/hadoop/mapred-site.xml

添加

|

<property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapreduce.jobhistory.address</name> <value>master:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>master:19888</value> </property> |

15.修改配置文件hadoop-2.6.0/etc/hadoop/yarn-site.xml,添加(hadoop用户操作)

|

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> <property> <name>yarn.resourcemanager.address</name> <value>master:8032</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>master:8030</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>master:8035</value> </property> <property> <name>yarn.resourcemanager.admin.address</name> <value>master:8033</value> </property> <property> <name>yarn.resourcemanager.webapp.address</name> <value>master:8088</value> </property> |

16.将配置好的hadoop文件copy到另外slave机器上(hadoop用户操作)

scp -r hadoop-2.6.0/ hadoop@slave1:~/hadoop

scp -r hadoop-2.6.0/ hadoop@slave2:~/hadoop

17.格式化HDFS,在hadoop解压目录下,执行如下命令:(hadoop用户操作)

bin/hdfs namenode -format

注意:格式化只能操作一次,如果因为某种原因,集群不能用, 需要再次格式化,需要把上一次格式化的信息删除,在三个节点用户根目录里执行 rm -rf /home/hadoop/hadoop/dfs

18.启动集群,在hadoop解压目录下,执行如下命令:(hadoop用户操作)

sbin/start-all.sh

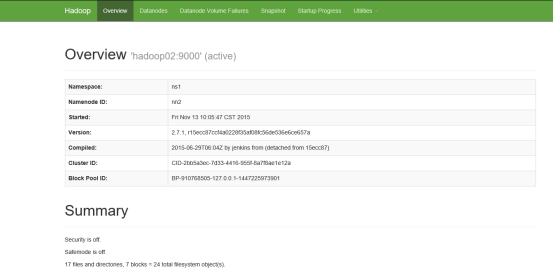

19.查看hadoop的web接口,在浏览器输入:主机名:50070。如:http://master:50070

启动以后jps查看,master有4个线程,slave1和slave2都有3个线程,其中都有一个是jps

Hadoop 新生报道(二) hadoop2.6.0 集群系统版本安装和启动配置的更多相关文章

- 国内最全最详细的hadoop2.2.0集群的MapReduce的最简单配置

简介 hadoop2的中的MapReduce不再是hadoop1中的结构已经没有了JobTracker,而是分解成ResourceManager和ApplicationMaster.这次大变革被称为M ...

- 分布式Hbase-0.98.4在Hadoop-2.2.0集群上的部署

fesh个人实践,欢迎经验交流!本文Blog地址:http://www.cnblogs.com/fesh/p/3898991.html Hbase 是Apache Hadoop的数据库,能够对大数据提 ...

- CentOS6.4上搭建hadoop-2.4.0集群

公司Commerce Cloud平台上提供申请主机的服务.昨天试了下,申请了3台机器,搭了个hadoop环境.以下是机器的一些配置: emi-centos-6.4-x86_64medium | 6GB ...

- hadoop-2.6.0集群开发环境配置

hadoop-2.6.0集群开发环境配置 一.环境说明 1.1安装环境说明 本例中,操作系统为CentOS 6.6, JDK版本号为JDK 1.7,Hadoop版本号为Apache Hadoop 2. ...

- Ubuntu12.04-x64编译Hadoop2.2.0和安装Hadoop2.2.0集群

本文Blog地址:http://www.cnblogs.com/fesh/p/3766656.html 本文对Hadoop-2.2.0源码进行重新编译(64位操作系统下不重新编译会有版本问题) ...

- 在Hadoop-2.2.0集群上安装 Hive-0.13.1 with MySQL

fesh个人实践,欢迎经验交流!本文Blog地址:http://www.cnblogs.com/fesh/p/3872872.html 软件环境 操作系统:Ubuntu14.04 JDK版本:jdk1 ...

- Hadoop-2.6.0 集群的 安装与配置

1. 配置节点bonnie1 hadoop环境 (1) 下载hadoop- 2.6.0 并解压缩 [root@bonnie1 ~]# wget http://apache.fayea.com/had ...

- Linux基于Hadoop2.8.0集群安装配置Hive2.1.1及基础操作

前言 安装Apache Hive前提是要先安装hadoop集群,并且hive只需要在hadoop的namenode节点集群里安装即可,安装前需保证Hadoop已启(动文中用到了hadoop的hdfs命 ...

- hadoop2.2.0集群搭建与部署

原创文章,转载请注明: 转载自http://www.cnblogs.com/tovin/p/3818908.html 一.安装环境 1.系统环境 CentOS 6.4 2.集群机器节点ip 节点一i ...

随机推荐

- mac+phpstorm增加xdebug调试

一.版本信息 mac 10.10.5 phpstorm 10.0.3 xdebug 版本需要与phpstorm匹配,匹配地址 点我匹配 点我查看所有版本 提示:不确定xdebug版本的,把php ...

- php后台拼接输出table表格

<?php header("Content-type:text/html;charset=utf-8"); $str=''; $str.='<table border= ...

- 【Android Developers Training】 85. 不要有冗余的下载

注:本文翻译自Google官方的Android Developers Training文档,译者技术一般,由于喜爱安卓而产生了翻译的念头,纯属个人兴趣爱好. 原文链接:http://developer ...

- 3.sublime vue 语法高亮插件安装

默认情况下,Vue.js 的单文件组件(*.vue)在 sublime 编辑器中是不被识别的.若要想高亮显示,需要安装插件 Vue Syntax Hightlight.安装步骤如下: 第一,在 s ...

- Spring MVC 项目搭建 -5- spring security 使用数据库进行验证

Spring MVC 项目搭建 -5- spring security 使用数据库进行验证 1.创建数据表格(这里使用的是mysql) CREATE TABLE security_role ( id ...

- SQL显示某月全部日期明细以及SQL日期格式

SQL显示某月全部日期明细<存储过程> 方法一: declare @date datetime declare @end datetime ,getdate()) ,@date) crea ...

- @RequestParam与@PathVariable的区别

在spring MVC中,两者的作用都是将request里的参数的值绑定到contorl里的方法参数里的,区别在于,URL写法不同. 使用@RequestParam时,URL是这样的:http://h ...

- 容器_JDK源码分析_自己简单实现ArrayList容器

这几天仔细研究下关于ArrayList容器的jdk源码,感觉收获颇多,以前自己只知道用它,但它里面具体是怎样实现的就完全不清楚了.于是自己尝试模拟写下java的ArrayList容器,简单了实现的Ar ...

- JavaScript一个简易枚举类型实现扑克牌

<script type="text/javascript"> /** * 这个函数创建一个新的枚举类型,实参对象表示类的每个实例的名字和值 * 返回值是一个构造函数, ...

- JS实现悬浮导航的制作--web前端

思想:导航在这里只有两种状态,一种是初始状态.一种是固定布局状态.实现悬浮导航其实就是通过Javascript脚本语言控制导航的两种状态,主要是对两种状态成立条件的判断,明确了这些,实现起来就不会太难 ...